【CV论文阅读】生成式对抗网络GAN

生成式对抗网络GAN

1、 基本GAN

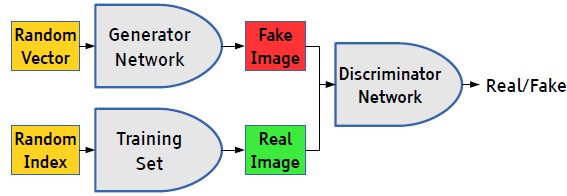

在论文《Generative Adversarial Nets》提出的GAN是最原始的框架,可以看成极大极小博弈的过程,因此称为“对抗网络”。一般包含两个部分:生成器(Generator)和判别器(Discriminator)。训练的过程是无监督学习。

先总结一下训练的过程。一般而言,输入是一个一维向量z,它从先验 生成。假设现在Generator生成的是图像

生成。假设现在Generator生成的是图像 。我们知道,无监督学习目的是学习数据集中的特征(或者说分布),假设真实的分布为

。我们知道,无监督学习目的是学习数据集中的特征(或者说分布),假设真实的分布为 ,而Generator的生成图像的过程其实隐式地定义了一个学习到的分布

,而Generator的生成图像的过程其实隐式地定义了一个学习到的分布 。把生成的图像

。把生成的图像 输入到Discriminator中即

输入到Discriminator中即 ,计算的是样本来自于真实分布而不是由

,计算的是样本来自于真实分布而不是由 生成的概率,因为Discriminator最终只有一个输出。上述无论是Generator或者Discriminator都是一般常见的网络,如下图:

生成的概率,因为Discriminator最终只有一个输出。上述无论是Generator或者Discriminator都是一般常见的网络,如下图:

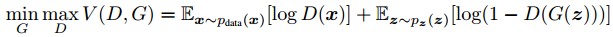

如上所说,训练的过程是极大极小的博弈过程,归纳成下式:

即Generator希望极大化Discriminator误判的概率,而Discriminator极小化把生成样本判成来自真实data的概率。论文中证明,上式的最优解在于 。

。

可以看到,学习到的样本分布(或者特征表示)并没有一个显式的结果,这算是GAN的一个缺点了。训练的过程是同时训练两个网络,由于Discriminator可以更好地指导Generator的调整,所以一般会让Discriminator循环的次数更多。最优化过程使用的是梯度下降算法,如下:

疑惑:在训练D的时候,按照公式应该是一个极大化的过程,为什么可以使用SGD呢?因此我觉得上式应该是不对的, 之前应该缺少一个负号转换成一个极小化的问题。

之前应该缺少一个负号转换成一个极小化的问题。

而开始时,可能 会很接近于0,这使得log函数也接近于0,最终结果是梯度下降时由于回流梯度过小无法更新浅层网络。因此,论文建议训练开始时可以求解极大化

会很接近于0,这使得log函数也接近于0,最终结果是梯度下降时由于回流梯度过小无法更新浅层网络。因此,论文建议训练开始时可以求解极大化 。

。

2、深度卷积生成对抗网络DCGAN

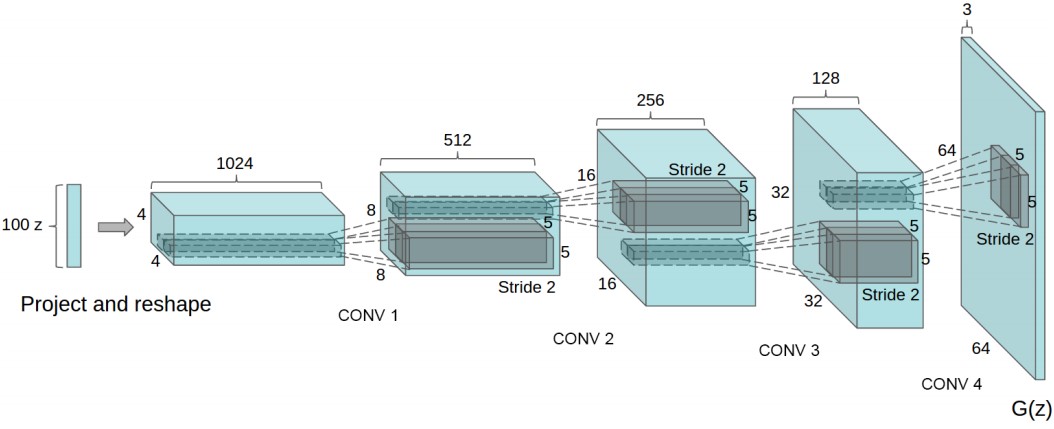

论文《UNSUPERVISED REPRESENTATION L EARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS》提出DCGAN,可以看成是GAN应用在CNN的尝试。论文更多的是在CNN工程上的尝试经验,由于GAN在训练时的不稳定性,因此提出了几点改变:

1、把所有的pooling层用strided convolution替代。在D网络即是跨步长的卷积,在G网络则是上采样(此处称为fractional-strided,但很多代码实现似乎都用了deconv,在tensorflow有这样一个函数)。

2、在G和D都应用BN,但是在G的输出层和D的输入层不应用BN。

3、移除全连接层

4、在G中的激活函数使用RELU,但在输出层使用的是Tanh

5、在D中的激活函数全部使用Leaky ReLu。

结构图如下:

这里主要看它的实现过程。代码来自https://github.com/carpedm20/DCGAN-tensorflow/blob/master/model.py 。

D网络部分和一般的卷积网络没有什么区别,主要最后一步是把feature map进行一个flatten的操作,然后全部feed到一个sigmoid的单元,即下式的h4。

h0 = lrelu(conv2d(image, self.df_dim, name='d_h0_conv'))

h1 = lrelu(self.d_bn1(conv2d(h0, self.df_dim*2, name='d_h1_conv')))

h2 = lrelu(self.d_bn2(conv2d(h1, self.df_dim*4, name='d_h2_conv')))

h3 = lrelu(self.d_bn3(conv2d(h2, self.df_dim*8, name='d_h3_conv')))

h4 = linear(tf.reshape(h3, [self.batch_size, -1]), 1, 'd_h3_lin')

return tf.nn.sigmoid(h4), h4

注意这里的conv2d实现时已经加上了bias。

在G网络部分,主要关注z到project and reshape部分和如何进行fractional-strided convolution。

对于project and reshape,代码中的实现是:

self.z_, self.h0_w, self.h0_b = linear(z, self.gf_dim*8*s16*s16, 'g_h0_lin', with_w=True)

self.h0 = tf.reshape(self.z_, [-1, s16, s16, self.gf_dim * 8])

其中linear()函数是通过matrix相乘把z变成self.gf_dim*8*s16*s16 大小的向量。然后通过reshape得到feature maps。

而对于fractional-strided convolution,这里使用一个函数deconv2d(),代码如下:

w = tf.get_variable('w', [k_h, k_w, output_shape[-1], input_.get_shape()[-1]],initializer=tf.random_normal_initializer(stddev=stddev))

deconv = tf.nn.conv2d_transpose(input_, w, output_shape=output_shape, strides=[1, d_h, d_w, 1])

biases = tf.get_variable('biases', [output_shape[-1]], initializer=tf.constant_initializer(0.0))

deconv = tf.reshape(tf.nn.bias_add(deconv, biases), deconv.get_shape())

通过一个tf.nn.conv2d_transpose()函数实现反卷积。但有一点注意的是,tf.nn.conv2d_transpose()函数不是什么shape都可以输出的,验证是否正确的方法是,把output与卷积核w做一次卷积,如果得到的shape和input的一致,代表是正确的。

可以参考http://stackoverflow.com/questions/35488717/confused-about-conv2d-transpose 。

3、条件GAN conditional GAN

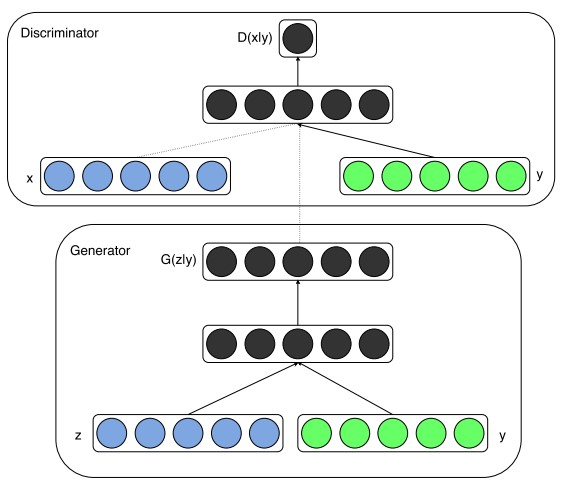

条件GAN,我认为很多blog是写错了的,它和条件概率应该是没有关系的。GAN的一个很大的优点是,它的输入很灵活没有过大的限制。而条件GAN其实是在一般输入时添加了额外的input,这作为一个可控制的变量去指导着网络的训练。因为基本GAN的训练应该是无方向(这里表达不准确)的。

一个简单的网络如下:

Y作为额外的输入的变量,是可控的。在论文《Conditional Generative Adversarial Nets》中的一个例子是训练mnist,其中y则是0~9的标签的一个one-hot的编码向量。

此外,由于GAN输入的灵活,可以很容易想到可以加入多模态的信息对网络训练进行指导,事实上已经有了不少的尝试。

【CV论文阅读】生成式对抗网络GAN的更多相关文章

- 生成式对抗网络GAN 的研究进展与展望

生成式对抗网络GAN的研究进展与展望.pdf 摘要: 生成式对抗网络GAN (Generative adversarial networks) 目前已经成为人工智能学界一个热门的研究方向. GAN的基 ...

- 【神经网络与深度学习】生成式对抗网络GAN研究进展(五)——Deep Convolutional Generative Adversarial Nerworks,DCGAN

[前言] 本文首先介绍生成式模型,然后着重梳理生成式模型(Generative Models)中生成对抗网络(Generative Adversarial Network)的研究与发展.作者 ...

- 生成式对抗网络(GAN)实战——书法字体生成练习赛

https://www.tinymind.cn/competitions/ai 生成式对抗网络(GAN)是近年来大热的深度学习模型. 目前GAN最常使用的场景就是图像生成,作为一种优秀的生成式模型,G ...

- Keras入门——(3)生成式对抗网络GAN

导入 matplotlib 模块: import matplotlib 查看自己版本所支持的backends: print(matplotlib.rcsetup.all_backends) 返回信息: ...

- 不要怂,就是GAN (生成式对抗网络) (一)

前面我们用 TensorFlow 写了简单的 cifar10 分类的代码,得到还不错的结果,下面我们来研究一下生成式对抗网络 GAN,并且用 TensorFlow 代码实现. 自从 Ian Goodf ...

- 不要怂,就是GAN (生成式对抗网络) (一): GAN 简介

前面我们用 TensorFlow 写了简单的 cifar10 分类的代码,得到还不错的结果,下面我们来研究一下生成式对抗网络 GAN,并且用 TensorFlow 代码实现. 自从 Ian Goodf ...

- GAN生成式对抗网络(四)——SRGAN超高分辨率图片重构

论文pdf 地址:https://arxiv.org/pdf/1609.04802v1.pdf 我的实际效果 清晰度距离我的期待有距离. 颜色上面存在差距. 解决想法 增加一个颜色判别器.将颜色值反馈 ...

- 生成式对抗网络(GAN)学习笔记

图像识别和自然语言处理是目前应用极为广泛的AI技术,这些技术不管是速度还是准确度都已经达到了相当的高度,具体应用例如智能手机的人脸解锁.内置的语音助手.这些技术的实现和发展都离不开神经网络,可是传统的 ...

- AI 生成式对抗网络(GAN)

生成式对抗网络(Generative Adversarial Network,简称GAN),主要由两部分构成:生成模型G和判别模型D.训练GAN就是两种模型的对抗过程. 生成模型:利用任意噪音(ran ...

随机推荐

- postgresql update from

1,update from 关联表的更新 update table a set name=b.name from table B b where a.id=b.id; update test ...

- Farseer.net轻量级开源框架 中级篇:SQL执行报告

导航 目 录:Farseer.net轻量级开源框架 目录 上一篇:Farseer.net轻量级开源框架 中级篇: 数据库切换 下一篇:Farseer.net轻量级开源框架 中级篇: 探究ORM(M ...

- K近邻法(K-Nearest Neighbor,KNN)

KNN是一种基本分类与回归方法,本篇只总结分类问题中的KNN. 输入:样本的特征向量,对应于特征空间中的点 输出:样本的类别,可取多类 算法思想:给定一个样本类别已知的训练数据集,对于新样本,根据其K ...

- Proc datasets

作用:控制数据集.Datasets 过程运行结果不输出,结果只有在日志里才能看到. 基本语法: proc datasets lib=work; quit; 用法: 1. 更改数据集 proc data ...

- 在Swift中定义属于自己的运算符

precedencegroup ChainingPrecedence { associativity: left higherThan: TernaryPrecedence } infix opera ...

- VINS-Mono论文笔记(未完)

这是整篇论文的架构,下面针对每一部分进行自己的详细理解.(数学公式的问题没在博客里面解决,都是论文中的截图,尽可能美观==) 一.测量预处理部分(MEASUREMENT PREPROCESSING) ...

- pom.xml配置引用项目时不生效

1 在项目pom.xml配置中引用项目A,但是编译时,取提数引起是B: 2 原因是:[Java Build Path - Projects] 引用的还是老的项目B,删除该引用即可解决.

- weblogic启动 web应用ssh关闭 nohup命令

平时我们操作linux服务器的时候,都是通过ssh远程连接,然后启动服务器上的服务的,所以有时候启动weblogic,我们关闭ssh,weblogic 服务也相应的关闭了,那么我们就只能用nohup这 ...

- 四种方案解决ScrollView嵌套ListView问题 [复制链接]

以下文章转自@安卓泡面 在工作中,曾多次碰到ScrollView嵌套ListView的问题,网上的解决方法有很多种,但是杂而不全.我试过很多种方法,它们各有利弊. 在这里我将会从使用ScrollVie ...

- Linux环境下验证码不显示F12报500

前言: 项目之前部署在linux系统上进行测试,今天重新部署的时候,重启了tomcat然后部署新的版本项目,结果登录页面验证码不显示,在浏览器F12页面显示的是500错误.网上查了很多方法,都没效果 ...