用Python爬取小说《一念永恒》

我们首先选定从笔趣看网站爬取这本小说。

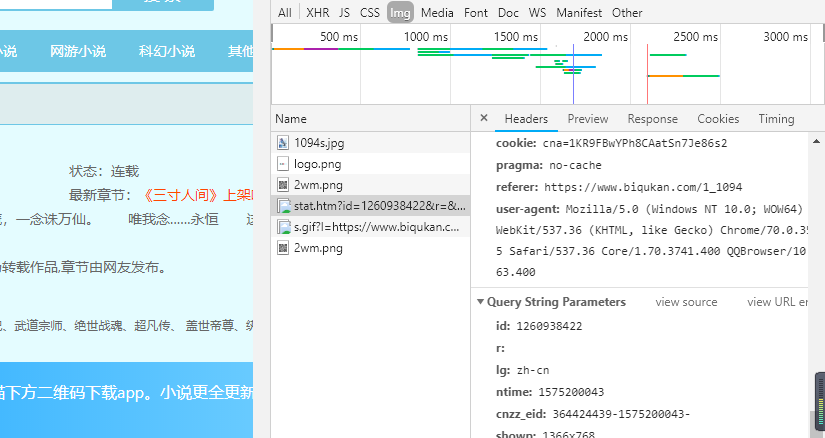

然后开始分析网页构造,这些与以前的分析过程大同小异,就不再多叙述了,只需要找到几个关键的标签和user-agent基本上就可以了。

那么下面,我们直接来看代码。

from urllib import request

from bs4 import BeautifulSoup

import re

import sys if __name__ == "__main__":

#创建txt文件

file = open('一念永恒.txt', 'w', encoding='utf-8')

#一念永恒小说目录地址

target_url = 'http://www.biqukan.com/1_1094/'

head = {}

head['User-Agent'] = 'Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19'

target_req = request.Request(url = target_url, headers = head)

target_response = request.urlopen(target_req)

target_html = target_response.read().decode('gbk','ignore')

listmain_soup = BeautifulSoup(target_html)

#找出div标签中class为listmain的所有子标签

chapters = listmain_soup.find_all('div',class_ = 'listmain')

download_soup = BeautifulSoup(str(chapters))

#计算章节个数

numbers = (len(download_soup.dl.contents) - 1) / 2 - 8

index = 1

begin_flag = False

for child in download_soup.dl.children:

if child != '\n':

#找到《一念永恒》正文卷

if child.string == u"《一念永恒》正文卷":

begin_flag = True

#爬取链接并下载链接内容

if begin_flag == True and child.a != None:

download_url = "http://www.biqukan.com" + child.a.get('href')

download_req = request.Request(url = download_url, headers = head)

download_response = request.urlopen(download_req)

download_html = download_response.read().decode('gbk','ignore')

download_name = child.string

soup_texts = BeautifulSoup(download_html)

texts = soup_texts.find_all(id = 'content', class_ = 'showtxt')

soup_text = BeautifulSoup(str(texts))

write_flag = True

file.write(download_name + '\n\n')

#将爬取内容写入文件

for each in soup_text.div.text.replace('\xa0',''): if each == 'h':

write_flag = False

if write_flag == True and each != ' ':

file.write(each)

if write_flag == True and each == '\r':

file.write('\n')

print('正在写入第{0}小节'.format(index))

index+=1

file.write('\n\n')

#打印爬取进度

sys.stdout.write("已下载:%.3f%%" % float(index/numbers) + '\r')

sys.stdout.flush()

index += 1

file.close()

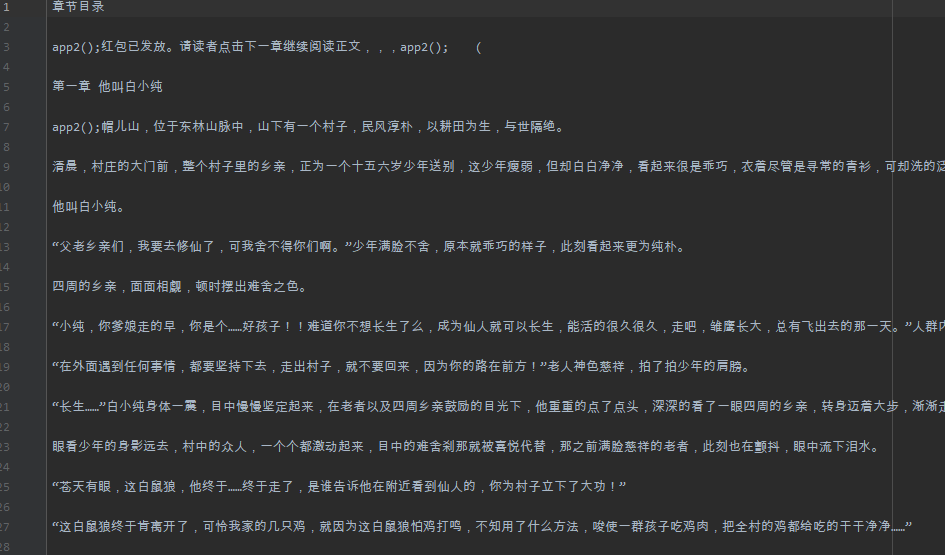

这个代码可能还存在着一些小问题,但是并不影响我们爬取小说,下面来看看我们的运行结果。

用Python爬取小说《一念永恒》的更多相关文章

- python爬取小说详解(一)

整理思路: 首先观察我们要爬取的页面信息.如下: 自此我们获得信息有如下: ♦1.小说名称链接小说内容的一个url,url的形式是:http://www.365haoshu.com/Book/Cha ...

- 详细记录了python爬取小说《元尊》的整个过程,看了你必会~

学了好几天的渗透测试基础理论,周末了让自己放松一下,最近听说天蚕土豆有一本新小说,叫做<元尊>,学生时代的我可是十分喜欢读天蚕土豆的小说,<斗破苍穹>相信很多小伙伴都看过吧.今 ...

- 用python爬取小说章节内容

在学爬虫之前, 最好有一些html基础, 才能更好的分析网页. 主要是五步: 1. 获取链接 2. 正则匹配 3. 获取内容 4. 处理内容 5. 写入文件 代码如下: #导入相关model fro ...

- python爬取小说

运行结果: 代码: import requests from bs4 import BeautifulSoup from selenium import webdriver import os cla ...

- python之爬取小说

继上一篇爬取小说一念之间的第一章,这里将进一步展示如何爬取整篇小说 # -*- coding: utf- -*- import urllib.request import bs4 import re ...

- python入门学习之Python爬取最新笔趣阁小说

Python爬取新笔趣阁小说,并保存到TXT文件中 我写的这篇文章,是利用Python爬取小说编写的程序,这是我学习Python爬虫当中自己独立写的第一个程序,中途也遇到了一些困难,但是最后 ...

- Python3爬取小说并保存到文件

问题 python课上,老师给同学们布置了一个问题,因为这节课上学的是正则表达式,所以要求利用python爬取小说网的任意小说并保存到文件. 我选的网站的URL是'https://www.biquka ...

- Python实战项目网络爬虫 之 爬取小说吧小说正文

本次实战项目适合,有一定Python语法知识的小白学员.本人也是根据一些网上的资料,自己摸索编写的内容.有不明白的童鞋,欢迎提问. 目的:爬取百度小说吧中的原创小说<猎奇师>部分小说内容 ...

- python爬虫——爬取小说 | 探索白子画和花千骨的爱恨情仇(转载)

转载出处:药少敏 ,感谢原作者清晰的讲解思路! 下述代码是我通过自己互联网搜索和拜读完此篇文章之后写出的具有同样效果的爬虫代码: from bs4 import BeautifulSoup imp ...

随机推荐

- Mac OS 安装 MySQL5.7

在 macOS 上安装 MySQL 5.7 安装 Homebrew $ /usr/bin/ruby -e "$(curl -fsSL https://raw.githubuserconten ...

- ImageSwitcher 图片切换器

<?xml version="1.0" encoding="utf-8"?> <LinearLayout xmlns:android=&quo ...

- leetcode 402. Remove K Digits 、321. Create Maximum Number

402. Remove K Digits https://www.cnblogs.com/grandyang/p/5883736.html https://blog.csdn.net/fuxuemin ...

- 【转载】 漫谈Code Review的错误实践

原文地址: https://www.cnblogs.com/chaosyang/p/code-review-wrong-practices.html ------------------------- ...

- postman内置脚本说明

1. 清除一个全局变量 Clear a global variable 对应脚本: postman.clearGlobalVariable("variable_key"); 参数: ...

- Java Utils工具类大全

源码和jar见:https://github.com/evil0ps/utils #Java Utils --- 封装了一些常用Java操作方法,便于重复开发利用. 另外希望身为Java牛牛的你们一起 ...

- DDos攻击解决办法

(1).DDos概念 分布式拒绝服务攻击(英文意思是Distributed Denial of Service,简称DDoS)是指处于不同位置的多个攻击者同时向一个或数个目标发动攻击,或者一个攻击者控 ...

- snmp oid 和厂商对应关系

<node oid="default" name="Unknown" type="workstation"/><node ...

- Python - Django - 页面上展示固定的页码数

如果页数太多的话,全部显示在页面上就会显得很冗杂 可以在页面中显示规定的页码数 例如: book_list.html: <!DOCTYPE html> <html lang=&quo ...

- DB2中ALTER TABLE的使用

今天在看DB2存储过程的时候发现了如下语句能够清空表: ... SET EX_SQL='ALTER TABLE TEST_TABLE ACTIVATE NOT LOGGED INITIALLY WIT ...