tensorflow学习笔记(2)-反向传播

tensorflow学习笔记(2)-反向传播

反向传播是为了训练模型参数,在所有参数上使用梯度下降,让NN模型在的损失函数最小

损失函数:学过机器学习logistic回归都知道损失函数-就是预测值和真实值得差距,比如sigmod或者cross-entropy

均方误差:tf.reduce_mean(tf.square(y-y_))很好理解,假如在欧式空间只有两个点的的话就是两点间距离的平方,多点就是多点误差的平方和除以对比点个数

学习率:决定了参数每次更新的幅度

反向传播训练方法:为了减小loss的值为优化目标

# -*- coding: utf-8 -*-

"""

Created on Sat May 26 18:42:08 2018 @author: Administrator

""" import tensorflow as tf

import numpy as np

BATCH_SIZE=8

seed=23455 #基于seed产生随机数

rng=np.random.RandomState(seed)

#随机返回32行2列的矩阵 作为数据集输入

X=rng.rand(32,2) #从X这个32行2列的矩阵中取出一行 判断如果和小于1 给Y赋值1 如果和不小于1 给Y赋值0

#Y作为训练集的标签

Y=[[int((x0+x1)<1)] for(x0,x1) in X] print(X)

print(Y)

#定义输入,参数和输出

x=tf.placeholder(tf.float32,shape=(None,2))

y_=tf.placeholder(tf.float32,shape=(None,1))

#2是特征值 3是隐藏层 1是输出

w1=tf.Variable(tf.random_normal([2,3],stddev=1,seed=1))

w2=tf.Variable(tf.random_normal([3,1],stddev=1,seed=1)) a=tf.matmul(x,w1)

y=tf.matmul(a,w2) #定义损失函数以及反向传播方法

loss=tf.reduce_mean(tf.square(y-y_))

train_step=tf.train.GradientDescentOptimizer(0.001).minimize(loss) #会话训练

with tf.Session() as sess:

init_op=tf.global_variables_initializer()

sess.run(init_op)

#输出未训练的参数值

print(sess.run(w1))

print(sess.run(w2)) #训练3000次

STEPS=10000

for i in range(STEPS):

start=(i*BATCH_SIZE)%32

end=BATCH_SIZE+start

#每次训练抽取start到end的数据

sess.run(train_step,feed_dict={x:X[start:end],y_:Y[start:end]})

#每500次打印一次参数

if i%500==0:

total_loss=sess.run(loss,feed_dict={x:X,y_:Y})

print("在第%d次训练,损失为%g"%(i,total_loss))

#输出训练后的参数

print("\n")

print(sess.run(w1))

print(sess.run(w2))

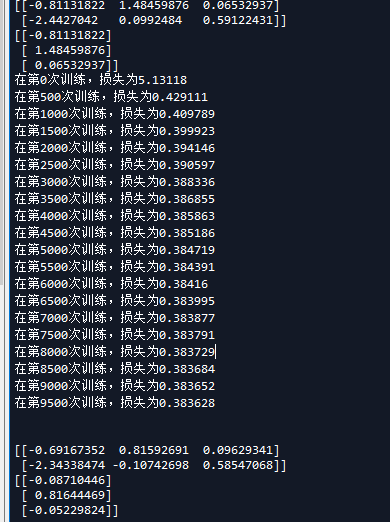

这是输出的内容

我们现在稍微改下参数比较下,首先是学习速率

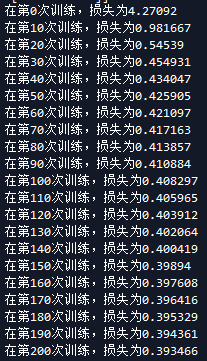

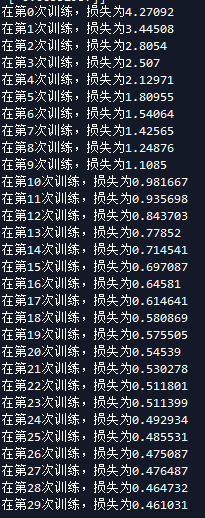

当学习速率为0.1时候 当学习速率为0.01

可以看出来学习速率越大梯度下降越块。

再来看看隐藏层

首先是隐藏层为4时候 隐藏层为3时候

现在还不知道隐藏层怎么定义,知道以后再补上

问了群里老哥:老哥回答

tensorflow学习笔记(2)-反向传播的更多相关文章

- tensorflow学习笔记(1)-基本语法和前向传播

tensorflow学习笔记(1) (1)tf中的图 图中就是一个计算图,一个计算过程. 图中的constant是个常量 计 ...

- tensorflow学习笔记(4)-学习率

tensorflow学习笔记(4)-学习率 首先学习率如下图 所以在实际运用中我们会使用指数衰减的学习率 在tf中有这样一个函数 tf.train.exponential_decay(learning ...

- tensorflow学习笔记(3)前置数学知识

tensorflow学习笔记(3)前置数学知识 首先是神经元的模型 接下来是激励函数 神经网络的复杂度计算 层数:隐藏层+输出层 总参数=总的w+b 下图为2层 如下图 w为3*4+4个 b为4* ...

- TensorFlow学习笔记——深层神经网络的整理

维基百科对深度学习的精确定义为“一类通过多层非线性变换对高复杂性数据建模算法的合集”.因为深层神经网络是实现“多层非线性变换”最常用的一种方法,所以在实际中可以认为深度学习就是深度神经网络的代名词.从 ...

- tensorflow学习笔记——使用TensorFlow操作MNIST数据(2)

tensorflow学习笔记——使用TensorFlow操作MNIST数据(1) 一:神经网络知识点整理 1.1,多层:使用多层权重,例如多层全连接方式 以下定义了三个隐藏层的全连接方式的神经网络样例 ...

- tensorflow学习笔记——自编码器及多层感知器

1,自编码器简介 传统机器学习任务很大程度上依赖于好的特征工程,比如对数值型,日期时间型,种类型等特征的提取.特征工程往往是非常耗时耗力的,在图像,语音和视频中提取到有效的特征就更难了,工程师必须在这 ...

- tensorflow学习笔记——使用TensorFlow操作MNIST数据(1)

续集请点击我:tensorflow学习笔记——使用TensorFlow操作MNIST数据(2) 本节开始学习使用tensorflow教程,当然从最简单的MNIST开始.这怎么说呢,就好比编程入门有He ...

- TensorFlow学习笔记10-卷积网络

卷积网络 卷积神经网络(Convolutional Neural Network,CNN)专门处理具有类似网格结构的数据的神经网络.如: 时间序列数据(在时间轴上有规律地采样形成的一维网格): 图像数 ...

- Tensorflow学习笔记No.4.1

使用CNN卷积神经网络(1) 简单介绍CNN卷积神经网络的概念和原理. 已经了解的小伙伴可以跳转到Tensorflow学习笔记No.4.2学习如和用Tensorflow实现简单的卷积神经网络. 1.C ...

随机推荐

- 菜鸟笔记 -- Chapter 6.2 类的构成

在前面我们讲过高级开发语言大多由7种语法构成,但这是一个很空泛的概述,下,面我们仅就针对Java程序来说一下构成一个Java程序的几大部分,其中类是最小的基本元素.类是封装对象属性和行为的载体,而在J ...

- 优雅的QSignleton (二) MonoSingleton单例实现

MonoSingleton.cs namespace QFramework.Example { using System.Collections; using UnityEngine; class C ...

- Anaconda的使用—Spyder常用快捷键

Ctrl + 1: 注释/反注释 Ctrl + 4/5: 块注释/块反注释 Ctrl + L: 跳转到行号 Tab/Shift + Tab: 代码缩进/反缩进 Ctrl +I:显示帮助

- java各种业务解决方案总结

最近有点时间,突然感慨良多,感觉辛苦工作这么久什么都没有,总结了以前的工作,将接触的主要工具列出来,希望给大家解决问题做参考.相关工具都是实践检验过的 1.数据库 (1).内存数据库 redis (2 ...

- 洛谷P1709 [USACO5.5]隐藏口令Hidden Password(最小表示法)

题目描述 有时候程序员有很奇怪的方法来隐藏他们的口令.Binny会选择一个字符串S(由N个小写字母组成,5<=N<=5,000,000),然后他把S顺时针绕成一个圈,每次取一个做开头字母并 ...

- Floyd 算法详解

Floyd-Warshall Floyd算法,是一种著名的多源最短路算法. 核心思想: 用邻接矩阵存储图,核心代码为三重循环,第一层枚举中间点k,二三层分别枚举起始点i与目标点j.然后判断经过中间点k ...

- poj_3256_Cow Picnic

The cows are having a picnic! Each of Farmer John's K (1 ≤ K ≤ 100) cows is grazing in one of N (1 ≤ ...

- js 关于字符串转数字及数字保留位数的控制

1.parseInt()和parseFloat()两个转换函数,将字符串转换成相应的数字. 1.parseInt() parseInt进行转换时,将字符串转成相应的整数.浮点数以后的数字都不要了. p ...

- Java小功能大杂烩

生成UUID: import java.util.UUID; public class ProductUUID { // 随机返回前十位的UUID public static String getUU ...

- js判断是否为数字

function isNumber(value) { var patrn = /^(-)?\d+(\.\d+)?$/; if (patrn.exec(value) == null || value = ...