你必须知道的容器日志 (2) 开源日志管理方案 ELK

本篇已加入《.NET Core on K8S学习实践系列文章索引》,可以点击查看更多容器化技术相关系列文章。上一篇《你必须知道的容器日志(1)》中介绍了Docker自带的logs子命令以及其Logging driver,本篇将会介绍一个流行的开源日志管理方案ELK。

一、关于ELK

1.1 ELK简介

ELK 是Elastic公司提供的一套完整的日志收集以及展示的解决方案,是三个产品的首字母缩写,分别是ElasticSearch、Logstash 和 Kibana。

- Elasticsearch是实时全文搜索和分析引擎,提供搜集、分析、存储数据三大功能

- Logstash是一个用来搜集、分析、过滤日志的工具

- Kibana是一个基于Web的图形界面,用于搜索、分析和可视化存储在 Elasticsearch指标中的日志数据

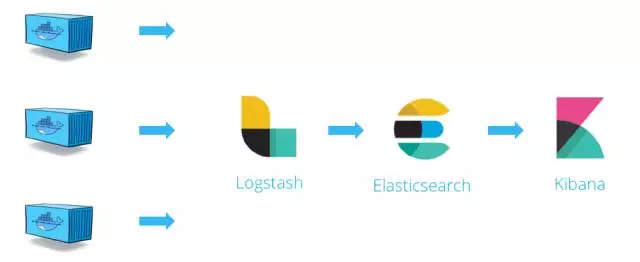

1.2 ELK日志处理流程

上图展示了在Docker环境下,一个典型的ELK方案下的日志收集处理流程:

- Logstash从各个Docker容器中提取日志信息

- Logstash将日志转发到ElasticSearch进行索引和保存

- Kibana负责分析和可视化日志信息

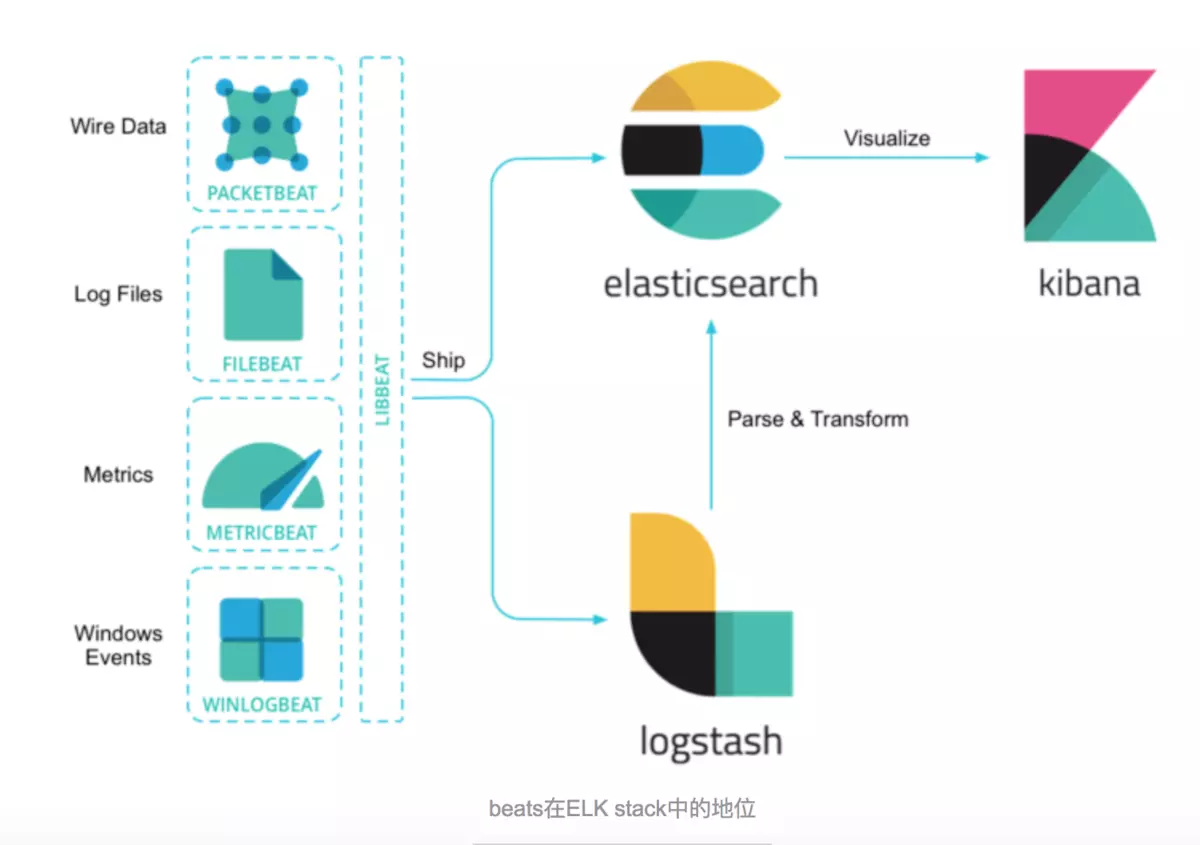

由于Logstash在数据收集上并不出色,而且作为Agent,其性能并不达标。基于此,Elastic发布了beats系列轻量级采集组件。

这里我们要实践的Beat组件是Filebeat,Filebeat是构建于beats之上的,应用于日志收集场景的实现,用来替代 Logstash Forwarder 的下一代 Logstash 收集器,是为了更快速稳定轻量低耗地进行收集工作,它可以很方便地与 Logstash 还有直接与 Elasticsearch 进行对接。

本次实验直接使用Filebeat作为Agent,它会收集我们在第一篇《Docker logs & logging driver》中介绍的json-file的log文件中的记录变动,并直接将日志发给ElasticSearch进行索引和保存,其处理流程变为下图,你也可以认为它可以称作 EFK。

二、ELK套件的安装

本次实验我们采用Docker方式部署一个最小规模的ELK运行环境,当然,实际环境中我们或许需要考虑高可用和负载均衡。

首先拉取一下sebp/elk这个集成镜像,这里选择的tag版本是640(最新版本已经是7XX了):

docker pull sebp/elk:

注:由于其包含了整个ELK方案,所以需要耐心等待一会。

通过以下命令使用sebp/elk这个集成镜像启动运行ELK:

docker run -it -d --name elk \

-p : \

-p : \

-p : \

sebp/elk:

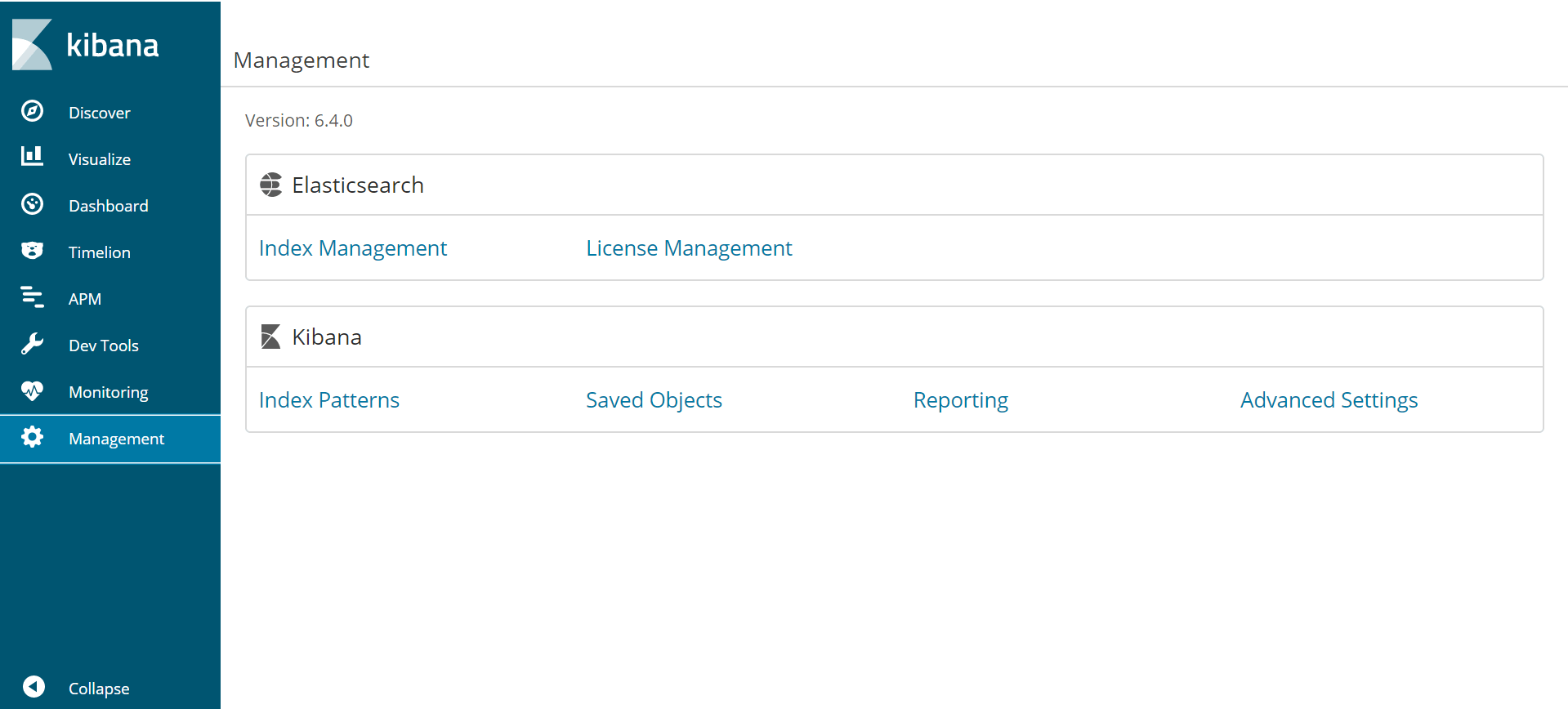

运行完成之后就可以先访问一下 http://[Your-HostIP]:5601 看看Kibana的效果:

Kibana管理界面

Kibana Index Patterns界面

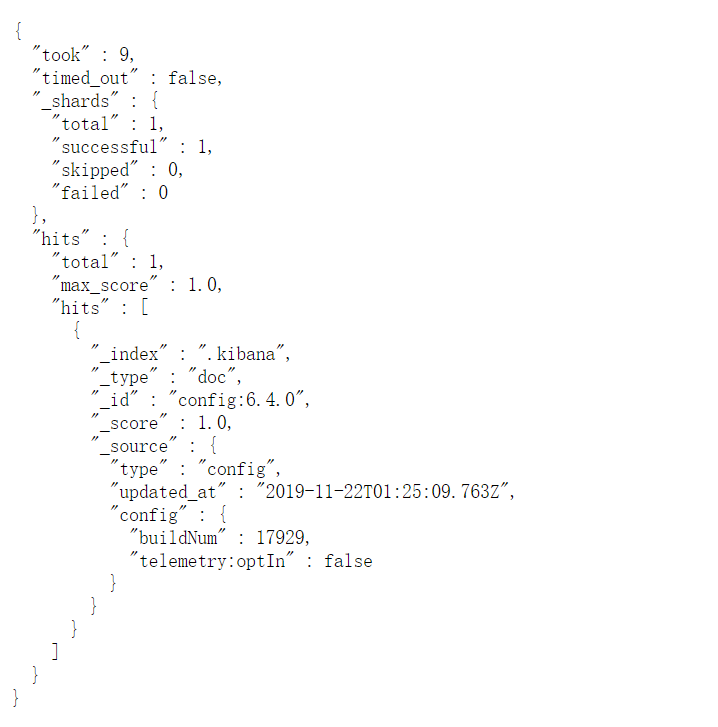

当然,目前没有任何可以显示的ES的索引和数据,再访问一下http://[Your-HostIP]:9200 看看ElasticSearch的API接口是否可用:

ElasticSearch API

Note:如果启动过程中发现一些错误,导致ELK容器无法启动,可以参考《Docker启动ElasticSearch报错》及《ElasticSearch启动常见错误》一文。如果你的主机内存低于4G,建议增加配置设置ES内存使用大小,以免启动不了。例如下面增加的配置,限制ES内存使用最大为1G:

docker run -it -d --name elk \

-p : \

-p : \

-p : \

-e ES_MIN_MEM=512m \

-e ES_MAX_MEM=1024m \

sebp/elk:

三、Filebeat配置

3.1 安装Filebeat

这里我们通过rpm的方式下载Filebeat,注意这里下载和我们ELK对应的版本(ELK是6.4.0,这里也是下载6.4.0,避免出现错误):

wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-6.4.0-x86_64.rpm

rpm -ivh filebeat-6.4.-x86_64.rpm

3.2 配置Filebeat

这里我们需要告诉Filebeat要监控哪些日志文件 及 将日志发送到哪里去,因此我们需要修改一下Filebeat的配置:

cd /etc/filebeat

vim filebeat.yml

要修改的内容为:

(1)监控哪些日志?

filebeat.inputs: # Each - is an input. Most options can be set at the input level, so

# you can use different inputs for various configurations.

# Below are the input specific configurations. - type: log # Change to true to enable this input configuration.

enabled: true # Paths that should be crawled and fetched. Glob based paths.

paths:

- /var/lib/docker/containers/*/*.log

- /var/log/syslog

这里指定paths:/var/lib/docker/containers/*/*.log,另外需要注意的是将 enabled 设为 true。

(2)将日志发到哪里?

#-------------------------- Elasticsearch output ------------------------------

output.elasticsearch:

# Array of hosts to connect to.

hosts: ["192.168.16.190:9200"] # Optional protocol and basic auth credentials.

#protocol: "https"

#username: "elastic"

#password: "changeme"

这里指定直接发送到ElasticSearch,配置一下ES的接口地址即可。

Note:如果要发到Logstash,请使用后面这段配置,将其取消注释进行相关配置即可:

#----------------------------- Logstash output --------------------------------

#output.logstash:

# The Logstash hosts

#hosts: ["localhost:5044"] # Optional SSL. By default is off.

# List of root certificates for HTTPS server verifications

#ssl.certificate_authorities: ["/etc/pki/root/ca.pem"] # Certificate for SSL client authentication

#ssl.certificate: "/etc/pki/client/cert.pem" # Client Certificate Key

#ssl.key: "/etc/pki/client/cert.key"

3.3 启动Filebeat

由于Filebeat在安装时已经注册为systemd的服务,所以只需要直接启动即可:

systemctl start filebeat.service

检查Filebeat启动状态:

systemctl status filebeat.service

3.4 验证Filebeat

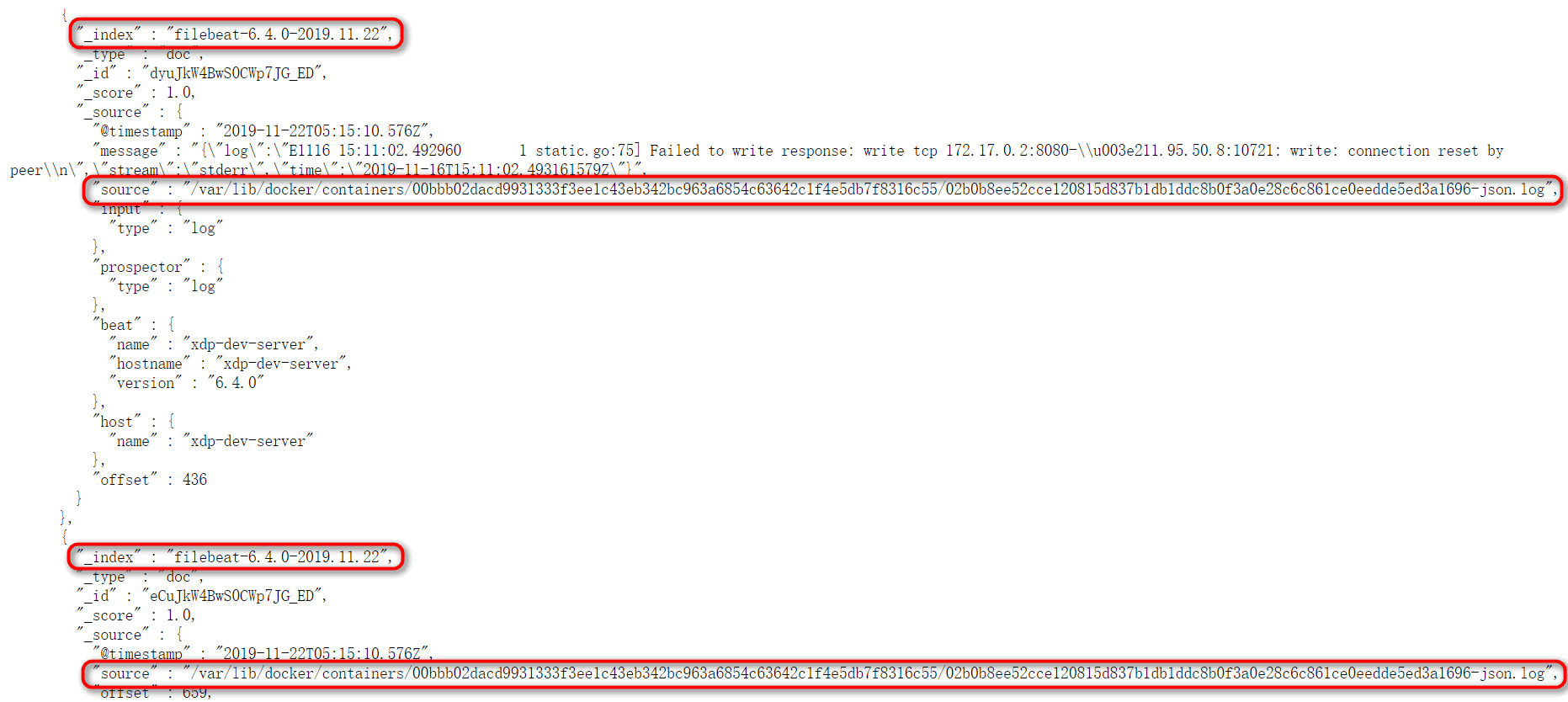

通过访问ElasticSearch API可以发现以下变化:ES建立了以filebeat-开头的索引,我们还能够看到其来源及具体的message。

四、Kibana配置

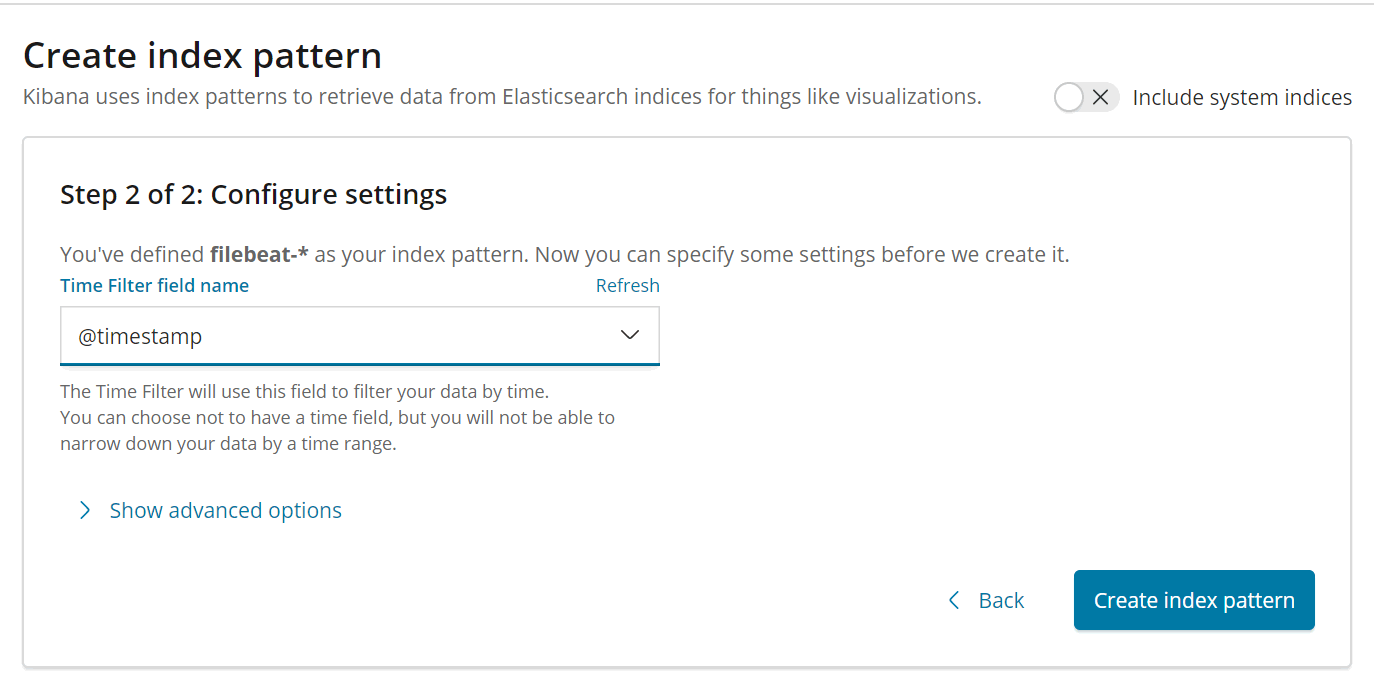

接下来我们就要告诉Kibana,要查询和分析ElasticSearch中的哪些日志,因此需要配置一个Index Pattern。从Filebeat中我们知道Index是filebeat-timestamp这种格式,因此这里我们定义Index Pattern为 filebeat-*

点击Next Step,这里我们选择Time Filter field name为@timestamp:

单击Create index pattern按钮,即可完成配置。

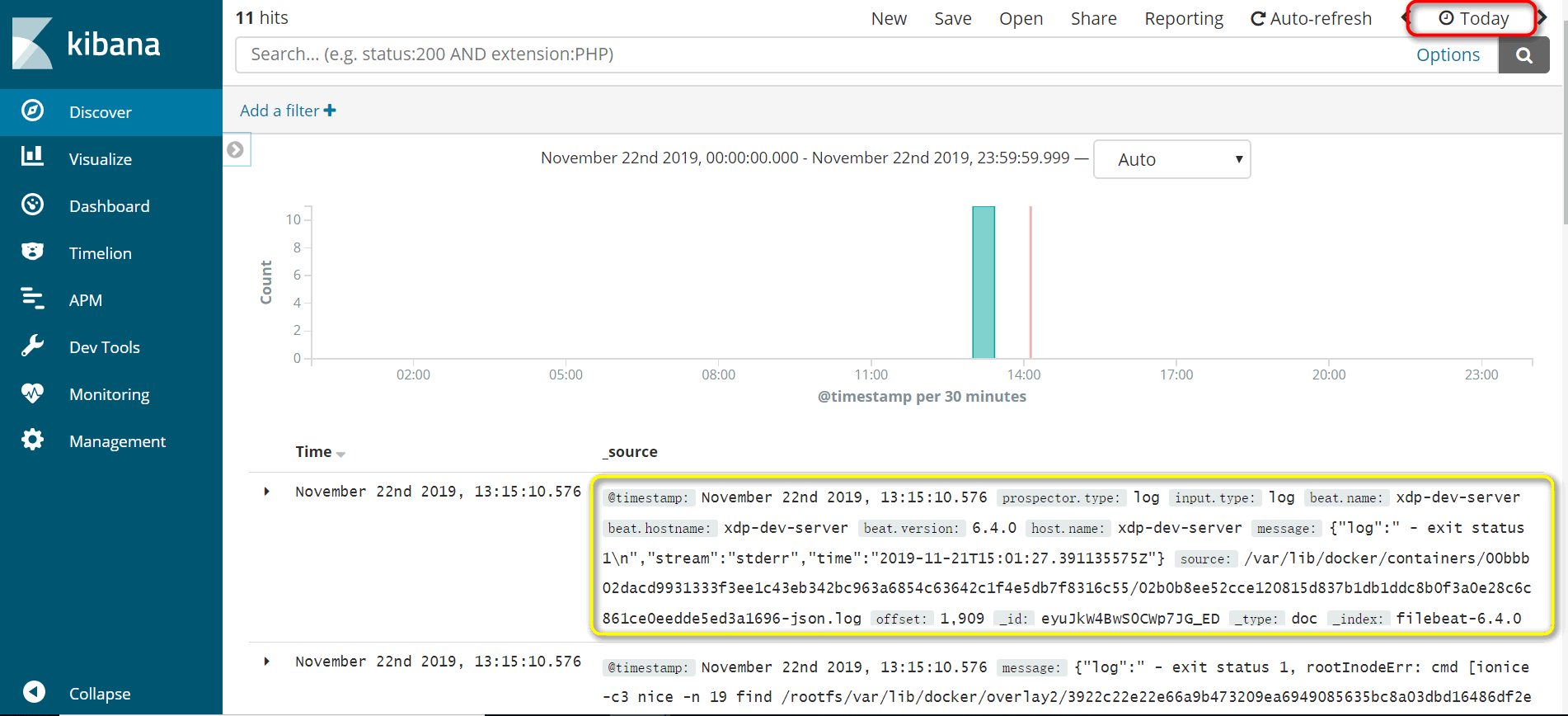

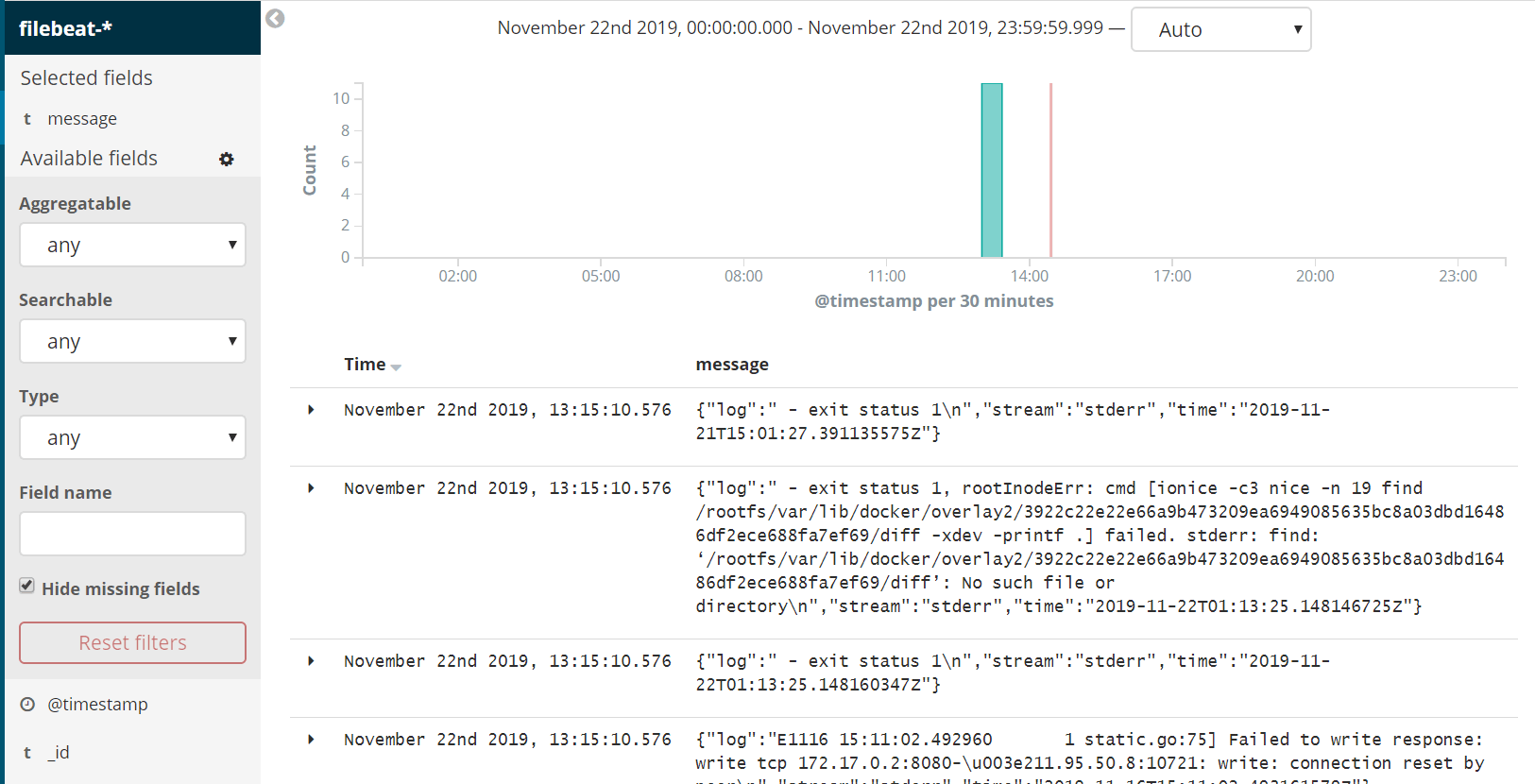

这时我们单击Kibana左侧的Discover菜单,即可看到容器的日志信息啦:

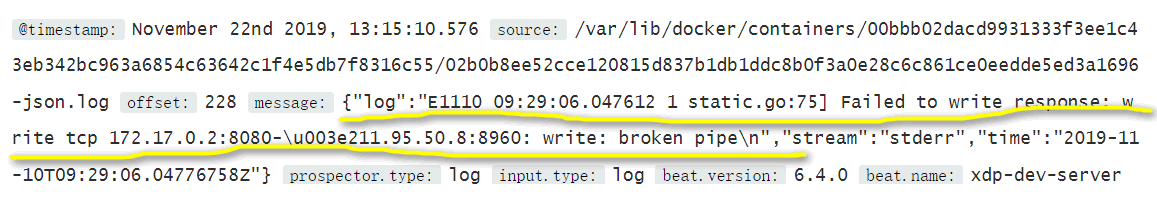

仔细看看细节,我们关注一下message字段:

可以看到,我们重点要关注的是message,因此我们也可以筛选一下只看这个字段的信息:

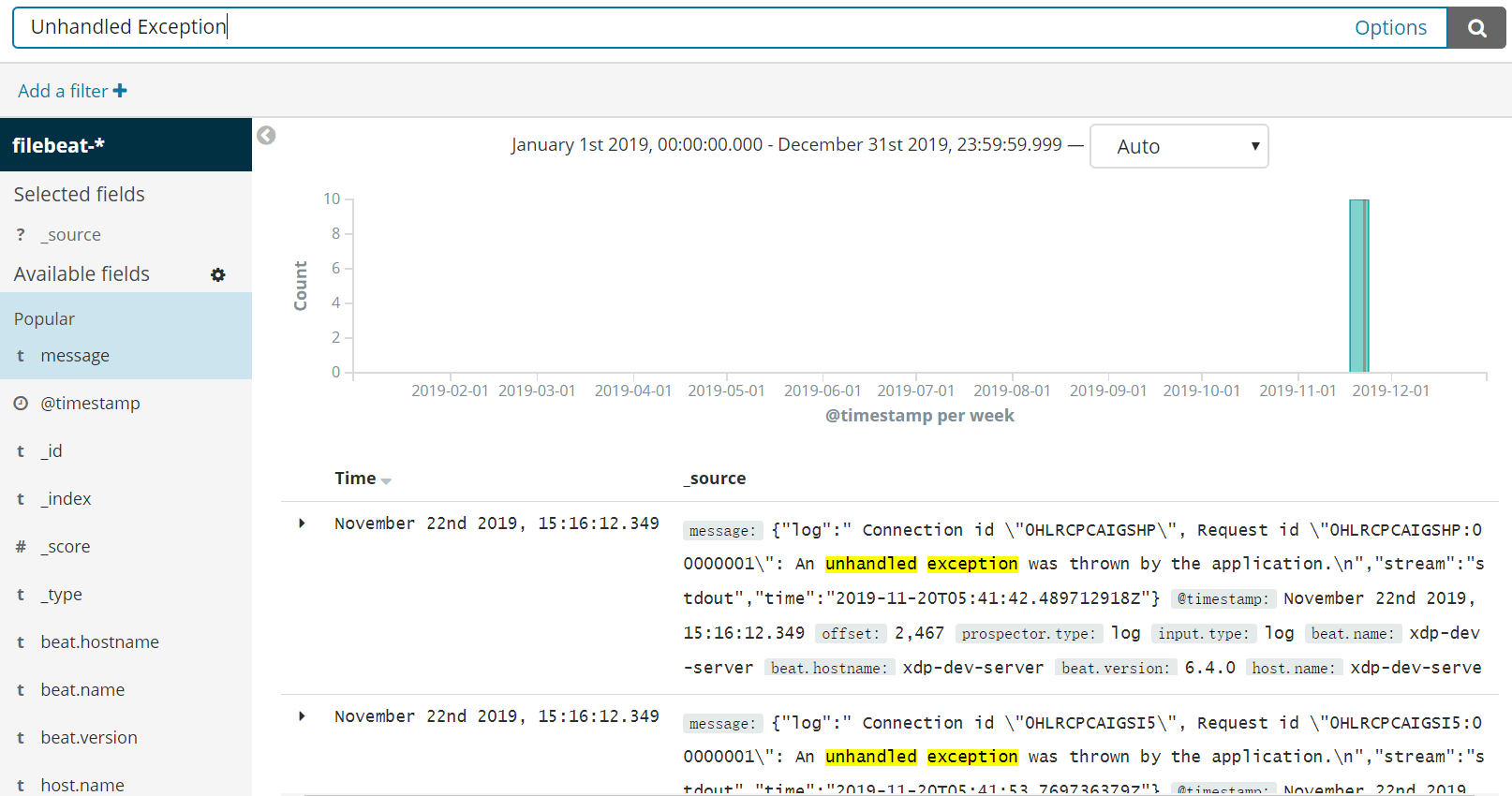

此外,Kibana还提供了搜索关键词的日志功能,例如这里我关注一下日志中包含unhandled exception(未处理异常)的日志信息:

这里只是朴素的展示了导入ELK的日志信息,实际上ELK还有很多很丰富的玩法,例如分析聚合、炫酷Dashboard等等。笔者在这里也是初步使用,就介绍到这里啦。

五、Fluentd引入

5.1 关于Fluentd

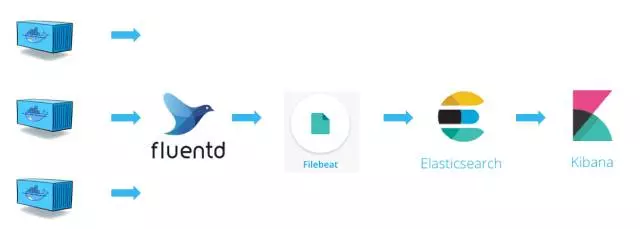

前面我们采用的是Filebeat收集Docker的日志信息,基于Docker默认的json-file这个logging driver,这里我们改用Fluentd这个开源项目来替换json-file收集容器的日志。

Fluentd是一个开源的数据收集器,专为处理数据流设计,使用JSON作为数据格式。它采用了插件式的架构,具有高可扩展性高可用性,同时还实现了高可靠的信息转发。Fluentd也是云原生基金会 (CNCF) 的成员项目之一,遵循Apache 2 License协议,其github地址为:https://github.com/fluent/fluentd/。Fluentd与Logstash相比,比占用内存更少、社区更活跃,两者的对比可以参考这篇文章《Fluentd vs Logstash》。

因此,整个日志收集与处理流程变为下图,我们用 Filebeat 将 Fluentd 收集到的日志转发给 Elasticsearch。

当然,我们也可以使用Fluentd的插件(fluent-plugin-elasticsearch)直接将日志发送给 Elasticsearch,可以根据自己的需要替换掉Filebeat,从而形成Fluentd => ElasticSearch => Kibana 的架构,也称作EFK。

5.2 运行Fluentd

这里我们通过容器来运行一个Fluentd采集器:

docker run -d -p : -p :/udp -v /edc/fluentd/log:/fluentd/log fluent/fluentd

默认Fluentd会使用24224端口,其日志会收集在我们映射的路径下。

此外,我们还需要修改Filebeat的配置文件,将/edc/fluentd/log加入监控目录下:

#=========================== Filebeat inputs ============================= filebeat.inputs: # Each - is an input. Most options can be set at the input level, so

# you can use different inputs for various configurations.

# Below are the input specific configurations. - type: log # Change to true to enable this input configuration.

enabled: true # Paths that should be crawled and fetched. Glob based paths.

paths:

- /edc/fluentd/log/*.log

添加监控配置之后,需要重新restart一下filebeat:

systemctl restart filebeat

5.3 运行测试容器

为了验证效果,这里我们Run两个容器,并分别制定其log-dirver为fluentd:

docker run -d \

--log-driver=fluentd \

--log-opt fluentd-address=localhost: \

--log-opt tag="test-docker-A" \

busybox sh -c 'while true; do echo "This is a log message from container A"; sleep 10; done;' docker run -d \

--log-driver=fluentd \

--log-opt fluentd-address=localhost: \

--log-opt tag="test-docker-B" \

busybox sh -c 'while true; do echo "This is a log message from container B"; sleep 10; done;'

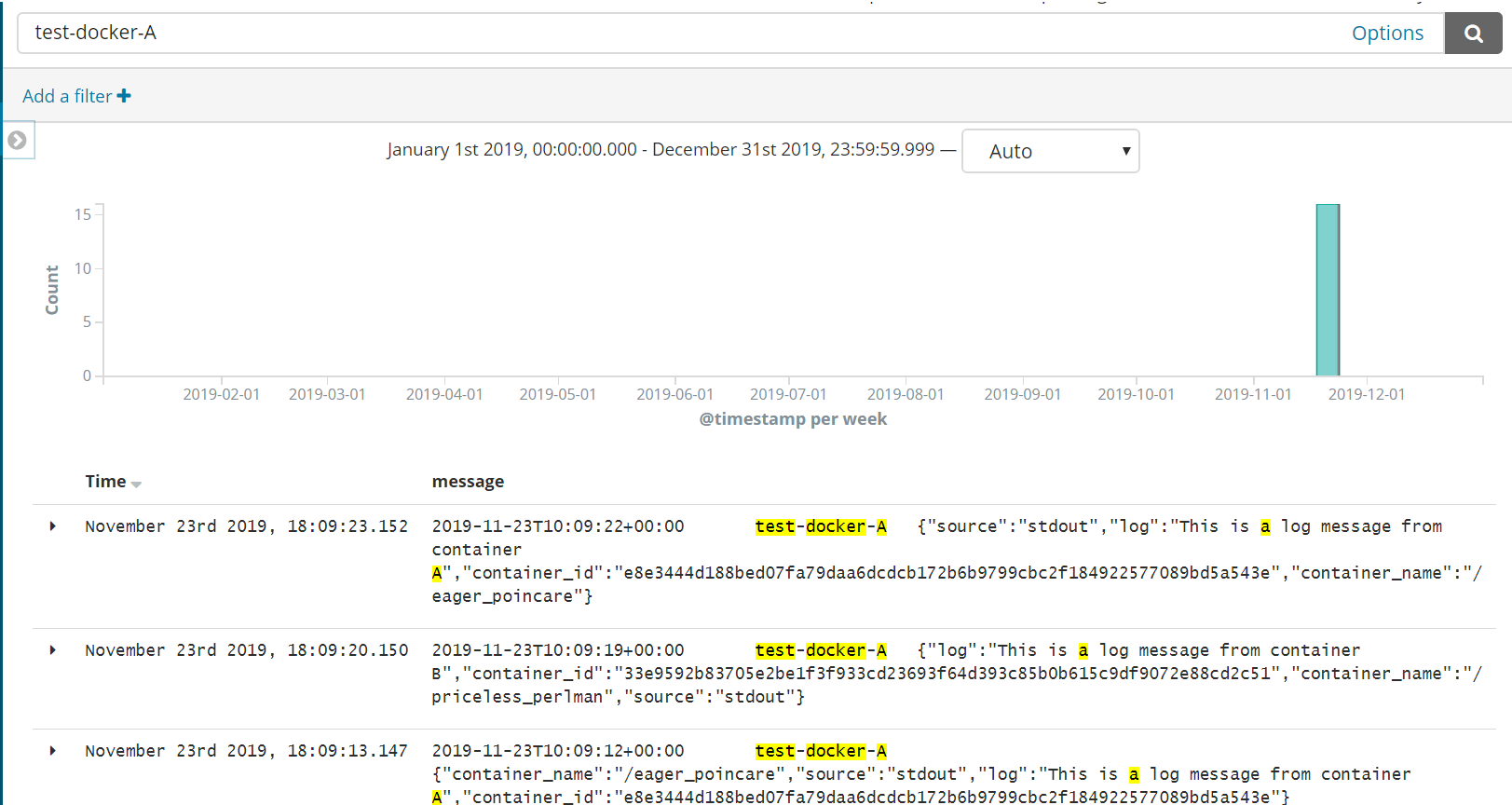

这里通过指定容器的log-driver,以及为每个容器设立了tag,方便我们后面验证查看日志。

5.4 验证EFK效果

这时再次进入Kibana中查看日志信息,便可以通过刚刚设置的tag信息筛选到刚刚添加的容器的日志信息了:

六、小结

本文从ELK的基本组成入手,介绍了ELK的基本处理流程,以及从0开始搭建了一个ELK环境,演示了基于Filebeat收集容器日志信息的案例。然后,通过引入Fluentd这个开源数据收集器,演示了如何基于EFK的日志收集案例。当然,ELK/EFK有很多的知识点,笔者也还只是初步使用,希望未来能够分享更多的实践总结。

参考资料

CloudMan,《每天5分钟玩转Docker容器技术》

一杯甜酒,《ELK学习总结》

于老三,《快速搭建ELK日志分析系统》

zpei0411,《Logstash beats系列 & Fluentd》

曹林华,《从ELK到EFK的演进》

你必须知道的容器日志 (2) 开源日志管理方案 ELK的更多相关文章

- 线上日志集中化可视化管理:ELK

本文来自网易云社区 作者:王贝 为什么推荐ELK: 当线上服务器出了问题,我们要做的最重要的事情是什么?当需要实时监控跟踪服务器的健康情况,我们又要拿什么去分析?大家一定会说,去看日志,去分析日志.是 ...

- 【开源】OSharp3.0框架解说系列(6.2):操作日志与数据日志

OSharp是什么? OSharp是个快速开发框架,但不是一个大而全的包罗万象的框架,严格的说,OSharp中什么都没有实现.与其他大而全的框架最大的不同点,就是OSharp只做抽象封装,不做实现.依 ...

- log4net--不可多得的开源日志记录组件

log4net--不可多得的开源日志记录组件 1 前奏 一直在用log4net日志工具,却没时间写个日志给大家分享一下这个工具,趁最近比较空些,好好分享一下这个工具. 2 说明 Log4net介绍就不 ...

- 爆料喽!!!开源日志库Logger的剖析分析

导读 Logger类提供了多种方法来处理日志活动.上一篇介绍了开源日志库Logger的使用,今天我主要来分析Logger实现的原理. 库的整体架构图 详细剖析 我们从使用的角度来对Logger库抽茧剥 ...

- 爆料喽!!!开源日志库Logger的使用秘籍

日志对于开发来说是非常重要的,不管是调试数据查看.bug问题追踪定位.数据信息收集统计,日常工作运行维护等等,都大量的使用到.今天介绍著名开源日志库Logger的使用,库的地址:https://git ...

- C++日志操作开源函数库之Google-glog

今天想给我的C++项目找一个开源的日志类,用于记录系统日志,结果浪费了半个下午的时间.从网上搜索相关资料,找到以下几个备选方案: 1.log4cplus 下载地址:http://sourceforge ...

- 开源日志系统 log4c 使用心得+总结

http://blog.csdn.net/sky_qing/article/details/7208645 一.安装: 我看网上好多人介绍log4c安装的时候都说有两个步骤:先下载expat安装包并安 ...

- C# 超高速高性能写日志 代码开源

1.需求 需求很简单,就是在C#开发中高速写日志.比如在高并发,高流量的地方需要写日志.我们知道程序在操作磁盘时是比较耗时的,所以我们把日志写到磁盘上会有一定的时间耗在上面,这些并不是我们想看到的. ...

- [Kubernetes]容器日志的收集与管理

在开始这篇文章之前,首先要明确一点: Kubernetes 中对容器日志的处理方式,都叫做 cluster-level-logging ,也就是说,这个日志处理系统,与容器, Pod 以及 Node ...

随机推荐

- ArcGIS Engine空间查询功能的实现(QueryFilterClass+SpatialFilterClass)

地图中包含大量的信息,为了快速地了解所需信息,必须借助为空间数据专门编写的空间查询功能. 空间查询主要有两种类型: 基于属性的查询,也称为属性查询. 基于空间位置的查询,也称为空间查询. 查询类的基本 ...

- VMware安装和linux(centos7)系统安装

下载centos系统ISO镜像 安装linux系统和winsdows安装系统一样,需要系统文件.浏览器访问centos官网进行下载,http://www.centos.org,因为是国外网站所有下载速 ...

- 解决html连续字符或数字换行的问题

word-break: break-all; word-wrap:break-word; 强制换行

- C加加学习之路 1——开始

C++是一门古老而复杂的语言,绝不是一门可以速成的语言,学习它需要有意识的刻意练习和长时间的持续不断的磨练.而大多数人不太能耐得住寂寞,喜欢速成,所以像<21天学通C++>这种书就比较受欢 ...

- JAVA必知必问问题-1

数据类型 1) 基本类型: byte, int, long, float, double, boolean.... 要求记住基本类型占多少字节.范围.例如:byte 1字节范围-128-127,sho ...

- fiddler的过滤

1.User Fiters启用 2.Action Action:Run Filterset now是否运行,Load Filterset加载,Save Filterset保存: 3.Hosts过滤 Z ...

- Caused by: org.springframework.context.annotation.ConflictingBeanDefinitionException 异常

Caused by: org.springframework.context.annotation.ConflictingBeanDefinitionException 报此异常是应为有相同的bean ...

- phpstorm 2016.2.2 激活

2016年7月14日 phpstorm 推送2016.2 更新 2016年10月25日phpstorm 推送2016.2.2 更新 2016年11月24日phpstorm 推送2016.3 更新 下面 ...

- 你还在用BeanUtils进行对象属性拷贝?

在做业务的时候,为了隔离变化,我们会将DAO查询出来的DO和对前端提供的DTO隔离开来.大概90%的时候,它们的结构都是类似的:但是我们很不喜欢写很多冗长的b.setF1(a.getF1())这样的代 ...

- IDEA复制多行及对多行代码上下左右移动

复制: 复制一行可不需要选中 多行需要选中 mac:command+D window:ctrl+D 移动: 选中代码 左移:tab+shift 右移:tab 上移:shift+alt+向上方向键 下移 ...