Python网络爬虫实战(三)照片定位与B站弹幕

之前两篇已经说完了如何爬取网页以及如何解析其中的数据,那么今天我们就可以开始第一次实战了。

这篇实战包含两个内容。

* 利用爬虫调用Api来解析照片的拍摄位置

* 利用爬虫爬取Bilibili视频中的弹幕

关于爬虫调用Api这一说法,其实就是通过get或者post请求携带着参数,将内容发给对方服务器,服务器会根据请求的Api是哪个来进行处理。

比如说/delete?id=2和/save?id=1&name=antz这两个请求就分别是删除id等于2的数据,保存一条id等于1姓名为antz的数据。

此时我们就只需要向对方服务器发送出这个请求就可以了,requests.get(url)就这么简单。

一.根据照片解析定位

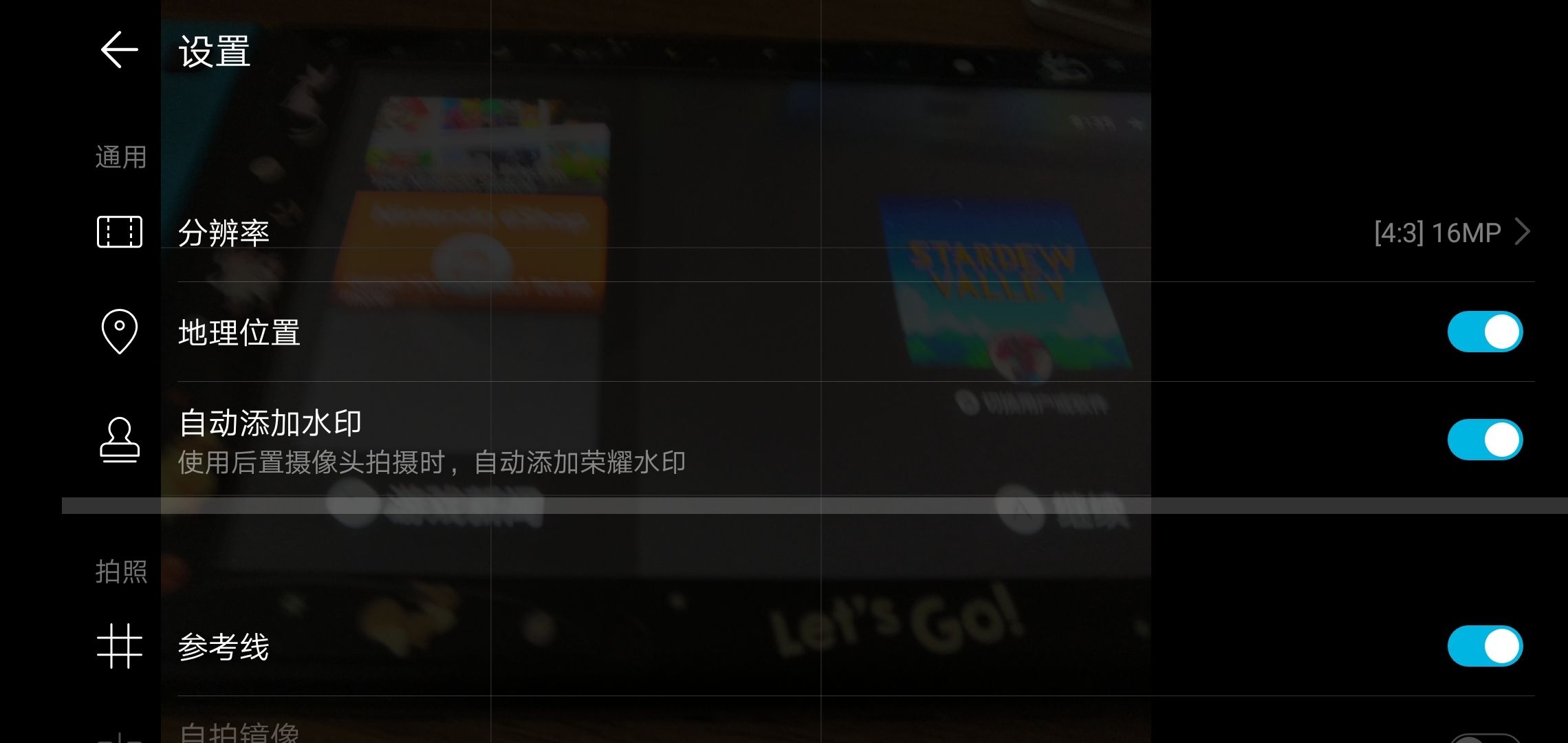

不知道你平常拍照片有没有在你手机的设置里仔细查看过,比如说下面这个选项【地理位置】。

打开它之后,我拍的照片上也没有显示地理位置啊?

这是因为这些数据被放在了照片文件数据里面,可能你很难理解,你可以回想一下之前我们说的get之后的响应,响应体分为响应头和响应体。照片的数据也是一样,有信息头(随便叫的)和数据体,信息头里面有你这张照片的各种信息,拍摄时间地点设备等,而数据体就是你用看图软件打开时显示在你眼中的那些了,我们平常关注到的只有数据体,只关心照片是不是好看,而信息头的内容对我们来说其实无关紧要。

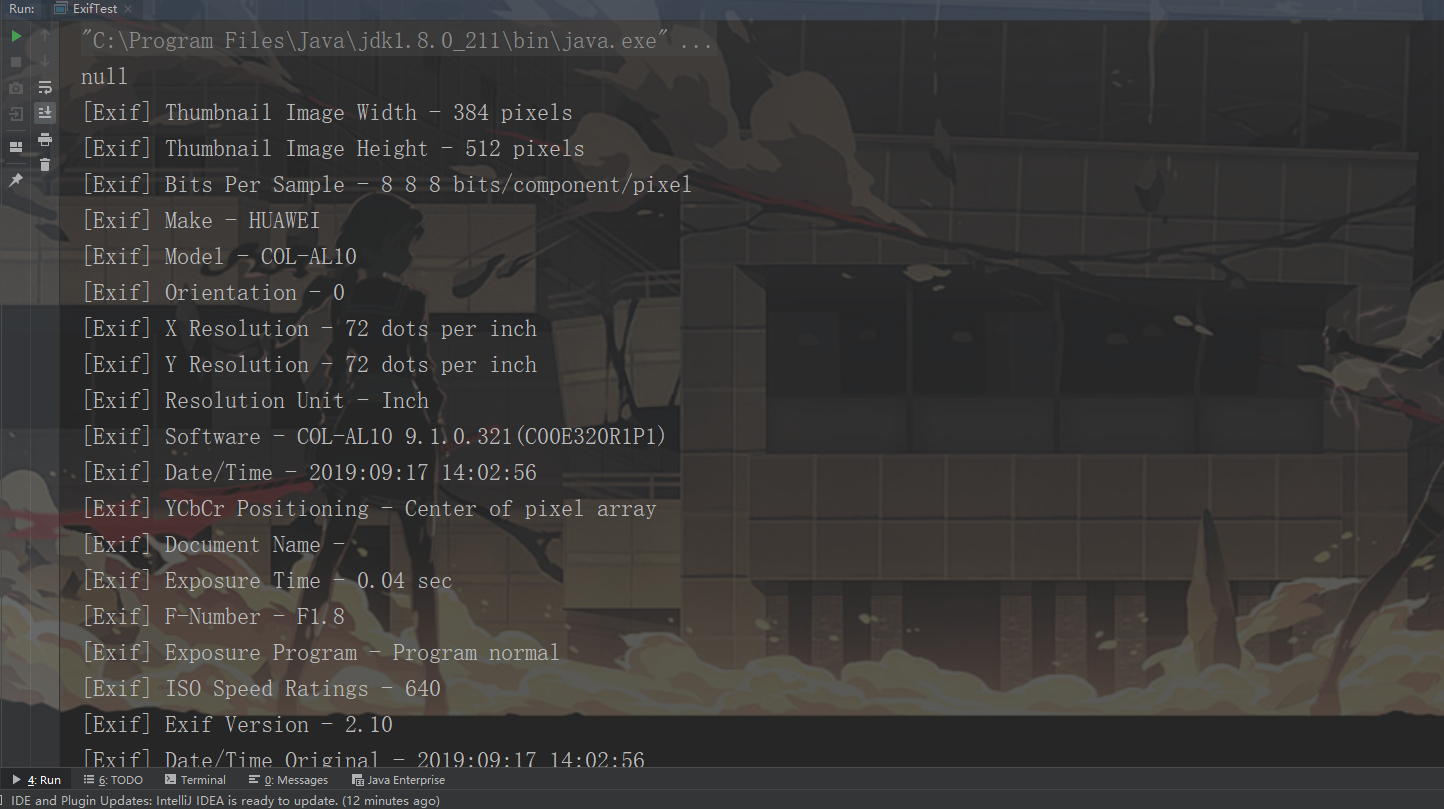

下面是我之前拍的一张照片经过解析获得的信息头数据,从里面可以看到照片尺寸,我的Make设备是HUAWEI,我的镜头数据,时间等等。

在Python中我们可以使用exifread库来解析图片的头信息。

pip install exifread

调用exifread的process_file方法,参数传入file,就可以得到照片的exif信息了。

img_exif = exifread.process_file(open("路径", 'rb'))

返回的img_exif是一个字典数据,我们可以直接根据上面那张头数据里面的标题来拿到对应的数据。

# 纬度数

latitude_gps = img_exif['GPS GPSLatitude']

# N,S 南北纬方向

latitude_direction = img_exif['GPS GPSLatitudeRef']

# 经度数

longitude_gps = img_exif['GPS GPSLongitude']

# E,W 东西经方向

longitude_direction = img_exif['GPS GPSLongitudeRef']

这样我们就拿到南北纬以及经纬度了。

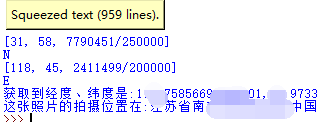

那么如何根据这些数据来获得定位呢?

我们可以利用高德地图开放的Api来将经纬度转换为我们能够直接读懂的位置信息。

url = 'https://restapi.amap.com/v3/geocode/regeo?key={}&location={}'

上面是高德地图逆向解析定位的api地址,key需要在高德地图官网申请开发者之后拿到(很容易),location就是经纬度南北纬信息了。

resp = requests.get(url.format(api_key, location))

location_data = json.loads(resp.text)

address = location_data.get('regeocode').get('formatted_address')

上面的代码是不是已经很简单了,requests.get请求api拿到对方返回的结果,返回的数据的json数据,所以loads解析之后直接拿address即可。

这样我们就可以拿到这张照片的拍摄地点了。

二.Bilibili弹幕爬虫

先来思考一个问题,B站一个视频的弹幕最多会有多少?

比较多的会有2000条吧,这么多数据,B站肯定是不会直接把弹幕和这个视频绑在一起的。

也就是说,有一个视频地址为https://www.bilibili.com/video/av67946325,你如果直接去requests.get这个地址,里面是不会有弹幕的,回想第一篇说到的携程异步加载数据的方式,B站的弹幕也一定是先加载当前视频的界面,然后再异步填充弹幕的。

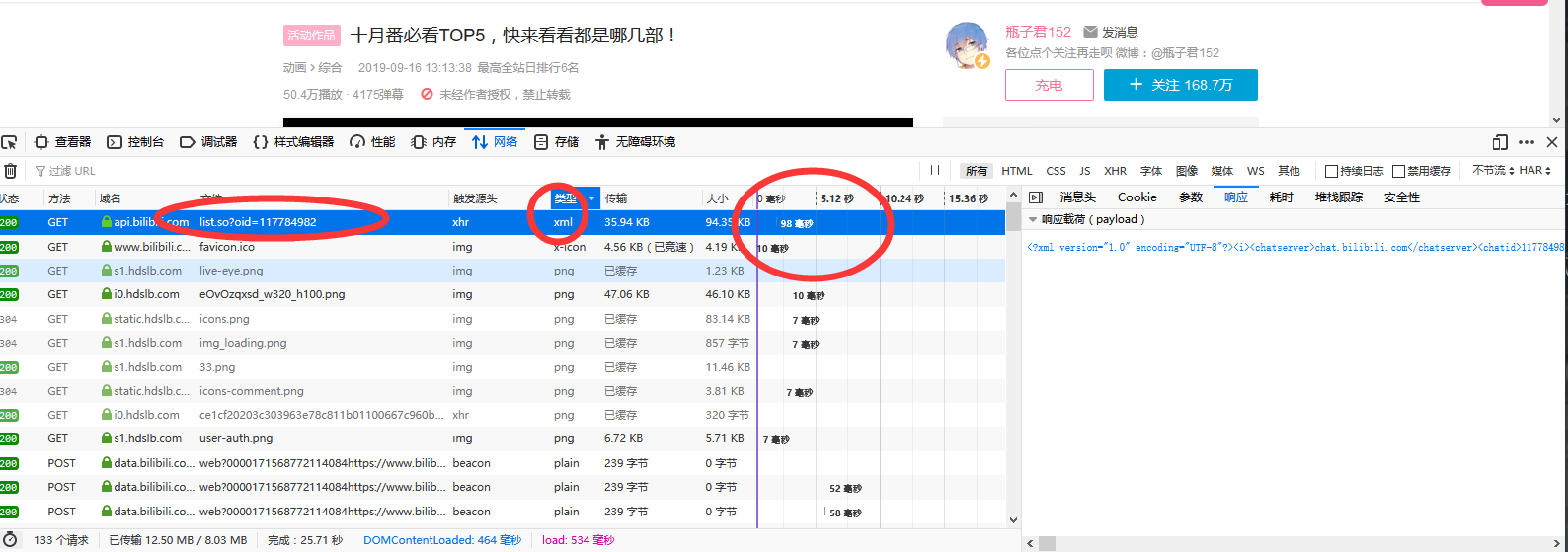

接下来我们就可以打开火狐浏览器(平常可以火狐谷歌控制台都使用,因为谷歌里面因为插件被拦截下来的包在火狐可以抓到,同理谷歌也是)的控制台来观察网络请求了。

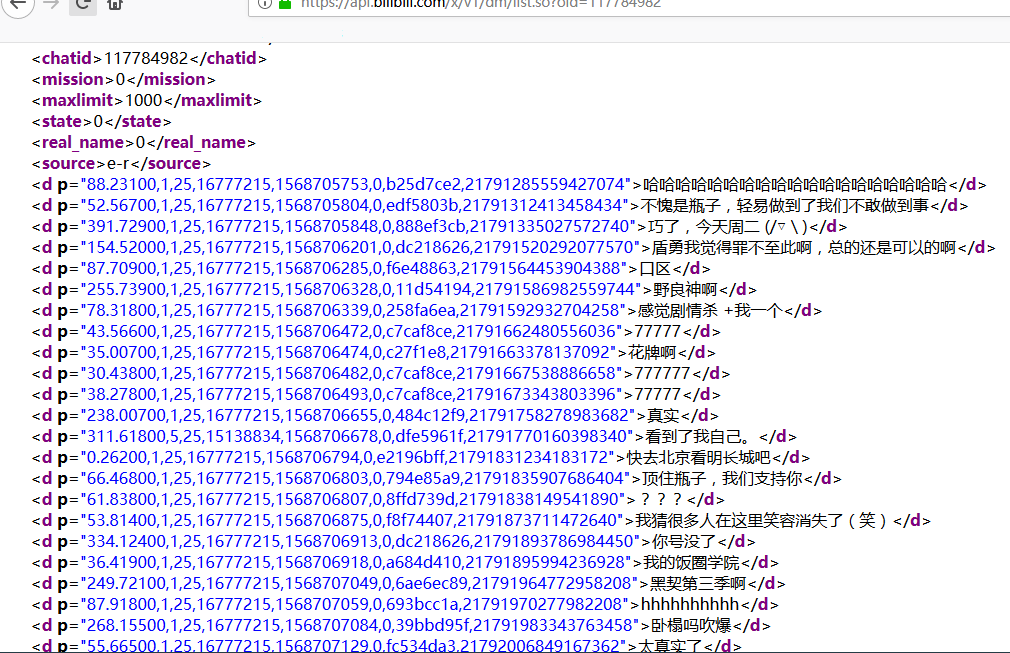

经过仔细排查之后,我找到了一个请求xml的,它后面跟了一个oid,查看它的响应内容之后可以发现它就是弹幕文件。

它的响应时间98毫秒,远超其它几个响应,所以说如果把弹幕直接放在视频页面,用户体验一定会很差。

找到弹幕了,爬取它很容易,但是我们想要是爬取固定av号视频的弹幕,而不是说随意去找一个oid来爬取弹幕,这样我们都不知道爬下来的弹幕是哪个视频的。

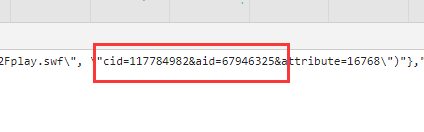

接下来我们就可以复制oid的117784982值,去视频页面搜索看看了,通过视频来获得它的oid再来爬xml弹幕就很方便了。

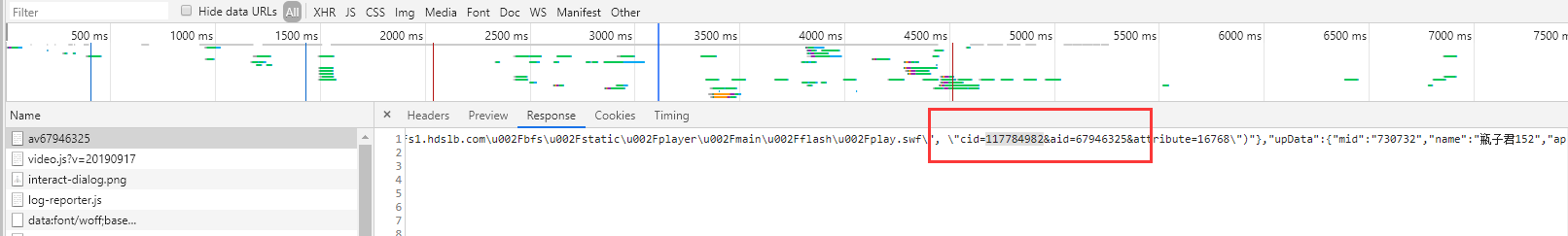

这次用了谷歌浏览器,在里面通过搜索oid果然搜索到相关的数据了。

其中cid是弹幕对应的id,aid对应视频av号。

先把这个页面爬取下来。

# encoding: utf-8

import requests

headers = {

'User-Agent':'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36',

'Accept': 'text/html',

'Cookie': "_uuid=1DBA4F96-2E63-8488-DC25-B8623EFF40E773841infoc; buvid3=FE0D3174-E871-4A3E-877C-A4ED86E20523155831infoc; LIVE_BUVID=AUTO8515670521735348; sid=l765gx48; DedeUserID=33717177; DedeUserID__ckMd5=be4de02fd64f0e56; SESSDATA=cf65a5e0%2C1569644183%2Cc4de7381; bili_jct=1e8cdbb5755b4ecd0346761a121650f5; CURRENT_FNVAL=16; stardustvideo=1; rpdid=|(umY))|ukl~0J'ulY~uJm)kJ; UM_distinctid=16ce0e51cf0abc-02da63c2df0b4b-5373e62-1fa400-16ce0e51cf18d8; stardustpgcv=0606; im_notify_type_33717177=0; finger=b3372c5f; CURRENT_QUALITY=112; bp_t_offset_33717177=300203628285382610"

}

resp = requests.get('https://www.bilibili.com/video/av67946325',headers=headers)

print(resp.text)

拿到了内容我们就要从中解析弹幕id了,对于这种规则紊乱的网页,我们就不能用上一篇中Bs4解析了,而是使用正则表达式。

正则表达式最简单的使用方式其实就是直接match。

re.search(匹配规则,文本).group()

观察这里的内容,我们大致的匹配规则就有了。

cid={目标}&aid=av号

117784982就是我们的目标。

av_id = '67946325'

resp = requests.get('https://www.bilibili.com/video/av'+av_id,headers=headers)

match_rule = r'cid=(.*?)&aid'

oid = re.search(match_rule,resp.text).group().replace('cid=','').replace('&aid','')

print('oid='+oid)

先根据av号拿到视频页面,然后解析视频页面拿到oid,最后用oid去请求xml弹幕文件。

xml_url = 'https://api.bilibili.com/x/v1/dm/list.so?oid='+oid

resp = requests.get(xml_url,headers=headers)

print(resp)

这样我们就完成B站弹幕爬虫了。

Python网络爬虫实战(三)照片定位与B站弹幕的更多相关文章

- python网络爬虫实战PDF高清完整版免费下载|百度云盘|Python基础教程免费电子书

点击获取提取码:vg1y python网络爬虫实战帮助读者学习Python并开发出符合自己要求的网络爬虫.网络爬虫,又被称为网页蜘蛛,网络机器人,是一种按照一定的规则,自动地抓取互联网信息的程序或者脚 ...

- 关于Python网络爬虫实战笔记③

Python网络爬虫实战笔记③如何下载韩寒博客文章 Python网络爬虫实战笔记③如何下载韩寒博客文章 target:下载全部的文章 1. 博客列表页面规则 也就是, http://blog.sina ...

- 关于Python网络爬虫实战笔记①

python网络爬虫项目实战笔记①如何下载韩寒的博客文章 python网络爬虫项目实战笔记①如何下载韩寒的博客文章 1. 打开韩寒博客列表页面 http://blog.sina.com.cn/s/ar ...

- Python网络爬虫实战(一)快速入门

本系列从零开始阐述如何编写Python网络爬虫,以及网络爬虫中容易遇到的问题,比如具有反爬,加密的网站,还有爬虫拿不到数据,以及登录验证等问题,会伴随大量网站的爬虫实战来进行. 我们编写网络爬虫最主要 ...

- python网络爬虫实战之快速入门

本系列从零开始阐述如何编写Python网络爬虫,以及网络爬虫中容易遇到的问题,比如具有反爬,加密的网站,还有爬虫拿不到数据,以及登录验证等问题,会伴随大量网站的爬虫实战来进行. 我们编写网络爬虫最主要 ...

- Python网络爬虫实战:根据天猫胸罩销售数据分析中国女性胸部大小分布

本文实现一个非常有趣的项目,这个项目是关于胸罩销售数据分析的.是网络爬虫和数据分析的综合应用项目.本项目会从天猫抓取胸罩销售数据,并将这些数据保存到SQLite数据库中,然后对数据进行清洗,最后通过S ...

- Python网络爬虫实战入门

一.网络爬虫 网络爬虫(又被称为网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取万维网信息的程序. 爬虫的基本流程: 发起请求: 通过HTTP库向目标站点发起请求,也就是发送一个Request ...

- python网络爬虫(三)requests库的13个控制访问参数及简单案例

酱酱~小编又来啦~

- [Python]网络爬虫(三):异常的处理和HTTP状态码的分类

先来说一说HTTP的异常处理问题. 当urlopen不能够处理一个response时,产生urlError. 不过通常的Python APIs异常如ValueError,TypeError等也会同时产 ...

随机推荐

- leetcode bug free

---不包含jiuzhang ladders中出现过的题.如出现多个方法,则最后一个方法是最优解. 目录: 1 String 2 Two pointers 3 Array 4 DFS &&am ...

- 使用 Docker 部署 Spring Boot

Docker 技术发展为微服务落地提供了更加便利的环境,使用 Docker 部署 Spring Boot 其实非常简单,这篇文章我们就来简单学习下. 首先构建一个简单的 Spring Boot 项目, ...

- windows安装nginx、mysql等软件并加入系统服务启动详细

windows类系统安装nginx.mysql软件 (PS:windows系统环境中设置完nginx.mysql环境变量,需要重新启动系统才会生效.) 一.NGINX:首先下载windows版ngin ...

- day01计算机硬件基础

1.cpu\内存\硬盘 2.存储器 操作系统 是什么 为什么 如何用 1.什么是编程语言: 语言是一个事物与另一个事物沟通的表达方式 编程语言即程序员与计算机沟通的介质 计算机是程序员的奴隶 2.什么 ...

- 剑指Offer(十九):顺时针打印矩阵

剑指Offer(十九):顺时针打印矩阵 搜索微信公众号:'AI-ming3526'或者'计算机视觉这件小事' 获取更多算法.机器学习干货 csdn:https://blog.csdn.net/baid ...

- 实战jmeter入门压测接口性能

什么是Jmeter? 是Apache组织开发的基于Java的压力测试工具. 准备工作: 一.安装配置好环境及压测工具 Jmeter下载地址:http://mirrors.tuna.tsinghua.e ...

- excel表格导出之后身份证号列变成了科学计数法

excel表格导出之后身份证号列变成了科学计数法 解决:写sql查询出所有数据,并在身份证列添加字符,然后导出,将要复制的excel表格设置单元格格式问文本类型,然后复制粘贴,再把加入的字符删除,搞定 ...

- unity编辑器扩展_04(使用Selection获取选择的游戏物体)

代码: [MenuItem("Tools/GetChance", false, 1)] static void GetChance() { if (Sel ...

- Leetcode之深度优先搜索(DFS)专题-494. 目标和(Target Sum)

Leetcode之深度优先搜索(DFS)专题-494. 目标和(Target Sum) 深度优先搜索的解题详细介绍,点击 给定一个非负整数数组,a1, a2, ..., an, 和一个目标数,S.现在 ...

- Python中绘制场景热力图

我们在做诸如人群密集度等可视化的时候,可能会考虑使用热力图,在Python中能很方便地绘制热力图. 下面以识别图片中的行人,并绘制热力图为例进行讲解. 步骤1:首先识别图像中的人,得到bounding ...