NiFi使用总结 一 hive到hive的PutHiveStreaming processor和SelectHiveQL

我说实话,NiFi的坑真的挺多的。。。

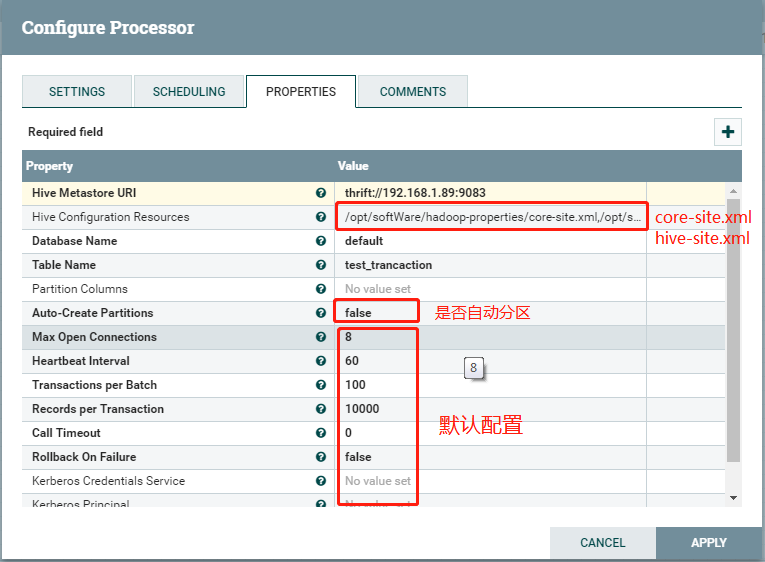

1、PutHiveStreaming processor的使用

具体配置可参考:https://community.hortonworks.com/articles/88309/using-puthivestreaming-processor-in-nifi.html

该控制器配置需要hive启用事物;且目前只支持orc格式,且建表需要分桶,开启事务等,建表示例如下:

create table test_trancaction

(user_id Int,name String)

clustered by (user_id) into 3 buckets

stored as orc TBLPROPERTIES ('transactional'='true');

hive的事物配置,hive-site.xml配置添加:

<!--start for trancaction --> <property>

<name>hive.support.concurrency</name>

<value>true</value>

</property> <property>

<name>hive.enforce.bucketing</name>

<value>true</value>

</property> <property>

<name>hive.exec.dynamic.partition.mode</name>

<value>nonstrict</value>

</property> <property>

<name>hive.txn.manager</name>

<value>org.apache.hadoop.hive.ql.lockmgr.DbTxnManager</value>

</property> <property>

<name>hive.compactor.initiator.on</name>

<value>true</value>

</property> <property>

<name>hive.compactor.worker.threads</name>

<value>1</value>

</property>

hive的事物性配置、验证参考:https://my.oschina.net/wangjiankui/blog/711942

具体配置:

PutHiveStreaming

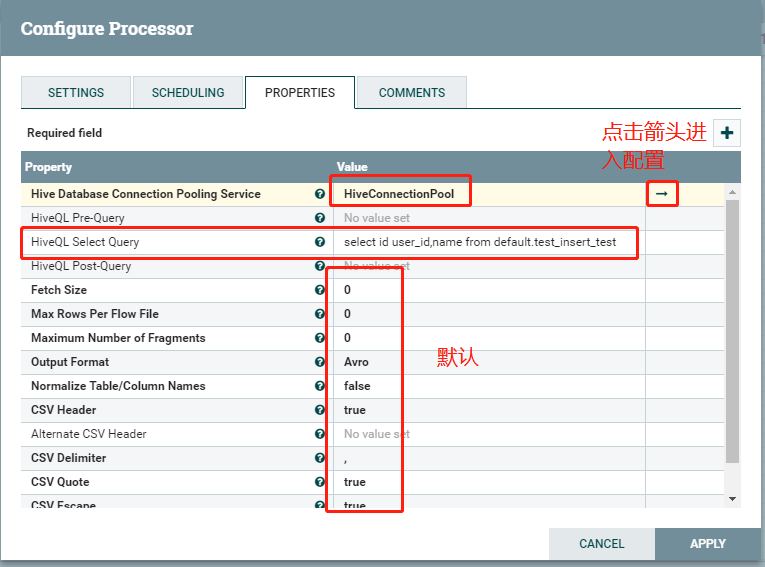

SelectHiveQL:

双击,进入config配置:

HiveConnectionPool配置:

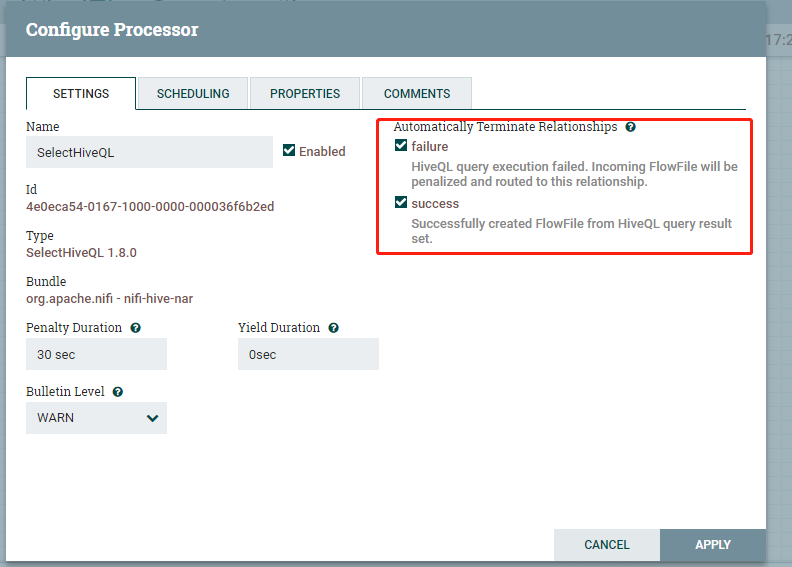

勾选自动终止关系类型:可以都选上

选择调度策略:

有三种,常用的有time driven,CRON driven

简单测试使用Run Schedule不要用0秒,不然会一直不停的在写入数据。。。

有关调度策略下篇在做具体说明

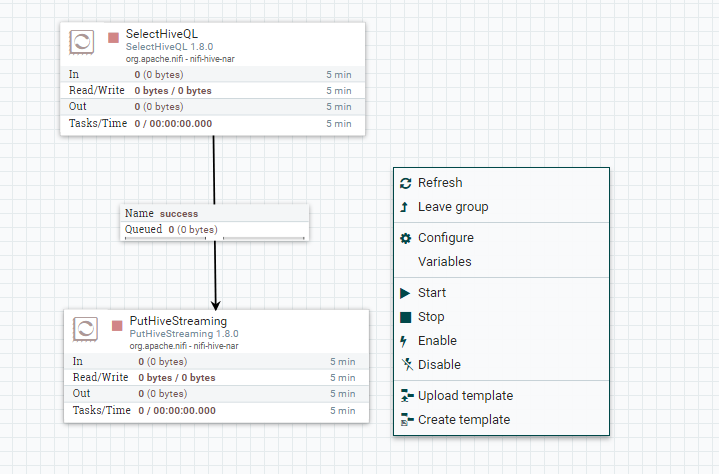

运行一下看看:

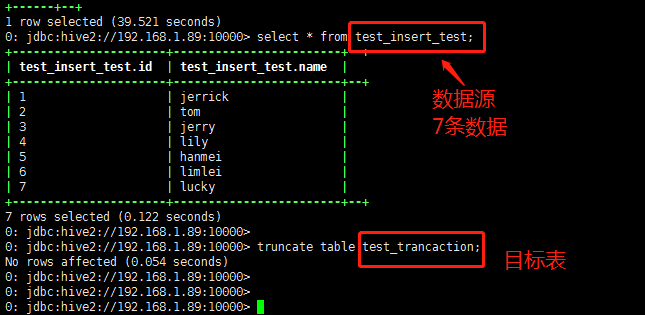

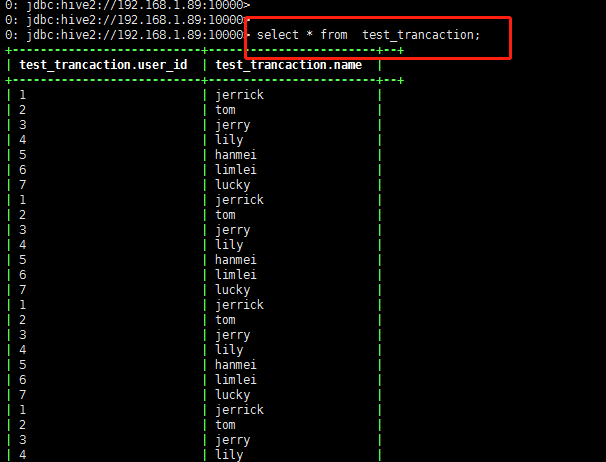

源数据:

配置好之后右键点击start

过一分钟左右查看插入数据:

条数有可能不止14条,后续再研究调度的程序设置;

到此为止简单实现了hive-hive的配置

NiFi使用总结 一 hive到hive的PutHiveStreaming processor和SelectHiveQL的更多相关文章

- 【hive】——Hive四种数据导入方式

Hive的几种常见的数据导入方式这里介绍四种:(1).从本地文件系统中导入数据到Hive表:(2).从HDFS上导入数据到Hive表:(3).从别的表中查询出相应的数据并导入到Hive表中:(4).在 ...

- ubuntu下搭建hive(包括hive的web接口)记录

Hive版本 0.12.0(独立模式) Hadoop版本 1.12.1 Ubuntu 版本 12.10 今天试着搭建了hive,差点迷失在了网上各种资料中,现在把我的经验分享给大家,亲手实践过,但未必 ...

- [Hive - LanguageManual] Hive Concurrency Model (待)

Hive Concurrency Model Hive Concurrency Model Use Cases Turn Off Concurrency Debugging Configuration ...

- Shell脚本运行hive语句 | hive以日期建立分区表 | linux schedule程序 | sed替换文件字符串 | shell推断hdfs文件文件夹是否存在

#!/bin/bash source /etc/profile; ################################################## # Author: ouyang ...

- Hive记录-Hive介绍(转载)

1.Hive是什么? Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的 SQL 查询功能,将类 SQL 语句转换为 MapReduce 任务执 ...

- Hive记录-Hive on Spark环境部署

1.hive执行引擎 Hive默认使用MapReduce作为执行引擎,即Hive on mr.实际上,Hive还可以使用Tez和Spark作为其执行引擎,分别为Hive on Tez和Hive on ...

- Ambari配置Hive,Hive的使用

mysql安装,hive环境的搭建 ambari部署hadoop 博客大牛:董的博客 ambari使用 ambari官方文档 hadoop 2.0 详细配置教程 使用Ambari快速部署Hadoop大 ...

- Hive之 hive的三种使用方式(CLI、HWI、Thrift)

Hive有三种使用方式——CLI命令行,HWI(hie web interface)浏览器 以及 Thrift客户端连接方式. 1.hive 命令行模式 直接输入/hive/bin/hive的执行程 ...

- Hive之 hive架构

Hive架构图 主要分为以下几个部分: 用户接口,包括 命令行CLI,Client,Web界面WUI,JDBC/ODBC接口等 中间件:包括thrift接口和JDBC/ODBC的服务端,用于整合Hiv ...

随机推荐

- 第09组 Beta冲刺(1/5)

队名:观光队 链接 组长博客 作业博客 组员实践情况 王耀鑫 过去两天完成了哪些任务 文字/口头描述 任务分配 展示GitHub当日代码/文档签入记录 接下来的计划 完成短租车,页面美化 还剩下哪些任 ...

- Kubernetes 学习(八)Kubernetes 源码阅读之初级篇------源码及依赖下载

0. 前言 阅读了一段时间 Golang 开源代码,准备正式阅读 Kubernetes 项目代码(工作机 Golang 版本为 Go 1.12) 参照 <k8s 源码阅读> 选择 1.13 ...

- [MSSQL]找出一天数据中从第一条数据开始每累加1小时的数据

用Sql Server找出一天数据中从第一条数据开始每累加1小时的数据 -- ============================================= -- Author: Alle ...

- 论文阅读: Building a 3-D Line-Based Map Using Stereo SLAM

Abstract 一个把直线用作feature的SLAM系统. 跟点相比, 直线对于环境的结构提供了更丰富的信息, 也让其鞥有可能推断地图的空间语义. 使用了Plucker line coordian ...

- sort和sorted

sort 与 sorted 区别: sort 是应用在 list 上的方法,sorted 可以对所有可迭代的对象进行排序操作. list 的 sort 方法返回的是对已经存在的列表进行操作,而内建函数 ...

- laravel中如何执行请求

laravel中如何执行request请求?本篇文章给大家介绍关于laravel中执行请求的方法,需要的朋友可以参考一下,希望对你有所帮助. 我们先来看一下request是什么? 客户端(例如Web浏 ...

- 【02】Kubernets:使用 kubeadm 部署 K8S 集群

写在前面的话 通过上一节,知道了 K8S 有 Master / Node 组成,但是具体怎么个组成法,就是这一节具体谈的内容.概念性的东西我们会尽量以实验的形式将其复现. 部署 K8S 集群 互联网常 ...

- 【LeetCode】230. Kth Smallest Element in a BST

Difficulty: Medium More:[目录]LeetCode Java实现 Description https://leetcode.com/problems/kth-smallest- ...

- 基于NPOI对Excel进行简单的操作

1. 关于NPOI NPOI是一个开源的用于在C#程序中读写Excel.WORD等微软OLE2组件文档的项目,使用NPOI可以在没有安装Office的情况下对Word或Excel文档进行读写操作. 2 ...

- Spring Boot 实战 入门

目前没有系统学习过 Spring 框架,参与工作时,直接参与到了 Spring Boot 项目的开发.目前还比较菜,所以,你要是和我一样,不妨也跳过 Spring 框架的学习,直接学习 Sring B ...