『高性能模型』轻量级网络MobileNet_v2

论文地址:MobileNetV2: Inverted Residuals and Linear Bottlenecks

前文链接:『高性能模型』深度可分离卷积和MobileNet_v1

一、MobileNet v1 的不足

Relu 和数据坍缩

Moblienet V2文中提出,假设在2维空间有一组由 个点组成的螺旋线

数据,经随机矩阵

映射到

维并进行ReLU运算,即:

再通过 矩阵的广义逆矩阵

将

映射回2维空间:

对比 和

发现,当映射维度

时,数据坍塌;当

时,数据基本被保存。虽然这不是严格的数学证明,但是至少说明:channel少的feature map不应后接ReLU,否则会破坏feature map。

简单说一下上图:对于一个输入图像,首先通过一个随机矩阵T将数据转换为n维,然后对这n维数据进行ReLU操作,最后再使用T的逆矩阵转换回来,实验发现当n很小的时候,后面接ReLU非线性变换的话会导致很多信息的丢失,而且维度越高还原的图片和原图越相似。

ResNet 、Relu 和神经元死亡

在神经网络训练中如果节点的值变为0就会“死掉”。因为ReLU对0值的梯度是0,后续无论怎么迭代这个节点的值都不会恢复了。而通过ResNet结构的特征复用,可以很大程度上缓解这种特征退化问题(这也从一个侧面说明ResNet为何好于VGG)。另外,一般情况训练网络使用的是float32浮点数;当使用低精度的float16时,这种特征复用可以更加有效的减缓退化。

二、Inverted residual block

理解之前的问题后看,其实Mobilenet V2使用的基本卷积单元结构有以下特点:

- 整体上继续使用Mobilenet V1的Separable convolution降低卷积运算量

- 引入了特征复用结构,即采取了ResNet的思想

- 采用Inverted residual block结构,对Relu的缺陷进行回避

Inverted residuals 可以认为是residual block的拓展,其重点聚焦在残差网络各层的层数,进入block后会先将特征维数放大,然后再压缩回去,呈现梭子的外形,而传统残差设计是沙漏形,下面是MobileNetV1、MobileNetV2 和ResNet微结构对比:

下面则对比了近年来比较先进的压缩网络子模块:

可以看到MobileNetV2 和ResNet基本结构很相似。不过ResNet是先降维(0.25倍)、提特征、再升维。而MobileNetV2 则是先升维(6倍)、提特征、再降维。、

注:模型中使用 ReLU6 作为非线性层,在低精度计算时能压缩动态范围,算法更稳健。

ReLU6 定义为:f(x) = min(max(x, 0), 6),详见 tf.nn.relu6 API

至于Linear Bottlenecks,论文中用很多公式表达这个思想,但是实现上非常简单,就是在MobileNetV2微结构中第二个PW后无ReLU6,对于低维空间而言,进行线性映射会保存特征,而非线性映射会破坏特征,实际代码如下:

def _bottleneck(inputs, nb_filters, t):

x = Conv2D(filters=nb_filters * t, kernel_size=(1,1), padding='same')(inputs)

x = Activation(relu6)(x)

x = DepthwiseConv2D(kernel_size=(3,3), padding='same')(x)

x = Activation(relu6)(x)

x = Conv2D(filters=nb_filters, kernel_size=(1,1), padding='same')(x)

# do not use activation function

if not K.get_variable_shape(inputs)[3] == nb_filters:

inputs = Conv2D(filters=nb_filters, kernel_size=(1,1), padding='same')(inputs)

outputs = add([x, inputs])

return outputs

相对应的,主结构堆叠上面的block 即可,下面是一个简单的版本,

def MobileNetV2_relu(input_shape, k):

inputs = Input(shape = input_shape)

x = Conv2D(filters=32, kernel_size=(3,3), padding='same')(inputs)

x = _bottleneck_relu(x, 8, 6)

x = MaxPooling2D((2,2))(x)

x = _bottleneck_relu(x, 16, 6)

x = _bottleneck_relu(x, 16, 6)

x = MaxPooling2D((2,2))(x)

x = _bottleneck_relu(x, 32, 6)

x = GlobalAveragePooling2D()(x)

x = Dense(128, activation='relu')(x)

outputs = Dense(k, activation='softmax')(x)

model = Model(inputs, outputs)

return model

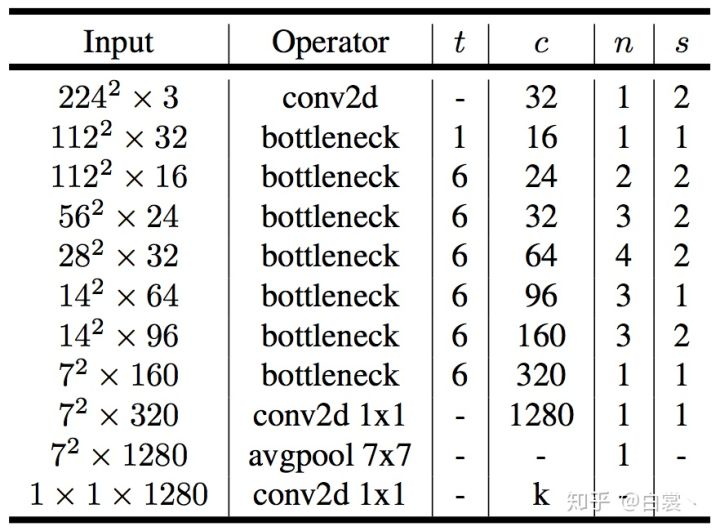

原文网络结构如下:

『高性能模型』轻量级网络MobileNet_v2的更多相关文章

- 『高性能模型』轻量级网络ShuffleNet_v1及v2

项目实现:GitHub 参考博客:CNN模型之ShuffleNet v1论文:ShuffleNet: An Extremely Efficient Convolutional Neural Netwo ...

- 『高性能模型』HetConv: HeterogeneousKernel-BasedConvolutionsforDeepCNNs

论文地址:HetConv 一.现有网络加速技术 1.卷积加速技术 作者对已有的新型卷积划分如下:标准卷积.Depthwise 卷积.Pointwise 卷积.群卷积(相关介绍见『高性能模型』深度可分离 ...

- 『高性能模型』卷积复杂度以及Inception系列

转载自知乎:卷积神经网络的复杂度分析 之前的Inception学习博客: 『TensorFlow』读书笔记_Inception_V3_上 『TensorFlow』读书笔记_Inception_V3_下 ...

- 『高性能模型』Roofline Model与深度学习模型的性能分析

转载自知乎:Roofline Model与深度学习模型的性能分析 在真实世界中,任何模型(例如 VGG / MobileNet 等)都必须依赖于具体的计算平台(例如CPU / GPU / ASIC 等 ...

- 『高性能模型』深度可分离卷积和MobileNet_v1

论文原址:MobileNets v1 TensorFlow实现:mobilenet_v1.py TensorFlow预训练模型:mobilenet_v1.md 一.深度可分离卷积 标准的卷积过程可以看 ...

- 『深度应用』NLP机器翻译深度学习实战课程·壹(RNN base)

深度学习用的有一年多了,最近开始NLP自然处理方面的研发.刚好趁着这个机会写一系列NLP机器翻译深度学习实战课程. 本系列课程将从原理讲解与数据处理深入到如何动手实践与应用部署,将包括以下内容:(更新 ...

- ShuffleNetV1/V2简述 | 轻量级网络

ShuffleNet系列是轻量级网络中很重要的一个系列,ShuffleNetV1提出了channel shuffle操作,使得网络可以尽情地使用分组卷积来加速,而ShuffleNetV2则推倒V1的大 ...

- 『Python进阶』专题汇总

基础知识 Python3内置函数 『Python』库安装 『流畅的Python』第1~4章_数据结构.编码 『Python』基础数据结构常见使用方法 『Python CoolBook』数据结构和算法_ ...

- 2017-2018-2 165X 『Java程序设计』课程 助教总结

2017-2018-2 165X 『Java程序设计』课程 助教总结 本学期完成的助教工作主要包括: 编写300道左右测试题,用于蓝墨云课下测试: 发布博客三篇:<2017-2018-2 165 ...

随机推荐

- YEP_footstepsounds

脚步声插件 ============================================================================Introduction====== ...

- 文件下载后台报错IllegalStateException: getOutputStream() has already been called

java.lang.IllegalStateException: getOutputStream() has already been called <%@page language=" ...

- 记录tiny6410 使用linux-2.6.28.6内核遇到starting kernel...的问题

1\问题的解决主要是参考了tiny210相同的问题 2\/home/suxuandong/Documents/computer/linux_kernel/tiny6410/linux-2.6.28.6 ...

- 记录ok6410 jlink 命令行调试uboot

1\启动ok6410 进入uboot命令行 2\启动JLinkGDBServer -device ARM11 3\arm-none-eabi-gdb u-boot 初始化脚本 # Connect to ...

- java中存储mysql数据库时间类型

Mysql 与 java 的时间类型 MySql的时间类型有 Java中与之对应的时间类型 date java.sql.Date Datetime ...

- 《Whitelabel Error Page 404》 对于Springboot初学者可能出现问题的原因

whitelabel error page异常一定是有原因的,比如,访问路径不对,解析不对,注解忘记引入等.对于初学者,一定要注意一点,程序只加载Application.java所在包及其子包下的内容 ...

- 用iPhone查看pc电脑上写的html(Mac电脑Charles)简单版

对于客户端同学开发来说,写一段代码想在真机上看看,是非常容易的. 那么在这么一个大前端的环境下,客户端开发想写点html和js代码,又想在手机上看看效果,怎么办呢? 需要以下几个步骤: 大体流程:1. ...

- Windows下安装Redis服务

说明:本文拷贝自https://jingyan.baidu.com/article/0f5fb099045b056d8334ea97.html Redis是有名的NoSql数据库,一般Linux都会默 ...

- bash 基础命令

bash的基础特性(): () 命令历史 history 环境变量: HISTSIZE:命令历史记录的条数: HISTFILE:~/.bash_history: HISTFILESIZE:命令历史文件 ...

- kubernetes容器删除时快速释放ip的方案

问题的来由 在kubernetes集群的生产中,经常遇到这样的一个问题,就是在应用大规模更新时,大量容器删除而后大量容器创建,创建的容器需要很长时间才能就绪.这其中一个可能的原因,就是大量容器删除释放 ...