【Spark篇】--Spark中Standalone的两种提交模式

一、前述

Spark中Standalone有两种提交模式,一个是Standalone-client模式,一个是Standalone-master模式。

二、具体

1、Standalone-client提交任务方式

- 提交命令

./spark-submit --master spark://node01:7077 --class org.apache.spark.examples.SparkPi ../lib/spark-examples-1.6.

0-hadoop2.6.0.jar 100

./spark-submit --master spark://node01:7077 --deploy-mode client --class org.apache.spark.examples.SparkPi ../li

b/spark-examples-1.6.0-hadoop2.6.0.jar 100

解释:--class org.apache.spark.examples.SparkPi main函数

../lib/spark-examples-1.6.0-hadoop2.6.0.jar jar包

100 main函数需要参数

- 执行原理图解

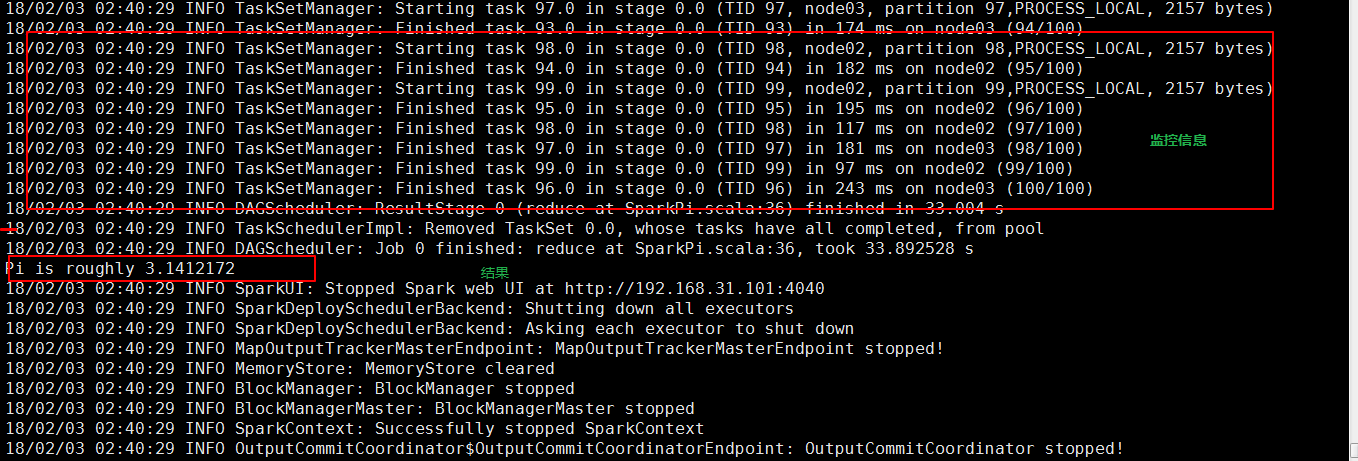

- 执行流程

1、client模式提交任务后,会在客户端启动Driver进程。

2、Driver会向Master申请启动Application启动的资源。

3、资源申请成功,Driver端将task发送到worker端执行。

4、worker将task执行结果返回到Driver端。

- 总结

个application到集群运行,次网卡流量暴增的问题。(因为要监控task的运行情况,会占用很多端口,如上图的结果图)客户端网卡通信,都被task监控信息占用。

2、Client端作用

1. Driver负责应用程序资源的申请

2. 任务的分发。

3. 结果的回收。

4. 监控task执行情况。

2、Standalone-cluster提交任务方式

- 提交命令

./spark-submit --master spark://node01:7077 --deploy-mode cluster --class org.apache.spark.examples.SparkPi ../

lib/spark-examples-1.6.0-hadoop2.6.0.jar 100

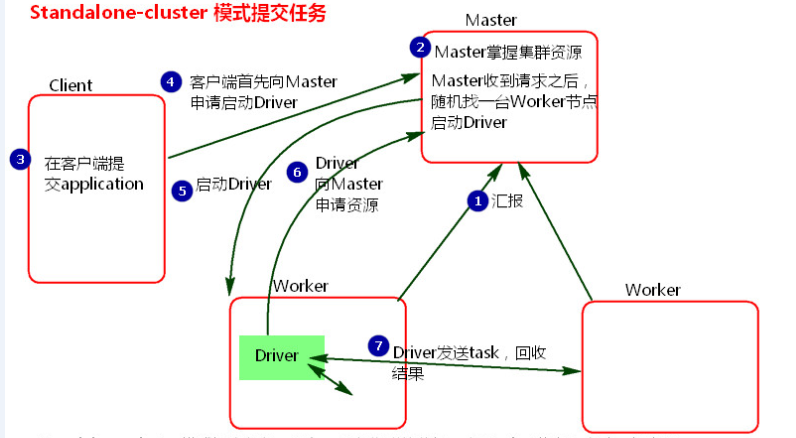

- 执行原理图解

- 执行流程

1、cluster模式提交应用程序后,会向Master请求启动Driver.(而不是启动application)

2、Master接受请求,随机在集群一台节点启动Driver进程。

3、Driver启动后为当前的应用程序申请资源。Master返回资源,并在对应的worker节点上发送消息启动Worker中的executor进程。

4、Driver端发送task到worker节点上执行。

5、worker将执行情况和执行结果返回给Driver端。Driver监控task任务,并回收结果。

- 总结

1、当在客户端提交多个application时,Driver会在Woker节点上随机启动,这种模式会将单节点的网卡流量激增问题分散到集群中。在客户端看不到task执行情况和结果。要去webui中看。cluster模式适用于生产环境

2、 Master模式先启动Driver,再启动Application。

【Spark篇】--Spark中Standalone的两种提交模式的更多相关文章

- Spark剖析-宽依赖与窄依赖、基于yarn的两种提交模式、sparkcontext原理剖析

Spark剖析-宽依赖与窄依赖.基于yarn的两种提交模式.sparkcontext原理剖析 一.宽依赖与窄依赖 二.基于yarn的两种提交模式深度剖析 2.1 Standalne-client 2. ...

- 小记--------spark的两种提交模式

spark的两种提交模式:yarn-cluster . yarn-client 图解

- spark基于yarn的两种提交模式

一.spark的三种提交模式 1.第一种,Spark内核架构,即standalone模式,基于Spark自己的Master-Worker集群. 2.第二种,基于YARN的yarn-cluster模式. ...

- 【Spark篇】---SparkStreaming+Kafka的两种模式receiver模式和Direct模式

一.前述 SparkStreamin是流式问题的解决的代表,一般结合kafka使用,所以本文着重讲解sparkStreaming+kafka两种模式. 二.具体 1.Receiver模式 原理图 ...

- 【Spark篇】---Spark中yarn模式两种提交任务方式

一.前述 Spark可以和Yarn整合,将Application提交到Yarn上运行,和StandAlone提交模式一样,Yarn也有两种提交任务的方式. 二.具体 1.yarn-clien ...

- Spark on YARN两种运行模式介绍

本文出自:Spark on YARN两种运行模式介绍http://www.aboutyun.com/thread-12294-1-1.html(出处: about云开发) 问题导读 1.Spark ...

- spark on mesos 两种运行模式

spark on mesos 有粗粒度(coarse-grained)和细粒度(fine-grained)两种运行模式,细粒度模式在spark2.0后开始弃用. 细粒度模式 优点 spark默认运行的 ...

- Spark on YARN的两种运行模式

Spark on YARN有两种运行模式,如下 1.yarn-cluster:适合于生产环境. Spark的Driver运行在ApplicationMaster中,它负责向YARN Re ...

- Spark Streaming中空batches处理的两种方法(转)

原文链接:Spark Streaming中空batches处理的两种方法 Spark Streaming是近实时(near real time)的小批处理系统.对给定的时间间隔(interval),S ...

随机推荐

- Spark实战

实战 数据导入Hive中全量: 拉链增量:用户.商品表数据量大时用 拉链表动作表 增量城市信息 全量 需求一: 获取点击.下单和支付数量排名前 的品类 ①使用累加器: click_category_i ...

- HDU - 1827 Summer Holiday (强连通)

<题目链接> 题目大意: 听说lcy帮大家预定了新马泰7日游,Wiskey真是高兴的夜不能寐啊,他想着得快点把这消息告诉大家,虽然他手上有所有人的联系方式,但是一个一个联系过去实在太耗时间 ...

- HTTP协议头部与Keep-Alive模式详解(转)

转自:http://a280606790.iteye.com/blog/1095085 http1.1 中怎么打开持久连接,怎么关闭,怎么传输数据(确定本次数据是否传输完毕) 1.什么是Keep-Al ...

- vue动态切换组件

<!DOCTYPE html><html> <head> <meta charset="utf-8"> <title>& ...

- Linux下安装、编译SDL

要搞图形界面,SDL是比较好上手的一个库.今天试着在centos下搞了一个SDL的程序.下面是配置的步骤: 首先yum search SDL,会出现SDL相关的软件包.不过我这里只有SDL1的,没有2 ...

- Python网络编程基础pdf

Python网络编程基础(高清版)PDF 百度网盘 链接:https://pan.baidu.com/s/1VGwGtMSZbE0bSZe-MBl6qA 提取码:mert 复制这段内容后打开百度网盘手 ...

- python利用xlrd读取excel文件始终报错原因

1.代码按照网上百度的格式进行书写如下: 但运行后,始终报错如下: 百度了xlrd网页: 分明支持xls和xlsx两种格式的文件,但运行始终报错. 最后找到原因是因为我所读取的文件虽然是以.xls命名 ...

- springboot增删改查

改https://blog.csdn.net/weixin_42338186/article/details/81561592 添加https://blog.csdn.net/weixin_42338 ...

- DataTable的Merge\COPY\AcceptChange使用说明

在C#内使用DataTable的Merge().Copy().AcceptChange().Clone()方法的用途如下: 1.Merge()可将两个不同的表结构的表进行合并,合并后新表的列为之前两表 ...

- Java Json字符串转Java对象遇到属性大小写的问题解决

String objectStr="{\"namE\":\"JSON\",\"age\":\"24\",\&q ...