Spark安装与部署

1.首先安装scala(找到合适版本的具体地址下载)

wget https://www.scala-lang.org/download/****

2.安装spark

wget http://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-2.4.3/spark-2.4.3-bin-hadoop2.7.tgz

tar -zxvf spark-2.4.-bin-hadoop2..tgz

rm spark-2.4.-bin-hadoop2..tgz

3.配置环境变量

vim /etc/profile

4.刷新环境变量

source /etc/profile

5.复制配置文件

cp slaves.template slaves

cp spark-env.sh.template spark-env.sh

6.接着进行以下配置

vim /etc/profile(查看其它配置文件直接复制即可)

vim ./spark-2.4.-bin-hadoop2./conf

vim spark-env.sh

7.启动spark环境

1)先启动Hadoop环境

/usr/local/hadoop-2.7./sbin/start-all.sh

2) 启动Spark环境

/usr/local/spark-2.4.-bin-hadoop2./sbin/start-all.sh

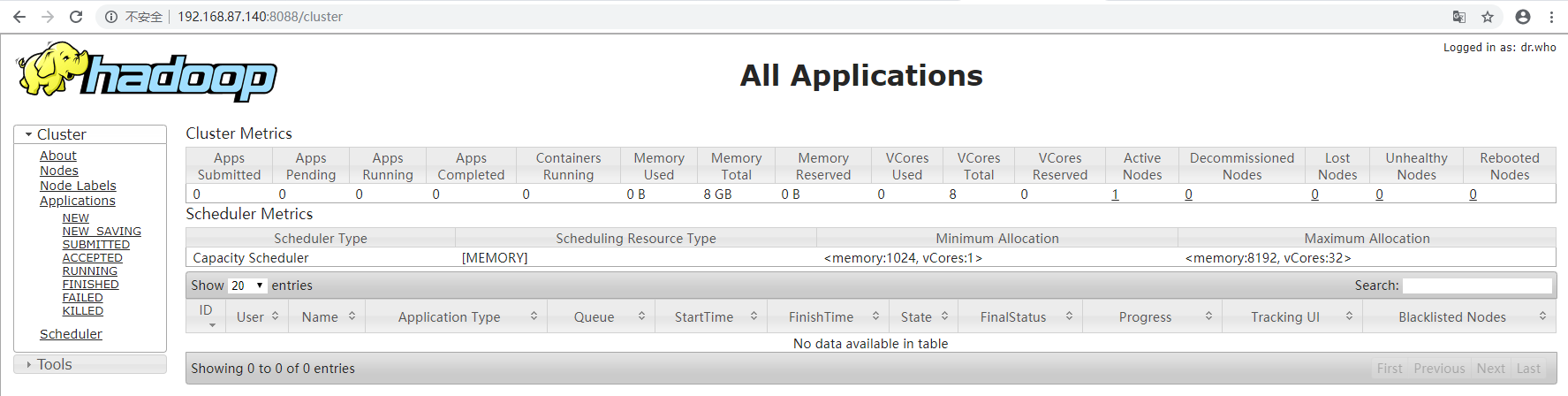

8.查看spark的web控制界面

9.查看Hadoop的web端界面

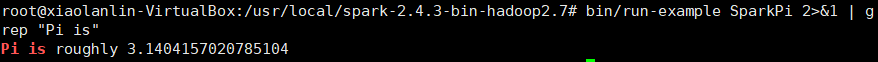

10.验证Spark是否安装成功

bin/run-example SparkPi

bin/run-example SparkPi >& | grep "Pi is"

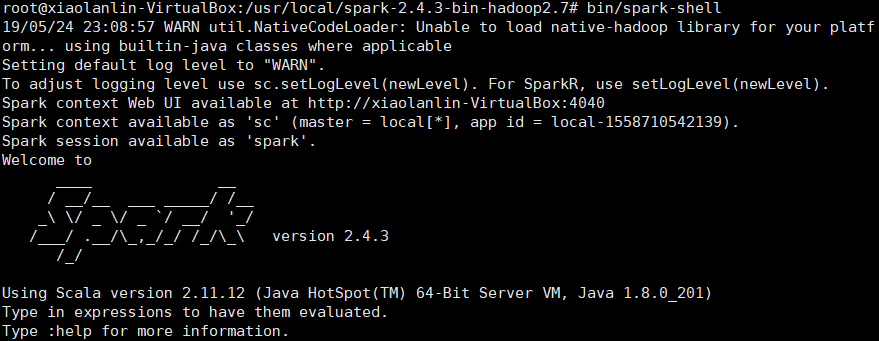

11.使用Spark Shell编写代码

1)启动Spark Shell

bin/spark-shell

2)加载text文件

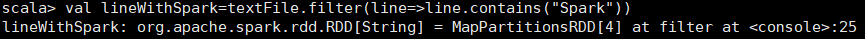

3)简单RDD操作

scala> textFile.first() // 获取RDD文件textFile的第一行内容

scala> textFile.count() // 获取RDD文件textFile的所有项的计数

scala> val lineWithSpark=textFile.filter(line=>line.contains("Spark"))// 抽取含有“Spark”的行,返回一个新的RDD

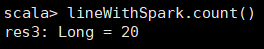

scala> lineWithSpark.count() //统计新的RDD的行数

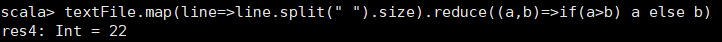

4)可以通过组合RDD操作进行组合,可以实现简易MapReduce操作

scala> textFile.map(line=>line.split(" ").size).reduce((a,b)=>if(a>b) a else b) //找出文本中每行的最多单词数

5)退出Spark shell

:quit

Spark安装与部署的更多相关文章

- Spark入门实战系列--2.Spark编译与部署(中)--Hadoop编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Hadooop 1.1 搭建环境 1.1.1 安装并设置maven 1. 下载mave ...

- Spark入门实战系列--2.Spark编译与部署(下)--Spark编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Spark .时间不一样,SBT是白天编译,Maven是深夜进行的,获取依赖包速度不同 ...

- Spark安装部署(local和standalone模式)

Spark运行的4中模式: Local Standalone Yarn Mesos 一.安装spark前期准备 1.安装java $ sudo tar -zxvf jdk-7u67-linux-x64 ...

- CentOS6安装各种大数据软件 第十章:Spark集群安装和部署

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- Spark 安装部署与快速上手

Spark 介绍 核心概念 Spark 是 UC Berkeley AMP lab 开发的一个集群计算的框架,类似于 Hadoop,但有很多的区别. 最大的优化是让计算任务的中间结果可以存储在内存中, ...

- spark-2.2.0安装和部署——Spark集群学习日记

前言 在安装后hadoop之后,接下来需要安装的就是Spark. scala-2.11.7下载与安装 具体步骤参见上一篇博文 Spark下载 为了方便,我直接是进入到了/usr/local文件夹下面进 ...

- Spark学习(一) -- Spark安装及简介

标签(空格分隔): Spark 学习中的知识点:函数式编程.泛型编程.面向对象.并行编程. 任何工具的产生都会涉及这几个问题: 现实问题是什么? 理论模型的提出. 工程实现. 思考: 数据规模达到一台 ...

- Spark入门实战系列--2.Spark编译与部署(上)--基础环境搭建

[注] 1.该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取: 2.Spark编译与部署将以CentOS 64位操作系统为基础,主要是考虑到实际应用 ...

- Spark on Mesos部署

一.Mesos的安装和部署 1.下载mesos源码和依赖包 部署环境 centOS 6.6 mesos-0.21.0 spark-1.4.1 因为mesos官方只提供源码,所以必须要自己进行编译安装使 ...

随机推荐

- SpringBoot第二十一篇:整合ActiveMQ

作者:追梦1819 原文:https://www.cnblogs.com/yanfei1819/p/11190048.html 版权声明:本文为博主原创文章,转载请附上博文链接! 引言 前一章节中 ...

- 前端经常碰到的小知识点-----js篇

一 js 1.可视区宽和高 ① document.documentElement.clientWidth //可视区的宽度 document.documentElement.clientHei ...

- Java设计模式学习笔记(五) 单例模式

前言 本篇是设计模式学习笔记的其中一篇文章,如对其他模式有兴趣,可从该地址查找设计模式学习笔记汇总地址 1. 使用单例模式的原因 以Windows任务管理器为例,在Windows系统中,任务管理器是唯 ...

- nu.xom:Serializer

Serializer: 机翻 /* 使用用于控制空格,规范化,缩进,换行和基本URI的各种选项以特定编码输出Document对象 */ Serializer(OutputStream out) :创建 ...

- iconfontのsymbol的使用

iconfontのsymbol的使用 iconfont三种方式的优缺点 unicode 优点: 1.兼容性最好,支持ie6+ 2.支持按字体的方式去动态调整图标大小,颜色等等 缺点: 1.不支持多色图 ...

- 新手小白之学习python一飞冲天日志之—基本数据类型,条件控制语句

python的历史 04年目前最流行的WEB框架Django诞生 python2:源码不统一,有重复的功能代码 python3:源码统一,没有重复的功能代码 python是一个什么编程语言 编译型:编 ...

- 个人永久性免费-Excel催化剂功能第19波-Excel与Sqlserver零门槛交互-查询篇

对频繁使用Excel的高级应用的尝试用户来说,绕不过的一个问题Excel的性能问题,对于几万条数据还说得过去,上了10万行的数据量,随便一个函数公式的运算都是一个不小的负荷,有些上进一点的用户会往Ac ...

- 《VR入门系列教程》之21---使用Unity开发GearVR应用

使用Unity开发GearVR应用 上一章我们介绍了如何运用Unity3D开发Oculus Rift应用,当然,这个便宜且强大的游戏引擎也可以用于GearVR的应用开发,这时我们需要用到Ocu ...

- 织梦(dede)底层模板概念、常用底层模板字段

织梦(dede)底层模板概念.常用底层模板字段 一.底层模板的概念以及调用方式: 1. 什么是底层模板? 底层模板不是一个模板! 他就是在实际页面当中所要显示的具体内容: 2. 底层模板的应用: 调用 ...

- Android的日期选择器

TimePicker(时间选择器) 方法 描述 Integer getCurrentHour () 返回当前设置的小时 Integer getCurrentMinute() 返回当前设置的分钟 boo ...