pandas的聚合操作: groupyby与agg

pandas提供基于行和列的聚合操作,groupby可理解为是基于行的,agg则是基于列的

从实现上看,groupby返回的是一个DataFrameGroupBy结构,这个结构必须调用聚合函数(如sum)之后,才会得到结构为Series的数据结果。

而agg是DataFrame的直接方法,返回的也是一个DataFrame。当然,很多功能用sum、mean等等也可以实现。但是agg更加简洁, 而且传给它的函数可以是字符串,也可以自定义,参数是column对应的子DataFrame

一、pandas.group_by

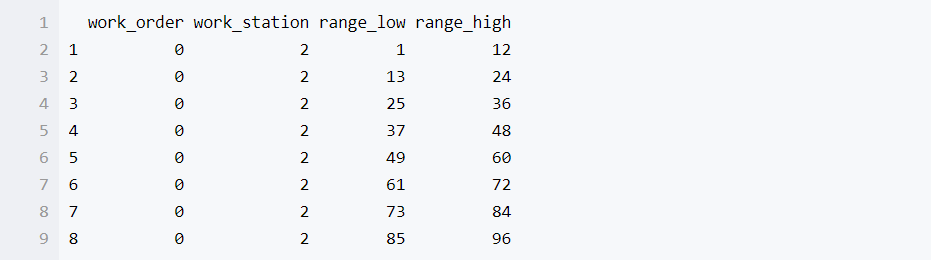

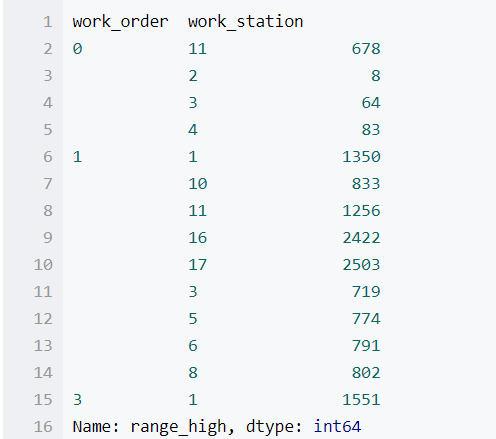

首先来看一下案例的数据格式,使用head函数调用DataFrame的前8条记录,这里一共4个属性

column_map.head(8)

work_order 表示工序, work_station表示工位,rang_low, range_high 表示对应记录的上下限,现在使用groupby统计每个工序工位下面各有多少条记录

column_map.groupby(['work_order','work_station'])我们会发现输出的是一个GroupBy类,并非我们想要的结果

<pandas.core.groupby.DataFrameGroupBy object at 0x111242630>还需要加上一个聚合函数,比如

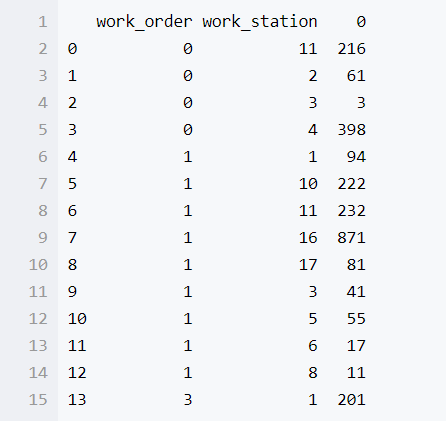

wo_ws_group = column_map.groupby(['work_order','work_station'])

wo_ws_group.size()我们就可以得到

新出现的列对应着每个工序工位下面有多少条记录

但是我们可以发现它的格式已经和我们平时使用的DataFrame不太一样了,我们可以使用下面的命令解决

wo_ws_group.size().reset_index()

想要查询具体每一个记录,可以使用loc命令

使用get_group可以查询具体每一个分组下面的所有记录

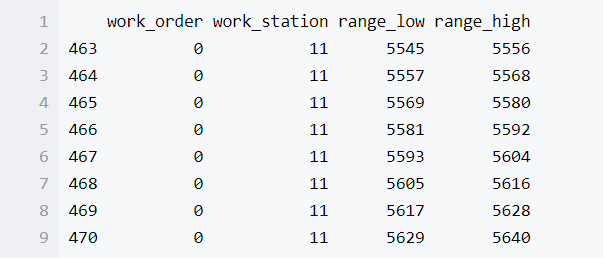

wo_ws_group.get_group(('0','11'))

因为比较多就显示全部了,使用head,显示前几条记录

wo_ws_group.get_group(('0','11')).head(8)

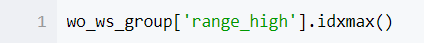

我们还可以使用idxmin(),idxmax()函数,获得每一个分组下面所有记录中数值最大最小的index

wo_ws_group['range_low'].idxmin()

对于分组结果的每一列还可以使用apply,进行一些函数的二次处理,如

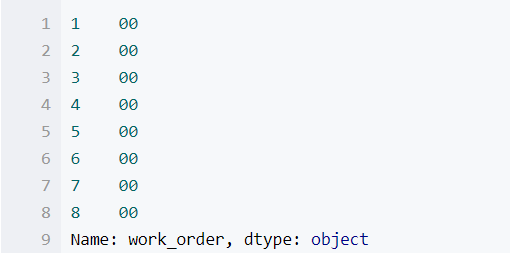

wo_ws_group['work_order'].apply(lambda x:2*x).head(8)

由于这里的0是字符串类型,所以2*以后都变成了2个0

二、pandas.agg

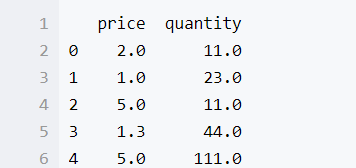

agg的使用比groupby还要简介一些,我们现自己创建一个DataFrame作为例子

data = pd.DataFrame([[2,11],[1,23],[5,11],[1.3,44],[5,111]],columns = ['price','quantity'],dtype = float)

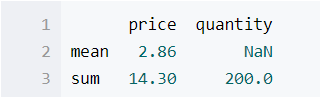

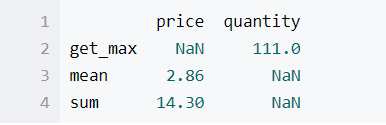

使用agg统计每一列的求和与平均值

data.agg({'price':['sum','mean'],'quantity':['sum']})

如果需要自定义一些函数的 话可以使用lambda函数

pandas的聚合操作: groupyby与agg的更多相关文章

- 数据分析入门——pandas之DataFrame多层/多级索引与聚合操作

一.行多层索引 1.隐式创建 在构造函数中给index.colunms等多个数组实现(datafarme与series都可以) df的多级索引创建方法类似: 2.显式创建pd.MultiIndex 其 ...

- Python Pandas分组聚合

Pycharm 鼠标移动到函数上,CTRL+Q可以快速查看文档,CTR+P可以看基本的参数. apply(),applymap()和map() apply()和applymap()是DataFrame ...

- Pandas 分组聚合

# 导入相关库 import numpy as np import pandas as pd 创建数据 index = pd.Index(data=["Tom", "Bo ...

- MongoTemplate聚合操作

Aggregation简单来说,就是提供数据统计.分析.分类的方法,这与mapreduce有异曲同工之处,只不过mongodb做了更多的封装与优化,让数据操作更加便捷和易用.Aggregation操作 ...

- Pandas的高级操作

pandas数据处理 1. 删除重复元素 使用duplicated()函数检测重复的行,返回元素为布尔类型的Series对象,每个元素对应一行,如果该行不是第一次出现,则元素为True keep参数: ...

- Update(Stage4):sparksql:第3节 Dataset (DataFrame) 的基础操作 & 第4节 SparkSQL_聚合操作_连接操作

8. Dataset (DataFrame) 的基础操作 8.1. 有类型操作 8.2. 无类型转换 8.5. Column 对象 9. 缺失值处理 10. 聚合 11. 连接 8. Dataset ...

- 数据分析05 /pandas的高级操作

数据分析05 /pandas的高级操作 目录 数据分析05 /pandas的高级操作 1. 替换操作 2. 映射操作 3. 运算工具 4. 映射索引 / 更改之前索引 5. 排序实现的随机抽样/打乱表 ...

- 《Entity Framework 6 Recipes》中文翻译系列 (27) ------ 第五章 加载实体和导航属性之关联实体过滤、排序、执行聚合操作

翻译的初衷以及为什么选择<Entity Framework 6 Recipes>来学习,请看本系列开篇 5-9 关联实体过滤和排序 问题 你有一实体的实例,你想加载应用了过滤和排序的相关 ...

- MongoDB 聚合操作

在MongoDB中,有两种方式计算聚合:Pipeline 和 MapReduce.Pipeline查询速度快于MapReduce,但是MapReduce的强大之处在于能够在多台Server上并行执行复 ...

随机推荐

- awr相关

手工生成awr快照SQL> exec dbms_workload_repository.create_snapshot; PL/SQL procedure successfully comple ...

- 485. Max Consecutive Ones最大连续1的个数

网址:https://leetcode.com/problems/max-consecutive-ones/ 很简单的一题 class Solution { public: int findMaxCo ...

- 2.两数相加(Add Two Numbers) C++

第一想法是顺着题目的原因,将两链表分别转化为一个数字,再将数字相加,然后把结果转化为字符串,存到答案链表中.但是数据太大会溢出! 所以,要在计算一对数字的过程当中直接存储一个结果,注意结果大于9时进位 ...

- IDA 逆向工程 反汇编使用

IDA pro 7.0版本 from:freebuf 用到的工具有IDA pro 7.0 ,被反汇编的是百度云(BaiduNetdisk_5.6.1.2.exe). 首先,IDA pro的长相如下: ...

- Python3+BaiduAI识别高颜值妹子图片

一.在百度云平台创建应用 为什么要到百度云平台创建应用,首先来说是为了获取获取access_token时需要的API Key和Secret Key 至于为什么需要API Key和Secret Key才 ...

- 微信小程序 HMACSHA256 哈希加密

下载CryptoJS, 增加红色的这句 module.exports = CryptoJS /* CryptoJS code.google.com/p/crypto-js (c) 2009-2012 ...

- SpringBoot使用Spring Initializer

IDE都支持使用Spring的项目创建Spring的项目创建向导,快速创建一个SpringBoot项目:选择我们需要的模块:向导会联网创建SpringBoot项目:默认生成的SpringBoot项目: ...

- python-flask基础

get请求: 使用场景:如果只对服务器获取数据,并没有对服务器产生任何影响,那么这时候使用get请求. 传参:get请求传参是放在url中,并且是通过’?’的形式来指定key和value的. post ...

- Win10系列:VC++绘制几何图形1

本小节主要介绍如何使用Direct2D来绘制几何图形,其中会使用到FillGeometry函数和FillEllipse函数,FillGeometry函数用于填充几何图形的内部区域,而FillEllip ...

- 解决Tomcat v6.0 Server at localhost was unable to start within 45 seconds

eclipse 中tomcat启动超时报错如下: Starting Tomcat v7.0 Server at localhost' has encountered a problem Server ...