HDFS伪分布式

(一)、HDFS shell操作

以上已经介绍了如何搭建伪分布式的Hadoop,既然环境已经搭建起来了,那要怎么去操作呢?这就是本节将要介绍的内容:

HDFS自带有一些shell命令,通过这些命令我们可以去操作HDFS文件系统,这些命令与Linux的命令挺相似的,如果熟悉Linux的命令很容易就可以上手HDFS的命令,关于这些命令的官方文档地址如下:

http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.7.0/hadoop-mapreduce-client/hadoop-mapreduce-client-core/MapredCommands.html

1.1 首先我们在/data下创建一个测试文件:

[root@web02 data]# vim hello.txt

18/04/07 12:03:05 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

如果遇到以上报错修改

[root@web02 hadoop]# pwd

/usr/local/src/hadoop-2.6.0-cdh5.7.0/etc/hadoop

[root@web02 hadoop]# vim log4j.properties

添加:

log4j.logger.org.apache.hadoop.util.NativeCodeLoader=ERROR1.2查看文件系统的根目录

[root@web02 data]# hdfs dfs -ls /1.3.将刚刚创建的文件拷贝到文件系统的根目录下:

[root@web02 data]# hdfs dfs -ls /

Found 1 items

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

[root@web02 data]#1.4.查看文件内容:

[root@web02 data]# hdfs dfs -cat /hello.txt

hello You 66 O

Hadoop HDFS mpareduce1.5创建目录

[root@web02 data]# hdfs dfs -mkdir /test

[root@web02 data]# hdfs dfs -ls /

Found 2 items

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

drwxr-xr-x - root supergroup 0 2018-04-07 12:20 /test

[root@web02 data]#1.6递归创建目录

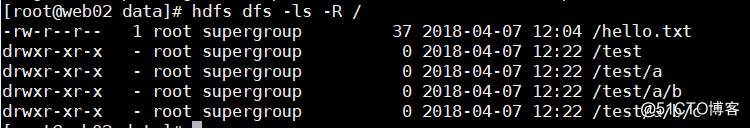

[root@web02 data]# hdfs dfs -mkdir -p /test/a/b/c1.7查看递归目录

[root@web02 data]# hdfs dfs -ls -R /

1.8复制文件

[root@web02 data]# hdfs dfs -copyFromLocal

./hello.txt /test/a/b

[root@web02 data]# hdfs dfs -ls -R /

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test/a

drwxr-xr-x - root supergroup 0 2018-04-07 12:28 /test/a/b

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test/a/b/c

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:28 /test/a/b/hello.txt

[root@web02 data]#1.9从系统中拿出文件

[root@web02 data]# hdfs dfs -get /test/a/b/hello.txt2.0删除文件

[root@web02 data]# hdfs dfs -rm /hello.txt

Deleted /hello.txt

[root@web02 data]#2.1删除目录

[root@web02 data]# hdfs dfs -rm -R /test

Deleted /test

[root@web02 data]#以上就是最为常用的一些操作命令了,如果需要使用其他命令,直接执行hdfs dfs就可以查看到所支持的所有命令。

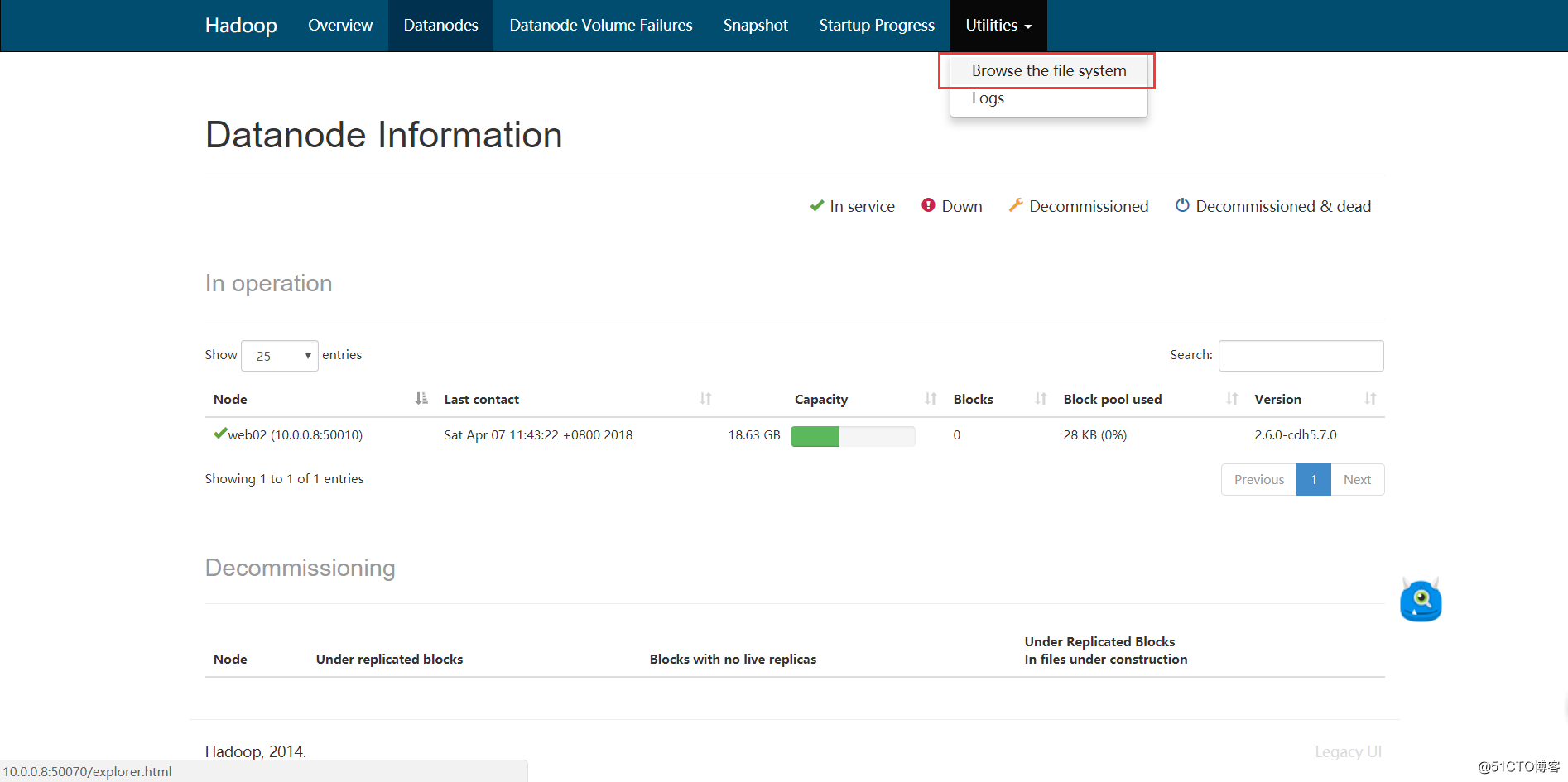

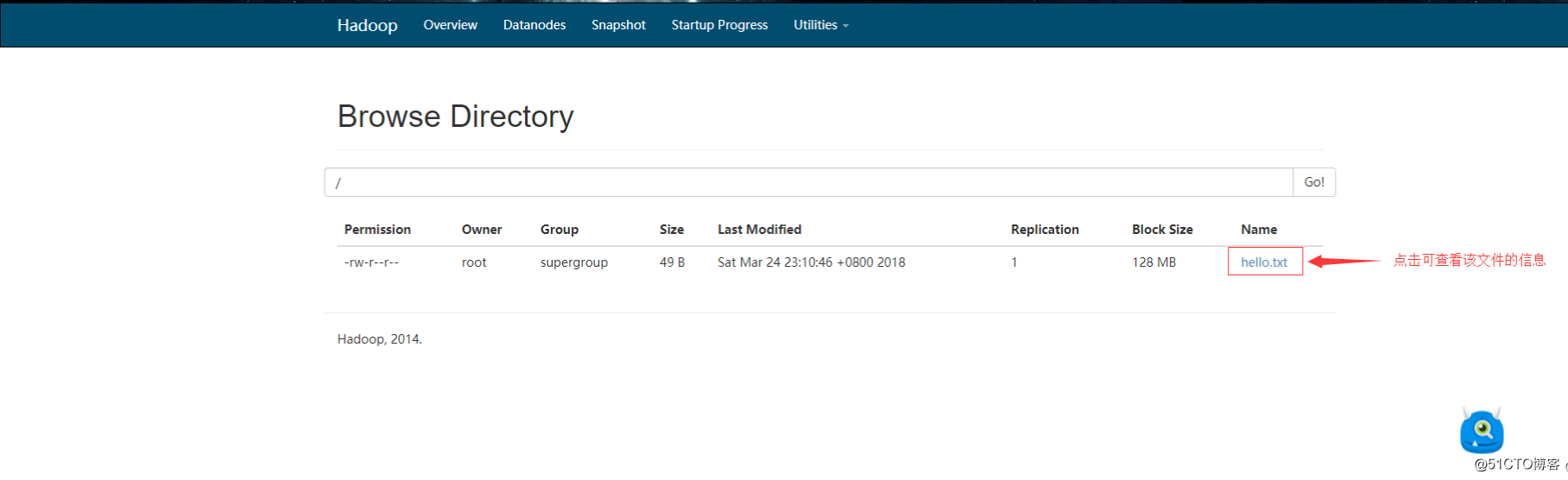

接下来我们在浏览器里查看文件系统,首先将刚刚删除的文件put回去:

2.2查看文件信息

HDFS伪分布式的更多相关文章

- Linux单机环境下HDFS伪分布式集群安装操作步骤v1.0

公司平台的分布式文件系统基于Hadoop HDFS技术构建,为开发人员学习及后续项目中Hadoop HDFS相关操作提供技术参考特编写此文档.本文档描述了Linux单机环境下Hadoop HDFS伪分 ...

- 大数据:Hadoop(JDK安装、HDFS伪分布式环境搭建、HDFS 的shell操作)

所有的内容都来源与 Hadoop 官方文档 一.Hadoop 伪分布式安装步骤 1)JDK安装 解压:tar -zxvf jdk-7u79-linux-x64.tar.gz -C ~/app 添加到系 ...

- HDFS 伪分布式环境搭建

HDFS 伪分布式环境搭建 作者:Grey 原文地址: 博客园:HDFS 伪分布式环境搭建 CSDN:HDFS 伪分布式环境搭建 相关软件版本 Hadoop 2.6.5 CentOS 7 Oracle ...

- HDFS伪分布式环境搭建

(一).HDFS shell操作 以上已经介绍了如何搭建伪分布式的Hadoop,既然环境已经搭建起来了,那要怎么去操作呢?这就是本节将要介绍的内容: HDFS自带有一些shell命令,通过这些命令我们 ...

- Hadoop 2.7 伪分布式环境搭建

1.安装环境 ①.一台Linux CentOS6.7 系统 hostname ipaddress subnet mask ...

- Hadoop伪分布式集群

一.HDFS伪分布式环境搭建 Hadoop分布式文件系统(HDFS)被设计成适合运行在通用硬件(commodity hardware)上的分布式文件系统.它和现有的分布式文件系统有很多共同点.但同时, ...

- Hadoop-HDFS的伪分布式和完全分布式集群搭建

Hadoop-HDFSHDFS伪分布式集群搭建步骤一.配置免密登录 ssh-keygen -t rsa1一句话回车到底 ssh-copy-id -i ~/.ssh/id_rsa.pub root@no ...

- [BigData]关于HDFS的伪分布式安装和虚拟机网络的配置

[BigData]关于Hadoop学习笔记第一天(段海涛老师)(三) 视频2: hadoop的应用在电商,"浏览了该商品的人还看了","浏览了该商品的人最终购买的&quo ...

- Hadoop的HDFS和MapReduce的安装(三台伪分布式集群)

一.创建虚拟机 1.从网上下载一个Centos6.X的镜像(http://vault.centos.org/) 2.安装一台虚拟机配置如下:cpu1个.内存1G.磁盘分配20G(看个人配置和需求,本人 ...

随机推荐

- 【luogu P1462 通往奥格瑞玛的道路】 题解

题目链接:https://www.luogu.org/problemnew/show/P1462 记住HP=0也叫死. #include <queue> #include <cstd ...

- CSharp调用C++编写的DLL的方法

自己比较懒,有的时候想写点东西,但由于文笔不行.技术不行也就没有怎么写.经常是用到什么.学习什么的时候,简单写点,权当是个学习笔记.上博客的次数也很少,有人给我留言也是没有怎么及时的回复,深感抱歉! ...

- 开始重学java【门头沟2017年12月6日】

现在从struts2开始重新学习java, 想找个人一起学习java/php都可以. 学习时间大概是两个月,就是年前这段时间. 下一个阶段就是做项目进行练习.(时间为:一个月时间) 不管是学习java ...

- mysql数据去重复distinct、group by

使用distinct 和group by都可以实现数据去重. select distinct 字段 group by 一般放在where条件后

- 核心动画(UIView封装动画)-转

一.UIView动画(首尾) 1.简单说明 UIKit直接将动画集成到UIView类中,当内部的一些属性发生改变时,UIView将为这些改变提供动画支持. 执行动画所需要的工作由UIView类自动完成 ...

- 台式机上如何配置并使用苹果iPhone的耳机麦克风 并且麦克风开启降噪功能

这个资料和技巧在网络上面很少有人分享,但是可能会有不少人需要这个东西.这里分享下经验.这也是一个困扰我很久的一个问题.因为买来了这个转接头,发现,录音的时候iPhone的耳机麦克风有很大的噪音无法消除 ...

- MB/s与Mbit/s的区别

数据传输率的单位一般采用MB/s或Mbit/s,尤其在内部数据传输率上官方数据中更多的采用Mbit/s为单位.此处有必要讲解一下两个单位二者之间的差异: MB/s的含义是兆字节每秒,Mbit/s的含义 ...

- vue兄弟组件传值$on多次执行的问题

首先附上如何进行兄弟组件通信的方法链接 https://segmentfault.com/a/1190000011882494 下面是$on多次执行的解决办法 https://blog.csdn.ne ...

- JDK8新垃圾回收机制--G1垃圾回收机制

G1全称是Garbage First Garbage Collector,使用G1的目的是简化性能优化的复杂性.例如,G1的主要输入参数是初始化和最大Java堆大小.最大GC中断时间. G1 GC由Y ...

- 列表排序之NB三人组附加一个希尔排序

NB三人组之 快速排序 def partition(li, left, right): tmp = li[left] while left < right: while left < ri ...