python框架Scrapy中crawlSpider的使用

一、创建Scrapy工程

#scrapy startproject 工程名

scrapy startproject demo3

二、进入工程目录,根据爬虫模板生成爬虫文件

#scrapy genspider -l # 查看可用模板

#scrapy genspider -t 模板名 爬虫文件名 允许的域名

scrapy genspider -t crawl test sohu.com

三、设置IP池或用户代理(middlewares.py文件)

# -*- coding: utf-8 -*-

# 导入随机模块

import random

# 导入有关IP池有关的模块

from scrapy.downloadermiddlewares.httpproxy import HttpProxyMiddleware

# 导入有关用户代理有关的模块

from scrapy.downloadermiddlewares.useragent import UserAgentMiddleware # IP池

class HTTPPROXY(HttpProxyMiddleware):

# 初始化 注意一定是 ip=''

def __init__(self, ip=''):

self.ip = ip def process_request(self, request, spider):

item = random.choice(IPPOOL)

try:

print("当前的IP是:"+item["ipaddr"])

request.meta["proxy"] = "http://"+item["ipaddr"]

except Exception as e:

print(e)

pass # 设置IP池

IPPOOL = [

{"ipaddr": "182.117.102.10:8118"},

{"ipaddr": "121.31.102.215:8123"},

{"ipaddr": "1222.94.128.49:8118"}

] # 用户代理

class USERAGENT(UserAgentMiddleware):

#初始化 注意一定是 user_agent=''

def __init__(self, user_agent=''):

self.user_agent = user_agent def process_request(self, request, spider):

item = random.choice(UPPOOL)

try:

print("当前的User-Agent是:"+item)

request.headers.setdefault('User-Agent', item)

except Exception as e:

print(e)

pass # 设置用户代理池

UPPOOL = [

"Mozilla/5.0 (Windows NT 10.0; WOW64; rv:52.0) Gecko/20100101 Firefox/52.0", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.79 Safari/537.36 Edge/14.14393"

]

四、settngs.py配置

#======================================== # 设置IP池和用户代理 # 禁止本地Cookie

COOKIES_ENABLED = False # 下载中间件配置指向(注意这里的工程名字是"demo3",指向DOWNLOADER_MIDDLEWARES = {

# 'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware':123,

# 'demo3.middlewares.HTTPPROXY' : 125,

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': 2,

'demo3.middlewares.USERAGENT': 1

} # 管道指向配置(注意这里的工程名字是"demo3",指向ITEM_PIPELINES = {

'demo3.pipelines.Demo3Pipeline': 300,

} #============================================

五、定义爬取关注的数据(items.py文件)

# -*- coding: utf-8 -*-

import scrapy

# Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html

class Demo3Item(scrapy.Item):

name = scrapy.Field()

link = scrapy.Field()

六、爬虫文件编写(test.py)

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from demo3.items import Demo3Item class TestSpider(CrawlSpider):

name = 'test'

allowed_domains = ['sohu.com']

start_urls = ['http://www.sohu.com/'] rules = (

Rule(LinkExtractor(allow=('http://news.sohu.com'), allow_domains=('sohu.com')), callback='parse_item', follow=False),

#Rule(LinkExtractor(allow=('.*?/n.*?shtml'),allow_domains=('sohu.com')), callback='parse_item', follow=False),

) def parse_item(self, response):

i = Demo3Item()

i['name'] = response.xpath('//div[@class="news"]/h1/a/text()').extract()

i['link'] = response.xpath('//div[@class="news"]/h1/a/@href').extract()

return i

七、管道文件编写(pipelines.py)

# -*- coding: utf-8 -*-

import codecs

import json

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

class Demo3Pipeline(object):

def __init__(self):

self.file = codecs.open("E:/workspace/PyCharm/codeSpace/books/python_web_crawler_book/chapter17/demo3/1.json", "wb", encoding='utf-8') def process_item(self, item, spider):

for j in range(0, len(item["name"])):

name = item["name"][j]

link = item["link"][j]

datas = {"name": name, "link": link}

i = json.dumps(dict(datas), ensure_ascii=False)

line = i + '\n'

self.file.write(line)

return item

def close_spider(self, spider):

self.file.close()

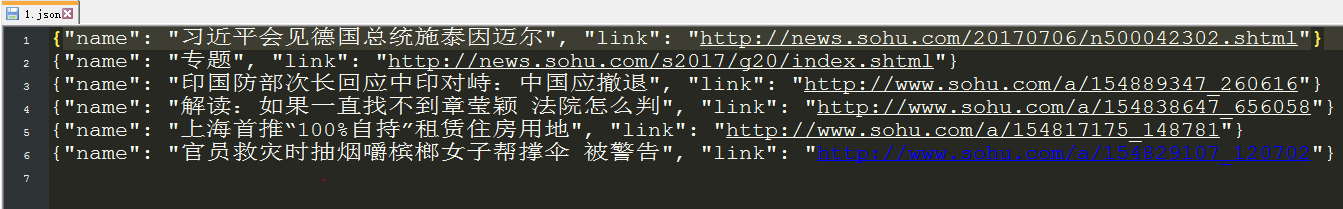

八、测试(scrapy crawl test )之后,生成了1.json文件

python框架Scrapy中crawlSpider的使用的更多相关文章

- python框架Scrapy中crawlSpider的使用——爬取内容写进MySQL

一.先在MySQL中创建test数据库,和相应的site数据表 二.创建Scrapy工程 #scrapy startproject 工程名 scrapy startproject demo4 三.进入 ...

- python框架Django中MTV框架之VIew(业务控制器)

MTV框架之VIew(业务控制器) 关注公众号"轻松学编程"了解更多. 1.什么是视图 视图层=路由表(urls.py)+视图函数(views.py) 其角色相当于MVC中的Con ...

- python框架Django中MTV框架之Template(模板/界面)

MTV框架之Template(模板/界面) 关注公众号"轻松学编程"了解更多. 1.模板目录位置 应用下 不需要注册 无法跨应用地进行复用 工程下 需要注册 settings.py ...

- python框架Django中MTV之Model(数据模型)

MTV框架之Model(数据模型) 关注公众号"轻松学编程"了解更多. 1.连接MySQL数据库 项目中的settings.py设置范例 # 配置数据库 DATABASES = { ...

- python框架Django中的MTV架构

MTV架构 关注公众号"轻松学编程"了解更多. 通过V对M和T进行连接,用户通过T(界面)对服务器进行访问(发送请求),T把请求传给V(调度),V调用M(数据模型)获取数据,把 ...

- scrapy 中crawlspider 爬虫

爬取目标网站: http://www.chinanews.com/rss/rss_2.html 获取url后进入另一个页面进行数据提取 检查网页: 爬虫该页数据的逻辑: Crawlspider爬虫类: ...

- python框架django中结合vue进行前后端分离

一:创建django项目 1.django-admin startproject mysite # 创建mysite项目 2.django-admin startapp app01# 创建app01应 ...

- python框架Scrapy报错TypeError: 'float' object is not iterable解决

原因是:Twisted版本高了. 解决办法: 只要把Twisted库降级到16.6.0即可: pip3 install Twisted== 注:Twisted16..0安装后,会自动卸载高版本的Twi ...

- 教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http://www.xiaohuar.com/,让你体验爬取校花的成就感. Scr ...

随机推荐

- delete与delete [] 真正差别

我们通常从教科书上看到这种说明: delete 释放new分配的单个对象指针指向的内存 delete[] 释放new分配的对象数组指针指向的内存 那么,依照教科书的理解,我们看下以下的代码: int ...

- PHP实现AOP的雏形

AOP是OOP的延续,是Aspect Oriented Programming的缩写,意思是面向方面编程,有的又称之为面向切面编程.在企业级开发中面向方面编程很有用.比如,我们在调用某些特定的方法之前 ...

- Atitit JAVA p2p设计与总结 JXTA 2

Atitit JAVA p2p设计与总结 JXTA 2 JXTA 2 是开放源代码 P2P 网络的第二个主要版本,它利用流行的.基于 Java 的参考实现作为构建基础.在设计方面进行了重要的修改,以 ...

- [svc]rsyslog及logrotate小结

[root@node1 logrotate.d]# ls dracut haproxy httpd mcelog nginx ppp psacct syslog yum yum install ngi ...

- Android开发-状态栏着色原理和API版本号兼容处理

介绍 先上实际效果图,有三个版本号请注意区分API版本号 API>=20 API=19 API<19 watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZX ...

- uva 11400 - Lighting System Design(动态规划 最长上升子序列问题变型)

本题难处好像是在于 能够把一些灯泡换成电压更高的灯泡以节省电源的钱 .所以也才有了对最优方案的探求 好的处理方法是依照电压从小到大排序.仅仅能让前面的换成后面的.也就满足了把一些灯泡换成电压更高的灯泡 ...

- 使用response.setHeader("Content-Disposition","attachment;filename="+fName)下载文件,中文文件名无法显示的问题

今天遇到这么一个情况,在Action代码中进行文件下载: ActionForm得到file_id,通过file_id进行数据库查询得到file_name以及服务器硬盘上的file_uri,其中file ...

- jsp中判断对象是否存在

<!-- 如果user对象存在,则显示用户名,如果不存在,则显示空值--> <input type="text" id="userName" ...

- target="_blank" 导致的钓鱼攻击

挺久的漏洞,之前没仔细看现在看了下 直接构建实验环境: test1.html: <!DOCTYPE html> <html> <head> <meta cha ...

- 浅谈myeclipse2015做cordova/phonegap开发

近期公司项目经理要求用cordova写安卓程序,之前对cordova什么都不懂,然后从网上搜啊搜,好歹有所了解了,感觉做web开发的比較合适,属于三种开发模式的第三种. myeclipse2015有个 ...