基于知识图谱的《红楼梦》人物关系可视化及问答系统(含码源):命名实体识别、关系识别、LTP简单教学

基于知识图谱的《红楼梦》人物关系可视化及问答系统(含码源):命名实体识别、关系识别、LTP简单教学

文件树:

- app.py是整个系统的主入口

- templates文件夹是HTML的页面

|-index.html 欢迎界面

|-search.html 搜索人物关系页面

|-all_relation.html 所有人物关系页面

|-KGQA.html 人物关系问答页面 - static文件夹存放css和js,是页面的样式和效果的文件

- raw_data文件夹是存在数据处理后的三元组文件

- neo_db文件夹是知识图谱构建模块

|-config.py 配置参数

|-create_graph.py 创建知识图谱,图数据库的建立

|-query_graph.py 知识图谱的查询 - KGQA文件夹是问答系统模块

|-ltp.py 分词、词性标注、命名实体识别 - spider文件夹是爬虫模块

|- get_*.py 是之前爬取人物资料的代码,已经产生好images和json 可以不用再执行

|-show_profile.py 是调用人物资料和图谱展示在前端的代码

部署步骤:

- 0.安装所需的库 执行pip install -r requirement.txt

- 1.先下载好neo4j图数据库,并配好环境(注意neo4j需要jdk8)。修改neo_db目录下的配置文件config.py,设置图数据库的账号和密码。

- 2.切换到neo_db目录下,执行python create_graph.py 建立知识图谱

- 3.去 这里 下载好ltp模型。ltp简介

- 4.在KGQA目录下,修改ltp.py里的ltp模型文件的存放目录

- 5.运行python app.py,浏览器打开localhost:5000即可查看

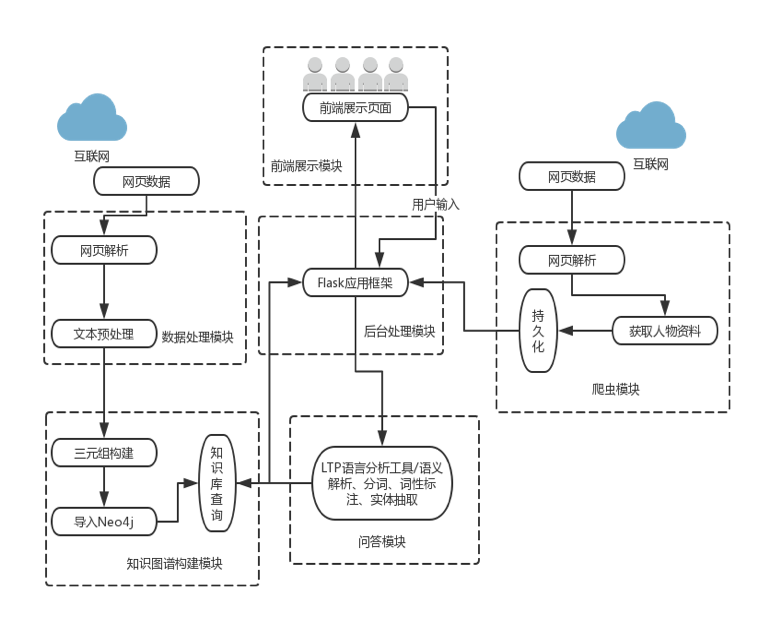

1.系统整体流程图:

项目码源见文章顶部或文末

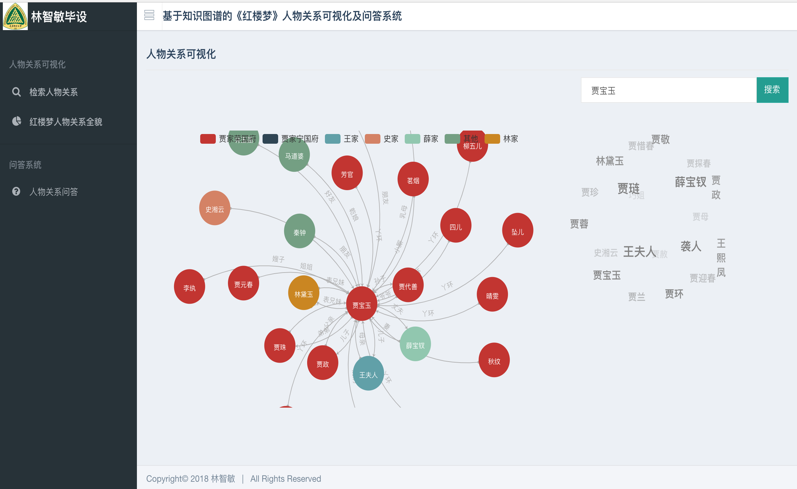

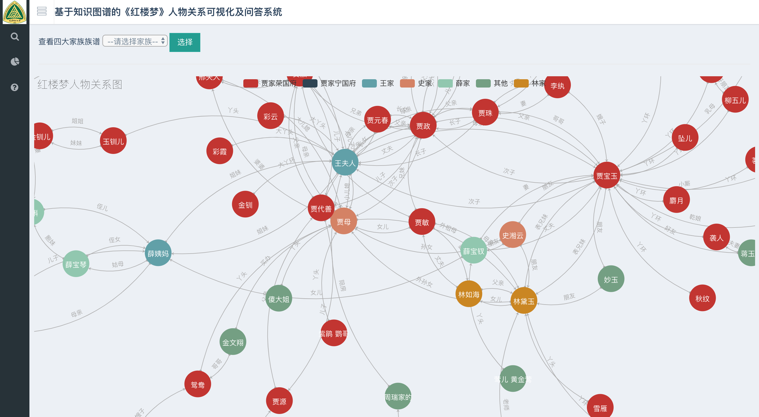

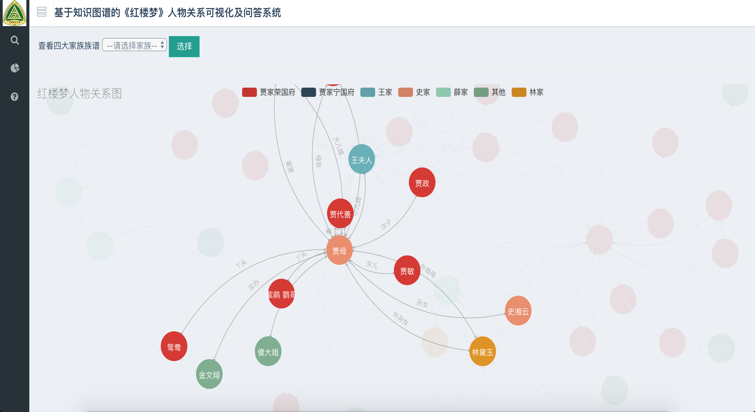

2.主界面-基于知识图谱的《红楼梦》人物关系可视化及问答系统

网站示例:

欢迎界面

3.KGQA部分码源展示

#-*- coding: utf-8 -*-

import pyltp

import os

LTP_DATA_DIR = '/Users/chizhu/data/ltp_data_v3.4.0' # ltp模型目录的路径

def cut_words(words):

segmentor = pyltp.Segmentor()

seg_model_path = os.path.join(LTP_DATA_DIR, 'cws.model')

segmentor.load(seg_model_path)

words = segmentor.segment(words)

array_str="|".join(words)

array=array_str.split("|")

segmentor.release()

return array

def words_mark(array):

# 词性标注模型路径,模型名称为`pos.model`

pos_model_path = os.path.join(LTP_DATA_DIR, 'pos.model')

postagger = pyltp.Postagger() # 初始化实例

postagger.load(pos_model_path) # 加载模型

postags = postagger.postag(array) # 词性标注

pos_str=' '.join(postags)

pos_array=pos_str.split(" ")

postagger.release() # 释放模型

return pos_array

def get_target_array(words):

target_pos=['nh','n']

target_array=[]

seg_array=cut_words(words)

pos_array = words_mark(seg_array)

for i in range(len(pos_array)):

if pos_array[i] in target_pos:

target_array.append(seg_array[i])

target_array.append(seg_array[1])

return target_array

4.LTP简单教学

pyltp 是 LTP 的 Python 封装,提供了分词,词性标注,命名实体识别,依存句法分析,语义角色标注的功能。

关于各个模块任务的介绍、标注体系、性能指标,可以查阅 这里 的介绍。

pyltp 的所有输入的分析文本和输出的结果的编码均为 UTF-8。

如果您以非 UTF-8 编码的文本输入进行分析,结果可能为空。请注意源代码文件的默认编码。

由于 Windows 终端采用 GBK 编码显示,直接输出 pyltp 的分析结果会在终端显示为乱码。您可以将标准输出重定向到文件,以 UTF8 方式查看文件,就可以解决显示乱码的问题。

4.1分句

使用 pyltp 进行分句示例如下

#-*- coding: utf-8 -*-

from pyltp import SentenceSplitter

sents = SentenceSplitter.split('元芳你怎么看?我就趴窗口上看呗!') # 分句

print '\n'.join(sents)

结果如下

4.2分词

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import Segmentor

segmentor = Segmentor() # 初始化实例

segmentor.load(cws_model_path) # 加载模型

words = segmentor.segment('元芳你怎么看') # 分词

print '\t'.join(words)

segmentor.release() # 释放模型

结果如下

words = segmentor.segment('元芳你怎么看') 的返回值类型是 native 的 VectorOfString 类型,可以使用 list 转换成 Python 的列表类型,例如

...

>>> words = segmentor.segment('元芳你怎么看')

>>> type(words)

<class 'pyltp.VectorOfString'>

>>> words_list = list(words)

>>> type(words_list)

<type 'list'>

>>> print words_list

['\xe5\xae\xa2\xe6\x9c\x8d', '\xe5\xa4\xaa', '\xe7\xb3\x9f\xe7\xb3\x95', '\xe4\xba\x86']

4.2.1使用分词外部词典

pyltp 分词支持用户使用自定义词典。分词外部词典本身是一个文本文件(plain text),每行指定一个词,编码同样须为 UTF-8,样例如下所示

示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import Segmentor

segmentor = Segmentor() # 初始化实例

segmentor.load_with_lexicon(cws_model_path, '/path/to/your/lexicon') # 加载模型,第二个参数是您的外部词典文件路径

words = segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

segmentor.release()

4.2.2使用个性化分词模型

个性化分词是 LTP 的特色功能。个性化分词为了解决测试数据切换到如小说、财经等不同于新闻领域的领域。 在切换到新领域时,用户只需要标注少量数据。 个性化分词会在原有新闻数据基础之上进行增量训练。 从而达到即利用新闻领域的丰富数据,又兼顾目标领域特殊性的目的。

pyltp 支持使用用户训练好的个性化模型。关于个性化模型的训练需使用 LTP,详细介绍和训练方法请参考 个性化分词 。

在 pyltp 中使用个性化分词模型的示例如下

#*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import CustomizedSegmentor

customized_segmentor = CustomizedSegmentor() # 初始化实例

customized_segmentor.load(cws_model_path, '/path/to/your/customized_model') # 加载模型,第二个参数是您的增量模型路径

words = customized_segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

customized_segmentor.release()

同样,使用个性化分词模型的同时也可以使用外部词典

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

cws_model_path = os.path.join(LTP_DATA_DIR, 'cws.model') # 分词模型路径,模型名称为`cws.model`

from pyltp import CustomizedSegmentor

customized_segmentor = CustomizedSegmentor() # 初始化实例

customized_segmentor.load_with_lexicon(cws_model_path, '/path/to/your/customized_model', '/path/to/your/lexicon') # 加载模型

words = customized_segmentor.segment('亚硝酸盐是一种化学物质')

print '\t'.join(words)

customized_segmentor.release()

4.3词性标注

使用 pyltp 进行词性标注示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

pos_model_path = os.path.join(LTP_DATA_DIR, 'pos.model') # 词性标注模型路径,模型名称为`pos.model`

from pyltp import Postagger

postagger = Postagger() # 初始化实例

postagger.load(pos_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看'] # 分词结果

postags = postagger.postag(words) # 词性标注

print '\t'.join(postags)

postagger.release() # 释放模型

结果如下

参数 words 是分词模块的返回值,也支持 Python 原生的 list 类型,例如

words = ['元芳', '你', '怎么', '看']

postags = postagger.postag(words)

LTP 使用 863 词性标注集,详细请参考 词性标注集 。

- 使用词性标注外部词典

pyltp 词性标注同样支持用户的外部词典。词性标注外部词典同样为一个文本文件,每行指定一个词,第一列指定单词,第二列之后指定该词的候选词性(可以有多项,每一项占一列),列与列之间用空格区分。示例如下

命名实体识别

使用 pyltp 进行命名实体识别示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

ner_model_path = os.path.join(LTP_DATA_DIR, 'ner.model') # 命名实体识别模型路径,模型名称为`pos.model`

from pyltp import NamedEntityRecognizer

recognizer = NamedEntityRecognizer() # 初始化实例

recognizer.load(ner_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

netags = recognizer.recognize(words, postags) # 命名实体识别

print '\t'.join(netags)

recognizer.release() # 释放模型

其中,words 和 postags 分别为分词和词性标注的结果。同样支持 Python 原生的 list 类型。

结果如下

LTP 采用 BIESO 标注体系。B 表示实体开始词,I 表示实体中间词,E 表示实体结束词,S 表示单独成实体,O 表示不构成命名实体。

LTP 提供的命名实体类型为: 人名(Nh)、地名(Ns)、机构名(Ni)。

B、I、E、S 位置标签和实体类型标签之间用一个横线 - 相连;O 标签后没有类型标签。

详细标注请参考 命名实体识别标注集 。

4.4依存句法分析

使用 pyltp 进行依存句法分析示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

par_model_path = os.path.join(LTP_DATA_DIR, 'parser.model') # 依存句法分析模型路径,模型名称为`parser.model`

from pyltp import Parser

parser = Parser() # 初始化实例

parser.load(par_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

arcs = parser.parse(words, postags) # 句法分析

print "\t".join("%d:%s" % (arc.head, arc.relation) for arc in arcs)

parser.release() # 释放模型

其中,words 和 postags 分别为分词和词性标注的结果。同样支持 Python 原生的 list 类型。

结果如下

arc.head 表示依存弧的父节点词的索引。ROOT 节点的索引是 0,第一个词开始的索引依次为 1、2、3…

arc.relation 表示依存弧的关系。

arc.head 表示依存弧的父节点词的索引,arc.relation 表示依存弧的关系。

标注集请参考 依存句法关系 。

4.5语义角色标注

使用 pyltp 进行语义角色标注示例如下

#-*- coding: utf-8 -*-

import os

LTP_DATA_DIR = '/path/to/your/ltp_data' # ltp模型目录的路径

srl_model_path = os.path.join(LTP_DATA_DIR, 'srl') # 语义角色标注模型目录路径,模型目录为`srl`。注意该模型路径是一个目录,而不是一个文件。

from pyltp import SementicRoleLabeller

labeller = SementicRoleLabeller() # 初始化实例

labeller.load(srl_model_path) # 加载模型

words = ['元芳', '你', '怎么', '看']

postags = ['nh', 'r', 'r', 'v']

#arcs 使用依存句法分析的结果

roles = labeller.label(words, postags, arcs) # 语义角色标注

#打印结果

for role in roles:

print role.index, "".join(

["%s:(%d,%d)" % (arg.name, arg.range.start, arg.range.end) for arg in role.arguments])

labeller.release() # 释放模型

结果如下

3 A0:(0,0)A0:(1,1)ADV:(2,2)

第一个词开始的索引依次为 0、1、2…

返回结果 roles 是关于多个谓词的语义角色分析的结果。由于一句话中可能不含有语义角色,所以结果可能为空。

role.index 代表谓词的索引, role.arguments 代表关于该谓词的若干语义角色。

arg.name 表示语义角色类型,arg.range.start 表示该语义角色起始词位置的索引,arg.range.end 表示该语义角色结束词位置的索引。

例如上面的例子,由于结果输出一行,所以 “元芳你怎么看” 有一组语义角色。 其谓词索引为 3,即 “看”。这个谓词有三个语义角色,范围分别是(0,0) 即“元芳”,(1,1)即 “你”,(2,2) 即“怎么”,类型分别是 A0、A0、ADV。

arg.name 表示语义角色关系,arg.range.start 表示起始词位置,arg.range.end 表示结束位置。

更多优质内容请关注公号&知乎:汀丶人工智能;会提供一些相关的资源和优质文章,免费获取阅读。

项目码源见文章顶部或文末

基于知识图谱的《红楼梦》人物关系可视化及问答系统(含码源):命名实体识别、关系识别、LTP简单教学的更多相关文章

- 红楼梦人物关系图,一代大师成绝响,下回分解待何人,kindle读书摘要

人物关系图: https://www.cnblogs.com/images/cnblogs_com/elesos/1120632/o_2033091006.jpg 红楼梦 (古典名著普及文库) ( ...

- 用深度学习模型Word2Vec探索《红楼梦》人物关系

先来看一看结果,发现: 1.贾宝玉和袭人的关系最近. 2.薛宝钗和自己的妈妈关系最近. 3.贾宝玉和林黛玉逼格比较统一,薛宝钗属于独树一帜的逼格调性. 4.大观园中可以看到邢岫烟经常出没... 还有更 ...

- 文本可视化[二]——《今生今世》人物关系可视化python实现

文本可视化[二]--<今生今世>人物关系可视化python实现 在文本可视化[一]--<今生今世>词云生成与小说分析一文中,我使用了jieba分词和wordcloud实现了,文 ...

- Google BERT应用之《红楼梦》对话人物提取

Google BERT应用之<红楼梦>对话人物提取 https://www.jiqizhixin.com/articles/2019-01-24-19

- Python3红楼梦人名出现次数统计分析

一.程序说明 本程序流程是读取红楼梦txt文件----使用jieba进行分词----借助Counter读取各人名出现次数并排序----使用matplotlib将结果可视化 这里的统计除了将“熙凤”出现 ...

- 基于知识图谱的APT组织追踪治理

高级持续性威胁(APT)正日益成为针对政府和企业重要资产的不可忽视的网络空间重大威胁.由于APT攻击往往具有明确的攻击意图,并且其攻击手段具备极高的隐蔽性和潜伏性,传统的网络检测手段通常无法有效对其进 ...

- 用R进行文本分析初探——以《红楼梦》为例

一.写在前面的话~ 刚吃饭的时候同学问我,你为什么要用R做文本分析,你不是应该用R建模么,在我和她解释了一会儿后,她嘱咐我好好写这篇博文,嗯为了娟儿同学,细细说一会儿文本分析. 文本数据挖掘(Text ...

- 红楼梦3d游戏

1. 红楼梦大观园2d图 2. 红楼梦3d图 潇湘馆 注册机:根据电脑名和时间生成一个id,然后根据注册机生成注册码.

- iOS_12_tableViewCell的删除更新_红楼梦

终于效果图: Girl.h // // Girl.h // 12_tableView的增删改 // // Created by beyond on 14-7-27. // Copyright (c) ...

- 朴素贝叶斯文本分类-在《红楼梦》作者鉴别的应用上(python实现)

朴素贝叶斯算法简单.高效.接下来我们来介绍其如何应用在<红楼梦>作者的鉴别上. 第一步,当然是先得有文本数据,我在网上随便下载了一个txt(当时急着交初稿...).分类肯定是要一个回合一个 ...

随机推荐

- Android 黑马 52 期视频,不加密,免费下载

Android 黑马学习视频 目录 01.安卓基础+JNI (14天) 02.Android应用开 发-代码版本管理和实战(1天) 03.android案 例与项目_手机安全卫士(12天) 04.自定 ...

- Mysql--binlog日志

一.简介 binlog日志也称二进制日志,记录了所有的DDL和DML( 除了数据查询语句 )语句,以事件形式记录,还包含语句所执行的消耗的时间,MySQL的二进制日志是事务安全型的. 一般来说开启二进 ...

- Woodpecker CI 设计分析|一个 Go 编写的开源持续集成引擎

一.前言 大家好,这里是白泽.随着 Go 语言在云原生领域大放异彩,开发者逐渐将目光转移到了这门语言上,而容器则是云原生时代最核心的载体. <Woodpecker CI 设计分析>系列文章 ...

- CPP-移动语义

"Move semantics allows us to optimize the copying of objects, where we no longer need the value ...

- 汇编 | mov. add. sub指令

Description 前面我们用到了mov, add. sub指令,它们都带有两个操作对象.到现在,我们知道,mov指令可以有以下几种形式. mov 寄存器,数据 比如: mov ax,8 mov ...

- Codeforces Round #663 (Div. 2) (A~C题,C题 Good)

比赛链接:Here 1391A. Suborrays 简单构造题, 把 \(n\) 放最前面,接着补 \(1\) ~ \(n - 1\) 即可 1391B. Fix You \((1,1)\) -&g ...

- Java ConcurrentHashMap 高并发安全实现原理解析

本文首发于 vivo互联网技术 微信公众号链接:https://mp.weixin.qq.com/s/4sz6sTPvBigR_1g8piFxug作者:vivo 游戏技术团队 一.概述 Concurr ...

- 二、mongo集群搭建

系列导航 一.linux单机版mongo安装(带密码验证) 二.mongo集群搭建 三.java连接mongo数据库 四.java对mongo数据库增删改查操作 五.mongo备份篇 mongoexp ...

- node-sass安装失败,安装后无法使用 gyp verb check python checking for Python executable "python2" in the PATH

这个问题搞了一会想起开始安装node-sass时的一句被我忽略的提示:执行 npm rebuild node-sass 这行后就可以了. 再说说 node-sass 的安装问题,现在使用 yarn i ...

- Java虚拟机——内存区域及内存溢出异常

一.Java内存区域 1.概述 对于java程序员来说,在虚拟机的自动内存管理机制的帮助下,不需要为每一个new操作去写delete/free代码,而且不容易出现内存泄漏和内存溢出问题.但是把内存控制 ...