sparkStreaming 读kafka的数据

目标:sparkStreaming每2s中读取一次kafka中的数据,进行单词计数。

topic:topic1

broker list:192.168.1.126:9092,192.168.1.127:9092,192.168.1.128:9092

1、首先往一个topic中实时生产数据。

代码如下: 代码功能:每秒向topic1发送一条消息,一条消息里包含4个单词,单词之间用空格隔开。

package kafkaProducer

import java.util.HashMap

import org.apache.kafka.clients.producer._

object KafkaProducer {

def main(args: Array[String]) {

val topic="topic1"

val brokers="192.168.1.126:9092,192.168.1.127:9092,192.168.1.128:9092"

val messagesPerSec=1 //每秒发送几条信息

val wordsPerMessage =4 //一条信息包括多少个单词

// Zookeeper connection properties

val props = new HashMap[String, Object]()

props.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, brokers)

props.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG,

"org.apache.kafka.common.serialization.StringSerializer")

props.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG,

"org.apache.kafka.common.serialization.StringSerializer")

val producer = new KafkaProducer[String, String](props)

// Send some messages

while(true) {

(1 to messagesPerSec.toInt).foreach { messageNum =>

val str = (1 to wordsPerMessage.toInt).map(x => scala.util.Random.nextInt(10).toString)

.mkString(" ")

val message = new ProducerRecord[String, String](topic, null, str)

producer.send(message)

println(message)

}

Thread.sleep(1000)

}

}

}

打包运行命令:hadoop jar jar包 (注意jar包是可运行的jar包)

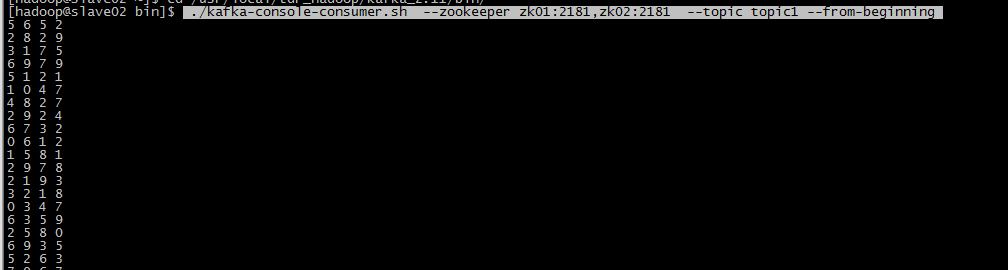

消费者消费命令: ./kafka-console-consumer.sh --zookeeper zk01:2181,zk02:2181 --topic topic1 --from-beginning

可以正常消费。

2、编写SparkStreaming代码读kafka中的数据,每2s读一次

代码如下:

package kafkaSparkStream import org.apache.spark.SparkConf

import org.apache.spark.streaming.StreamingContext

import org.apache.spark.streaming.Seconds

import org.apache.spark.streaming.kafka.KafkaUtils

import kafka.serializer.StringDecoder

/**

* sparkStreaming读取kafka中topic的数据

*/

object KafkaToSpark {

def main(args: Array[String]) {

if (args.length<2) {

System.err.println("Usage: <brokers> <topics>");

System.exit(1)

}

val Array(brokers,topics)=args

//2s从kafka中读取一次

val conf=new SparkConf().setAppName("KafkaToSpark");

val scc=new StreamingContext(conf,Seconds(2))

// Create direct kafka stream with brokers and topics

val topicSet=topics.split(",").toSet

val kafkaParams=Map[String,String]("metadata.broker.list"->brokers)

//获取信息

val messages=KafkaUtils.createDirectStream[String, String, StringDecoder, StringDecoder](

scc,kafkaParams,topicSet)

// Get the lines, split them into words, count the words and print

val lines= messages.map(_._2)

val words=lines.flatMap(_.split(" "))

val wordCouts=words.map(x =>(x,1L)).reduceByKey(_+_)

wordCouts.print

//开启计算

scc.start()

scc.awaitTermination()

} }

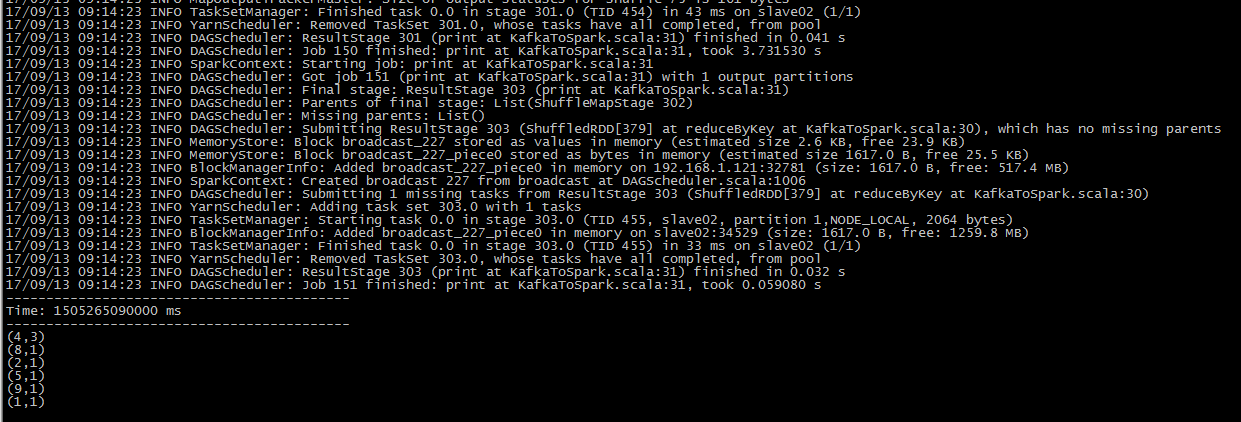

打包运行命令:./spark-submit --class kafkaSparkStream.KafkaToSpark --master yarn-client /home/hadoop/sparkJar/kafkaToSpark.jar 192.168.1.126:9092,192.168.1.127:9092,192.168.1.128:9092 topic1

运行成功!

sparkStreaming 读kafka的数据的更多相关文章

- SparkStreaming消费kafka中数据的方式

有两种:Direct直连方式.Receiver方式 1.Receiver方式: 使用kafka高层次的consumer API来实现,receiver从kafka中获取的数据都保存在spark exc ...

- spark-streaming读kafka数据到hive遇到的问题

在项目中使用spark-stream读取kafka数据源的数据,然后转成dataframe,再后通过sql方式来进行处理,然后放到hive表中, 遇到问题如下,hive-metastor在没有做高可用 ...

- Spark Streaming使用Kafka保证数据零丢失

来自: https://community.qingcloud.com/topic/344/spark-streaming使用kafka保证数据零丢失 spark streaming从1.2开始提供了 ...

- 大数据学习day32-----spark12-----1. sparkstreaming(1.1简介,1.2 sparkstreaming入门程序(统计单词个数,updateStageByKey的用法,1.3 SparkStreaming整合Kafka,1.4 SparkStreaming获取KafkaRDD的偏移量,并将偏移量写入kafka中)

1. Spark Streaming 1.1 简介(来源:spark官网介绍) Spark Streaming是Spark Core API的扩展,其是支持可伸缩.高吞吐量.容错的实时数据流处理.Sp ...

- spark-streaming集成Kafka处理实时数据

在这篇文章里,我们模拟了一个场景,实时分析订单数据,统计实时收益. 场景模拟 我试图覆盖工程上最为常用的一个场景: 1)首先,向Kafka里实时的写入订单数据,JSON格式,包含订单ID-订单类型-订 ...

- SparkStreaming获取kafka数据的两种方式:Receiver与Direct

简介: Spark-Streaming获取kafka数据的两种方式-Receiver与Direct的方式,可以简单理解成: Receiver方式是通过zookeeper来连接kafka队列, Dire ...

- SparkStreaming与Kafka,SparkStreaming接收Kafka数据的两种方式

SparkStreaming接收Kafka数据的两种方式 SparkStreaming接收数据原理 一.SparkStreaming + Kafka Receiver模式 二.SparkStreami ...

- 图解SparkStreaming与Kafka的整合,这些细节大家要注意!

前言 老刘是一名即将找工作的研二学生,写博客一方面是复习总结大数据开发的知识点,一方面是希望帮助更多自学的小伙伴.由于老刘是自学大数据开发,肯定会存在一些不足,还希望大家能够批评指正,让我们一起进步! ...

- 读Kafka Consumer源码

最近一直在关注阿里的一个开源项目:OpenMessaging OpenMessaging, which includes the establishment of industry guideline ...

随机推荐

- Java的设计模式(7)— 生产者-消费者模式

生产者-消费者模式是一个经典的多线程设计模式,它为多线程间的协作提供了良好的解决方案.这个模式中,通常有两类线程,即若干个生产者线程和若干个消费者线程.生产者线程负责提交用户请求,消费者线程则负责具体 ...

- Java的设计模式(5)-- 策略模式

定义一系列算法,把它们一个个封装起来,并且使它们可以相互替换,本模式使得算法可以独立于使用它的客户而变化.策略模式包括以下三种角色 策略(Strategy):策略是一个接口,该接口定义若干个算法标识, ...

- Python循环的基本使用(for in、while)

Python的循环有两种: 一种是for-in 循环:主要用于遍历tuple.list; 一种是while循环:只要条件满足,就不断循环,条件不满足时退出循环. #!/usr/bin/python # ...

- 10分钟搭建一个小型网页(python django)(hello world!)

10分钟搭建一个小型网页(python django)(hello world!) 1.安装django pip install django 安装成功后,在Scripts目录下存在django-ad ...

- python第二天---字符串的魔法

# "adcbdefg" # "a" # 判断某个东西是否在里面包含 in | not in # name = "abcdefg" # # ...

- 腾讯云开发微信小程序使用体验

主体内容 代码构成 数据:JSON 配置文件 结构:WXML 模版文件 样式:WXSS 页面样式 交互:JS 脚本逻辑文件 云开发 云数据库 云函数 云存储 WXML 是小程序框架设计的一套标签语言, ...

- PowerBuilder学习笔记之行删除卡死问题

在数据窗口勾选这两个选项后,在删除行数据时会导致系统直接崩溃退出

- Java8新特性 - 方法引用与构造器引用

方法引用 若Lambda体中的内容有方法已经实现了,我们可以使用"方法应用",可以理解为方法引用是Lambda表达式的另外一种表现形式. 使用操作符"::"将方 ...

- 基于【 springBoot +springCloud+vue 项目】一 || 项目架构简介

一.前言 基于前期学习以及工作经验积累,持续更新基于springboot+springcloud+vue的demo项目.

- python使用Pyinstaller打包

一.前言 python文件打包,将.py文件转化成.exe文件(windows平台),可以使用Pyinstaller来打包 Pyinstaller可以在全平台下使用,但是请注意打包生成的文件不能在全平 ...