HBase协处理器同步二级索引到Solr

一、 背景

在实际生产中,HBase往往不能满足多维度分析,我们能想到的办法就是通过创建HBase数据的二级索引来快速获取rowkey,从而得到想要的数据。目前比较流行的二级索引解决方案有Lily HBase Indexer,Phoenix自带的二级索引,华为Indexer,以及360的二级索引方案。上面的目前使用比较广泛的应该是Lily HBase Indexer,但是我们有时候只想实现一些简单的功能或者比较特殊的功能的时候,需要自己写协处理器进行处理。学习HBase的协处理器对于了解HBase架构是有帮助的。

二、 什么是HBase的协处理器

协处理器分两种类型,系统协处理器可以全局导入region server上的所有数据表,表协处理器即是用户可以指定一张表使用协处理器。

Hbase的coprocessor分为两类,Observer和EndPoint。其中Observer相当于触发器,EndPoint相当于存储过程。其中Observer的代码部署在服务端,相当于对API调用的代理。

另一个是终端(endpoint),动态的终端有点像存储过程。

Observer

观察者的设计意图是允许用户通过插入代码来重载协处理器框架的upcall方法,而具体的事件触发的callback方法由HBase的核心代码来执行。协处理器框架处理所有的callback调用细节,协处理器自身只需要插入添加或者改变的功能。以HBase0.92版本为例,它提供了三种观察者接口:

- RegionObserver:提供客户端的数据操纵事件钩子:Get、Put、Delete、Scan等。

- WALObserver:提供WAL相关操作钩子。

- MasterObserver:提供DDL-类型的操作钩子。如创建、删除、修改数据表等。

这些接口可以同时使用在同一个地方,按照不同优先级顺序执行.用户可以任意基于协处理器实现复杂的HBase功能层。HBase有很多种事件可以触发观察者方法,这些事件与方法从HBase0.92版本起,都会集成在HBase API中。不过这些API可能会由于各种原因有所改动,不同版本的接口改动比较大。

三、 HBase协处理器同步数据到Solr

实时更新数据需要获取到HBase的插入、更新和删除操作。由于HBase中的插入和更新都是对应RegionServer的Put操作,因此我们需要使用RegionObserver中的"postPut"和"postDelete函数"。至于Truncate操作则需要使用MasterObserver。

我们需要做的就是拦截put和delete操作,将里面的内容获取出来,写入Solr。 对应的协处理器代码如下:

package com.bqjr.bigdata.HBaseObserver.server;import com.bqjr.bigdata.HBaseObserver.entity.SolrServerManager;import org.apache.hadoop.hbase.CellUtil;import org.apache.hadoop.hbase.client.Delete;import org.apache.hadoop.hbase.client.Durability;import org.apache.hadoop.hbase.client.Put;import org.apache.hadoop.hbase.coprocessor.BaseRegionObserver;import org.apache.hadoop.hbase.coprocessor.ObserverContext;import org.apache.hadoop.hbase.coprocessor.RegionCoprocessorEnvironment;import org.apache.hadoop.hbase.regionserver.wal.WALEdit;import org.apache.hadoop.hbase.util.Bytes;import org.apache.solr.client.solrj.SolrServerException;import org.apache.solr.common.SolrInputDocument;import java.io.IOException;/*** Created by hp on 2017-02-15. */public class HBaseIndexerToSolrObserver extends BaseRegionObserver{String[] columns = {"test_age","test_name"};String collection = "bqjr";SolrServerManager solrManager = new SolrServerManager(collection);@Overridepublic void postPut(ObserverContext<RegionCoprocessorEnvironment> e,Put put, WALEdit edit, Durability durability) throws IOException {String rowkey= Bytes.toString(put.getRow());SolrInputDocument doc = new SolrInputDocument();for(String column : columns){if(put.has(Bytes.toBytes("cf1"),Bytes.toBytes(column))){doc.addField(column,Bytes.toString(CellUtil.cloneValue(put.get(Bytes.toBytes("cf1"),Bytes.toBytes(column)).get(0))));}}try {solrManager.addDocToCache(doc);} catch (SolrServerException e1) {e1.printStackTrace();}}@Overridepublic void postDelete(ObserverContext<RegionCoprocessorEnvironment> e,Delete delete,WALEdit edit,Durability durability) throws IOException{String rowkey= Bytes.toString(delete.getRow());try {solrManager.delete(rowkey);} catch (SolrServerException e1) {e1.printStackTrace();}}}

大体的写入流程我们已经完成了,接下来就是Solr的写入实现了。由于Solr需要使用Zookeeper等信息,我们可以直接通过HBase的conf中获取Zookeeper相关信息来构造所需要的SolrCloudServer。

另一方面,我们不能来了一条数据就马上写入,这样非常消耗资源。因此我们需要做一个缓存,将这些Solr数据暂时保存在里面,定时 + 定量的发送。代码如下

package com.bqjr.bigdata.HBaseObserver.entity;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.hbase.HBaseConfiguration;import org.apache.solr.client.solrj.SolrServerException;import org.apache.solr.client.solrj.impl.CloudSolrServer;import org.apache.solr.client.solrj.response.UpdateResponse;import org.apache.solr.common.SolrInputDocument;import java.io.IOException;import java.util.*;/*** Created by hp on 2017-02-15. */public class SolrServerManager {public static String ZKHost = "";public static String ZKPort = "";int zkClientTimeout = 1800000;// 心跳int zkConnectTimeout = 1800000;// 连接时间CloudSolrServer solrServer;private static String defaultCollection;int maxCache = 10000;public static List<SolrInputDocument> cache = new LinkedList<SolrInputDocument>();private static int maxCommitTime = 60; //最大提交时间,spublic SolrServerManager(String collection) {defaultCollection = collection;Configuration conf = HBaseConfiguration.create();ZKHost = conf.get("hbase.zookeeper.quorum", "bqdpm1,bqdpm2,bqdps2");ZKPort = conf.get("hbase.zookeeper.property.clientPort", "2181");String SolrUrl = ZKHost + ":" + ZKPort + "/" + "solr";solrServer = new CloudSolrServer(SolrUrl);solrServer.setDefaultCollection(defaultCollection);solrServer.setZkClientTimeout(zkClientTimeout);solrServer.setZkConnectTimeout(zkConnectTimeout);//启动定时任务,第一次延迟10执行,之后每隔指定时间执行一次Timer timer = new Timer();timer.schedule(new CommitTimer(), 10 * 1000L, maxCommitTime * 1000L);}public UpdateResponse put(SolrInputDocument doc) throws IOException, SolrServerException {solrServer.add(doc);return solrServer.commit(false, false);}public UpdateResponse put(List<SolrInputDocument> docs) throws IOException, SolrServerException {solrServer.add(docs);return solrServer.commit(false, false);}public void addDocToCache(SolrInputDocument doc) throws IOException, SolrServerException {synchronized (cache) {cache.add(doc);if (cache.size() >= maxCache) {this.put(cache);cache.clear();}}}public UpdateResponse delete(String rowkey) throws IOException, SolrServerException {solrServer.deleteById(rowkey);return solrServer.commit(false, false);}/*** 提交定时器 */ static class CommitTimer extends TimerTask {@Overridepublic void run() {synchronized (cache) {try {new SolrServerManager(defaultCollection).put(cache);cache.clear();} catch (IOException e) {e.printStackTrace();} catch (SolrServerException e) {e.printStackTrace();}cache.clear();}}}}

四、 添加协处理器

#先禁用这张表disable 'HBASE_OBSERVER_TEST'#为这张表添加协处理器,设置的参数具体为: jar文件路径|类名|优先级(SYSTEM或者USER)alter 'HBASE_OBSERVER_TEST','coprocessor'=>'hdfs://bqdpm1:8020/ext_lib/HBaseObserver-1.0.0.jar|com.bqjr.bigdata.HBaseObserver.server.HBaseIndexerToSolrObserver||'#启用这张表enable 'HBASE_OBSERVER_TEST'#删除某个协处理器,"$<bumber>"后面跟的ID号与desc里面的ID号相同alter 'HBASE_OBSERVER_TEST',METHOD=>'table_att_unset',NAME => 'coprocessor$1'

五、 测试

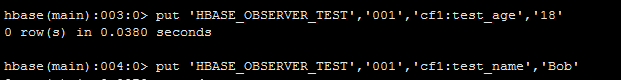

尝试插入一条数据put 'HBASE_OBSERVER_TEST','001','cf1:test_age','18'

结果Solr中一条数据都没有

然后查看了regionserver的日志发现,没有找到SolrJ的类

然后我们将所有的依赖加到Jar包里面之后,再次运行。就可以看到数据了。

测试Delete功能

测试进行到这里就完了吗?当然不是

我们尝试再插入一条put 'HBASE_OBSERVER_TEST','001','cf1:test_name','Bob'

理论上我们需要在Solr中看到 test_age = 18,test_name = Bob。

但是在Solr中只有一条数据

于是我们需要使用到Solr的原子更新功能。将postPut改成下面这样的代码即可

public void postPut(ObserverContext<RegionCoprocessorEnvironment> e,Put put, WALEdit edit, Durability durability) throws IOException {String rowkey= Bytes.toString(put.getRow());Long version = 1L;SolrInputDocument doc = new SolrInputDocument();for(String column : columns){if(put.has(Bytes.toBytes("cf1"),Bytes.toBytes(column))){Cell cell = put.get(Bytes.toBytes("cf1"),Bytes.toBytes(column)).get(0);Map<String, String > operation = new HashMap<String,String>();operation.put("set",Bytes.toString(CellUtil.cloneValue(cell)));doc.setField(column,operation);}}doc.addField("id",rowkey);// doc.addField("_version_",version);try {solrManager.addDocToCache(doc);} catch (SolrServerException e1) {e1.printStackTrace();}}

再次插入数据

查看Solr结果

六、 协处理器动态加载

hbase的官方文档指出动态级别的协处理器,可以做到不重启hbase,更新协处理,做法就是

禁用表,卸载协处理器,重新指定协处理器, 激活表,即可,但实际测试发现

动态加载无效,是hbase的一个bug,看这个链接:

https://issues.apache.org/jira/browse/HBASE-8445

因为协处理器,已经被JVM加载,即使删除jar也不能重新load的jar,因为cache里面的hdfs的jar路径,没有变化,所以动态更新无效

,除非重启JVM,那样就意味着,需要重启RegionServer,

里面的小伙伴们指出了两种办法,使协处理器加载生效:

(1)滚动重启regionserver,避免停掉所有的节点

(2)改变协处理器的jar的类名字或者hdfs加载路径,以方便有新的ClassLoad去加载它

但总体来看,第2种方法,比较安全,第一种风险太大,一般情况下没有人会随便滚动重启线上的服务器的,这只在hbase升级的时候使用

HBase协处理器同步二级索引到Solr的更多相关文章

- HBase协处理器同步二级索引到Solr(续)

一. 已知的问题和不足二.解决思路三.代码3.1 读取config文件内容3.2 封装SolrServer的获取方式3.3 编写提交数据到Solr的代码3.4 拦截HBase的Put和Delete操作 ...

- Hbase(三) hbase协处理器与二级索引

一.协处理器—Coprocessor 1. 起源Hbase 作为列族数据库最经常被人诟病的特性包括:无法轻易建立“二级索引”,难以执 行求和.计数.排序等操作.比如,在旧版本的(<0.92)Hb ...

- HBase 协处理器实现二级索引

HBase在0.92之后引入了coprocessors,提供了一系列的钩子,让我们能够轻易实现访问控制和二级索引的特性.下面简单介绍下两种coprocessors,第一种是Observers,它实际类 ...

- Lily HBase Indexer同步HBase二级索引到Solr丢失数据的问题分析

一.问题描述二.分析步骤2.1 查看日志2.2 修改Solr的硬提交2.3 寻求StackOverFlow帮助2.4 修改了read-row="never"后,丢失部分字段2.5 ...

- 通过phoenix在hbase上创建二级索引,Secondary Indexing

环境描述: 操作系统版本:CentOS release 6.5 (Final) 内核版本:2.6.32-431.el6.x86_64 phoenix版本:phoenix-4.10.0 hbase版本: ...

- CDH版本Hbase二级索引方案Solr key value index

概述 在Hbase中,表的RowKey 按照字典排序, Region按照RowKey设置split point进行shard,通过这种方式实现的全局.分布式索引. 成为了其成功的最大的砝码. 然而单一 ...

- HBase Region级别二级索引

我们会经常谈及二级索引,这是对全表数据进行另外一种方式的组织存储,是针对table级别的.如果要为HBase上的表实现一个强一致性的二级索引,那么就无法逃避分布式事务,而这一直是用户最期待的功能. 而 ...

- hbase基于solr配置二级索引

一.概述 Hbase适用于大表的存储,通过单一的RowKey查询虽然能快速查询,但是对于复杂查询,尤其分页.查询总数等,实现方案浪费计算资源,所以可以针对hbase数据创建二级索引(Hbase Sec ...

- HBase的二级索引

使用HBase存储中国好声音数据的案例,业务描述如下: 为了能高效的查询到我们需要的数据,我们在RowKey的设计上下了不少功夫,因为过滤RowKey或者根据RowKey查询数据的效率是最高的,我们的 ...

随机推荐

- 【Luogu】P1155双栈排序(二分图)

题目链接在此 此题一开始写了个深搜,过了30%的数据,也就是n<=10的那一段.... 然后看了题解发现这是个二分图的判断. 我们先举例子找到不能放进一个栈里的规律.设有数列[2,3,1,4] ...

- HDU 3001 Travelling ——状压DP

[题目分析] 赤裸裸的状压DP. 每个点可以经过两次,问经过所有点的最短路径. 然后写了一发四进制(真是好写) 然后就MLE了. 懒得写hash了. 改成三进制,顺利A掉,时间垫底. [代码] #in ...

- POJ 2888 Magic Bracelet ——Burnside引理

[题目分析] 同样是Burnside引理.但是有几种颜色是不能放在一起的. 所以DP就好了. 然后T掉 所以矩阵乘法就好了. 然后T掉 所以取模取的少一些,矩阵乘法里的取模尤其要注意,就可以了. A掉 ...

- BZOJ3130 [Sdoi2013]费用流 【网络流 + 二分】

题目 Alice和Bob在图论课程上学习了最大流和最小费用最大流的相关知识. 最大流问题:给定一张有向图表示运输网络,一个源点S和一个汇点T,每条边都有最大流量.一个合法的网络流方案必须满足:(1)每 ...

- 【loj6029】「雅礼集训 2017 Day1」市场

题目 题意:四种操作,区间加法.区间除法(下取整).区间求最小值.区间求和. 第1.3.4个操作都是摆设,关键在于如何做区间除法. 很明显不能直接把区间的和做除法后向下取整,因为区间和可能会多凑出一个 ...

- charts 画饼图

统计某一天某类物体的百分比 新知识点:aggregate https://blog.csdn.net/congcong68/article/details/51619882 主要的 $group $m ...

- Mato的文件管理(bzoj 3289)

Description Mato同学从各路神犇以各种方式(你们懂的)收集了许多资料,这些资料一共有n份,每份有一个大小和一个编号.为了防止他人偷拷,这些资料都是加密过的,只能用Mato自己写的程序才能 ...

- 洛谷试炼场 提高模板-nlogn数据结构

树状数组-区间求和 P3374 [模板]树状数组 1 /*by SilverN*/ #include<algorithm> #include<iostream> #includ ...

- 【HDOJ5978】To begin or not to begin(概率)

题意:有k个黑球和1个红球,两个轮流抽,抽到红球算赢,问先手赢的概率大还是后手大还是相等 k<=1e5 思路:手算前几项概率 大胆猜想 #include<cstdio> #inclu ...

- linux内核中预留4M以上大内存的方法

在内核中, kmalloc能够分配的最大连续内存为2的(MAX_ORDER-1)次方个page(参见alloc_pages函数, "if (unlikely(order >= ...