池化层 Pooling Layer

写在前面:人生就是努力、搞不懂、躺平,循环。

文章结构

- 池化层的相对位置

- 在多通道任务中,池化层和卷积层的不同

- 重要的参数stride 与 kernel_size 大小的相对关系决定3种池化层

- 参数

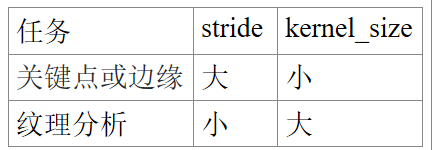

- 针对不同的任务,使用不同的 stride 和 kernel_size。

- kernel_size是否越大越好?

- 常用的池化层/结构(名称、优点、适用于、pytorch 函数)

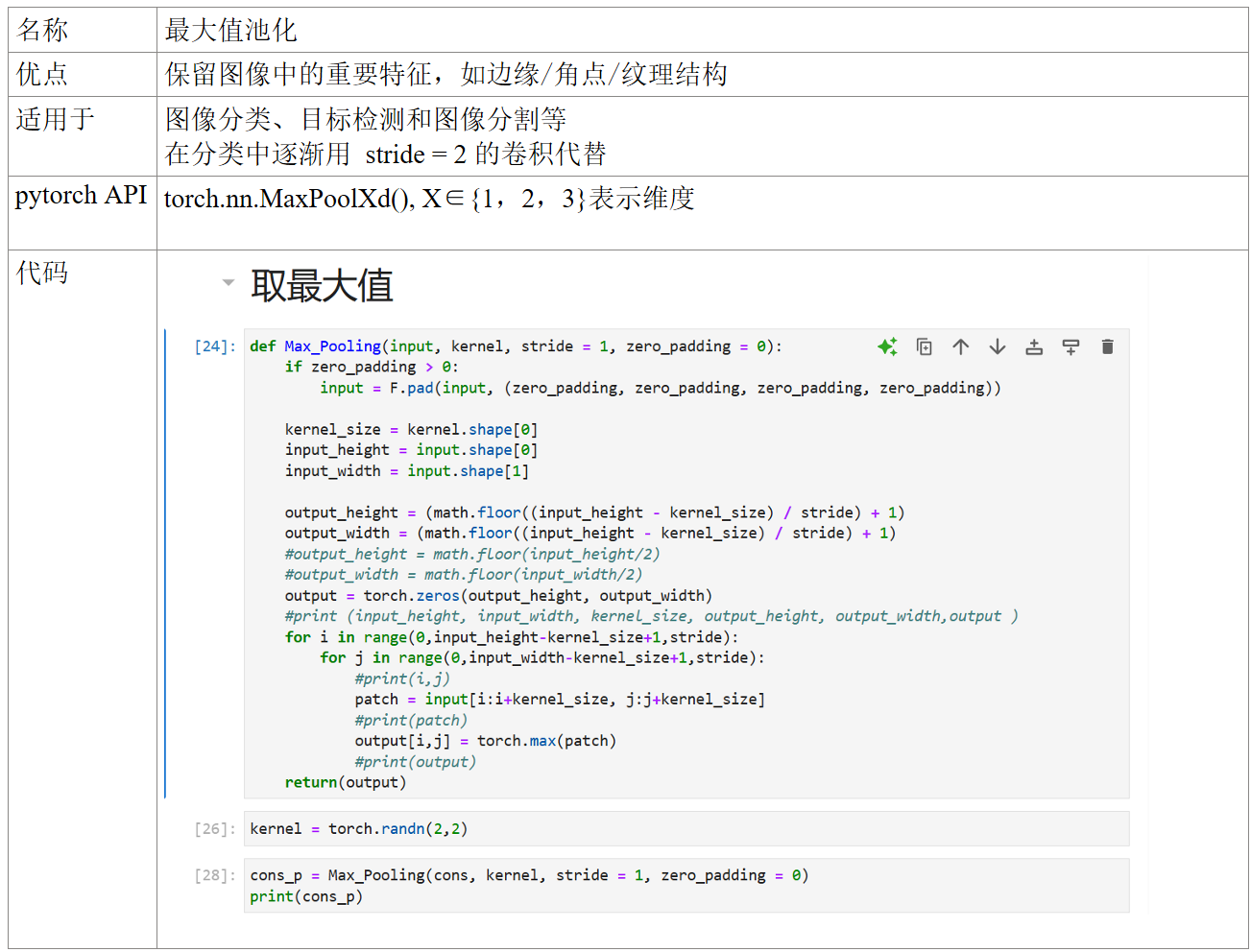

- 最大值池化

- 平均值池化

- 组合池化

- 自适应最大值/均值池化

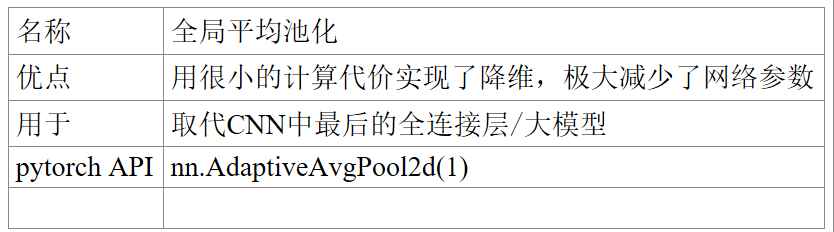

- 全局平均池化

- 随即池化

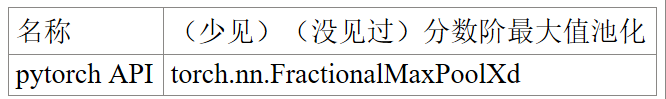

- 分数阶最大池化

- 幂均值池化/LP池化

- Detail-Preserving Pooling

- Local Importance Pooling

- 软池化

- 双线性池化

- 反池化反卷积/转置卷积

- 适用于

- pytorch函数

如果存在错误,欢迎指正,共同学习。

部分图片与公式来源网络。博客起初是我的个人学习笔记,如有侵权,请联系我添加来源或进行删除。

池化层的相对位置

Convolutional Layer → ReLU → Pooling Layer

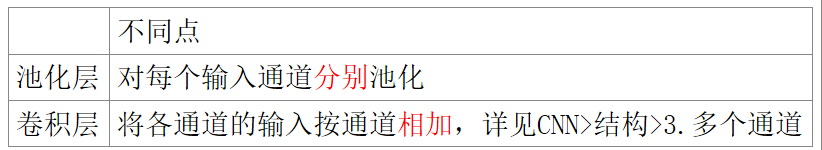

在多通道任务中,池化层和卷积层的不同

重要参数

- 参数

- 步长 stride

- 填充值 zero_padding

- 卷积核kernel及其大小size,深度/个数depth

- 针对不同的任务,使用不同的 stride 和 kernel_size。

- kernel_size是否越大越好?

stride 与 kernel_size 大小的相对关系决定3种池化层。

常用的池化层/结构(名称、优点、适用于、pytorch 函数)

组合池化 组合最大值池化和均值池化,常见 Cat与Add 当做分类任务的一个trick,其作用就是丰富特征层,maxpool更关注重要的局部特征,而average pooling更关注全局特征。

随机池化/随机位置池化 将方格中的元素同时除以它们的和sum,得到概率矩阵

Detail-Preserving Pooling 保存网络的精度 放大空间变化并保留重要的图像结构细节,且其内部的参数可通过反向传播加以学习

Local Importance Pooling

反池化

- 适用于:扩大特征图的尺寸,它通过学习滤波器和步长来逆转池化过程中的降维过程。

- pytorch 函数: torch.nn.MaxUnpool2d

反卷积/转置卷积 计算步骤

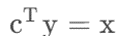

按卷积核个数depth,写成一个depth行input_size*input_size列大小的矩阵 C,将现有的结果y,根据公式

计算得 输入 input/x

池化层 Pooling Layer的更多相关文章

- 图像处理池化层pooling和卷积核

1.池化层的作用 在卷积神经网络中,卷积层之间往往会加上一个池化层.池化层可以非常有效地缩小参数矩阵的尺寸,从而减少最后全连层中的参数数量.使用池化层即可以加快计算速度也有防止过拟合的作用. 2.为什 ...

- 神经网络中的池化层(pooling)

在卷积神经网络中,我们经常会碰到池化操作,而池化层往往在卷积层后面,通过池化来降低卷积层输出的特征向量,同时改善结果(不易出现过拟合).为什么可以通过降低维度呢? 因为图像具有一种“静态性”的属性,这 ...

- 池化层pooling

from mxnet import autograd,nd from mxnet import gluon,init from mxnet.gluon import nn,loss as gloss ...

- CNN之池化层tf.nn.max_pool | tf.nn.avg_pool | tf.reduce_mean | padding的规则解释

摘要:池化层的主要目的是降维,通过滤波器映射区域内取最大值.平均值等操作. 均值池化:tf.nn.avg_pool(input,ksize,strides,padding) 最大池化:tf.nn.ma ...

- 深入解析CNN pooling 池化层原理及其作用

原文地址:https://blog.csdn.net/CVSvsvsvsvs/article/details/90477062 池化层作用机理我们以最简单的最常用的max pooling最大池化层为例 ...

- tensorflow 1.0 学习:池化层(pooling)和全连接层(dense)

池化层定义在 tensorflow/python/layers/pooling.py. 有最大值池化和均值池化. 1.tf.layers.max_pooling2d max_pooling2d( in ...

- 【37】池化层讲解(Pooling layers)

池化层(Pooling layers) 除了卷积层,卷积网络也经常使用池化层来缩减模型的大小,提高计算速度,同时提高所提取特征的鲁棒性,我们来看一下. 先举一个池化层的例子,然后我们再讨论池化层的 ...

- ubuntu之路——day17.3 简单的CNN和CNN的常用结构池化层

来看上图的简单CNN: 从39x39x3的原始图像 不填充且步长为1的情况下经过3x3的10个filter卷积后 得到了 37x37x10的数据 不填充且步长为2的情况下经过5x5的20个filter ...

- 【python实现卷积神经网络】池化层实现

代码来源:https://github.com/eriklindernoren/ML-From-Scratch 卷积神经网络中卷积层Conv2D(带stride.padding)的具体实现:https ...

- [PyTorch 学习笔记] 3.3 池化层、线性层和激活函数层

本章代码:https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson3/nn_layers_others.py 这篇文章主要介绍 ...

随机推荐

- 输出满足1+2+3+…+*n*<8888的最大整数

输出满足1+2+3+-+n<8888的最大整数 编写应用程序,输出满足1+2+3+-+n<8888的最大整数 输出格式:满足条件的最大整数:xxxxx public class Demo0 ...

- MySQL 中information_schema、mysql、performance_schema、sys 简介

一.information_schema简介在MySQL中,把 information_schema 看作是一个数据库,确切说是信息数据库.其中保存着关于MySQL服务器所维护的所有其他数据库的信息. ...

- Java虚拟机调优-典型配置举例

背景: 以下配置主要针对分代垃圾回收算法而言. 堆大小设置 年轻代的设置很关键 JVM中最大堆大小有三方面限制:相关操作系统的数据模型(32-bt还是64-bit)限制:系统的可用虚拟内存限制:系统的 ...

- Java API 之集合

1. 包装类 (基本类型中没有多少我们能够使用的方法和属性,为了便捷我们需要自己去写) 针对每一种基本类型提供了对应的类的形式 --- 包装类 byte short int long float ...

- 接口的应用:代理模式(Proxy)

应用场景: 安全代理:屏蔽对真实角色的直接访问. 远程代理:通过代理类处理远程方法调用(RMI) 延迟加载:先加载轻量级的代理对象,真正需要再加载真实对象比如你要开发一个大文档查看软件,大文档中 ...

- .NET Core GC压缩(compact_phase)底层原理浅谈

简介 终于来到了GC的最后一个步骤,在此之间,大量预备工作已经完成.万事俱备,只欠东风 清除 如果GC决定不压缩,它将仅执行清除操作.清除操作非常简单,把所有不可到达对象(gap),转换成Free.也 ...

- CPU的指令周期

本文分享自天翼云开发者社区<CPU的指令周期>,作者:冯****怡 指令周期(Instruction Cycle) CPU中会有 存器.指令寄存器.控制器等多类单元.指令集,就是CPU中用 ...

- Q:查看服务器内存和cpu占用排名

pid 表示进程 ID,cmd 表示进程命令行,%mem 表示进程占用内存百分比,%cpu 表示进程占用 CPU 百分比,--sort=-%mem 表示按照内存占用率从高到低排序. 1.内存占比排序 ...

- Mac使用docker安装Doris

一.编译源码 (1)拉取编译镜像docker pull apache/incubator-doris:build-env-1.2 (2)Mac电脑上拉取源码git clone https://gith ...

- HT-018 Div3 构造 题解 [ 黄 ] [ 数学 ] [ 结论 ]

构造:结论题,gcy数竞大佬tql%%%orz. 结论 先放结论:如果 \(x \bmod 4=2\) ,那么 \(x\) 无法被表示为 \(a^2-b^2\) 的形式:除此之外的其他数都可以. 证明 ...