Spark 倾斜连接

- 业务数据本身的特性

- Key分布不均匀

- 建表时考虑不周

- 某些SQL语句本身就有数据倾斜

【数据倾斜的解决方案】

------

------ ------

------

【SPARK 代码】

package spark

import org.apache.spark.{SparkContext, SparkConf}

/**

* Created by Liu Jinhong on 2016/5/27.

*/

object TiltJoin {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("TiltJoin").setMaster("local")

val sc = new SparkContext(conf)

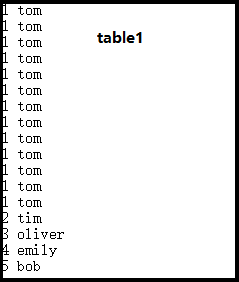

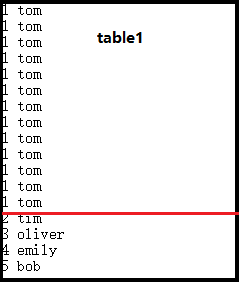

val line1 = sc.textFile("E:\\testdoc\\a.txt")

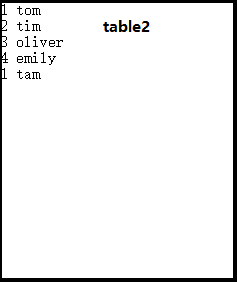

val line2 = sc.textFile("E:\\testdoc\\b.txt")

val table1 = line1.map(_.split(' ')).map(x => (x(0), x(1)))

val table2 = line2.map(_.split(' ')).map(x => (x(0), x(1)))

//对table1进行采样

val sample = table1.sample(false, 0.3, 9).map(x => (x._1, 1)).reduceByKey(_+_)

//找到table1中的倾斜数据

val maxrowKey = sample.map(x => (x._2, x._1)).sortByKey(false).take(1).toSeq(0)._2

//把table1拆分成两个表

val maxrowTable = table1.filter(_._1 == maxrowKey)

val maintable = table1.filter(_._1 != maxrowKey)

val result = sc.union(maxrowTable.join(table2), maintable.join(table2)).foreach(println(_))

}

}

【涉及到的函数】

val maxrowKey = sample.map(x => (x._2, x._1)).sortByKey(false).take(1).toSeq(0)._2

上诉代码相当于实现了按照value降序排序。

Spark 倾斜连接的更多相关文章

- Spark Streaming连接TCP Socket

1.Spark Streaming是什么 Spark Streaming是在Spark上建立的可扩展的高吞吐量实时处理流数据的框架,数据可以是来自多种不同的源,例如kafka,Flume,Twitte ...

- 【spark】连接Hbase

0.我们有这样一个表,表名为Student 1.在Hbase中创建一个表 表明为student,列族为info 2.插入数据 我们这里采用put来插入数据 格式如下 put ‘表命’,‘行键’, ...

- Spark Streaming连接Kafka的两种方式 direct 跟receiver 方式接收数据的区别

Receiver是使用Kafka的高层次Consumer API来实现的. Receiver从Kafka中获取的数据都是存储在Spark Executor的内存中的,然后Spark Streaming ...

- Spark join连接

内链接

- Spark SQL 官方文档-中文翻译

Spark SQL 官方文档-中文翻译 Spark版本:Spark 1.5.2 转载请注明出处:http://www.cnblogs.com/BYRans/ 1 概述(Overview) 2 Data ...

- 《Spark大数据处理:技术、应用与性能优化 》

基本信息 作者: 高彦杰 丛书名:大数据技术丛书 出版社:机械工业出版社 ISBN:9787111483861 上架时间:2014-11-5 出版日期:2014 年11月 开本:16开 页码:255 ...

- 《Spark大数据处理:技术、应用与性能优化》【PDF】 下载

内容简介 <Spark大数据处理:技术.应用与性能优化>根据最新技术版本,系统.全面.详细讲解Spark的各项功能使用.原理机制.技术细节.应用方法.性能优化,以及BDAS生态系统的相关技 ...

- 《Spark大数据处理:技术、应用与性能优化》【PDF】

内容简介 <Spark大数据处理:技术.应用与性能优化>根据最新技术版本,系统.全面.详细讲解Spark的各项功能使用.原理机制.技术细节.应用方法.性能优化,以及BDAS生态系统的相关技 ...

- Spark记录-SparkSql官方文档中文翻译(部分转载)

1 概述(Overview) Spark SQL是Spark的一个组件,用于结构化数据的计算.Spark SQL提供了一个称为DataFrames的编程抽象,DataFrames可以充当分布式SQL查 ...

随机推荐

- [MFC美化] USkin使用详解-使用方法

该种皮肤库资料很少,用法与前面几种类似. 它主要有:USkin.dll ,USkin.lib,USkin.h和Sakura.msstyles这四个文件.皮肤格式是.u3.SkinBuilder是USk ...

- CreateMutex()参数报错问题

举例: hMutex = CreateMutex(NULL, FALSE,"screen"); 报错 error C2664:"CreateMutexW": 不 ...

- MVC 之下载 我的实践

Controller 1. public ActionResult DownLoad(string path,string fileName) { return File(new FileStream ...

- Java Calendar日历类的使用

Calendar cal = Calendar.getInstance(); // 当前年 int year = cal.get(Calendar.YEAR); // 当前月 int month = ...

- android studio 导入外部库文件,以及将项目中module变成library引用依赖

一:导入如百度地图等的外部类. 步骤:1.首先 将androidstudio项目显示切换到 project 状态显示项目 2.然后添加.jar文件,将所有的.jar文件放入libs文件夹内(libs文 ...

- angular2+webpack的搭建过程遇到的问题记录

最近在由于公司的项目要重构,Superiors要求将原先的Ionic1+angular1+gulp用全新的Ionic2+angular2+webpack重构.苦逼的Google了好久,环境搭建还是不太 ...

- java自带的监控工具VisualVM一

转自:http://www.cnblogs.com/wade-xu/p/4369094.html 这篇总结的很不错(本人亲自操手学习),留着以后复习备用,很适合入门级的学习者: VisualVM 是一 ...

- c++设计模式-----抽象工厂模式

抽象工厂模式 要创建一组相关或者相互依赖的对象 作用:提供一个创建一系列相关或相互依赖对象的接口,而无需指定它们具体的类. UML类图 抽象基类: 1)AbstractProductA.Abstrac ...

- could not resolve property问题(ssh框架)

could not resolve property不能解析属性问题, 刚开始把hql语句中的"from User user where user.user_name = '"+u ...

- Ubuntu 12.04 修改键盘映射

背景: (1) 我的笔记本G450上,Page_up/Page_down键分别和Home/End在同一个键位上,需要同时按住Fn键才能敲出Home/End (2) 习惯用Vim的同志都有这个感觉,Es ...