Java url爬虫

java 爬虫抓取

可以在线编辑java代码的连接http://www.runoob.com

import java.util.Scanner;

import java.util.ArrayList;

import java.net.*;

public class Spider {

public static void main(String[] args) {

String url = "http://www.runoob.com";

craweler(url);

} public static void craweler(String startingURL) {

int Max_item = 10000; // 爬虫抓取最大条目数

ArrayList<String> listOfPendingURLs=new ArrayList<>();

ArrayList<String> listOfTraversedURLs=new ArrayList<>();

//将起始的URL添加到listOfPendingURLs,然后通过一个while循环重复处理listOfPendingURLs中每一个URL

listOfPendingURLs.add(startingURL);

while(!listOfPendingURLs.isEmpty()&&listOfTraversedURLs.size()<=Max_item) {

//将列表中第一个RUL去除,如果该RUL没有被处理过则对其进行处理

String urlString=listOfPendingURLs.remove(0);

if(!listOfTraversedURLs.contains(urlString)) {

listOfTraversedURLs.add(urlString);

System.out.println("url:"+urlString);

//程序使用foreach循环,将页面中的每个不存在listOfTraversedURLs中的URL添加到listOfPendingURLs中

for(String s:getSubURLs(urlString)) {

if(!listOfTraversedURLs.contains(s))

listOfPendingURLs.add(s);

} }

}

} public static ArrayList<String> getSubURLs(String urlString) {

//该方法为每个给定的URL返回一个URL列表

ArrayList<String> list=new ArrayList<>();

try {

int current=0;

URL url=new URL(urlString);

Scanner input=new Scanner(url.openStream());

while(input.hasNext()) {

String line=input.nextLine();//从Web读取每一行

current=line.indexOf("http:",current);//寻找该行中的URL

while(current>0) {

int endIndex=line.indexOf("\"",current);//假设URL以引号"结束

if(endIndex>0) {

list.add(line.substring(current,endIndex));//一行中可能包含多个URL,

current=line.indexOf("http:",endIndex);//方法继续寻找下一个URL

}

else current=-1;//如果该行中没有发现URL,curr设为-1

}

}

}

catch (Exception ex) {

System.out.println("抓取异常: "+ex.getMessage());

}

return list; //页面中包含的URL以一个列表的形式返回

}

}

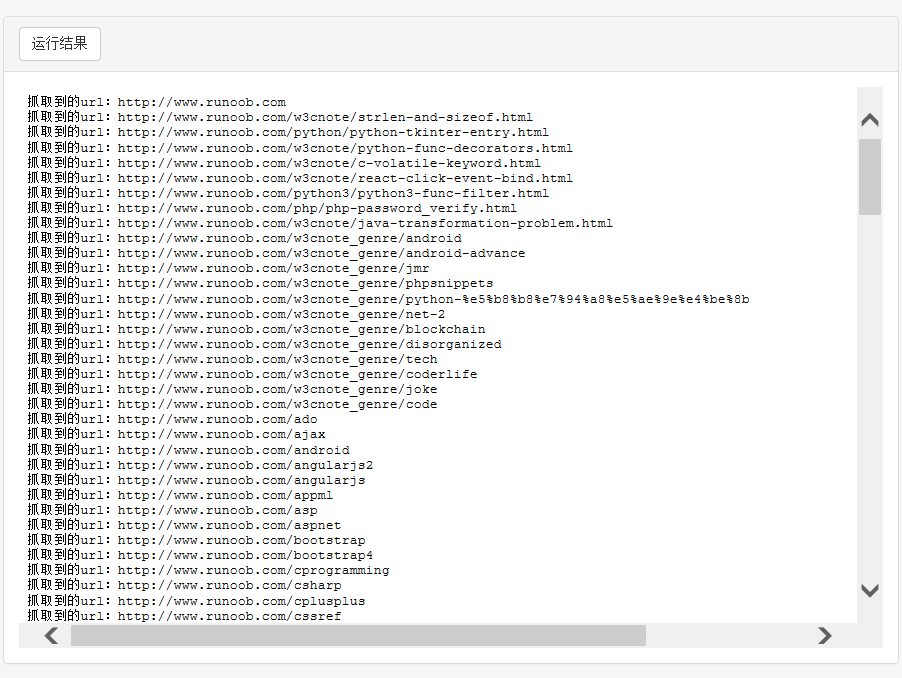

抓取效果:

可以对抓取到的url进行提取。

Java url爬虫的更多相关文章

- Java 网络爬虫获取网页源代码原理及实现

Java 网络爬虫获取网页源代码原理及实现 1.网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成.传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL ...

- 开源的49款Java 网络爬虫软件

参考地址 搜索引擎 Nutch Nutch 是一个开源Java 实现的搜索引擎.它提供了我们运行自己的搜索引擎所需的全部工具.包括全文搜索和Web爬虫. Nutch的创始人是Doug Cutting, ...

- java正则表达式之java小爬虫

这个java小爬虫, 功能很简单,只有一个,抓取网上的邮箱.用到了javaI/O,正则表达式. public static void main(String[] args) throws IOExce ...

- 【转】44款Java 网络爬虫开源软件

原帖地址 http://www.oschina.net/project/lang/19?tag=64&sort=time 极简网络爬虫组件 WebFetch WebFetch 是无依赖极简网页 ...

- java网络爬虫基础学习(三)

尝试直接请求URL获取资源 豆瓣电影 https://movie.douban.com/explore#!type=movie&tag=%E7%83%AD%E9%97%A8&sort= ...

- java网络爬虫基础学习(一)

刚开始接触java爬虫,在这里是搜索网上做一些理论知识的总结 主要参考文章:gitchat 的java 网络爬虫基础入门,好像要付费,也不贵,感觉内容对新手很友好. 一.爬虫介绍 网络爬虫是一个自动提 ...

- Java 图片爬虫,java打包jar文件

目录 1. Java 图片爬虫,制作 .jar 文件 spider.java 制作 jar 文件 添加执行权限 1. Java 图片爬虫,制作 .jar 文件 spider.java spider.j ...

- java开发爬虫Deno

java开发爬虫Deno 身为一个程序员不会两三手爬虫怎么能在行业里立足啊,这是开发中自己写的一个java爬虫的Demo,供大家参考. java爬虫的开发依赖于jsoup.jar 直接上代码 publ ...

- Java基础-爬虫实战之爬去校花网网站内容

Java基础-爬虫实战之爬去校花网网站内容 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 爬虫这个实现点我压根就没有把它当做重点,也没打算做网络爬虫工程师,说起爬虫我更喜欢用Pyt ...

随机推荐

- 『MySQL』时间戳转换

1 NOW() //当前时间 2 SYSDATE() //当前时间 3 CURRENT_TIMESTAMP 4 以'YYYY-MM-DD HH:MM:SS'或YYYYMMDDHHMMSS格式返回当前的 ...

- c#,Model 实体转json,字符串转json

public class JsonF { #region 字符串转json /// <summary> /// 字符串转json /// </summary> /// < ...

- C# .NET Web Api 保存Session

Global.asax中添加: public override void Init() { this.PostAuthenticateRequest += (sender, e) => Http ...

- jquery双击事件会触发单击事件

实际工作中,我们经常会遇到在同一个元素上,绑定多种事件类型,比较常见的是单击事件和一些鼠标事件,一般而言影响不大.但是如果同时绑定单击事件和双击事件呢? 其实,只要能够想明白的话,解决方案也比较简单, ...

- 20165205 2017-2018-2 《Java程序设计》实验三 敏捷开发与XP实践

20165205 2017-2018-2 <Java程序设计>实验三 敏捷开发与XP实践 实验内容 检查点1: 安装alibaba 插件,解决代码中的规范问题 首先把搭档加入到自己的项目中 ...

- jquery小效果:新浪游戏右侧导航菜单 (页面效果)

偷盗:新浪游戏右侧导航菜单 http://games.sina.com.cn 效果: 随着页面的滚动,左侧页面的内容,和右侧的导航菜单的按钮文字对应: 点击右侧的导航按钮,左侧页面滚动到相应的内容 2 ...

- 《算法》第四章部分程序 part 11

▶ 书中第四章部分程序,包括在加上自己补充的代码,二分图的判定和染色 ● 二分图 1 //+------------------------------------------------------ ...

- mysql source 命令导入不了sql!

sql文件也是正常, 为什么就是导入不了呢?? 后面才发现,可能是编码被notepad++ 修改了—— 一看发现是UTF-8 无BOM,改回UTF-8格式编码 就正常了!! 虽然看到的都是正常汉字, ...

- Unable to locate Spring NamespaceHandler for XML schema namespace [http://www.springframework.org/schema/tx]

ERROR - Context initialization failed org.springframework.beans.factory.parsing.BeanDefinitionParsin ...

- 网关协议学习:CGI、FastCGI、WSGI

网关协议学习:CGI.FastCGI.WSGI https://www.biaodianfu.com/cgi-fastcgi-wsgi.html