hadoop(hbase)副本数修改

一、需求场景

随着业务数据的快速增长,物理磁盘剩余空间告警,需要将数据备份从3份修改为1份,从而快速腾出可用磁盘容量。

二、解决方案

1. 修改hdfs的副本数

Hbase 的数据是存储在 hdfs 上的,Hbase的副本数是默认读取hdfs的配置进行副本备份的,所以需要修改hdfs上的副本数据。

2.删除重复数据

修改hdfs-site.xml的副本数,只能对以后的数据有效,不能修改已经存储的文件备份数,所以需要删除多余的数据。

3.负载均衡

可以增加新的存储节点,并且执行负载均衡策略。将数据均匀的分布到多个数据节点中,最大化的利用数据磁盘。

4.开启hbase表压缩

Hbase数据采用的列式存储,占用空间较大,指定压缩方式可以很好的减少磁盘的占用。

三、操作步骤

1.修改hdfs副本数

a) 通过CDH的web界面修改:

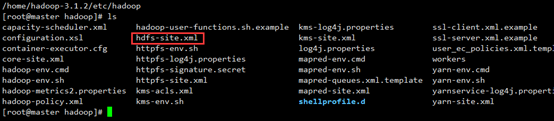

b) 通过hdfs-site.xml修改

2.删除重复数据

该问题网上有很多回答,我这里使用的强制修改备份的方法。

|

//将HDFS上的数据仅保留一份备份 hadoop fs -setrep -R 1 / // HDFS会为每一个用户创建一个回收站目录:/user/用户名/.Trash/,每一个被用户通过Shell删除的文件/目录,在系统回收站中都一个周期,也就是当系统回收站中的文件/目录在一段时间之后没有被用户回复的话,HDFS就会自动的把这个文件/目录彻底删除,之后,用户就永远也找不回这个文件/目录了。如果磁盘占用依旧很大,需要去回收厂手动删除。 |

3.负载均衡

修改存储节点后,使用hdfs用户shell命令执行:hdfs balancer

4.对现有表修改压缩方式

|

disable 'testcompression' //首先将表下线 alter 'testcompression', NAME => 'f1', COMPRESSION => 'SNAPPY' //修改表属性,指定压缩方式为SNAPPY enable 'testcompression' //启用表 desc 'testcompression' //验证是否已启用压缩放肆 major_compact 'testcompression' //执行大合并 |

四、查看结果

hadoop(hbase)副本数修改的更多相关文章

- elastic操作-索引重命名,索引副本数修改

目前我们使用的elastic版本为2.3.5 当前版本没有直接的curl操作可以更改索引的名称,索引的副本数. 有直接更改索引副本数的api. curl -XPUT "192.168.1.1 ...

- 【大数据系列】使用api修改hadoop的副本数和块大小

package com.slp.hdfs; import org.apache.commons.io.output.ByteArrayOutputStream; import org.apache.h ...

- kafka修改topic副本数

工作案例: 大数据开发用系统脚本自动在kafka建topic,检查后才发现副本数只有1个,存在数据丢失的风险.需要立刻把副本数改为3个. 开始干活,首先想到的是下面的命令: ${BIN_PATH}/k ...

- HDFS 修改默认副本数

描述:将HDFS副本数修改为2第一步:将HDFS上已有文件副本数修改为2 hdfs dfs -setrep 2 -R -w / 第二步:修改dfs.replication值为2(页面上操作),然后重启 ...

- hadoop修改MR的提交的代码程序的副本数

hadoop修改MR的提交的代码程序的副本数 Under-Replicated Blocks的数量很多,有7万多个.hadoop fsck -blocks 检查发现有很多replica missing ...

- Hadoop副本数配置

一个文件,上传到hdfs上时指定的是几个副本就是几个.修改了副本数(dfs.replications),对已经上传了的文件也不会起作用.当然可以在上传文件的同时指定创建的副本数hadoop dfs - ...

- kafka关于修改副本数和分区的数的案例实战(也可用作leader节点均衡案例)

kafka关于修改副本数和分区的数的案例实战(也可用作leader节点均衡案例) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.关于topic分区数的修改 1>.创建1分 ...

- 修改hadoop/hbase/spark的pid文件位置

1.说明 当不修改PID文件位置时,系统默认会把PID文件生成到/tmp目录下,但是/tmp目录在一段时间后会被删除,所以以后当我们停止HADOOP/HBASE/SPARK时,会发现无法停止相应的进程 ...

- 一个大数据方案:基于Nutch+Hadoop+Hbase+ElasticSearch的网络爬虫及搜索引擎

网络爬虫架构在Nutch+Hadoop之上,是一个典型的分布式离线批量处理架构,有非常优异的吞吐量和抓取性能并提供了大量的配置定制选项.由于网络爬虫只负责网络资源的抓取,所以,需要一个分布式搜索引擎, ...

随机推荐

- RedHat 的 crontab

Chapter 39. Automated Tasks In Linux, tasks can be configured to run automatically within a specifie ...

- Linux操作系统进入单用户模式的方法

单用户模式的作用 在使用Linux的过程中,维护人员经常会碰到一些问题,就是在拥有root账号权限和密码的用户中,总是会出现忘记root密码的情况. 遇到这种情况,一般情况下,维护人员就会通过最常用的 ...

- 搭建Springboot+mybatis+redis+druid

2019独角兽企业重金招聘Python工程师标准>>> 准备工作 JDK:1.8 使用技术:SpringBoot.Dubbo.Mybatis.Druid 开发工具:Intelj ID ...

- 如何在Vue项目中优雅的使用sass

开始之前,请先确保有一个基于webpack模板的项目(vue-cli脚手架一键安装~) 1.打开项目终端,安装sass的依赖包 npm install --save-dev sass-loader / ...

- ELSE 技术周刊(2017.12.25期)

业界动态 V8 release v6.4 V8引擎发布v6.4,在速度和内存优化上又带来了一些提升.对于instanceof操作符的优化,带来了3.6x速度提升,同时使得uglify-js提高了15- ...

- #Week7 Neural Networks : Learning

一.Cost Function and Backpropagation 神经网络的损失函数: \[J(\Theta) = - \frac{1}{m} \sum_{i=1}^m \sum_{k=1}^K ...

- 一张图告诉你UML图怎么画❀

UML 能帮我们做什么? 我们在进行项目的时候,通过使用 UML 的面向对象图的方式来更明确.清晰的表达项目中的架设思想.项目结构.执行顺序等一些逻辑思维. UML 介绍: 1997年,OMG 组织( ...

- VUE生命周期中的钩子函数及父子组件的执行顺序

先附一张官网上的vue实例的生命周期图,每个Vue实例在被创建的时候都需要经过一系列的初始化过程,例如需要设置数据监听,编译模板,将实例挂载到DOM并在数据变化时更新DOM等.同时在这个过程中也会运行 ...

- shell之路 Linux核心命令【第一篇】管道符与重定向

输出重定向 命令输出重定向的语法为: command > file 或 command >> file 这样,输出到显示器的内容就可以被重定向到文件.果不希望文件内容被覆盖,可以使用 ...

- Linux查看redis占用内存的方法

redis-cli auth 密码info # Memory used_memory:13490096 //数据占用了多少内存(字节) used_memory_human:12.87M //数据占用了 ...