Python爬虫:BeautifulSoup用法总结

BeautifulSoup是一个解析HTML或XML文件的第三方库。HTML或XML文件可以用DOM模型解释。一般包含三种节点:

- 元素节点 - 通常指HTML 或 XML的标签

- 文本节点 - 标签内部的文本内容

- 属性节点 - 每个标签的属性

BeautifulSoup库可以对HTML或XML文件解析,查找到一个或多个标签元素,并获取每个标签里的文本和属性。

BeautifulSoup很好的特性是它接受一个str或byte对象后会对编码自动检测,并对当前文档编码并转换成Unicode编码。这样可以不用担心乱码问题。

安装: pip install beautifulsoup4

使用: from bs4 import BeautifulSoup

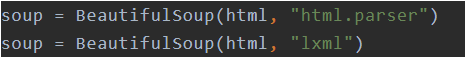

推荐安装: pip install lxml, 比 python自带的解析库html.parser更快

BeautifulSoup库的使用方法:

对一个元素的查找主要有3种方法:

- 根据标签名直接查找:soup.title, soup.p .仅适用于查找单个元素

- 使用find 和 find_all 方法 - 根据标签名和属性对文档遍历查找提取一个或多个元素

- 使用select方法 - 根据css 样式选择器对文档进行遍历提取一个或多个元素

# 根据tag直接获取元素

soup.p #获取p标签元素对象,只获取第一个

soup.p.name #获取p标签的名字,即'p"

soup.p.string # 获取p标签元素内的文本

soup.p['class'] #获取p标签元素的class属性

soup.p.get('class') #等同于上述案例

soup.a['href'] #获取第一个a元素的href属性 # find_all方法。find方法类似,仅用于提取首个匹配元素

# find_all( name , attrs , recursive , text , **kwargs )

# name :要查找的标签名(字符串、正则、方法、True)

# attrs: 标签的属性

# recursive: 递归

# text: 查找文本

# **kwargs :其它 键值参数

# 因class是关键字,所以要写成class_="value", 等同于attrs={"class":"value"}

soup.find_all('p') # 以列表形式返回所有p标签

soup.find_all('p', attrs={"class":"sister"}) # 以列表形式返回所有class属性==sister的p标签

soup.find_all('p', class_="sister") # 以列表形式返回所有class属性==sister的p标签

soup.find_all(id='link2') # 返回所有id属性==link2的标签

soup.find_all(re.compile("^b")) # 使用正则查找标签以b开头的元素

soup.find_all(href=re.compile("elsie")) # 使用正则, 返回所有href属性包含elsie的标签

soup.find_all(id="link1", href=re.compile('elsie')) # id=link1且href包含elsie的标签 # select方法 - css选择器

# 注意select方法提取的元素均是列表形式,获取文本时注意加index

soup.select('p') # 根据标签名查找所有p元素,等于soup.find_all('p')

soup.select('.sister') # 通过css属性查找class=sister的标签

soup.select('#link1') # 通过id查找所有id=#link1的元素

soup.select('p #link1') # 组合查找id=#link11的p元素

soup.select("head > title") # 查找head标签的子元素title

soup.select('a[class="sister"]') # 查找所有属性为sister的a标签

soup.select('a[href="http://example.com/elsie"]') #查找href=xxx的a标签元素

soup.select('p')[0].get_text() # 获取首个p元素的文本

soup.select('a[href*=".com/el"]')[0].attrs['href'] #获取xxx.com的href

除了 find()和find_all()之外,还有一些常用的方法可用来搜索父子和兄弟节点:

find_parent()

find_parents()

find_next_sibling()

find_next_siblings()

find_previous_sibling()

find_previous_siblings()

find_next()

find_previous()

find_all_next()

find_all_previous()

请注意select方法和find方法有如下区别,使用时请注意:

find方法返回的是单个元素,find_all方法返回的是一个元素列表,而select方法永远返回的是元素列表。如果你使用了select方法查找到了单个元素,别忘了先加列表索引[0],然后才可以调用get_text()方法获取文本。

find方法还支持方法参数查询,比select方法更强大,如下所示:

def has_class_no_id(tag):

return tag.has_attr("class") and not tag.has_attr("id")

soup.find_all(has_class_no_id) # 支持方法参数

Python爬虫:BeautifulSoup用法总结的更多相关文章

- 【爬虫】python之BeautifulSoup用法

1.爬虫 网络爬虫是捜索引擎抓取系统的重要组成部分.爬虫的主要目的是将互联网上的网页下载到本地形成一个或联网内容的镜像备份.通过分析和过滤HTML 代码,实现对图片.文字等资源的获取. 2.pytho ...

- python爬虫---BeautifulSoup的用法

BeautifulSoup是一个灵活的网页解析库,不需要编写正则表达式即可提取有效信息. 推荐使用lxml作为解析器,因为效率更高. 在Python2.7.3之前的版本和Python3中3.2.2之前 ...

- Python爬虫--beautifulsoup 4 用法

Beautiful Soup将复杂HTML文档转换成一个复杂的树形结构, 每个节点都是Python对象,所有对象可以归纳为4种: Tag , NavigableString , BeautifulSo ...

- Python爬虫-- BeautifulSoup库

BeautifulSoup库 beautifulsoup就是一个非常强大的工具,爬虫利器.一个灵活又方便的网页解析库,处理高效,支持多种解析器.利用它就不用编写正则表达式也能方便的实现网页信息的抓取 ...

- python爬虫BeautifulSoup库class_

因为class是python的关键字,所以在写过滤的时候,应该是这样写: r = requests.get(web_url, headers=headers) # 向目标url地址发送get请求,返回 ...

- python爬虫 BeautifulSoup

简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据. Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码. Bea ...

- Python爬虫 | Beautifulsoup解析html页面

引入 大多数情况下的需求,我们都会指定去使用聚焦爬虫,也就是爬取页面中指定部分的数据值,而不是整个页面的数据.因此,在聚焦爬虫中使用数据解析.所以,我们的数据爬取的流程为: 指定url 基于reque ...

- Python 爬虫-BeautifulSoup

2017-07-26 10:10:11 Beautiful Soup可以解析html 和 xml 格式的文件. Beautiful Soup库是解析.遍历.维护“标签树”的功能库.使用Beautifu ...

- Python 爬虫 —— BeautifulSoup

from bs4 import BeautifulSoup % 首字母大写,显然这是一个类 1. BeautifulSoup 类 HTML 解析类(parser) r = requests.get(. ...

- $python爬虫系列(2)—— requests和BeautifulSoup库的基本用法

本文主要介绍python爬虫的两大利器:requests和BeautifulSoup库的基本用法. 1. 安装requests和BeautifulSoup库 可以通过3种方式安装: easy_inst ...

随机推荐

- 剑指offer62:二叉搜索树的第k个结点,二叉搜索树【左边的元素小于根,右边的元素大于根】

1 题目描述 给定一棵二叉搜索树,请找出其中的第k小的结点.例如, (5,3,7,2,4,6,8) 中,按结点数值大小顺序第三小结点的值为4. 2 思路和方法 二叉搜索树[左边的元素小于根,右边 ...

- php获取当前月的天数

<?php //php获取当前月份的所有天数 $start_day = date('Ym01', time()); $end_day = date('Ymd', strtotime(" ...

- AJAX一些注释掉的语句

var sysdept=JSON.parse(localStorage.getItem("loginSysUser")); for(var o in sysdept){ alert ...

- Spring的事件监听ApplicationListener

ApplicationListener是Spring事件机制的一部分,与抽象类ApplicationEvent类配合来完成ApplicationContext的事件机制. 如果容器中存在Applica ...

- apply,call和bind的使用及区别

1.用途 1)apply,call和bind都是 用来改变this的指向 2)apply和call会让当前函数立即执行,而bind会返回一个函数,后续需要的时候再调用执行 2.this指向问题 thi ...

- MacBook Pro 安装composer及Yii2.0

最近想看看Yii的一些东西,需要安装一下composer curl -sS https://getcomposer.org/installer | php 此操作会下载最新版本到当前的目录下 然后将下 ...

- Spring Cloud Alibaba学习笔记(2) - Nacos服务发现

1.什么是Nacos Nacos的官网对这一问题进行了详细的介绍,通俗的来说: Nacos是一个服务发现组件,同时也是一个配置服务器,它解决了两个问题: 1.服务A如何发现服务B 2.管理微服务的配置 ...

- Effective Java 读书笔记(五):Lambda和Stream

1 Lamdba优于匿名内部类 (1)DEMO1 匿名内部类:过时 Collections.sort(words, new Comparator<String>() { public in ...

- nginx代理(正向代理和反向代理)

正向代理 是一个位于客户端和原始服务器(origin server)之间的服务器,为了从原始服务器取得内容,客户端向代理发送一个请求并指定目标(原始服务器),然后代理向原始服务器转交请求并将获得的内容 ...

- JavaScript时钟效果

在JavaScript中,有一个内置对象Date,它重要的一个作用就是实现了时间的时刻更新,通过代码来创造一个实实在在的时间表. 代码例子: <!DOCTYPE html> <htm ...