hdfs校验和

hdfs完整性:用户希望储存和处理数据的时候,不会有任何损失或者损坏。所以提供了两种校验:

1.校验和(常用循环冗余校验CRC-32)。

2.运行后台进程来检测数据块。

校验和:

a.写入数据节点验证

b.读取数据节点验证

c.恢复数据

d.Localfilesystem类

e.ChecksumfileSystem类

写入数据节点验证:

Hdfs会对写入的所有数据计算校验和,并在读取数据时验证校验和。

元数据节点负责在验证收到的数据后,储存数据及其校验和。在收到客户端数据或复制其他datanode的数据时执行。

正在写数据的客户端将数据及其校验和发送到一系列数据节点组成的管线,管线的最后一个数据节点负责验证校验和。

读取数据节点验证:

客户端读取数据节点数据也会验证校验和,将它们与数据节点中储存的校验和进行比较。

每个数据节点都持久化一个用于验证的校验和日志。 客户端成功验证一个数据块后,会告诉这个数据节点,数据节点由此更新日志。

恢复数据:

由于hdfs储存着每个数据块的备份,它可以通过复制完好的数据备份来修复损坏的数据块来恢复数据。

Localfilesystem类:

Hadoop的LocalFileSystem类是用来执行客户端的校验和验证。当写入一个名为filename的文件时文件系统客户端会在包含文件块校验和的同一目录内建立一个名为Filename.crc的隐藏文件。

ChecksumfileSystem类:

LocalFileSystem类通过ChecksumFileSystem类来完成自己的任务 FileSystem rawFs;

FileSystem checksummedFs=new ChecksumFileSystem(rawFS);

可以通过CheckFileSystem的getRawFileSystem()方法获取源文件系统。

当检测到错误,CheckFileSystem类会调用reportCheckSumFailure()方法报告错误,然后LocalFileSystem将这个出错的文件和校验和移到名为bad_files的文件夹内,管理员可以定期检查这个文件夹。

DatablockScanner:

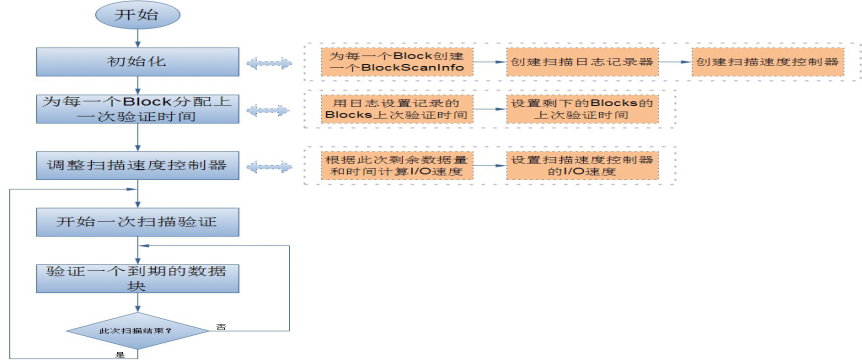

数据节点后台有一个进程DataBlockScanner,定期验证储存在这个数据节点上的所有数据项,该项措施是为解决物理储存媒介上的损坏。DataBlockScanner是作为数据节点的一个后台线程工作的,跟着数据节点同时启动 它的工作流程如图:

由于对数据节点上的每一个数据块扫描一遍要消耗较多系统资源,因此扫描周期的值一般比较大, 这就带来另一个问题,就是在一个扫描周期内可能出现数据节点重启的情况,所以为了提高系统性能,避免数据节点在启动后对还没有过期的数据块又扫描一遍, DataBlockScanner在其内部使用了日志记录器来持久化保存每一个数据块上一次扫描的时间 这样的话,数据节点可以在启动之后通过日志文件来恢复之前所有的数据块的有效时间。

hdfs校验和的更多相关文章

- Hbase学习02

第2章 Apache HBase配置 本章在“入门”一章中进行了扩展,以进一步解释Apache HBase的配置. 请仔细阅读本章,特别是基本先决条件,确保您的HBase测试和部署顺利进行,并防止数据 ...

- 何为HDFS?

该文来自百度百科,自我收藏. Hadoop分布式文件系统(HDFS)被设计成适合运行在通用硬件(commodity hardware)上的分布式文件系统.它和现有的分布式文件系统有很多共同点.但同时, ...

- HDFS DataNode 设计实现解析

前文分析了 NameNode,本文进一步解析 DataNode 的设计和实现要点. 文件存储 DataNode 正如其名是负责存储文件数据的节点.HDFS 中文件的存储方式是将文件按块(block)切 ...

- hdfs的读写数据流

hdfs的读: 首先客户端通过调用fileSystem对象中的open()函数读取他需要的的数据,fileSystem是DistributedFileSystem的一个实例, Distrib ...

- Hadoop官方文档翻译——HDFS Architecture 2.7.3

HDFS Architecture HDFS Architecture(HDFS 架构) Introduction(简介) Assumptions and Goals(假设和目标) Hardware ...

- HDFS原理介绍

HDFS(Hadoop Distributed File System )Hadoop分布式文件系统.是根据google发表的论文翻版的.论文为GFS(Google File System)Googl ...

- Hbase写入hdfs源码分析

版权声明:本文由熊训德原创文章,转载请注明出处: 文章原文链接:https://www.qcloud.com/community/article/258 来源:腾云阁 https://www.qclo ...

- HDFS文件读写过程

参考自<Hadoop权威指南> [http://www.cnblogs.com/swanspouse/p/5137308.html] HDFS读文件过程: 客户端通过调用FileSyste ...

- HDFS 原理、架构与特性介绍--转载

原文地址:http://www.uml.org.cn/sjjm/201309044.asp 本文主要讲述 HDFS原理-架构.副本机制.HDFS负载均衡.机架感知.健壮性.文件删除恢复机制 1:当前H ...

随机推荐

- VS2005打开VS2008项目的2种方法

vs2008支持.net3.5,而vs2005支持.net2.0,所以使用vs2005打开vs2008的项目,要确定你的项目是.net2.0的. 下面介绍2种方法: 方法1:用记事本打开.sln文件, ...

- win32常用代码整理

1.ShellExecute [Use ShellAPI] ShellExecute(Handle, 'open', 'http://www.cnblogs.com/lovelp/', nil, ni ...

- QTableWidget笔记

1.QTableWidget继承自QTableView. 2.头文件:QTableWidget 3.简单使用: #include "mainwindow.h" #include & ...

- 多进程小例子--fork+pipe

1 #include<stdio.h> 2 #include<unistd.h> 3 4 #define m 6 5 int main() 6 { 7 ...

- 2014年第五届蓝桥杯国赛试题(JavaA组)

1.结果填空 (满分15分)2.结果填空 (满分45分)3.代码填空 (满分30分)4.程序设计(满分30分)5.程序设计(满分80分)6.程序设计(满分100分) 1.标题:海盗分金币 有5个海盗, ...

- HDU - 5451 Best Solver(循环节+矩阵快速幂)

Best Solver The so-called best problem solver can easily solve this problem, with his/her childhood ...

- POJ1251 Jungle Roads Kruskal+scanf输入小技巧

Jungle Roads The Head Elder of the tropical island of Lagrishan has a problem. A burst of foreign ai ...

- UniqueIdentifier 数据类型

UniqueIdentifier 数据类型用于存储GUID的值,占用16Byte. SQL Server将UniqueIdentifier存储为16字节的二进制数值,Binary(16),按照特定的格 ...

- OVN学习(一)

参考文档 OVN学习系列参考博文 部署OVN实验环境 网络拓扑 ### Central节点 # cat ifcfg-ens3 TYPE=Ethernet BOOTPROTO=static DEFROU ...

- CF360E Levko and Game【贪心+dijsktra】

先把所有边可动设为r[i]又这些边不是l就是r(如果想一个方向改变能更优的话就尽量多的改变),每次跑dijsktra,对于可动边(x,y),如果dis1[x]<=dis2[x],那么就把这条边改 ...