request库

0x00 环境简介和安装

我这里使用的是python2.7版本,直接使用pycharm2018这款IDE。

首先在pycharm中配置一下virtualenv环境,virtualenv是一个创建独立Python运行环境的工具,为一个应用创建一套“隔离”的Python运行环境。

创建new project时选择创建新的环境,修改你们自己的目录,如果主机内有多个版本的python解释器可自行选择

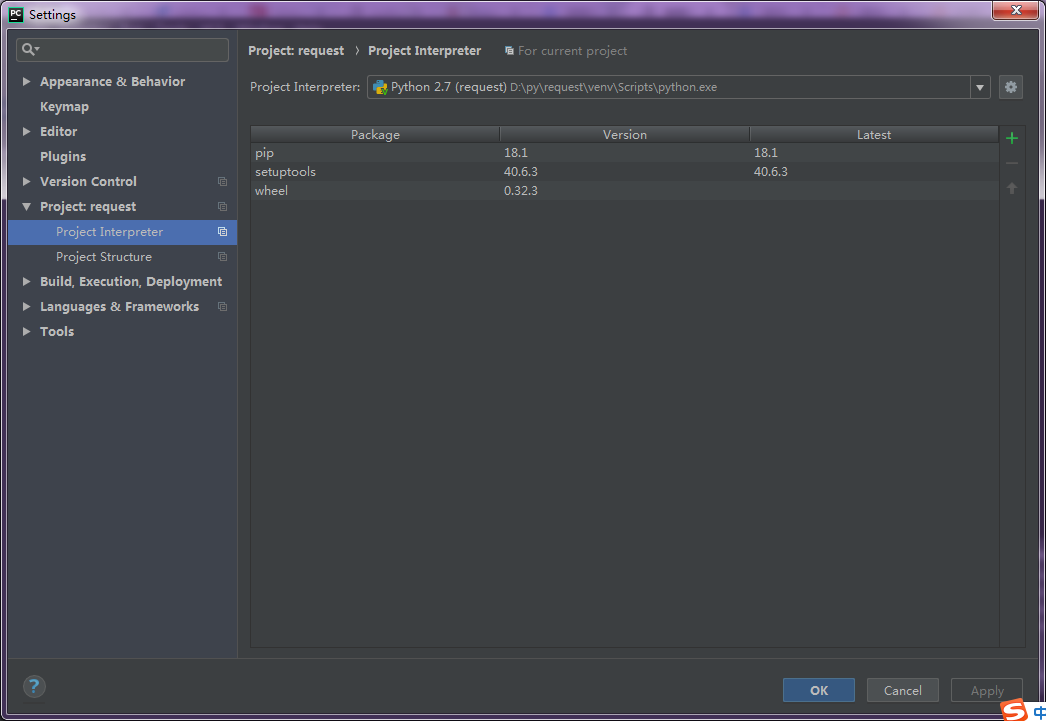

创建完成后可以在项目中安装requests库,file-settings打开如下界面

单击右上角绿色加号,搜索requests并install

这里如果你的pip版本大于等于10,安装的时候会报错,原因是由于新版pip的函数发生了变化,解决办法参考这个帖子

【Python】【亲测好用】安装第三方包报错:AttributeError:'module' object has no attribute 'main'

0x01 使用requests

请求方法

- GET: 查看资源

- POST: 增加资源

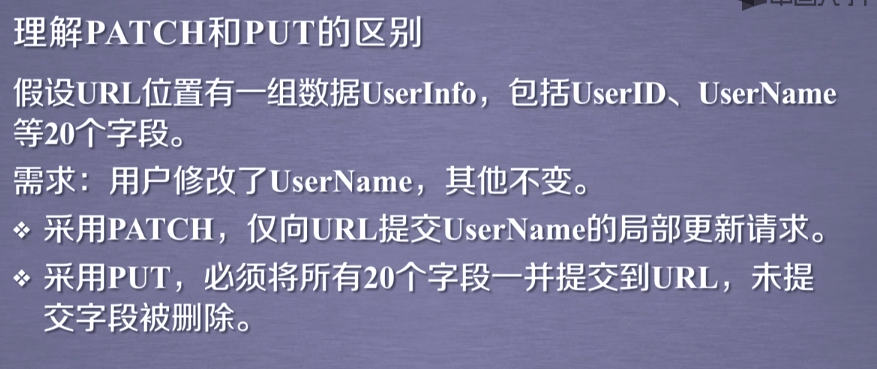

- PUT: 修改资源

- DELETE: 删除资源

- HEAD: 查看响应头

- patch: 局部更新url资源

基本用法:requests.[methon](url)

import requests

response = requests.get('https://www.cnblogs.com/Ragd0ll/p/10176258.html')

print(response.status_code) # 打印状态码

print(response.url) # 打印请求url

print(response.headers) # 打印头信息

print(response.cookies) # 打印cookie信息

print(response.text) #以文本形式打印网页源码

print(response.content) #以字节流形式打印

request的可选参数

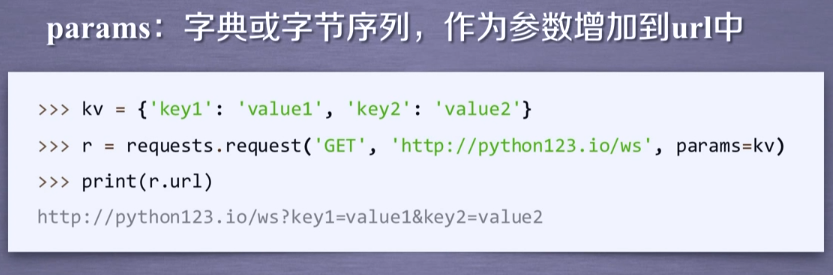

1.param

2.data

3.json

4.headers

5.cookies、auth

6.files

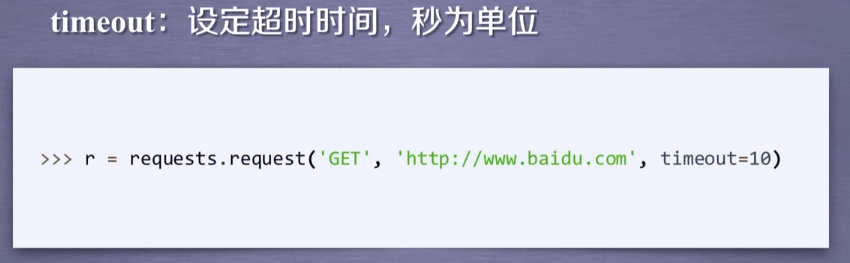

7.timeout

8.proxies

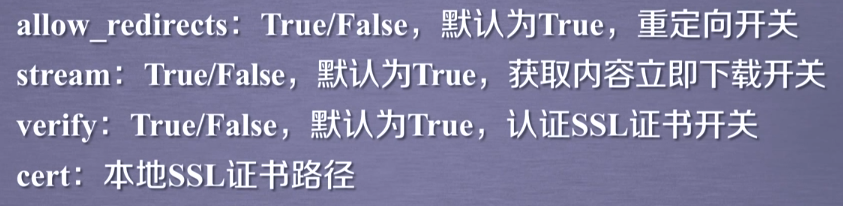

9.allow_redirects、stream、verify、cert

带参数的get请求:

第一种直接将参数放在url内

import requests response = requests.get(http://httpbin.org/get?name=gemey&age=22)

print(response.text)

第二种是将参数放入字典,然后在请求时给params参数赋值

import requests

data = {

'name': 'tom',

'age': 20

}

response = requests.get('http://httpbin.org/get', params=data)

print(response.text)

两段代码的结果相同

基本POST请求:

import requests

data = {'name':'tom','age':''}

response = requests.post('http://httpbin.org/post', data=data)

简单保存一个二进制文件

import requests

response = requests.get('https://img2018.cnblogs.com/blog/1342178/201812/1342178-20181225201042109-1353349536.png')

b = response.content

with open('F://fengjing.jpg','wb') as f:

f.write(b)

为你的请求添加头信息

import requests

heads = {}

heads['User-Agent'] = 'Mozilla/5.0 ' \

'(Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 ' \

'(KHTML, like Gecko) Version/5.1 Safari/534.50'

response = requests.get('https://home.cnblogs.com/u/Ragd0ll/',headers=headers)

获取cookie

import requests

response = requests.get('https://home.cnblogs.com/u/Ragd0ll/')

print(response.cookies)

print(type(response.cookies))

for k,v in response.cookies.items():

print(k+':'+v)

会话维持

import requests session = requests.Session()

session.get('http://httpbin.org/cookies/set/number/12345')

response = session.get('http://httpbin.org/cookies')

print(response.text)

证书验证设置

import requests

from requests.packages import urllib3 urllib3.disable_warnings() #从urllib3中消除警告

response = requests.get('https://www.12306.cn',verify=False) #证书验证设为FALSE

print(response.status_code)

超时异常捕获

import requests

from requests.exceptions import ReadTimeout try:

res = requests.get('http://httpbin.org', timeout=0.1)

print(res.status_code)

except ReadTimeout:

print(timeout)

异常处理

import requests

from requests.exceptions import ReadTimeout,HTTPError,RequestException try:

response = requests.get('http://www.baidu.com',timeout=0.5)

print(response.status_code)

except ReadTimeout:

print('timeout')

except HTTPError:

print('httperror')

except RequestException:

print('reqerror')

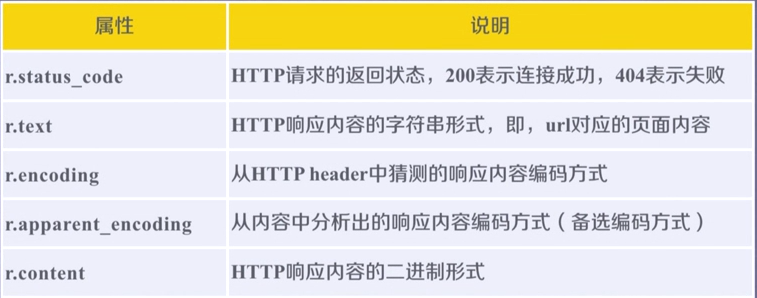

Response的方法

request库的更多相关文章

- Python3 urllib.request库的基本使用

Python3 urllib.request库的基本使用 所谓网页抓取,就是把URL地址中指定的网络资源从网络流中读取出来,保存到本地. 在Python中有很多库可以用来抓取网页,我们先学习urlli ...

- Python request库与爬虫框架

Requests库的7个主要方法 requests.request():构造一个请求,支持以下各方法的基础方法 requests.get():获取HTML网页的主要方法,对应于HTTP的GET ...

- Request库使用response.text返回乱码问题

我们日常使用Request库获取response.text,这种调用方式返回的text通常会有乱码显示: import requests res = requests.get("https: ...

- 爬虫——urllib.request库的基本使用

所谓网页抓取,就是把URL地址中指定的网络资源从网络流中读取出来,保存到本地.在Python中有很多库可以用来抓取网页,我们先学习urllib.request.(在python2.x中为urllib2 ...

- 爬虫request库规则与实例

Request库的7个主要方法: requests.request(method,url,**kwargs) method:请求方式,对应get/put/post等7种: r = reques ...

- Python网络爬虫与信息提取[request库的应用](单元一)

---恢复内容开始--- 注:学习中国大学mooc 嵩天课程 的学习笔记 request的七个主要方法 request.request() 构造一个请求用以支撑其他基本方法 request.get(u ...

- Request库的安装与使用

Request库的安装与使用 安装 pip install reqeusts Requests库的7个主要使用方法 requests.request() 构造一个请求,支撑以下各方法的基础方法 req ...

- python网络爬虫学习笔记(一)Request库

一.Requests库的基本说明 引入Rquests库的代码如下 import requests 库中支持REQUEST, GET, HEAD, POST, PUT, PATCH, DELETE共7个 ...

- Request库学习

0x00前言 这库让我爱上了python 碉堡! 开心去学了一些python,然后就来学这个时候神库~~ 资料来源:http://cn.python-requests.org/en/latest/u ...

- 爬虫入门【1】urllib.request库用法简介

urlopen方法 打开指定的URL urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, ca ...

随机推荐

- (转)为什么在 2013 十月番中出现了很多以 3D 渲染代替传统 2D 绘画来表现人物的镜头?

一直都有的,特别是三次元这家公司一直致力于3d的风格化渲染既大家说的3d转2d.目前最厉害的商业化软件是pencil+,占领大部分的作品.而mentalray,早期用于disney的部分风格化渲染:i ...

- 如何修改iframe内的页面的元素的样式。。。。

方法一: 直接通过设置backgroundColor的颜色即可:<!DOCTYPE html><html><head><script>function ...

- ARM linux中断总结

Linux异常处理体系结构 Linux异常体系之vector_stub宏解析 Linux异常体系之stubs_offset Linux中断体系结构 ARM系统调用

- 动态规划:最长上升子序列之基础(经典算法 n^2)

解题心得: 1.注意动态转移方程式,d[j]+1>d[i]>?d[i]=d[j]+1:d[i] 2.动态规划的基本思想:将大的问题化为小的,再逐步扩大得到答案,但是小问题的基本性质要和大的 ...

- Linux命令之---find

命令简介 find明林用于查找目录下的文件,同时也可以调用其他命令执行相应的操作 命令格式 find pathname -options [-print -exec -ok ...] find [选项 ...

- HTML练习题

1.查询一下对div和span标签的理解 div标签:是用来为HTML文档内大块的内容提供结构和背景的元素.DIV的起始标签和结束标签之间的所有内容都是用来构成这个块的,中文我们把它称作“层”. sp ...

- Python中str、list、numpy分片操作

在Python里,像字符串(str).列表(list).元组(tupple)和这类序列类型都支持切片操作 对对象切片,s是一个字符串,可以通过类似数组索引的方式获取字符串中的字符,同时也可以用s[a: ...

- FreeMarker的基础语法使用 && 心得和技巧

FreeMarker语言 FreeMarker语言概述 FreeMarker是一个模板引擎,一个基于模板生成文本输出的通用工具,使用纯Java编写. FreeMarker被设计用来生成HTML Web ...

- Careercup - Microsoft面试题 - 5485521224597504

2014-05-12 06:19 题目链接 原题: Given an input list of lists.. flatten the list. For e.g. {{,}, {}, {,}} . ...

- C++ STL map容器的说明测试1

// maptest.cpp : 定义控制台应用程序的入口点.// #include "stdafx.h" /*********************************** ...