Spark常用函数讲解之Action操作

RDD:弹性分布式数据集,是一种特殊集合 ‚ 支持多种来源 ‚ 有容错机制 ‚ 可以被缓存 ‚ 支持并行操作,一个RDD代表一个分区里的数据集

RDD有两种操作算子:

Ation(执行):触发Spark作业的运行,真正触发转换算子的计算

本系列主要讲解Spark中常用的函数操作:

1.RDD基本转换

2.键-值RDD转换

3.Action操作篇

def main(args: Array[String]) {

val conf = new SparkConf().setMaster("local").setAppName("reduce")

val sc = new SparkContext(conf)

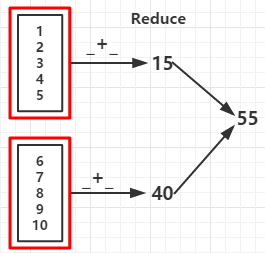

val rdd = sc.parallelize(1 to 10,2)

val reduceRDD = rdd.reduce(_ + _)

val reduceRDD1 = rdd.reduce(_ - _) //如果分区数据为1结果为 -53

val countRDD = rdd.count()

val firstRDD = rdd.first()

val takeRDD = rdd.take(5) //输出前个元素

val topRDD = rdd.top(3) //从高到底输出前三个元素

val takeOrderedRDD = rdd.takeOrdered(3) //按自然顺序从底到高输出前三个元素

println("func +: "+reduceRDD)

println("func -: "+reduceRDD1)

println("count: "+countRDD)

println("first: "+firstRDD)

println("take:")

takeRDD.foreach(x => print(x +" "))

println("\ntop:")

topRDD.foreach(x => print(x +" "))

println("\ntakeOrdered:")

takeOrderedRDD.foreach(x => print(x +" "))

sc.stop

}

func +:

func -: //如果分区数据为1结果为 -53

count:

first:

take: top: takeOrdered:

def main(args: Array[String]) {

val conf = new SparkConf().setMaster("local").setAppName("KVFunc")

val sc = new SparkContext(conf)

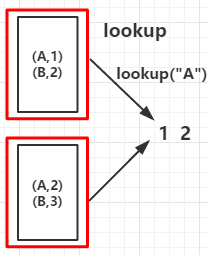

val arr = List(("A", 1), ("B", 2), ("A", 2), ("B", 3))

val rdd = sc.parallelize(arr,2)

val countByKeyRDD = rdd.countByKey()

val collectAsMapRDD = rdd.collectAsMap()

println("countByKey:")

countByKeyRDD.foreach(print)

println("\ncollectAsMap:")

collectAsMapRDD.foreach(print)

sc.stop

}

countByKey:

(B,)(A,)

collectAsMap:

(A,)(B,)

def main(args: Array[String]) {

val conf = new SparkConf().setMaster("local").setAppName("Fold")

val sc = new SparkContext(conf)

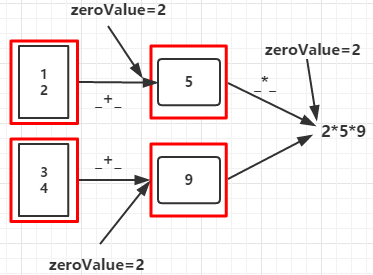

val rdd = sc.parallelize(List(1,2,3,4),2)

val aggregateRDD = rdd.aggregate(2)(_+_,_ * _)

println(aggregateRDD)

sc.stop

}

def main(args: Array[String]) {

val conf = new SparkConf().setMaster("local").setAppName("Fold")

val sc = new SparkContext(conf)

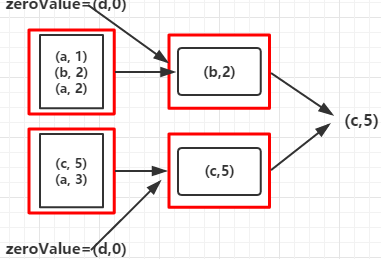

val rdd = sc.parallelize(Array(("a", 1), ("b", 2), ("a", 2), ("c", 5), ("a", 3)), 2)

val foldRDD = rdd.fold(("d", 0))((val1, val2) => { if (val1._2 >= val2._2) val1 else val2

})

println(foldRDD)

}

c,5

Spark常用函数讲解之Action操作的更多相关文章

- Spark常用函数讲解之键值RDD转换

摘要: RDD:弹性分布式数据集,是一种特殊集合 ‚ 支持多种来源 ‚ 有容错机制 ‚ 可以被缓存 ‚ 支持并行操作,一个RDD代表一个分区里的数据集RDD有两种操作算子: Trans ...

- spark 常用函数介绍(python)

以下是个人理解,一切以官网文档为准. http://spark.apache.org/docs/latest/api/python/pyspark.html 在开始之前,我先介绍一下,RDD是什么? ...

- Spark RDD概念学习系列之action操作

不多说,直接上干货! action操作

- Spark常用函数(源码阅读六)

源码层面整理下我们常用的操作RDD数据处理与分析的函数,从而能更好的应用于工作中. 连接Hbase,读取hbase的过程,首先代码如下: def tableInitByTime(sc : SparkC ...

- CI框架常用函数(AR数据库操作的常用函数)

用户手册地址:http://codeigniter.org.cn/user_guide/index.html 1.查询表记录$this->db->select(); //选择查询的字段$t ...

- 四、spark常用函数说明学习

1.parallelize 并行集合,切片数.默认为这个程序所分配到的资源的cpu核的个数. 查看大小:rdd.partitions.size sc.paraliel ...

- Opencv常用函数讲解

1.approxPolyDP(Mat(ps), poly, 5, true);//根据点集,拟合出多边形 2.fillConvexPoly(mask, Mat(ps), Scalar(255));根据 ...

- Spark RDD、DataFrame原理及操作详解

RDD是什么? RDD (resilientdistributed dataset),指的是一个只读的,可分区的分布式数据集,这个数据集的全部或部分可以缓存在内存中,在多次计算间重用. RDD内部可以 ...

- Spark Streaming中的操作函数讲解

Spark Streaming中的操作函数讲解 根据根据Spark官方文档中的描述,在Spark Streaming应用中,一个DStream对象可以调用多种操作,主要分为以下几类 Transform ...

随机推荐

- 初学者学Java设计模式(一)------单例设计模式

单例设计模式 单例设计模式是指一个类只会生成一个对象,优点是他可以确保所有对象都访问唯一实例. 具体实现代码如下: public class A { public static void main(S ...

- Word文档分割总结

Word文档分割总结 方法: 1. word创建子文件实现文件分割 2. VBA实现 3. 网上分割合并的插件软件 一. word创建子文件实现文件分割 打开需要分割的文件 >> 视图 & ...

- Javascript基础引用类型之Object

虽然说ECMAScript也是一门对象语言,但是它和其他面向对象语言还是有区别的,它不具有类和接口等基本结构.所以在ECMAScript中一般说类指的是引用类型.创建Object实例的方式有两种: 第 ...

- 巧记--Css选择器

love ------> hate 即: a:link --> a:visited --> a:hover --> a:active a:link ...

- ASP.NET批量下载服务器端指定目录文件

//遍历服务器指定文件夹下的所有文件 string path = "uploads/Image/"; string serverPath = Server.MapPath(path ...

- vi 快捷键【转】【weber整理必出精品】

光标的移动 命令 光标移动 h或^h 向左移一个字符 j或^j或^n 向下移一行 k或^p 向上移一行 l或空格 向右移一个字符 G 移到文件的最后一行 nG 移到文件的第n行 w 移到下一个字的开头 ...

- 决策树简单介绍(二) Accord.Net中决策树的实现和使用

决策树介绍 决策树是一类机器学习算法,可以实现对数据集的分类.预测等.具体请阅读我另一篇博客(http://www.cnblogs.com/twocold/p/5424517.html). Accor ...

- unity音频组件

unity 支持的四种音频格式: .AIFF 适用于较短的音乐文件可用作游戏打斗音效 .WAV 适用于较短的音乐文件可用作游戏打斗音效 .MP3 适用于较长的音乐文件可用作游戏背景音乐 .OGG ...

- JavaScript的数据类型转换

首先,由于JavaScript是弱类型语言(弱类型的语言的东西没有明显的类型,他能随着环境的不同,自动变换类型而强类型则没这样的规定,不同类型间的操作有严格定义,只有相同类型的变量才能操作,虽然系统也 ...

- C/C++中的switch使用

代码: #include <iostream> #include <string> #include <cstdio> using namespace std; i ...