基于spark和sparkstreaming的word2vec

概述

Word2vec是一款由谷歌发布开源的自然语言处理算法,其目的是把words转换成vectors,从而可以用数学的方法来分析words之间的关系。Spark其该算法进行了封装,并在mllib中实现。

整体流程是spark离线训练模型,可以是1小时1训练也可以1天1训练,根据具体业务来判断,sparkstreaming在线分析。

由于历史问题,spark还在用1.5.0,接口上和2.1还是有点区别,大概看了下文档,流程上差不多

spark离线训练

如下代码,通过word2vec训练出一个模型,并且找出“导弹”的10个近义词

val input = sc.textFile("word2vec.txt").map(line => line.split(" ").toSeq)

val word2vec = new Word2Vec()

word2vec.setMinCount(1)

word2vec.setNumPartitions(1)

word2vec.setNumIterations(1)

val model = word2vec.fit(input)

val synonyms = model.findSynonyms("导弹", 10)

for((synonym, cosineSimilarity) <- synonyms) {

println(s"$synonym $cosineSimilarity")

}

model.save(sc,"myModelPath")

参数解释

|

参数 |

默认 |

解释 |

|

vectorSize |

100 |

向量的维度,一般维度不会太大,通常在100-500 |

|

learningRate |

0.025 |

Sets initial learning rate |

|

numPartitions |

1 |

分区个数,设置多个可以提高计算效率,但会少量的numpartitions有利于精确度 |

|

numIterations |

1 |

迭代次数,应该小于等于numPartitions |

经过粗略的测试,适当提高numPartition可以加快word2vec的计算速度

测试结果

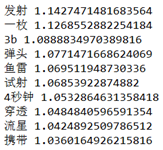

每次测试的结果都有点不同,大致差不多

这里说明一点,结果中第一个字段是word,第二个字段是余弦相似度,由于sparkmllib考虑到计算效率,没有用完成的余弦相似度公式,所以结果会大于1,但这并不影响相似度的判断

测试数据下载地址,数据集为搜狗语料分类中的军事篇

http://files.cnblogs.com/files/ulysses-you/word2vec.zip

sparkstreaming在线分析

这个demo用了socket接口(这样测试是最方便的..),实现了在线对word2vec模型的调用

val model = Word2VecModel.load(ssc.sparkContext, "myModelPath")

val lines = ssc.socketTextStream("localhost",9999)

// Split each line into words

val words = lines.flatMap(_.split(" "))

// Count each word in each batch

words.map{word =>

val synonyms = model.findSynonyms(word,10)

for((synonym, cosineSimilarity) <- synonyms) {

println(s"syn => $synonym $cosineSimilarity")

}

}

参考资料

//numPartitions和numIterations数量的相似问题

//官方1.5.0版本的word2vec介绍

http://spark.apache.org/docs/1.5.0/mllib-feature-extraction.html#word2vec

基于spark和sparkstreaming的word2vec的更多相关文章

- 基于Spark和SparkSQL的NetFlow流量的初步分析——scala语言

基于Spark和SparkSQL的NetFlow流量的初步分析--scala语言 标签: NetFlow Spark SparkSQL 本文主要是介绍如何使用Spark做一些简单的NetFlow数据的 ...

- 基于Spark Mllib的文本分类

基于Spark Mllib的文本分类 文本分类是一个典型的机器学习问题,其主要目标是通过对已有语料库文本数据训练得到分类模型,进而对新文本进行类别标签的预测.这在很多领域都有现实的应用场景,如新闻网站 ...

- 基于HDFS的SparkStreaming案例实战和内幕源码解密

一:Spark集群开发环境准备 启动HDFS,如下图所示: 通过web端查看节点正常启动,如下图所示: 2.启动Spark集群,如下图所示: 通过web端查看集群启动正常,如下图所示: 3.启动sta ...

- 基于Spark的电影推荐系统(推荐系统~7)

基于Spark的电影推荐系统(推荐系统~7) 22/100 发布文章 liuge36 第四部分-推荐系统-实时推荐 本模块基于第4节得到的模型,开始为用户做实时推荐,推荐用户最有可能喜爱的5部电影. ...

- 基于Spark的电影推荐系统(推荐系统~1)

第四部分-推荐系统-项目介绍 行业背景: 快速:Apache Spark以内存计算为核心 通用 :一站式解决各个问题,ADHOC SQL查询,流计算,数据挖掘,图计算 完整的生态圈 只要掌握Spark ...

- 基于spark邮件自动分类

代码放在github上:click me 一.数据说明 数据集为英文语料集,一共包含20种类别的邮件,除了类别soc.religion.christian的邮件数为997以外每个类别的邮件数都是100 ...

- 基于Spark ALS构建商品推荐引擎

基于Spark ALS构建商品推荐引擎 一般来讲,推荐引擎试图对用户与某类物品之间的联系建模,其想法是预测人们可能喜好的物品并通过探索物品之间的联系来辅助这个过程,让用户能更快速.更准确的获得所需 ...

- 【基于spark IM 的二次开发笔记】第一天 各种配置

[基于spark IM 的二次开发笔记]第一天 各种配置 http://juforg.iteye.com/blog/1870487 http://www.igniterealtime.org/down ...

- 大数据实时处理-基于Spark的大数据实时处理及应用技术培训

随着互联网.移动互联网和物联网的发展,我们已经切实地迎来了一个大数据 的时代.大数据是指无法在一定时间内用常规软件工具对其内容进行抓取.管理和处理的数据集合,对大数据的分析已经成为一个非常重要且紧迫的 ...

随机推荐

- 【Egret】里使用iframe标签达到内嵌多个web界面

目的:Egret里使用iframe标签达到内嵌多个web界面,模式相当于主swf调用N个子swf的效果: 目前在做项目过程中,在使用iframe的时候,碰到了一些功能需求,以及解决方法如下: 一..在 ...

- 【 Android】自定义的AlertDialog中的EditText无法调用输入法问题解决

1.问题描述: 在自定义的AlertDialog 中添加了EditText组件,但运行时怎么点EditText都无法调出软键盘: 2.原因分析: 一开始我以为EditText的focus属性没有设置好 ...

- Android kernel LOGO的更换方法

[从制作logo到LCD显示或者VGA显示logo] 1.制作logo的方法: 首先选择一个自己喜欢的图片,然后通过GIMP软件将该图片保存为.png格式, 变换方式这个就不说了(very easy) ...

- 20155304 实验一《Java开发环境的熟悉》实验报告

20155304 实验一实验报告 实验一 Java开发环境的熟悉 实验内容 1.使用JDK编译.运行简单的Java程序: 2.使用IDEA编译.编译.运行.调试Java程序. 实验步骤 (一)命令行下 ...

- javaScript 基础学习笔记

边看视频和书记得有点杂. 1.插入JS标签 一种是在文档中插入<script></script>标签.另一种是把javaScript代码放在.js文件中.放在head中如. & ...

- 轻量级操作系统FreeRTOS的内存管理机制(一)

本文由嵌入式企鹅圈原创团队成员朱衡德(Hunter_Zhu)供稿. 近几年来,FreeRTOS在嵌入式操作系统排行榜中一直位居前列,作为开源的嵌入式操作系统之一,它支持许多不同架构的处理器以及多种编译 ...

- 关于sql、mysql语句的模糊查询分类与详解,包括基本用法和mapper.xml文件里插入写法

欢迎猿类加qq:2318645572,共同学习进步 实际例子: ssm框架:service业务层->dao层->mappers.xml->junit/test测试 1:service ...

- STM32F0的flash读写

flash大小64k Rom+8k Ram的大小,stm32f051有64k Rom,总的分为 64页,一页1024byte ,在flash的Rom里面写数据掉电保存,相当于W25q80 uint32 ...

- Nodejs进阶:express+session实现简易身份认证

本文摘录自<Nodejs学习笔记>,更多章节及更新,请访问 github主页地址.欢迎加群交流,群号 197339705. 文档概览 本文基于express.express-session ...

- Java中四种遍历List的方法

package com.ietree.basic.collection.loop; import java.util.ArrayList; import java.util.Iterator; imp ...