python爬西刺代理

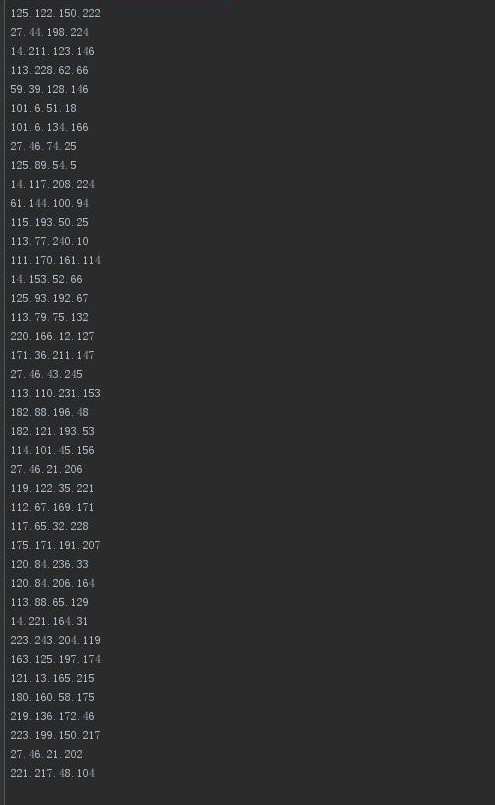

爬IP代码

import requests

import re

import dauk

from bs4 import BeautifulSoup

import time

def daili():

print('[+]极速爬取代理IP,默认为99页')

for b in range(1,99):

url="http://www.xicidaili.com/nt/{}".format(b)

header={'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:58.0) Gecko/20100101 Firefox/48.0'}

r=requests.get(url,headers=header)

gsx=BeautifulSoup(r.content,'html.parser')

for line in gsx.find_all('td'):

sf=line.get_text()

dailix=re.findall('(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)',str(sf))

for g in dailix:

po=".".join(g)

print(po)

with open ('采集到的IP.txt','a') as l:

l.write(po+'\n') daili() def dailigaoni():

print('[+]极速爬取代理IP,默认为99页')

for i in range(1,99):

url="http://www.xicidaili.com/nn/{}".format(i)

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}

r=requests.get(url,headers=header)

bks=r.content

luk=re.findall('(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)',str(bks))

for g in luk:

vks=".".join(g)

print(vks)

with open('采集到的IP.txt','a') as b:

b.write(vks+'\n')

dailigaoni() def dailihtp():

print('[+]极速爬取代理IP,默认为99页')

for x in range(1,99):

header="{'User-Agent':'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}"

url="http://www.xicidaili.com/wn/{}".format(x)

r=requests.get(url,headers=header)

gs=r.content

bs=re.findall('(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)',gs)

for kl in bs:

kgf=".".join(kl)

print(kgf)

with open ('采集到的IP.txt','a') as h:

h.write(kgf)

dailihtp() def dailihttps():

print('[+]极速爬代理IP,默认为99页')

for s in range(1,99):

url="http://www.xicidaili.com/wt/{}".format(s)

header={'User-Agent':'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}

r=requests.get(url,headers=header)

kl=r.content

lox=re.findall('(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)\.(25[0-5]|2[0-4]\d|[0-1]\d{2}|[1-9]?\d)',kl)

for lk in lox:

los=".".join(lk)

print(los)

with open('采集到的IP.txt','a') as lp:

lp.write(los)

dailihttps()

端口代码

import requests

import re

from bs4 import BeautifulSoup def daili():

print('[+]极速爬取代理IP端口,默认为99页')

for b in range(1, 99):

url = "http://www.xicidaili.com/nt/{}".format(b)

header = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:58.0) Gecko/20100101 Firefox/48.0'}

r = requests.get(url, headers=header)

gsx = BeautifulSoup(r.content, 'html.parser')

for line in gsx.find_all('td'):

sf = line.get_text()

dailix = re.findall(

'<td>([0-9]|[1-9]\d{1,3}|[1-5]\d{4}|6[0-5]{2}[0-3][0-5])</td>',

str(sf))

for g in dailix:

po = ".".join(g)

print(po )

with open('采集到的端口.txt.txt', 'a') as l:

l.write(po + '\n') daili() def dailigaoni():

print('[+]极速爬取代理IP的端口,默认为99页')

for i in range(1, 99):

url = "http://www.xicidaili.com/nn/{}".format(i)

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}

r = requests.get(url, headers=header)

bks = r.content

luk = re.findall(

'<td>([0-9]|[1-9]\d{1,3}|[1-5]\d{4}|6[0-5]{2}[0-3][0-5])</td>',

str(bks))

for g in luk:

vks = ".".join(g)

print(vks)

with open('采集到的端口.txt.txt', 'a') as b:

b.write(vks + '\n') dailigaoni() def dailihtp():

print('[+]极速爬取代理IP,默认为99页')

for x in range(1, 99):

header = "{'User-Agent':'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}"

url = "http://www.xicidaili.com/wn/{}".format(x)

r = requests.get(url, headers=header)

gs = r.content

bs = re.findall(

'<td>([0-9]|[1-9]\d{1,3}|[1-5]\d{4}|6[0-5]{2}[0-3][0-5])</td>',

gs)

for kl in bs:

kgf = ".".join(kl)

print(kgf)

with open('采集到的端口.txt.txt', 'a') as h:

h.write(kgf) dailihtp() def dailihttps():

print('[+]极速爬代理IP的端口,默认为99页')

for s in range(1, 99):

url = "http://www.xicidaili.com/wt/{}".format(s)

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1 Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'}

r = requests.get(url, headers=header)

kl = r.content

lox = re.findall(

'<td>([0-9]|[1-9]\d{1,3}|[1-5]\d{4}|6[0-5]{2}[0-3][0-5])</td>',

kl)

for lk in lox:

los = ".".join(lk)

print(los)

with open('采集到的端口.txt', 'a') as lp:

lp.write(los) dailihttps()

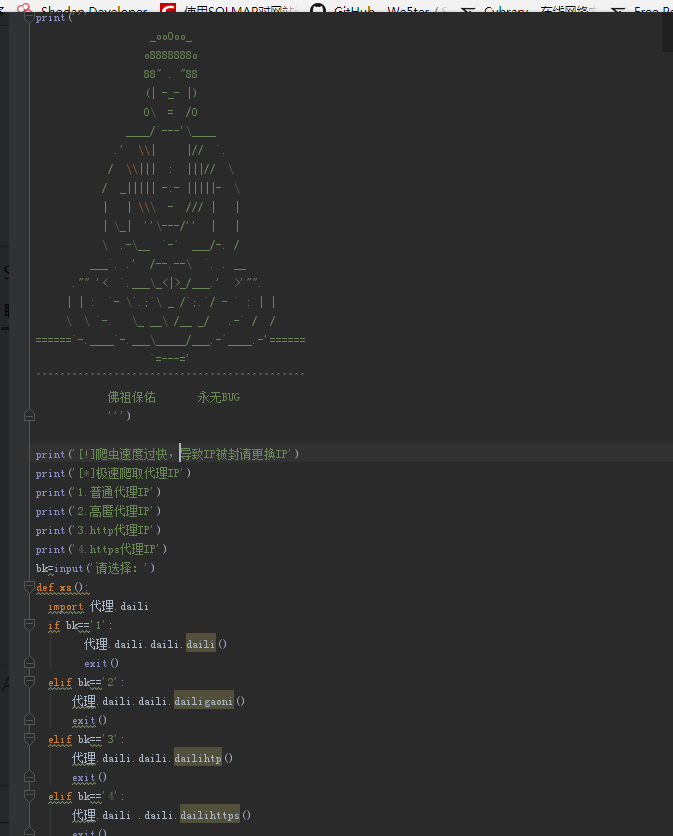

调用代码

print('''

_ooOoo_

o8888888o

88" . "88

(| -_- |)

O\ = /O

____/`---'\____

.' \\| |// `.

/ \\||| : |||// \

/ _||||| -:- |||||- \

| | \\\ - /// | |

| \_| ''\---/'' | |

\ .-\__ `-` ___/-. /

___`. .' /--.--\ `. . __

."" '< `.___\_<|>_/___.' >'"".

| | : `- \`.;`\ _ /`;.`/ - ` : | |

\ \ `-. \_ __\ /__ _/ .-` / /

======`-.____`-.___\_____/___.-`____.-'======

`=---='

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

佛祖保佑 永无BUG

''')

print('[!]爬虫速度过快,导致IP被封请更换IP')

print('[*]极速爬取代理IP')

print('1.普通代理IP')

print('2.高匿代理IP')

print('3.http代理IP')

print('4.https代理IP')

bk=input('请选择:')

def xs():

import 代理.daili

import 代理.dauk

if bk=='1':

代理.daili.daili.daili()

代理.dauk.daili()

exit()

elif bk=='2':

代理.daili.daili.dailigaoni()

代理.dauk.dailigaoni()

exit()

elif bk=='3':

代理.daili.daili.dailihtp()

代理.dauk.dailihtp()

exit()

elif bk=='4':

代理.daili .daili.dailihttps()

代理.dauk.dailihttps()

exit()

elif bk=='q':

exit()

else:

print('[-]没有找到你要的选项')

xs()

2018-02-17

python爬西刺代理的更多相关文章

- 代理IP爬取和验证(快代理&西刺代理)

前言 仅仅伪装网页agent是不够的,你还需要一点新东西 今天主要讲解两个比较知名的国内免费IP代理网站:西刺代理&快代理,我们主要的目标是爬取其免费的高匿代理,这些IP有两大特点:免费,不稳 ...

- 使用XPath爬取西刺代理

因为在Scrapy的使用过程中,提取页面信息使用XPath比较方便,遂成此文. 在b站上看了介绍XPath的:https://www.bilibili.com/video/av30320885?fro ...

- Scrapy爬取西刺代理ip流程

西刺代理爬虫 1. 新建项目和爬虫 scrapy startproject daili_ips ...... cd daili_ips/ #爬虫名称和domains scrapy genspider ...

- python scrapy 爬取西刺代理ip(一基础篇)(ubuntu环境下) -赖大大

第一步:环境搭建 1.python2 或 python3 2.用pip安装下载scrapy框架 具体就自行百度了,主要内容不是在这. 第二步:创建scrapy(简单介绍) 1.Creating a p ...

- Python四线程爬取西刺代理

import requests from bs4 import BeautifulSoup import lxml import telnetlib #验证代理的可用性 import pymysql. ...

- python+scrapy 爬取西刺代理ip(一)

转自:https://www.cnblogs.com/lyc642983907/p/10739577.html 第一步:环境搭建 1.python2 或 python3 2.用pip安装下载scrap ...

- 手把手教你使用Python爬取西刺代理数据(下篇)

/1 前言/ 前几天小编发布了手把手教你使用Python爬取西次代理数据(上篇),木有赶上车的小伙伴,可以戳进去看看.今天小编带大家进行网页结构的分析以及网页数据的提取,具体步骤如下. /2 首页分析 ...

- python3爬虫-通过requests爬取西刺代理

import requests from fake_useragent import UserAgent from lxml import etree from urllib.parse import ...

- 极简代理IP爬取代码——Python爬取免费代理IP

这两日又捡起了许久不碰的爬虫知识,原因是亲友在朋友圈拉人投票,点进去一看发现不用登陆或注册,觉得并不复杂,就一时技痒搞一搞,看看自己的知识都忘到啥样了. 分析一看,其实就是个post请求,需要的信息都 ...

随机推荐

- zzuli 2179 最短路

2179: 紧急营救 Time Limit: 1 Sec Memory Limit: 128 MBSubmit: 89 Solved: 9 SubmitStatusWeb Board Descri ...

- urllib2打开URL(含中文)的问题

import urllib2 url = u"http://www.baidu.com/wd=测试" urllib2.urlopen(url.encode('utf-8')).re ...

- LeetCode OJ:Sqrt(x)(平方根)

Implement int sqrt(int x). Compute and return the square root of x. 简单的二分法,注意mid应该选为long,否则容易溢出: cla ...

- request对象和response对象,什么时候用,具体用哪一个,没有感觉

request对象和response对象,什么时候用,具体用哪一个,没有感觉

- postgresql recovery.conf改变需要重启吗

之前在研究pgpoll时,发现trigger_file参数指定的文件存在后,会自动将standby节点提升为可写节点.不需要手动执行pg_ctl promote,但是这个时间一般有延迟,因为进程会定期 ...

- mysql int(3)与int(11)的区别

总结,int(M) zerofill,加上zerofill后M才表现出有点点效果,比如 int(3) zerofill,你插入到数据库里的是10,则实际插入为010,也就是在前面补充加了一个0.如果i ...

- beego配置文件

关于App配置: #App配置 for Api AppName = ApiService RunMode = dev RouterCaseSensitive = true ServerName = A ...

- eclipse javaw.exe in your current path问题

问题: 第一次运行eclipse的时候,可能会提醒找不到javaw.exe ******等的问题 很坑的! 解决方案: 无法启动Eclipe,因找不到javaw.exe 还是环境变量的问题!!! 注意 ...

- 解决 Laravel/Lumen 出现 "Please provide a valid cache path" 问题

解决 Laravel/Lumen 出现 "Please provide a valid cache path" 问题 解决 Laravel/Lumen 出现 "Pleas ...

- kali视频学习(6-10)

第三周 kali视频(6-10)学习 6.信息搜集之主机探测 7.信息搜集之主机扫描(nmap使用) 8.信息搜集之指纹识别 9.信息搜集之协议分析 10.漏洞分析之OpenVAS安装 6.信息搜集之 ...