kubernetes(K8S)集群及Dashboard安装配置

环境准备

机器信息

| 主机名 | 操作系统 | IP地址 |

|---|---|---|

| K8sm-218 | Centos 7.5-x86_64 | 172.17.0.218 |

| k8s-219 | Centos 7.5-x86_64 | 172.17.0.219 |

| k8s-220 | Centos 7.5-x86_64 | 172.17.0.220 |

关闭防火墙及selinux

# systemctl stop firewalld

# systemctl disable firewalld

# setenforce 0

修改hosts

172.17.0.218 k8sm-218

172.17.0.219 k8s-219

172.17.0.220 k8s-220

增加网络转发

# cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

# sysctl --system //使配置生效

安装docker

# wget -O /etc/yum.repos.d/docker-ce.repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# yum install docker-ce-18.06.1.ce-3.el7 -y

# systemctl start docker

# systemctl enable docker

安装kubelet kubeadm kubectl

# cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# yum install kubelet-1.13.3 -y

# yum install kubeadm-1.13.3 -y

# yum install kubectl-1.13.3 -y

# systemctl enable kubelet

初始化master

操作均在master中执行。

# kubeadm init --kubernetes-version=v1.13.3 --apiserver-advertise-address=172.17.0.218 --image-repository registry.aliyuncs.com/google_containers --pod-network-cidr=10.244.0.0/16 --service-cidr=10.96.0.0/12

--kubernetes-version:指定kubeadm版本;

--pod-network-cidr:指定pod所属网络

--image-repository 指定下载源

--service-cidr:指定service网段,负载均衡ip

--ignore-preflight-errors=Swap/all:忽略 swap/所有 报错

初始化成功:

Your Kubernetes master has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of machines by running the following on each node

as root:

kubeadm join 172.17.0.218:6443 --token ai3bxc.zgq33i1sbdybhnci --discovery-token-ca-cert-hash sha256:20cb9ccc07e2612bc3b31bd7b5e8909bdbd3d293e7c7f4c18dbee6f62ea94788

增加kubectl权限访问:

# mkdir -p $HOME/.kube

# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

# sudo chown $(id -u):$(id -g) $HOME/.kube/config

安装pod网络组件

# kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

查看镜像状态

# kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

coredns-78d4cf999f-5hcjm 1/1 Running 0 29m

coredns-78d4cf999f-6mlql 1/1 Running 0 29m

etcd-k8sm-218 1/1 Running 0 29m

kube-apiserver-k8sm-218 1/1 Running 0 28m

kube-controller-manager-k8sm-218 1/1 Running 0 29m

kube-flannel-ds-amd64-6kfhg 1/1 Running 0 22m

kube-proxy-b4txb 1/1 Running 0 29m

kube-scheduler-k8sm-218 1/1 Running 0 28m

查看node状态

# kubectl get node

NAME STATUS ROLES AGE VERSION

k8sm-218 Ready master 32m v1.13.3

# kubectl get cs

NAME STATUS MESSAGE ERROR

controller-manager Healthy ok

scheduler Healthy ok

etcd-0 Healthy {"health": "true"}

增加node到集群里

操作在node中执行。

// master初始化后的命令

# kubeadm join 172.17.0.218:6443 --token ai3bxc.zgq33i1sbdybhnci --discovery-token-ca-cert-hash sha256:20cb9ccc07e2612bc3b31bd7b5e8909bdbd3d293e7c7f4c18dbee6f62ea94788

master节点查看node状态

# kubectl get node

NAME STATUS ROLES AGE VERSION

k8s-219 Ready <none> 112m v1.13.3

k8s-220 Ready <none> 113m v1.13.3

k8sm-218 Ready master 162m v1.13.3

测试集群是否正常

# kubectl create deployment nginx --image=nginx

deployment.apps/nginx created

# 创建service

# kubectl expose deployment nginx --port=80 --type=NodePort

service/nginx exposed

# kubectl get pods,svc

NAME READY STATUS RESTARTS AGE

pod/nginx-5c7588df-hrhfh 1/1 Running 0 2m16s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 3h6m

service/nginx NodePort 10.97.240.92 <none> 80:30054/TCP 23s

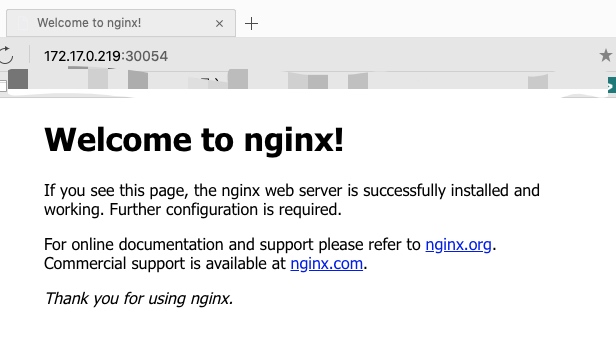

测试nginx

通过任意一个nodeip+端口 ,既可以访问到nginx页面

部署webui dashboard

下载官方的yaml文件

# wget https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

修改两个地方

第一个是修改镜像,kubernetes-dashboard.yaml配置文件112行

90 # ------------------- Dashboard Deployment ------------------- #

91

92 kind: Deployment

93 apiVersion: apps/v1

94 metadata:

95 labels:

96 k8s-app: kubernetes-dashboard

97 name: kubernetes-dashboard

98 namespace: kube-system

99 spec:

100 replicas: 1

101 revisionHistoryLimit: 10

102 selector:

103 matchLabels:

104 k8s-app: kubernetes-dashboard

105 template:

106 metadata:

107 labels:

108 k8s-app: kubernetes-dashboard

109 spec:

110 containers:

111 - name: kubernetes-dashboard

112 #image: k8s.gcr.io/kubernetes-dashboard-amd64:v1.10.1

113 image: mirrorgooglecontainers/kubernetes-dashboard-amd64:v1.10.0

114 ports:

115 - containerPort: 8443

116 protocol: TCP

第二个是添加一个type,指定端口类型为 NodePort,这样外界可以通过地址 nodeIP:nodePort 访问 dashboard,kubernetes-dashboard.yaml配置文件158行

148 # ------------------- Dashboard Service ------------------- #

149

150 kind: Service

151 apiVersion: v1

152 metadata:

153 labels:

154 k8s-app: kubernetes-dashboard

155 name: kubernetes-dashboard

156 namespace: kube-system

157 spec:

158 type: NodePort

159 ports:

160 - port: 443

161 targetPort: 8443

162 selector:

163 k8s-app: kubernetes-dashboard

部署到k8s集群

# kubectl apply -f kubernetes-dashboard.yaml

# kubectl get pods -n kube-system |grep dashboard

kubernetes-dashboard-6685cb584f-xlk2h 1/1 Running 0 98s

# kubectl get pods,svc -n kube-system

NAME READY STATUS RESTARTS AGE

pod/coredns-78d4cf999f-5hcjm 1/1 Running 0 3h21m

pod/coredns-78d4cf999f-6mlql 1/1 Running 0 3h21m

pod/etcd-k8sm-218 1/1 Running 0 3h20m

pod/kube-apiserver-k8sm-218 1/1 Running 0 3h19m

pod/kube-controller-manager-k8sm-218 1/1 Running 0 3h20m

pod/kube-flannel-ds-amd64-6kfhg 1/1 Running 0 3h13m

pod/kube-flannel-ds-amd64-c4fr4 1/1 Running 0 152m

pod/kube-flannel-ds-amd64-qhc2w 1/1 Running 0 151m

pod/kube-proxy-7hntq 1/1 Running 0 151m

pod/kube-proxy-b4txb 1/1 Running 0 3h21m

pod/kube-proxy-bz529 1/1 Running 0 152m

pod/kube-scheduler-k8sm-218 1/1 Running 0 3h20m

pod/kubernetes-dashboard-6685cb584f-xlk2h 1/1 Running 0 3m5s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kube-dns ClusterIP 10.96.0.10 <none> 53/UDP,53/TCP 3h21m

service/kubernetes-dashboard NodePort 10.104.4.26 <none> 443:31667/TCP 3m5s

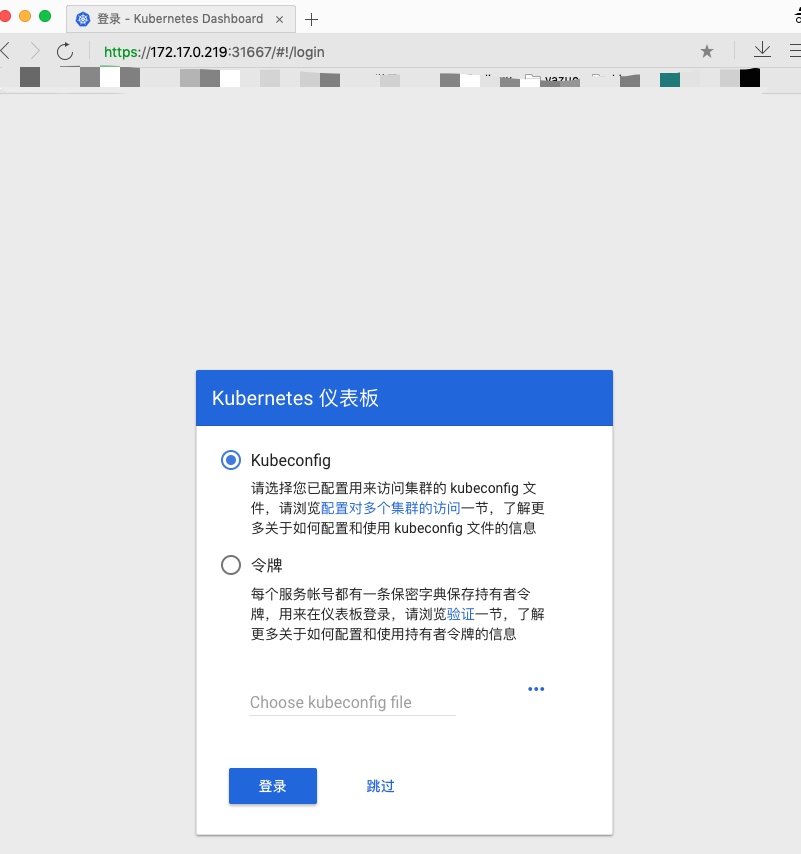

通过https访问ui

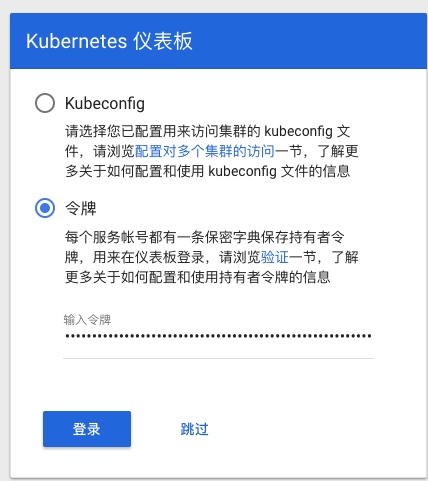

Token (令牌) 认证方式

此操作在master中执行。

1.授权 (所有 namespace )

#创建serviceaccount

[root@master ~]# kubectl create serviceaccount dashboard-serviceaccount -n kube-system

#创建clusterrolebinding

# kubectl create clusterrolebinding dashboard-cluster-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-serviceaccount

2.获取令牌(用于网页登录)

#查看口令列表

# kubectl get secret -n kube-system |grep dashboard-serviceaccount-token

dashboard-serviceaccount-token-f45wg kubernetes.io/service-account-token 3 22s

#获取口令

# kubectl describe secret dashboard-serviceaccount-token-f45wg -n kube-system

将获取到的token放在令牌里

登录成功

至此,K8S集群+Dashboard搭建成功!

转载请添加出处:https://www.cnblogs.com/aresxin/p/k8s-install.html

kubernetes(K8S)集群及Dashboard安装配置的更多相关文章

- Centos7 安装部署Kubernetes(k8s)集群

目录 一.系统环境 二.前言 三.Kubernetes 3.1 概述 3.2 Kubernetes 组件 3.2.1 控制平面组件 3.2.2 Node组件 四.安装部署Kubernetes集群 4. ...

- Istio(二):在Kubernetes(k8s)集群上安装部署istio1.14

目录 一.模块概览 二.系统环境 三.安装istio 3.1 使用 Istioctl 安装 3.2 使用 Istio Operator 安装 3.3 生产部署情况如何? 3.4 平台安装指南 四.Ge ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之自签TLS证书及Etcd集群部署(二)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.服务器设置 1.把每一 ...

- 使用kubectl管理Kubernetes(k8s)集群:常用命令,查看负载,命名空间namespace管理

目录 一.系统环境 二.前言 三.kubectl 3.1 kubectl语法 3.2 kubectl格式化输出 四.kubectl常用命令 五.查看kubernetes集群node节点和pod负载 5 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之flanneld网络介绍及部署(三)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.flanneld介绍 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之部署master/node节点组件(四)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 1.部署master组件 ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录

0.目录 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.感谢 在此感谢.net ...

- Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列之集群部署环境规划(一)

0.前言 整体架构目录:ASP.NET Core分布式项目实战-目录 k8s架构目录:Kubernetes(k8s)集群部署(k8s企业级Docker容器集群管理)系列目录 一.环境规划 软件 版本 ...

- Hadoop集群搭建-05安装配置YARN

Hadoop集群搭建-04安装配置HDFS Hadoop集群搭建-03编译安装hadoop Hadoop集群搭建-02安装配置Zookeeper Hadoop集群搭建-01前期准备 先保证集群5台虚 ...

随机推荐

- rabbitMq 学习笔记(二) 备份交换器,过期时间,死信队列,死信队列

备份交换器 备份交换器,英文名称为 Altemate Exchange,简称庙,或者更直白地称之为"备胎交换器". 生产者在发送消息的时候如果不设置 mandatory 参数, 那 ...

- tp框架防止表单重复提交

转载 框架官方 http://www.thinkphp.cn/topic/9090.html 第三方 https://my.oschina.net/caomenglong/blog/728908

- 过渡属性transition

过渡属性:使元素变化过程可见 transition: all 1s;元素所有变化过程都可见 transition: 1s;元素所有变化过程都可见 transition: 指定属性 2s 1s;指定属性 ...

- Core Animation笔记(动画)

一.隐式动画 layer默认开启隐式动画 禁用隐式动画 [CATransaction setDisableActions:true]; 设置隐士动画时间 //默认0.25s [CATransactio ...

- Sqlite常用命令及基本知识

sqlite菜鸟教程:http://www.runoob.com/sqlite/sqlite-tutorial.html 常用命令: .sqlite3 --从dos命令模式进入sqlite命令 ...

- Python多版本环境搭建(Linux系统)

python Linux 环境 (版本隔离工具) 首先新建用户,养成良好习惯 useradd python 1.安装pyenv GitHub官网: https://github.c ...

- MySQL Hardware--RAID卡常用信息查看

MegaRAID信息查看 #查raid卡信息(生产商.电池信息及所支持的raid级别) /usr/local/sbin/MegaCli -AdpAllInfo -aALL |grep -E " ...

- oracle密码修改保持和以前相同

需求:密码要求3个月变更一次,不管是不是业务密码,均需修改.对于非业务账号,直接修改即可,没有什么影响,SQL语句为: ALTER USER {user_name} IDENTIFIED BY {ne ...

- zabbix-web切换为nginx及https

目录 zabbix-web切换为nginx及https 1.背景和环境 2.安装nginx 2.1.编译参数 2.2.修改配置文件并配置https 2.3.配置nginx为系统服务 3.安装php 3 ...

- 登录-redis

session的问题 目前session直接是js变量,放在nodejs进程内存中 1.进程内存有限,访问量过大,内存暴增怎么办? 2.正式线上运行是多进程,进程之间内存无法共享 为何session适 ...