Kafka支持单集群20万分区

Kafka支持单集群20万分区

之前网上关于确定Kafka分区数的博客多多少少都源自于饶军大神的文章,如今他带来了这方面的第二篇文章,特此翻译一下,记录一下其中的要点。

原贴地址: https://www.confluent.io/blog/apache-kafka-supports-200k-partitions-per-cluster

Kafka中topic可以设置多个分区,而分区是最小的并行度单位。通常而言,分区数越多吞吐量也越高。但是依然有很多因素制约了一个Kafka集群所能支持的最大分区数。我现在高兴地宣布Kafka 1.1.0版本在这方面取得了重大的改进。目前生产环境中单Kafka集群支持的分区上限得到了极大的提升。

为了便于理解这个改进是如何实现的,我们重温一下分区leader和controller的基本概念。首先,每个分区都可以配置多个副本用于实现高可用性以及持久性。其中的一个副本被指定为leader而所有client只与leader进行交互;其次,cluster中的某个broker被指定为controller来管理整个集群。若broker挂掉,controller负责为该broker上所有分区选举leader。

默认情况下关闭Kafka broker执行的是一个受控关闭操作(下称controlled shutdown)。Controlled shutdown对client的影响是最小的。一个典型的controlled shutdown分为以下几步:1. 发送SIGTERM信号给待关闭的broker;2. Broker发送请求给controller表明自己要正常关闭;3. Controller变更该broker上所有分区的leader并将这部分数据保存回Zookeeper;4. Controller发送新的leader信息给其他broker;5. Controller发送响应给关闭中的broker表明操作成功,于是broker成功关闭。此时,client端不受任何影响因为新leader已经转移到其他broker上。下面的两张图描述了这个过程,注意到图中(4)和(5)步是可以并行执行的:

上图中步骤(1)发起broker关闭;步骤(2)发送controlled shutdown请求给controller;步骤(3)中controller写入新leader到Zookeeper;步骤(4)controller发送新leader信息到其他broker;步骤(5)controller发送成功信息给关闭中的broker

在Kafka 1.1.0之前,一旦发起controlled shutdown,controller每次只能为一个分区选举leader。对于每个分区而言,controller顺序执行:选择新leader、同步写leader信息回Zookeeper以及同步leader信息给其他broker等操作。这种设计是低效率的:首先,同步写入Zookeeper就有很高的延时,从而整体拖慢controller shudown时间;其次,每次处理一个分区的做法导致需要给其他broker发送很多次请求,即使这些请求本身携带的数据量是很小的,从而最终导致对新leader的处理时间被极大地拉长。

Kafka 1.1.0为controlled shutdown引入了多个方面的性能提升。第一个提升就是使用异步API来替代了之前的同步写入Zookeeper。在controlled shutdown过程中,Kafka不再是每次写入一个leader信息,等待其完成然后再写入下一个。相反地,controller使用异步API一次性地提交多个分区的leader到Zookeeper上,然后统一等待其执行完毕。这就等于在Kafka与Zookeeper之间构建了一种管道式请求处理流程,从而减少了整体的延时。第二个提升则是将于新leader的交互操作批量化。与其每次为一个分区发送RPC请求,controller使用单个RPC请求一次性地携带所有受影响分区的leader信息。

同时,Kafka对于controller failover的时间也做了优化。当controller挂掉后,Kafka集群自动检测controller失败并选择其他broker作为新的controller。在开启controller工作之前,新选出的controller必须要从Zookeeper中加载所有分区的状态信息到内存中。如果controller直接崩溃的话,分区不可用的时间窗口将等同于Zookeeper会话超时时间加上controller状态加载时间,所以降低加载时间能够有效地帮助我们改善Kafka可用性。在1.1.0之前,加载操作使用的也是同步Zookeeper API。在1.1.0中被替换成了异步API。

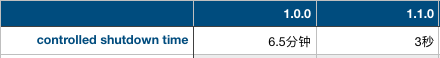

社区对controlled shutdown时间和加载时间都做了测试。每个测试都使用了5节点Zookeeper的集群。在测试controlled shutdown时,社区搭建了一个5节点broker的Kafka集群并为该集群创建了25000个单分区的topic,每个topic都是双副本,故每个broker上平均有10000个分区。之后测试controlled shutdown,测试结果如下:

提升的很大一部分来自于修复了打日志(logging)的开销:之前在每个分区leader变更时都会记录集群中所有分区的数据——这实际上是没必要的。通过修复了这个logging的bug,controller shutdown从6.5分钟被压缩到30秒,而采用异步API更进一步地将其拉低到3秒。这些提升都极大地缩短了Kafka集群重启恢复的时间。

在第二项测试中,社区同样搭建了一个5节点集群,只不过这次创建了2000个配置有50分区的topic,单副本——故总数是1000000个分区。当测试controller状态加载时间时发现比1.0.0有了100%的提升(1.0.0耗时28秒,1.1.0耗时14秒)。

有了这些提升,Kafka单集群能够支持多少分区呢?确切的数字自然依赖于诸如可容忍的不可用窗口时间、Zookeeper延时、broker存储类型等因素。根据经验法则我们评估单台broker能够支撑的分区数可达4000个,而单集群能够支撑200000个分区。当然后者主要受限于集群对controller崩溃这种不常见情形的容忍度,另外其他影响分区数的因素也要考虑进来。

1.1.0所做的改进仅仅是提升Kafka高扩展性的一小步。事实上社区在1.1.0版本还尝试了更多的分区并改进了它们的延时表现。后面可能会在另一篇文章中给出具体的说明。在未来,Kafka社区计划实现单集群支撑百万级分区的构想,所以,敬请期待~~

Kafka支持单集群20万分区的更多相关文章

- 【译】Apache Kafka支持单集群20万分区

之前网上关于确定Kafka分区数的博客多多少少都源自于饶军大神的文章,如今他带来了这方面的第二篇文章,特此翻译一下,记录一下其中的要点. 原贴地址: https://www.confluent.io/ ...

- [转帖]单集群10万节点 走进腾讯云分布式调度系统VStation

单集群10万节点 走进腾讯云分布式调度系统VStation https://www.sohu.com/a/227223696_355140 2018-04-04 08:18 云计算并非无中生有的概念, ...

- [转帖]“腾百万”之后,腾讯的云操作系统VStation单集群调度达10万台

“腾百万”之后,腾讯的云操作系统VStation单集群调度达10万台 https://www.leiphone.com/news/201909/4BsKCJtvvUCEb66c.html 腾讯有超过1 ...

- 100+诡异的数据集,20万Eclipse Bug、死囚遗言等

摘要:近日,Robert Seaton整理了100多个最有趣的数据集,其中包括Jeopardy真题,死囚的最后一句话,20万个Eclipse Bug,足球比赛相关,柏拉图式的爱情,太阳系以外的行星,1 ...

- Python 基于Python结合pykafka实现kafka生产及消费速率&主题分区偏移实时监控

基于Python结合pykafka实现kafka生产及消费速率&主题分区偏移实时监控 By: 授客 QQ:1033553122 1.测试环境 python 3.4 zookeeper- ...

- ELK+zookeeper+kafka+rsyslog集群搭建

前言 环境困境: 1.开发人员无法登陆服务器 2.各系统都有日志,日志数据分散难以查找 3.日志数据量大,查询忙,不能实时 环境要求: 1.日志需要标准化 集群流程图: 角色: 软件: 以 ...

- 当 K8s 集群达到万级规模,阿里巴巴如何解决系统各组件性能问题?

作者 | 阿里云容器平台高级技术专家 曾凡松(逐灵) 本文主要介绍阿里巴巴在大规模生产环境中落地 Kubernetes 的过程中,在集群规模上遇到的典型问题以及对应的解决方案,内容包含对 etcd.k ...

- kafka高可用性集群

kafka集群并测试其高可用性 介绍 Kafka是由Apache软件基金会开发的一个开源流处理平台,由Scala和Java编写.Kafka是一种高吞吐量的分布式发布订阅消息系统,它可以处理消费者在网站 ...

- [转帖]当 K8s 集群达到万级规模,阿里巴巴如何解决系统各组件性能问题?

改天学习一下. https://www.cnblogs.com/alisystemsoftware/p/11570806.html 当 K8s 集群达到万级规模,阿里巴巴如何解决系统各组件性能问题 ...

随机推荐

- SVN客户端安装

1.安装客户端 双击运行: 点击[next] 点击[next] 选择好路径后,点击[next] 点击[install]安装 点击[finish]完成安装.安装完成后重启计算机. 2.客户端访问SVN服 ...

- 前端通过js获取微信公众号用户的唯一标识符openId

微信公众号程序开发的时候,获取用户信息的时候,需要用到用户的openId,openId是微信用户的唯一标识符,这个操作可以后台实现也可以前端实现,之前项目里是通过后台来获取的,好像用到了一些三方的包, ...

- JS面向对象设计-创建对象

Object构造函数和对象字面量都可以用来创建单个对象,但是在创建多个对象时,会产生大量重复代码. 1.工厂模式 工厂模式抽象了创建具体对象的过程.由于ECMAScript无法创建类,我们用函数来封装 ...

- 用javascript写了一个模拟阅读小说的程序

<html> <meta http-equiv="content-type" content="text/html; charset=UTF-8&quo ...

- 在verilog中使用格雷码

格雷码的一些知识: https://baike.baidu.com/item/%E6%A0%BC%E9%9B%B7%E7%A0%81/6510858?fr=aladdin 绿色框起来的是0--15的格 ...

- android studio学习----偏好设置

主要找到设置的界面:Files->Settings , android studio里面没有preferences 1.字体大小设置 进入后你也许发现字体大小或者样式不符合你的习惯,比如我是觉得 ...

- Qt中QWidget、QDialog和QMainWindow

QWidget 类是所有用户界面对象的基类.只有一个"页面" QMainWindow 是一个"窗口".含有菜单栏.状态栏.工具栏.停靠窗口.中心窗口 QDial ...

- 【转】WPF 异步执行方法后对 UI 进行更新的几种方法

使用 async/await 的情况: private async void Button_Click(object sender, RoutedEventArgs e) { (sender as B ...

- 配置以https访问网站

环境 centos7 nginx1.16.1 一.申请证书(已有域名) 进入阿里云控制台,点击域名(我已经弄好了,一开始是没有ssl选项) 点击免费开启ssl 点购买->选择免费版 购买成功后 ...

- 在系统下文件上传报错:The temporary upload location [/tmp/tomcat.xxx/work/Tomcat/localhost/ROOT] is not valid

线上的系统中长时间不访问时不能上传文件了,出现如下错误: 2019-03-11 23:37:42.741 ERROR 66505 --- [nio-8081-exec-3] o.a.c.c.C.[.[ ...