Spark实现分组TopN

一.概述

在许多数据中,都存在类别的数据,在一些功能中需要根据类别分别获取前几或后几的数据,用于数据可视化或异常数据预警。在这种情况下,实现分组TopN就显得非常重要了,因此,使用了Spark聚合函数和排序算法实现了分布式TopN计算功能。

二.代码实现

package scala

import org.apache.log4j.{Level, Logger}

import org.apache.spark.sql.types.{StringType, StructField, StructType}

import org.apache.spark.sql.{Row, SparkSession}

/**

* 计算分组topN

* Created by Administrator on 2019/11/20.

*/

object GroupTopN {

Logger.getLogger("org").setLevel(Level.WARN) // 设置日志级别

def main(args: Array[String]) {

//创建测试数据

val test_data = Array("CJ20191120,201911", "CJ20191120,201910", "CJ20191105,201910", "CJ20191105,201909", "CJ20191111,201910")

val spark = SparkSession.builder().appName("GroupTopN").master("local[2]").getOrCreate()

val sc = spark.sparkContext

val test_data_rdd = sc.parallelize(test_data).map(row => {

val Array(scene, cycle) = row.split(",")

Row(scene, cycle)

})

// 设置数据模式

val structType = StructType(Array(

StructField("scene", StringType, true),

StructField("cycle", StringType, true)

))

// 转换为df

val test_data_df = spark.createDataFrame(test_data_rdd, structType)

test_data_df.createOrReplaceTempView("test_data_df")

// 拼接周期

val scene_ws = spark.sql("select scene,concat_ws(',',collect_set(cycle)) as cycles from test_data_df group by scene")

scene_ws.count()

scene_ws.show()

scene_ws.createOrReplaceTempView("scene_ws")

/**

* 定义参数确定N的大小,暂定为1

*/

val sum = 1

// 创建广播变量,把N的大小广播出去

val broadcast = sc.broadcast(sum)

/**

* 定义Udf实现获取组内的前N个数据

*/

spark.udf.register("getTopN", (cycles : String) => {

val sum = broadcast.value

var mid = ""

if(cycles.contains(",")){ // 多值

val cycle = cycles.split(",").sorted.reverse // 降序排序

val min = Math.min(cycle.length, sum)

for(i <- 0 until min){

if(mid.equals("")){

mid = cycle(i)

}else{

mid += "," + cycle(i)

}

}

}else{ // 单值

mid = cycles

}

mid

})

val result = spark.sql("select scene,getTopN(cycles) cycles from scene_ws")

result.show()

spark.stop()

}

}

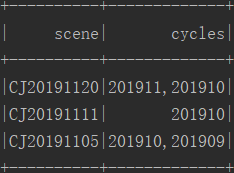

三.结果

四.备注

当N大于1时,多个数据会拼接在一起,若想每个一行,可是使用使用列转行功能,参考我的博客:https://www.cnblogs.com/yszd/p/11266552.html

Spark实现分组TopN的更多相关文章

- 020 Spark中分组后的TopN,以及Spark的优化(重点)

一:准备 1.源数据 2.上传数据 二:TopN程序编码 1.程序 package com.ibeifeng.bigdata.spark.core import java.util.concurren ...

- 大数据学习day29-----spark09-------1. 练习: 统计店铺按月份的销售额和累计到该月的总销售额(SQL, DSL,RDD) 2. 分组topN的实现(row_number(), rank(), dense_rank()方法的区别)3. spark自定义函数-UDF

1. 练习 数据: (1)需求1:统计有过连续3天以上销售的店铺有哪些,并且计算出连续三天以上的销售额 第一步:将每天的金额求和(同一天可能会有多个订单) SELECT sid,dt,SUM(mone ...

- QL查询案例:取得分组 TOP-N

[转]SQL查询案例:取得分组 TOP-N CREATE TABLE TopnTest ( name VARCHAR(10), --姓名 procDate DATETIME, ...

- 用Spark完成复杂TopN计算的两种逻辑

如果有商品品类的数据pairRDD(categoryId,clickCount_orderCount_payCount),用Spark完成Top5,你会怎么做? 这里假设使用Java语言进行编写,那么 ...

- 取分组TOPN好理解案例

- 分别使用Hadoop和Spark实现TopN(1)——唯一键

0.简介 TopN算法是一个经典的算法,由于每个map都只是实现了本地的TopN算法,而假设map有M个,在归约的阶段只有M x N个,这个结果是可以接受的并不会造成性能瓶颈. 这个TopN算法在ma ...

- TopN问题(分别使用Hadoop和Spark实现)

简介 TopN算法是一个经典的算法,由于每个map都只是实现了本地的TopN算法,而假设map有M个,在归约的阶段只有M x N个,这个结果是可以接受的并不会造成性能瓶颈. 这个TopN算法在map阶 ...

- spark面试总结3

Spark core面试篇03 1.Spark使用parquet文件存储格式能带来哪些好处? 1) 如果说HDFS 是大数据时代分布式文件系统首选标准,那么parquet则是整个大数据时代文件存储格式 ...

- Spark面试相关

Spark Core面试篇01 随着Spark技术在企业中应用越来越广泛,Spark成为大数据开发必须掌握的技能.前期分享了很多关于Spark的学习视频和文章,为了进一步巩固和掌握Spark,在原有s ...

随机推荐

- CF1256(div3 java题解)

A: 题意:给定A个N元,B个一元,问是否可以凑成S元. 思路:A*i+j=S 即 A*I<=S<=A*I+B 即min(S/N,A)+B>=S: /* @author nimphy ...

- luoguP3172 [CQOI2015]选数

题意 所求即为: \(\sum\limits_{i_1=L}^{R}\sum\limits_{i_2=L}^{R}...\sum\limits_{i_k=L}^{R}[\gcd(i_1,i_2,... ...

- Python进阶-Ⅹ 正则表达式(RexEx)、re模块

1.正则表达式(RexEx)常用知识 2.python中re模块的初步使用 1).findall方法 ret = re.findall('a', 'eva egon yuan') # 返回所有满足匹配 ...

- 第四章、Go-面向“对象”

4.1.结构体和方法 (1)go语言的面向对象 go仅支持封装,不支持继承和多态 go语言没有class,只有struct (2)struct的创建 package main import " ...

- Linux文件系统与日志

1.inode 包含文件的元信息(1)inode 内容:文件的字节数.拥有者的 UID.GID.文件的读写执行权限.时间戳等,但不包含文件名.文件名是储存在目录的目录项中.(2)查看文件的 inode ...

- RAID及磁盘配额

RAID的对比: 版本 特点 磁盘个数 可用空间 故障磁盘数 应用环境 RAID0 读写速度快,数据容易丢失 两个 全部 一块 测试,临时性 RAID1 读写速度慢,数据可靠 至少两个,可以2的倍数 ...

- Codeforces Round #545 (Div. 2) E 强连通块 + dag上求最大路径 + 将状态看成点建图

https://codeforces.com/contest/1138/problem/E 题意 有n个城市(1e5),有m条单向边(1e5),每一周有d天(50),对于每个城市假如在某一天为1表示这 ...

- [LeetCode] 402. Remove K Digits 去掉K位数字

Given a non-negative integer num represented as a string, remove k digits from the number so that th ...

- 应用层协议:HTTP

1. HTTP定义 HyperText Transfer Protocol,超文本传输协议,是一个基于请求与响应,无状态的,应用层的协议,常基于TCP/IP协议传输数据,互联网上应用最为广泛的一种网络 ...

- .NET Core应用中使用分布式缓存及内存缓存

.NET Core针对缓存提供了很好的支持 ,我们不仅可以选择将数据缓存在应用进程自身的内存中,还可以采用分布式的形式将缓存数据存储在一个“中心数据库”中.对于分布式缓存,.NET Core提供了针对 ...