DataFrames与RDDs的相互转换

import org.apache.spark.sql.{DataFrameReader, SQLContext}

import org.apache.spark.{SparkConf, SparkContext}

object InferringSchema {

def main(args: Array[String]) {

//创建SparkConf()并设置App名称

val conf = new SparkConf().setAppName("SQL-intsmaze")

//SQLContext要依赖SparkContext

val sc = new SparkContext(conf)

//创建SQLContext

val sqlContext = new SQLContext(sc)

//从指定的地址创建RDD

val lineRDD = sc.textFile("hdfs://192.168.19.131:9000/person.tzt").map(_.split(","))

//创建case class

//将RDD和case class关联

val personRDD = lineRDD.map(x => Person(x().toInt, x(), x().toInt))

//导入隐式转换,如果不导入无法将RDD转换成DataFrame

//将RDD转换成DataFrame

import sqlContext.implicits._

val personDF = personRDD.toDF

//注册表

personDF.registerTempTable("intsmaze")

//传入SQL

val df = sqlContext.sql("select * from intsmaze order by age desc limit 2")

//将结果以JSON的方式存储到指定位置

df.write.json("hdfs://192.168.19.131:9000/personresult")

//停止Spark Context

sc.stop()

}

}

//case class一定要放到外面

case class Person(id: Int, name: String, age: Int)

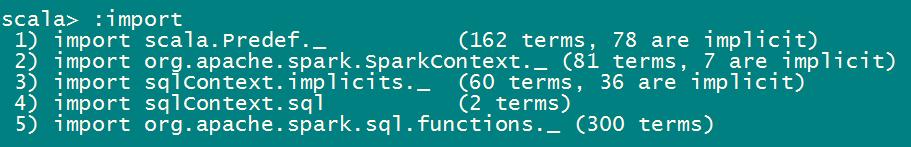

spark shell中不需要导入sqlContext.implicits._是因为spark shell默认已经自动导入了。

打包提交到yarn集群:

/home/hadoop/app/spark/bin/spark-submit --class InferringSchema \

--master yarn \

--deploy-mode cluster \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar

通过编程接口指定Schema(Programmatically Specifying the Schema)

当JavaBean不能被预先定义的时候,编程创建DataFrame分为三步:

从原来的RDD创建一个Row格式的RDD.

创建与RDD中Rows结构匹配的StructType,通过该StructType创建表示RDD的Schema.

通过SQLContext提供的createDataFrame方法创建DataFrame,方法参数为RDD的Schema.

import org.apache.spark.sql.{Row, SQLContext}

import org.apache.spark.sql.types._

import org.apache.spark.{SparkContext, SparkConf}

object SpecifyingSchema {

def main(args: Array[String]) {

//创建SparkConf()并设置App名称

val conf = new SparkConf().setAppName("SQL-intsmaze")

//SQLContext要依赖SparkContext

val sc = new SparkContext(conf)

//创建SQLContext

val sqlContext = new SQLContext(sc)

//从指定的地址创建RDD

val personRDD = sc.textFile(args()).map(_.split(","))

//通过StructType直接指定每个字段的schema

val schema = StructType(

List(

StructField("id", IntegerType, true),

StructField("name", StringType, true),

StructField("age", IntegerType, true)

)

)

//将RDD映射到rowRDD

val rowRDD = personRDD.map(p => Row(p().toInt, p().trim, p().toInt))

//将schema信息应用到rowRDD上

val personDataFrame = sqlContext.createDataFrame(rowRDD, schema)

//注册表

personDataFrame.registerTempTable("intsmaze")

//执行SQL

val df = sqlContext.sql("select * from intsmaze order by age desc ")

//将结果以JSON的方式存储到指定位置

df.write.json(args())

//停止Spark Context

sc.stop()

}

}

将程序打成jar包,上传到spark集群,提交Spark任务

/home/hadoop/app/spark/bin/spark-submit --class SpecifyingSchema \

--master yarn \

--deploy-mode cluster \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar \

hdfs://192.168.19.131:9000/person.txt hdfs://192.168.19.131:9000/intsmazeresult

/home/hadoop/app/spark/bin/spark-submit --class SpecifyingSchema \

--master yarn \

--deploy-mode client \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar \

hdfs://192.168.19.131:9000/person.txt hdfs://192.168.19.131:9000/intsmazeresult

在maven项目的pom.xml中添加Spark SQL的依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.</artifactId>

<version>1.6.</version>

</dependency>

DataFrames与RDDs的相互转换的更多相关文章

- 2.sparkSQL--DataFrames与RDDs的相互转换

Spark SQL支持两种RDDs转换为DataFrames的方式 使用反射获取RDD内的Schema 当已知类的Schema的时候,使用这种基于反射的方法会让代码更加简洁而且效果也很好. 通 ...

- Spark SQL 之 DataFrame

Spark SQL 之 DataFrame 转载请注明出处:http://www.cnblogs.com/BYRans/ 概述(Overview) Spark SQL是Spark的一个组件,用于结构化 ...

- Spark SQL 官方文档-中文翻译

Spark SQL 官方文档-中文翻译 Spark版本:Spark 1.5.2 转载请注明出处:http://www.cnblogs.com/BYRans/ 1 概述(Overview) 2 Data ...

- SparkSql官方文档中文翻译(java版本)

1 概述(Overview) 2 DataFrames 2.1 入口:SQLContext(Starting Point: SQLContext) 2.2 创建DataFrames(Creating ...

- Spark记录-SparkSql官方文档中文翻译(部分转载)

1 概述(Overview) Spark SQL是Spark的一个组件,用于结构化数据的计算.Spark SQL提供了一个称为DataFrames的编程抽象,DataFrames可以充当分布式SQL查 ...

- 转】Spark SQL 之 DataFrame

原博文出自于: http://www.cnblogs.com/BYRans/p/5003029.html 感谢! Spark SQL 之 DataFrame 转载请注明出处:http://www.cn ...

- DataFrames,Datasets,与 SparkSQL

v\:* {behavior:url(#default#VML);} o\:* {behavior:url(#default#VML);} w\:* {behavior:url(#default#VM ...

- A Tale of Three Apache Spark APIs: RDDs, DataFrames, and Datasets(中英双语)

文章标题 A Tale of Three Apache Spark APIs: RDDs, DataFrames, and Datasets 且谈Apache Spark的API三剑客:RDD.Dat ...

- Spark RDDs vs DataFrames vs SparkSQL

简介 Spark的 RDD.DataFrame 和 SparkSQL的性能比较. 2方面的比较 单条记录的随机查找 aggregation聚合并且sorting后输出 使用以下Spark的三种方式来解 ...

随机推荐

- LLE局部线性嵌入算法

非线性降维 流形学习 算法思想有些类似于NLM,但是是进行的降维操作. [转载自] 局部线性嵌入(LLE)原理总结 - yukgwy60648的博客 - CSDN博客 https://blog.csd ...

- [转]ASP.NET MVC 5 - 查询Details和Delete方法

在这部分教程中,接下来我们将讨论自动生成的Details和Delete方法. 查询Details和Delete方法 打开Movie控制器并查看Details方法. public ActionResul ...

- Oracle-随机数获取

1.获取10-100的数据,保留两位小数 select trunc(dbms_random.value(10,100),2) from dual ; 2.获取0-1的小数 select dbms_ra ...

- Linux mysql 命令

mysql 是 MySQL 服务的一个命令行工具,常见用法如下: [root@localhost ~]$ mysql -uroot -p' # 本地连接 MySQL 服务 [root@localhos ...

- Linux echo 命令

echo命令用于输出指定的字符串,常见用法如下: [root@localhost ~]$ echo # 输出一个空白行[root@localhost ~]$ echo "hello worl ...

- oracle12c创建用户和表空间出现的问题

Oracle12c 中,增加了可插接数据库的概念,即PDB,允许一个数据库容器(CDB)承载多个可插拔数据库(PDB).CDB全称为 ContainerDatabase,中文翻译为数据库容器,PDB全 ...

- spring AOP底层原理实现——jdk动态代理

spring AOP底层原理实现——jdk动态代理

- 【转】DevOps的前世今生

转自:http://www.infoq.com/cn/news/2016/09/learn-devops-from-reports 目前在国外,互联网巨头如Google.Facebook.Amazon ...

- 【BZOJ5082】弗拉格 矩阵乘法

[BZOJ5082]弗拉格 Description “如果明天进了面试,我就去爆妹子的照”——有妹子的丁相允作为一个oier,自然不能立太多flag,让我们来看一道和flag有关的题目吧 给你n个fl ...

- 【BZOJ3932】[CQOI2015]任务查询系统 主席树

[BZOJ3932][CQOI2015]任务查询系统 Description 最近实验室正在为其管理的超级计算机编制一套任务管理系统,而你被安排完成其中的查询部分.超级计算机中的 任务用三元组(Si, ...