记一次简单爬虫(豆瓣/dytt)

磕磕绊绊学python一个月,这次到正则表达式终于能写点有趣的东西,在此作个记录:

—————————————————————————————————————————————————

1.爬取豆瓣电影榜前250名单

运行环境:

pycharm-professional-2018.2.4

3.7.0 (v3.7.0:1bf9cc5093, Jun 27 2018, 04:59:51) [MSC v.1914 64 bit (AMD64)]

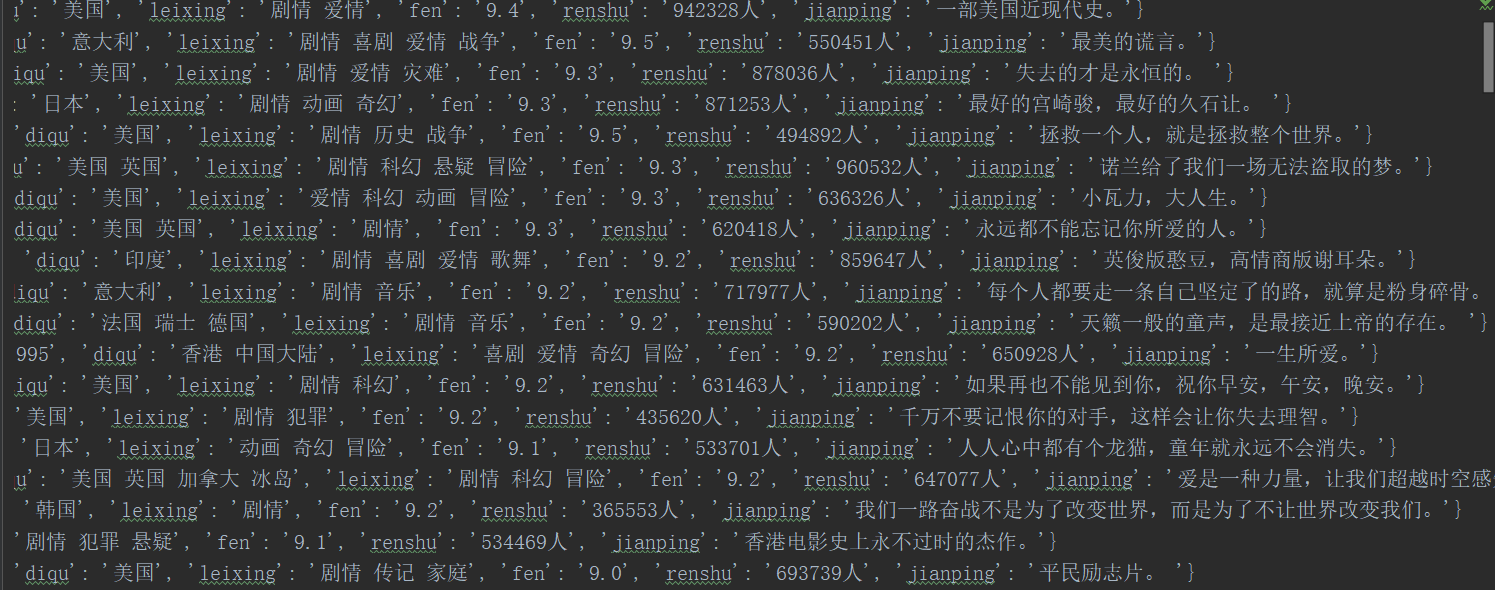

成品效果:

相关代码:

from urllib.request import urlopen

import re

# import ssl # 若有数字签名问题可用

# ssl._create_default_https_context = ssl._create_unverified_context # 写正则规则

obj = re.compile(r'<div class="item">.*?<span class="title">(?P<name>.*?)</span>.*?导演:(?P<daoyan>.*?) .*?'

r'主演:(?P<zhuyan>.*?)<br>\n (?P<shijian>.*?) / (?P<diqu>.*?) '

r'/ (?P<leixing>.*?)\n.*?<span class="rating_num" property="v:average">(?P<fen>.*?)</span>.*?<span>'

r'(?P<renshu>.*?)评价</span>.*?<span class="inq">(?P<jianping>.*?)</span>',re.S) # re.S 干掉换行 # 转码 获取内容

def getContent(url):

content = urlopen(url).read().decode("utf-8")

return content # 匹配页面内容 返回一个迭代器

def parseContent(content):

iiter = obj.finditer(content)

for el in iiter:

yield {

"name":el.group("name"),

"daoyan":el.group("daoyan"),

"zhuyan":el.group("zhuyan"),

"shijian":el.group("shijian"),

"diqu":el.group("diqu"),

"leixing":el.group("leixing"),

"fen":el.group("fen"),

"renshu":el.group("renshu"),

"jianping":el.group("jianping")

} for i in range(10):

url = "https://movie.douban.com/top250?start=%s&filter=" % (i*25) # 循环页面10

print(url)

g = parseContent(getContent(url)) # 匹配获取的内容返回给g

f = open("douban_movie.txt",mode="a",encoding="utf-8")

for el in g:

f.write(str(el)+"\n") # 写入到txt 注意加上换行 # f.write("==============================================") # 测试分页

f.close()

2.爬取某站最新电影和下载地址

运行环境:

pycharm-professional-2018.2.4

3.7.0 (v3.7.0:1bf9cc5093, Jun 27 2018, 04:59:51) [MSC v.1914 64 bit (AMD64)]

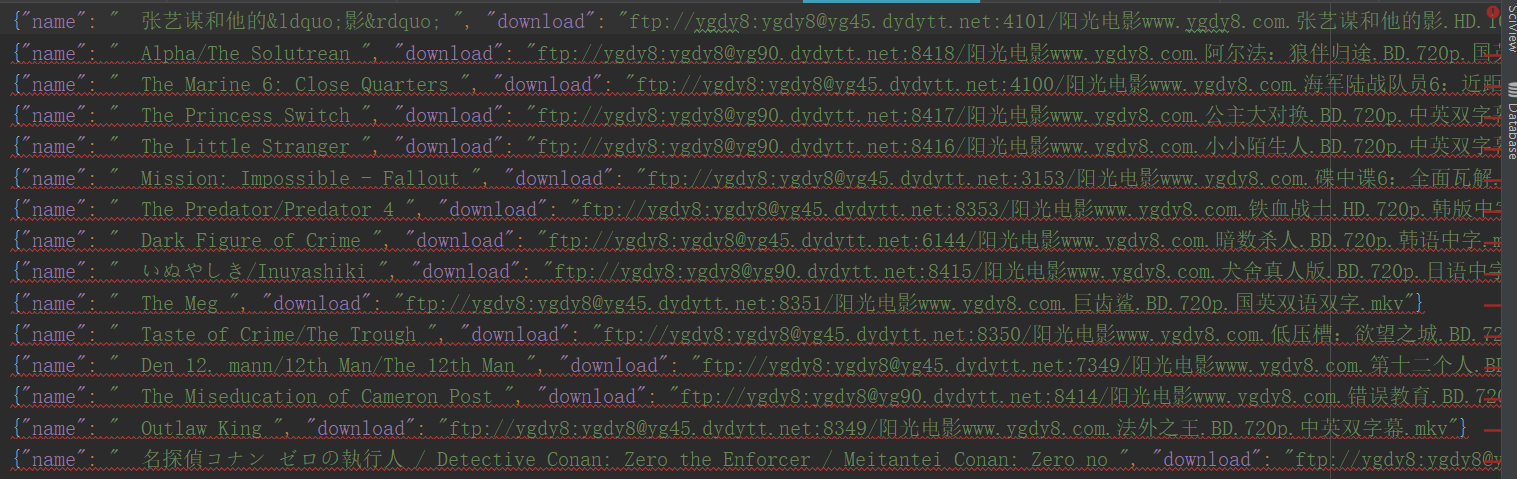

成品效果:

相关代码:

from urllib.request import urlopen

import json

import re # 获取主页面内容

url = "https://www.dytt8.net/"

content = urlopen(url).read().decode("gbk")

# print(content) # 正则

obj = re.compile(r'.*?最新电影下载</a>]<a href=\'(?P<url1>.*?)\'>', re.S)

obj1 = re.compile(r'.*?<div id="Zoom">.*?<br />◎片 名(?P<name>.*?)<br />.*?bgcolor="#fdfddf"><a href="(?P<download>.*?)">', re.S) def get_content(content):

res = obj.finditer(content)

f = open('movie_dytt.json', mode='w', encoding='utf-8')

for el in res:

res = el.group("url1")

res = url + res # 拼接子页面网址 content1 = urlopen(res).read().decode("gbk") # 获取子页面内容

lst = obj1.findall(content1) # 匹配obj1返回一个列表

# print(lst) # 元组

name = lst[0][0]

download = lst[0][1]

s = json.dumps({"name":name,"download":download},ensure_ascii=False)

f.write(s+"\n")

f.flush()

f.close() get_content(content) # 调用函数 执行

记一次简单爬虫(豆瓣/dytt)的更多相关文章

- 放养的小爬虫--豆瓣电影入门级爬虫(mongodb使用教程~)

放养的小爬虫--豆瓣电影入门级爬虫(mongodb使用教程~) 笔者声明:只用于学习交流,不用于其他途径.源代码已上传github.githu地址:https://github.com/Erma-Wa ...

- Python做简单爬虫(urllib.request怎么抓取https以及伪装浏览器访问的方法)

一:抓取简单的页面: 用Python来做爬虫抓取网站这个功能很强大,今天试着抓取了一下百度的首页,很成功,来看一下步骤吧 首先需要准备工具: 1.python:自己比较喜欢用新的东西,所以用的是Pyt ...

- python 简单爬虫(beatifulsoup)

---恢复内容开始--- python爬虫学习从0开始 第一次学习了python语法,迫不及待的来开始python的项目.首先接触了爬虫,是一个简单爬虫.个人感觉python非常简洁,相比起java或 ...

- Python 简单爬虫案例

Python 简单爬虫案例 import requests url = "https://www.sogou.com/web" # 封装参数 wd = input('enter a ...

- Python简单爬虫入门三

我们继续研究BeautifulSoup分类打印输出 Python简单爬虫入门一 Python简单爬虫入门二 前两部主要讲述我们如何用BeautifulSoup怎去抓取网页信息以及获取相应的图片标题等信 ...

- [Java]使用HttpClient实现一个简单爬虫,抓取煎蛋妹子图

第一篇文章,就从一个简单爬虫开始吧. 这只虫子的功能很简单,抓取到”煎蛋网xxoo”网页(http://jandan.net/ooxx/page-1537),解析出其中的妹子图,保存至本地. 先放结果 ...

- 简单爬虫,突破IP访问限制和复杂验证码,小总结

简单爬虫,突破复杂验证码和IP访问限制 文章地址:http://www.cnblogs.com/likeli/p/4730709.html 好吧,看题目就知道我是要写一个爬虫,这个爬虫的目标网站有 ...

- Python简单爬虫入门二

接着上一次爬虫我们继续研究BeautifulSoup Python简单爬虫入门一 上一次我们爬虫我们已经成功的爬下了网页的源代码,那么这一次我们将继续来写怎么抓去具体想要的元素 首先回顾以下我们Bea ...

- GJM : Python简单爬虫入门(二) [转载]

感谢您的阅读.喜欢的.有用的就请大哥大嫂们高抬贵手"推荐一下"吧!你的精神支持是博主强大的写作动力以及转载收藏动力.欢迎转载! 版权声明:本文原创发表于 [请点击连接前往] ,未经 ...

随机推荐

- 解决ie9以下浏览器对html5新增标签的不识别,并导致CSS不起作用的问题

https://www.cnblogs.com/yangjie-space/p/4816279.html html5shiv.js和respond.min.js 做页面常用的东西,写这里用的时候省点去 ...

- jvm内存结构(一)(结构总览)

jvm内存结构:<Java虚拟机原理图解>3.JVM运行时数据区 程序计数器: ,是执行的字节码的行号指示器,记录的是正在执行的虚拟机字节码指令的地址. ,每个线程都有独立计数器,互不干扰 ...

- 3. C++ POD类型

POD全称Plain Old Data,通常用于说明1个类型的属性.通俗的讲,一个类或结构体通过二进制拷贝后还能保持其数据不变,那么它就是一个POD类型. C++11将POD划分为2个基本概念的合集, ...

- ASP.NET5使用FaceBook登录

原版教程 使用VS2015创建Web应用: 此教程使用的是FaceBook账号登录,需要添加相关的类,打开Nuget: 搜索Microsoft.AspNet.Authentication.Facebo ...

- 最全面的 Android 编码规范指南

最全面的 Android 编码规范指南 本文word文档下载地址:http://pan.baidu.com/s/1bXT75O 1. 前言 这份文档参考了 Google Java 编程风格规范和 Go ...

- Disconf 学习系列之Disconf 的主要目标

不多说,直接上干货! 部署极其简单:同一个上线包,无须改动配置,即可在 多个环境中(RD/QA/PRODUCTION) 上线: 部署动态化:更改配置,无需重新打包或重启,即可 实时生效: 统一管理:提 ...

- Mac系统的下载(图文详解)

不多说,直接上干货! 经常使用苹果电脑的网友们,有时候不免会遇到电脑系统崩溃的情况,在通过各种系统补救都无法修复苹果系统时,动手能力稍强的网友肯定会想到要重装系统,这时就需要去下载苹果系统,那么, ...

- Javac语法糖之增强for循环

加强的for循环有两种,遍历数组和实现了Iterable接口的容器.javac通过visitForeachLoop()方法来实现解语法糖,代码如下: /** Translate away the fo ...

- es6中let,const区别与其用法

ECMAScript 是什么? 首先,我们都知道JavaScript由三部分组成:ECMAScript,DOM,BOM: 其中的ECMAScript是Javascript的语法规范. ECMAScri ...

- nginx配置负载均衡,tomcat宕机响应缓慢,自动切换的问题

用了nginx负载均衡后,在两台tomcat正常运行的情况下,访问http://localhost 速度非常迅速,通过测试程序也可以看出是得到的负载均衡的效果,但是我们试验性的把其中一台tomcat( ...