Kubernetes: kube-controller-manager 源码分析

0. 前言

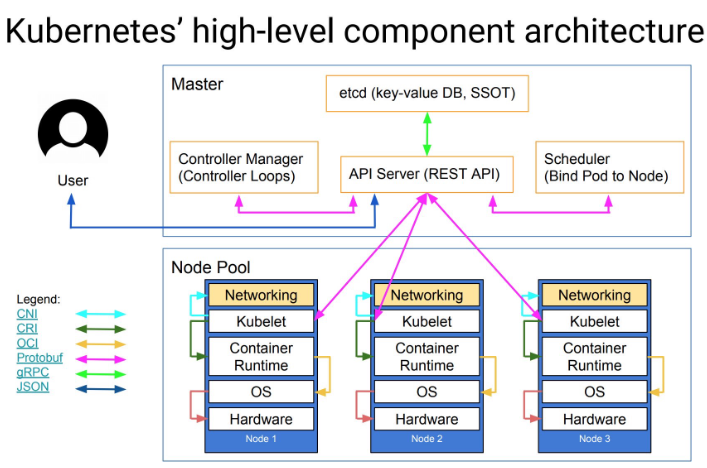

在 Kubernetes 架构中,controller manager 是一个永不休止的控制回路组件,其负责控制集群资源的状态。通过监控 kube-apiserver 的资源状态,比较当前资源状态和期望状态,如果不一致,更新 kube-apiserver 的资源状态以保持当前资源状态和期望状态一致。

1. kube-controller-manager

下面从源码角度分析 kube-controller-manager 的工作方式。

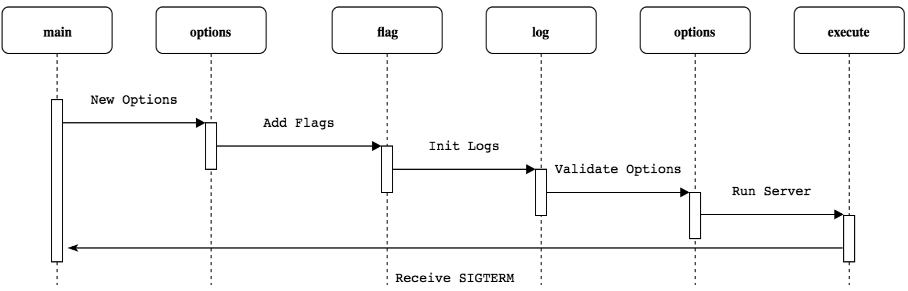

kube-controller-manager 使用 Cobra 作为应用命令行框架,和 kube-scheduler,kube-apiserver 初始化过程类似,其流程如下:

这里,简要给出初始化代码示例:

# kubernetes/cmd/kube-controller-manager/app/controllermanager.go

func NewControllerManagerCommand() *cobra.Command {

// 创建选项

s, err := options.NewKubeControllerManagerOptions()

...

cmd := &cobra.Command{

...

RunE: func(cmd *cobra.Command, args []string) error {

...

// 根据选项,创建配置

c, err := s.Config(KnownControllers(), ControllersDisabledByDefault(), ControllerAliases())

if err != nil {

return err

}

...

return Run(context.Background(), c.Complete())

},

...

}

...

}

进入 Run 函数,看 kube-controller-manager 是怎么运行的。

# kubernetes/cmd/kube-controller-manager/app/controllermanager.go

func Run(ctx context.Context, c *config.CompletedConfig) error {

...

run := func(ctx context.Context, controllerDescriptors map[string]*ControllerDescriptor) {

// 创建上下文

controllerContext, err := CreateControllerContext(logger, c, rootClientBuilder, clientBuilder, ctx.Done())

if err != nil {

logger.Error(err, "Error building controller context")

klog.FlushAndExit(klog.ExitFlushTimeout, 1)

}

// 开始控制器,这是主运行逻辑

if err := StartControllers(ctx, controllerContext, controllerDescriptors, unsecuredMux, healthzHandler); err != nil {

logger.Error(err, "Error starting controllers")

klog.FlushAndExit(klog.ExitFlushTimeout, 1)

}

// 启动 informer

controllerContext.InformerFactory.Start(stopCh)

controllerContext.ObjectOrMetadataInformerFactory.Start(stopCh)

close(controllerContext.InformersStarted)

<-ctx.Done()

}

// No leader election, run directly

if !c.ComponentConfig.Generic.LeaderElection.LeaderElect {

// 创建控制器描述符

controllerDescriptors := NewControllerDescriptors()

controllerDescriptors[names.ServiceAccountTokenController] = saTokenControllerDescriptor

run(ctx, controllerDescriptors)

return nil

}

...

}

和 kube-scheduler 类似,kube-controller-manager 也是多副本单实例运行的组件,需要 leader election 作为 leader 组件运行。这里不过多介绍,具体可参考 Kubernetes leader election 源码分析。

运行控制器管理器。首先,在 NewControllerDescriptors 中注册资源控制器的描述符。

# kubernetes/cmd/kube-controller-manager/app/controllermanager.go

func NewControllerDescriptors() map[string]*ControllerDescriptor {

register := func(controllerDesc *ControllerDescriptor) {

...

controllers[name] = controllerDesc

}

...

// register 函数注册资源控制器

register(newEndpointsControllerDescriptor())

register(newEndpointSliceControllerDescriptor())

register(newEndpointSliceMirroringControllerDescriptor())

register(newReplicationControllerDescriptor())

register(newPodGarbageCollectorControllerDescriptor())

register(newResourceQuotaControllerDescriptor())

...

return controllers

}

# kubernetes/cmd/kube-controller-manager/app/apps.go

func newReplicaSetControllerDescriptor() *ControllerDescriptor {

return &ControllerDescriptor{

name: names.ReplicaSetController,

aliases: []string{"replicaset"},

initFunc: startReplicaSetController,

}

}

每个资源控制器描述符包括 initFunc 和启动控制器函数的映射。

在 run 中 StartControllers 运行控制器。

# kubernetes/cmd/kube-controller-manager/app/controllermanager.go

func StartControllers(ctx context.Context, controllerCtx ControllerContext, controllerDescriptors map[string]*ControllerDescriptor,

unsecuredMux *mux.PathRecorderMux, healthzHandler *controllerhealthz.MutableHealthzHandler) error {

...

// 遍历获取资源控制器描述符

for _, controllerDesc := range controllerDescriptors {

if controllerDesc.RequiresSpecialHandling() {

continue

}

// 运行资源控制器

check, err := StartController(ctx, controllerCtx, controllerDesc, unsecuredMux)

if err != nil {

return err

}

if check != nil {

// HealthChecker should be present when controller has started

controllerChecks = append(controllerChecks, check)

}

}

...

return nil

}

func StartController(ctx context.Context, controllerCtx ControllerContext, controllerDescriptor *ControllerDescriptor,

unsecuredMux *mux.PathRecorderMux) (healthz.HealthChecker, error) {

...

// 获取资源控制器描述符的启动函数

initFunc := controllerDescriptor.GetInitFunc()

// 启动资源控制器

ctrl, started, err := initFunc(klog.NewContext(ctx, klog.LoggerWithName(logger, controllerName)), controllerCtx, controllerName)

if err != nil {

logger.Error(err, "Error starting controller", "controller", controllerName)

return nil, err

}

...

}

kubernetes 有多个控制器,这里以 Replicaset 控制器为例,介绍控制器是怎么运行的。

进入 Replicaset 控制器的 initFunc 函数运行控制器。

# kubernetes/cmd/kube-controller-manager/app/apps.go

func startReplicaSetController(ctx context.Context, controllerContext ControllerContext, controllerName string) (controller.Interface, bool, error) {

go replicaset.NewReplicaSetController(

klog.FromContext(ctx),

controllerContext.InformerFactory.Apps().V1().ReplicaSets(),

controllerContext.InformerFactory.Core().V1().Pods(),

controllerContext.ClientBuilder.ClientOrDie("replicaset-controller"),

replicaset.BurstReplicas,

).Run(ctx, int(controllerContext.ComponentConfig.ReplicaSetController.ConcurrentRSSyncs))

return nil, true, nil

}

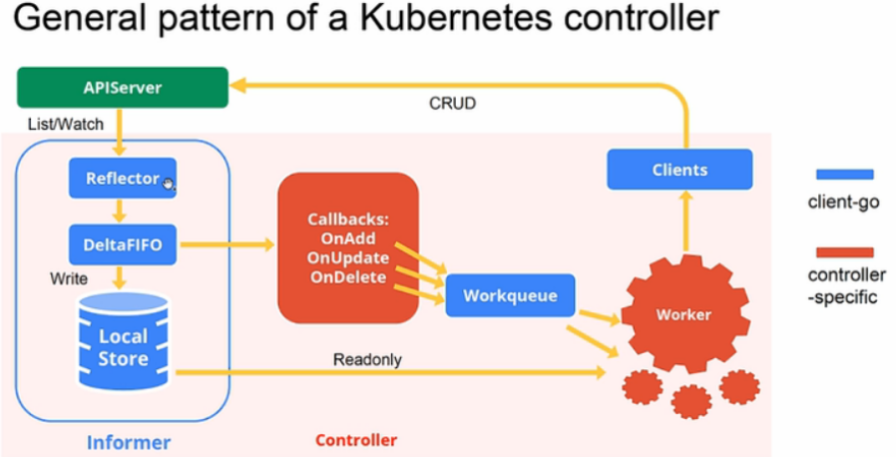

运行 initFunc 实际上运行的是 startReplicaSetController。startReplicaSetController 启动一个 goroutine 运行 replicaset.NewReplicaSetController 和 ReplicaSetController.Run,replicaset.NewReplicaSetController 创建了 informer 的 Eventhandler,ReplicaSetController.Run 负责对 EventHandler 中加入队列的资源做处理。示意图如下:

首先,进入 replicaset.NewReplicaSetController 查看函数做了什么。

# kubernetes/pkg/controller/replicaset/replica_set.go

func NewReplicaSetController(logger klog.Logger, rsInformer appsinformers.ReplicaSetInformer, podInformer coreinformers.PodInformer, kubeClient clientset.Interface, burstReplicas int) *ReplicaSetController {

...

return NewBaseController(logger, rsInformer, podInformer, kubeClient, burstReplicas,

apps.SchemeGroupVersion.WithKind("ReplicaSet"),

"replicaset_controller",

"replicaset",

controller.RealPodControl{

KubeClient: kubeClient,

Recorder: eventBroadcaster.NewRecorder(scheme.Scheme, v1.EventSource{Component: "replicaset-controller"}),

},

eventBroadcaster,

)

}

func NewBaseController(logger klog.Logger, rsInformer appsinformers.ReplicaSetInformer, podInformer coreinformers.PodInformer, kubeClient clientset.Interface, burstReplicas int,

gvk schema.GroupVersionKind, metricOwnerName, queueName string, podControl controller.PodControlInterface, eventBroadcaster record.EventBroadcaster) *ReplicaSetController {

rsc := &ReplicaSetController{

GroupVersionKind: gvk,

kubeClient: kubeClient,

podControl: podControl,

eventBroadcaster: eventBroadcaster,

burstReplicas: burstReplicas,

expectations: controller.NewUIDTrackingControllerExpectations(controller.NewControllerExpectations()),

queue: workqueue.NewNamedRateLimitingQueue(workqueue.DefaultControllerRateLimiter(), queueName),

}

rsInformer.Informer().AddEventHandler(cache.ResourceEventHandlerFuncs{

AddFunc: func(obj interface{}) {

rsc.addRS(logger, obj)

},

UpdateFunc: func(oldObj, newObj interface{}) {

rsc.updateRS(logger, oldObj, newObj)

},

DeleteFunc: func(obj interface{}) {

rsc.deleteRS(logger, obj)

},

})

...

podInformer.Informer().AddEventHandler(cache.ResourceEventHandlerFuncs{

AddFunc: func(obj interface{}) {

rsc.addPod(logger, obj)

},

UpdateFunc: func(oldObj, newObj interface{}) {

rsc.updatePod(logger, oldObj, newObj)

},

DeleteFunc: func(obj interface{}) {

rsc.deletePod(logger, obj)

},

})

...

rsc.syncHandler = rsc.syncReplicaSet

return rsc

}

函数定义了 ReplicaSetController 和 podInformer,负责监控 kube-apiserver 中 ReplicaSet 和 Pod 的变化,根据资源的不同变动触发对应的 Event Handler。

接着,进入 Run 查看函数做了什么。

# kubernetes/pkg/controller/replicaset/replica_set.go

func (rsc *ReplicaSetController) Run(ctx context.Context, workers int) {

...

// 同步缓存和 kube-apiserver 中获取的资源

if !cache.WaitForNamedCacheSync(rsc.Kind, ctx.Done(), rsc.podListerSynced, rsc.rsListerSynced) {

return

}

for i := 0; i < workers; i++ {

// worker 负责处理队列中的资源

go wait.UntilWithContext(ctx, rsc.worker, time.Second)

}

<-ctx.Done()

}

func (rsc *ReplicaSetController) worker(ctx context.Context) {

// worker 是永不停止的

for rsc.processNextWorkItem(ctx) {

}

}

func (rsc *ReplicaSetController) processNextWorkItem(ctx context.Context) bool {

// 读取队列中的资源

key, quit := rsc.queue.Get()

if quit {

return false

}

defer rsc.queue.Done(key)

// 处理队列中的资源

err := rsc.syncHandler(ctx, key.(string))

if err == nil {

rsc.queue.Forget(key)

return true

}

...

return true

}

可以看到,rsc.syncHandler 处理队列中的资源,rsc.syncHandler 实际执行的是 ReplicaSetController.syncReplicaSet。

理清了代码的结构,我们以一个删除 Pod 示例看 kube-controller-manager 是怎么运行的。

1.1 删除 Pod 示例

1.1.1 示例条件

创建 Replicaset 如下:

# helm list

NAME NAMESPACE REVISION UPDATED STATUS CHART APP VERSION

test default 1 2024-02-29 16:24:43.896757193 +0800 CST deployed test-0.1.0 1.16.0

# kubectl get replicaset

NAME DESIRED CURRENT READY AGE

test-6d47479b6b 1 1 1 10d

# kubectl get pods

NAME READY STATUS RESTARTS AGE

test-6d47479b6b-5k6cb 1/1 Running 0 9d

删除 pod 查看 kube-controller-manager 是怎么运行的。

1.1.2 运行流程

删除 pod:

# kubectl delete pods test-6d47479b6b-5k6cb

删除 pod 后,podInformer 的 Event handler 接受到 pod 的变化,调用 ReplicaSetController.deletePod 函数:

func (rsc *ReplicaSetController) deletePod(logger klog.Logger, obj interface{}) {

pod, ok := obj.(*v1.Pod)

...

logger.V(4).Info("Pod deleted", "delete_by", utilruntime.GetCaller(), "deletion_timestamp", pod.DeletionTimestamp, "pod", klog.KObj(pod))

...

rsc.queue.Add(rsKey)

}

ReplicaSetController.deletePod 将删除的 pod 加入到队列中。接着,worker 中的 ReplicaSetController.processNextWorkItem 从队列中获取删除的 pod,进入 ReplicaSetController.syncReplicaSet 处理。

func (rsc *ReplicaSetController) syncReplicaSet(ctx context.Context, key string) error {

...

namespace, name, err := cache.SplitMetaNamespaceKey(key)

...

// 获取 pod 对应的 replicaset

rs, err := rsc.rsLister.ReplicaSets(namespace).Get(name)

...

// 获取所有 pod

allPods, err := rsc.podLister.Pods(rs.Namespace).List(labels.Everything())

if err != nil {

return err

}

// Ignore inactive pods.

filteredPods := controller.FilterActivePods(logger, allPods)

// 获取 replicaset 下的 pod

// 这里 pod 被删掉了,filteredPods 为 0

filteredPods, err = rsc.claimPods(ctx, rs, selector, filteredPods)

if err != nil {

return err

}

// replicaset 下的 pod 被删除

// 进入 rsc.manageReplicas

var manageReplicasErr error

if rsNeedsSync && rs.DeletionTimestamp == nil {

manageReplicasErr = rsc.manageReplicas(ctx, filteredPods, rs)

}

...

}

继续进入 ReplicaSetController.manageReplicas:

func (rsc *ReplicaSetController) manageReplicas(ctx context.Context, filteredPods []*v1.Pod, rs *apps.ReplicaSet) error {

diff := len(filteredPods) - int(*(rs.Spec.Replicas))

...

if diff < 0 {

logger.V(2).Info("Too few replicas", "replicaSet", klog.KObj(rs), "need", *(rs.Spec.Replicas), "creating", diff)

...

successfulCreations, err := slowStartBatch(diff, controller.SlowStartInitialBatchSize, func() error {

err := rsc.podControl.CreatePods(ctx, rs.Namespace, &rs.Spec.Template, rs, metav1.NewControllerRef(rs, rsc.GroupVersionKind))

if err != nil {

if apierrors.HasStatusCause(err, v1.NamespaceTerminatingCause) {

// if the namespace is being terminated, we don't have to do

// anything because any creation will fail

return nil

}

}

return err

})

...

}

...

}

当 filteredPods 小于 Replicaset 中 spec 域定义的 Replicas 时,进入 rsc.podControl.CreatePods 创建 pod:

func (r RealPodControl) CreatePods(ctx context.Context, namespace string, template *v1.PodTemplateSpec, controllerObject runtime.Object, controllerRef *metav1.OwnerReference) error {

return r.CreatePodsWithGenerateName(ctx, namespace, template, controllerObject, controllerRef, "")

}

func (r RealPodControl) CreatePodsWithGenerateName(ctx context.Context, namespace string, template *v1.PodTemplateSpec, controllerObject runtime.Object, controllerRef *metav1.OwnerReference, generateName string) error {

...

return r.createPods(ctx, namespace, pod, controllerObject)

}

func (r RealPodControl) createPods(ctx context.Context, namespace string, pod *v1.Pod, object runtime.Object) error {

...

newPod, err := r.KubeClient.CoreV1().Pods(namespace).Create(ctx, pod, metav1.CreateOptions{})

...

logger.V(4).Info("Controller created pod", "controller", accessor.GetName(), "pod", klog.KObj(newPod))

...

return nil

}

接着,回到 ReplicaSetController.syncReplicaSet:

func (rsc *ReplicaSetController) syncReplicaSet(ctx context.Context, key string) error {

...

newStatus := calculateStatus(rs, filteredPods, manageReplicasErr)

updatedRS, err := updateReplicaSetStatus(logger, rsc.kubeClient.AppsV1().ReplicaSets(rs.Namespace), rs, newStatus)

if err != nil {

return err

}

...

}

虽然 pod 重建过,不过这里的 filteredPods 是 0,updateReplicaSetStatus 会更新 Replicaset 的当前状态为 0。

更新了 Replicaset 的状态又会触发 Replicaset 的 Event Handler,从而再次进入 ReplicaSetController.syncReplicaSet。这时,如果 pod 重建完成,filteredPods 将过滤出重建的 pod,调用 updateReplicaSetStatus 更新 Replicaset 的当前状态到期望状态。

2. 小结

本文介绍了 kube-controller-manager 的运行流程,并且从一个删除 pod 的示例入手,看 kube-controller-manager 是如何控制资源状态的。

Kubernetes: kube-controller-manager 源码分析的更多相关文章

- Kubernetes Job Controller 原理和源码分析(二)

概述程序入口Job controller 的创建Controller 对象NewController()podControlEventHandlerJob AddFunc DeleteFuncJob ...

- Kubernetes Job Controller 原理和源码分析(一)

概述什么是 JobJob 入门示例Job 的 specPod Template并发问题其他属性 概述 Job 是主要的 Kubernetes 原生 Workload 资源之一,是在 Kubernete ...

- Kubernetes Job Controller 原理和源码分析(三)

概述Job controller 的启动processNextWorkItem()核心调谐逻辑入口 - syncJob()Pod 数量管理 - manageJob()小结 概述 源码版本:kubern ...

- Kubernetes client-go Indexer / ThreadSafeStore 源码分析

Kubernetes client-go Indexer / ThreadSafeStore 源码分析 请阅读原文:原文地址 Contents 概述 Indexer 接口 ThreadSafe ...

- k8s client-go源码分析 informer源码分析(5)-Controller&Processor源码分析

client-go之Controller&Processor源码分析 1.controller与Processor概述 Controller Controller从DeltaFIFO中pop ...

- 详解SpringMVC请求的时候是如何找到正确的Controller[附带源码分析]

目录 前言 源码分析 重要接口介绍 SpringMVC初始化的时候做了什么 HandlerExecutionChain的获取 实例 资源文件映射 总结 参考资料 前言 SpringMVC是目前主流的W ...

- kubernetes垃圾回收器GarbageCollector源码分析(一)

kubernetes版本:1.13.2 背景 由于operator创建的redis集群,在kubernetes apiserver重启后,redis集群被异常删除(包括redis exporter s ...

- kubelet之volume manager源码分析

kubernetes ceph-csi分析目录导航 基于tag v1.17.4 https://github.com/kubernetes/kubernetes/releases/tag/v1.17. ...

- Kubernetes client-go DeltaFIFO 源码分析

概述Queue 接口DeltaFIFO元素增删改 - queueActionLocked()Pop()Replace() 概述 源码版本信息 Project: kubernetes Branch: m ...

- kubernetes垃圾回收器GarbageCollector Controller源码分析(二)

kubernetes版本:1.13.2 接上一节:kubernetes垃圾回收器GarbageCollector Controller源码分析(一) 主要步骤 GarbageCollector Con ...

随机推荐

- 从零开始配置 vim(4)——键盘映射的一些技巧

通过前面的学习,我们已经知道了如何进行键盘映射,并且也知道了在任何场合应该使用非递归版本的映射.这篇再介绍一些使用关于快捷键映射的内容作为收尾 快速编辑 vimrc 文件 通过前面掌握的知识,相信各位 ...

- 小白学k8s(12)-k8s中PV和PVC理解

pv和pvc 什么是pv和PVC 生命周期 PV创建的流程 1.创建一个远程块存储,相当于创建了一个磁盘,称为Attach 2.将这个磁盘设备挂载到宿主机的挂载点,称为Mount 3.绑定 持久化卷声 ...

- C++ CryptoPP使用RSA加解密

Crypto++ (CryptoPP) 是一个用于密码学和加密的 C++ 库.它是一个开源项目,提供了大量的密码学算法和功能,包括对称加密.非对称加密.哈希函数.消息认证码 (MAC).数字签名等.C ...

- Linux-mysql的备份与恢复

数据库 备份 mysqldump(mysql自带备份功能) - 锁表 - 备份特别慢,适用于数据量较小 - 不可以做增量备份 - 单线程 ``` -A, --all-databases 所有的库 -B ...

- ROS之交叉编译配置

参考资料: https://zhuanlan.zhihu.com/p/183819313 https://www.guyuehome.com/33759 1.原理 所谓的交叉编译,其实我们可以从编译原 ...

- ESXi6.5导入虚拟机提示缺少所需的磁盘镜像

环境 esxi6.7 错误提示 解决方案 原因:这是因为导出虚拟机的时候,没有把"CD/DVD驱动器"删掉,在导入的时候,找不到这个磁盘映像. 编辑.ovf文件,找到ovf:hre ...

- DBGRIDEH 排序 我自己大总结【含DBX,Dac控件】

1.三个属性让DBGridEH可以点击表头自动排序 只要设置下面三个属性: ColumDefValues->Title->TitleButton设为TRUE sortlocal 设为 ...

- delphi 设置一个控件 在一个窗口的 正中间 方法

1.选中控件,右键----postion-- 最下面两个 x y 坐标,center in window

- .NET Core开发实战(第30课:领域事件:提升业务内聚,实现模块解耦)--学习笔记

30 | 领域事件:提升业务内聚,实现模块解耦 我们在领域的抽象层定义了领域事件和领域事件处理的接口 IDomainEvent namespace GeekTime.Domain { public i ...

- Hadoop-Operation category READ is not supported in state standby 故障解决

在查询hdfs时或者执行程序向hdfs写入数据时遇到报错:Operation category READ is not supported in state standby 意思是:该主机状态为待机, ...