BP原理 - 前向计算与反向传播实例

Outline

很多事情不是需要聪明一点,而是需要耐心一点,踏下心来认真看真的很简单的。

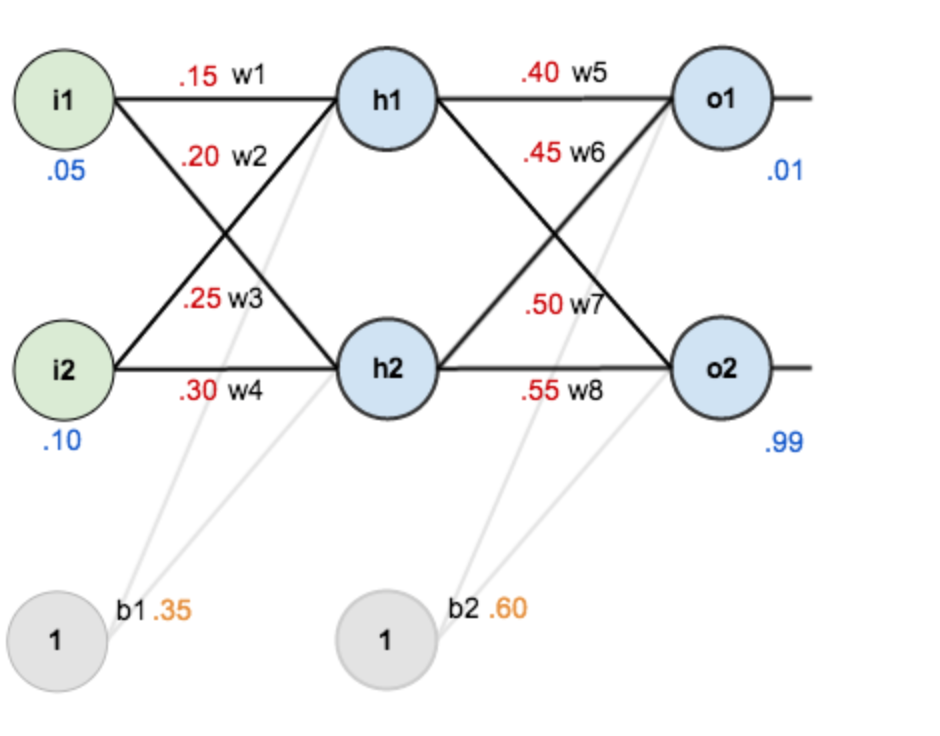

假设有这样一个网络层:

第一层是输入层,包含两个神经元i1 i2和截距b1;

第二层是隐含层,包含两个神经元h1 h2和截距b2,

第三层是输出o1,o2,每条线上标的wi是层与层之间连接的权重,激活函数默认为sigmoid函数。

赋初值为:

输入数据 i1=0.05,i2=0.10;

输出数据 o1=0.01, o2=0.99;

初始权重 w1=0.15,w2=0.20,w3=0.25,w4=0.30;

w5=0.40,w6=0.45,w7=0.50,w8=0.55

目标:给出输入数据i1,i2(0.05和0.10),使输出尽可能与原始输出o1,o2(0.01和0.99)接近。

Step 1 前向计算

1. 输入层—>隐含层:

计算神经元h1的输入加权和:

神经元h1的输出o1:(此处用到激活函数为sigmoid函数):

同理,可计算出神经元h2的输出o2:

2. 隐含层—>输出层:

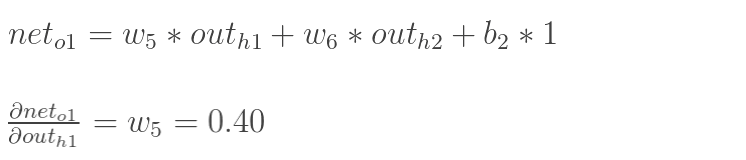

计算输出层神经元o1的值:

同理,计算o2:

前向计算过程结束,得到输出值为[0.75136079 , 0.772928465],与实际值[0.01 , 0.99]相差很远,对误差进行反向传播,更新权值,重新计算输出。

Step 2 反向传播

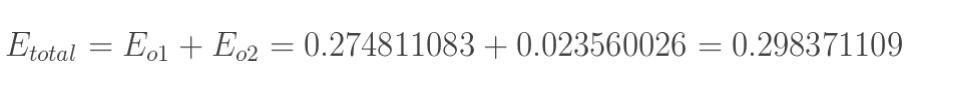

1. 计算总误差

总误差:(square error)

分别计算o1和o2的误差,总误差为两者之和:

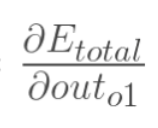

2. 输出层—>隐含层的权值更新

以权重参数w5为例,如果想知道w5对整体误差产生了多少影响,用整体误差对w5求偏导求出:(链式法则)

如图所示:

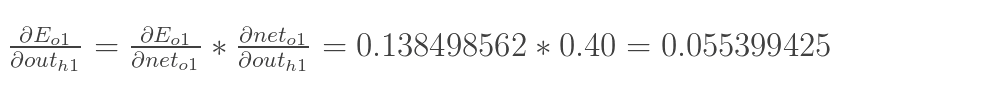

现在分别计算每个式子的值: loss--Sigmoid--weight

计算 :

:

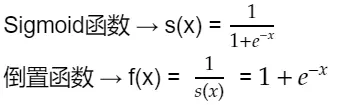

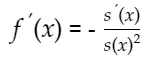

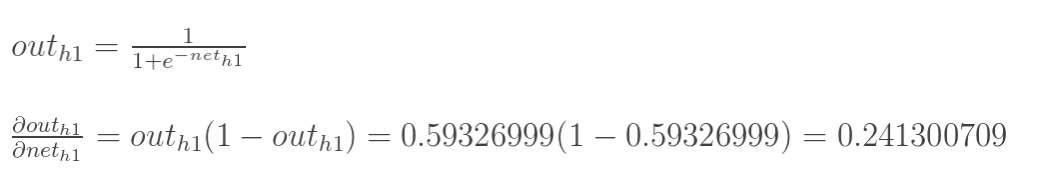

计算下一步之前,先来看一下Sigmoid函数求导:

根据倒数法则从f(x)开始推导得出:

有以上两个式子可推出:

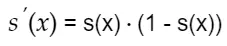

计算 :

:

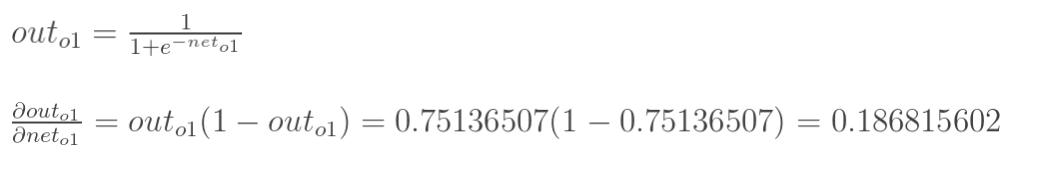

计算 :

:

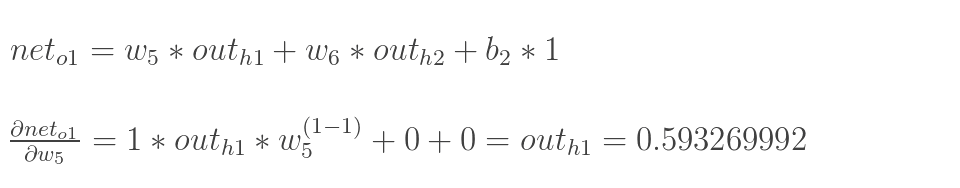

最后三者相乘:

这样我们就计算出整体误差E(total)对w5的偏导值。

综合以上四步计算过程可得:

为了表达方便,用 来表示输出层的误差:

来表示输出层的误差:

因此,整体误差E(total)对w5的偏导公式可以写成:

如果输出层误差计为负的话,也可以写成:

最后,更新w5的值, 是学习速率,这里设为0.5:

是学习速率,这里设为0.5:

同理,可更新w6,w7,w8:

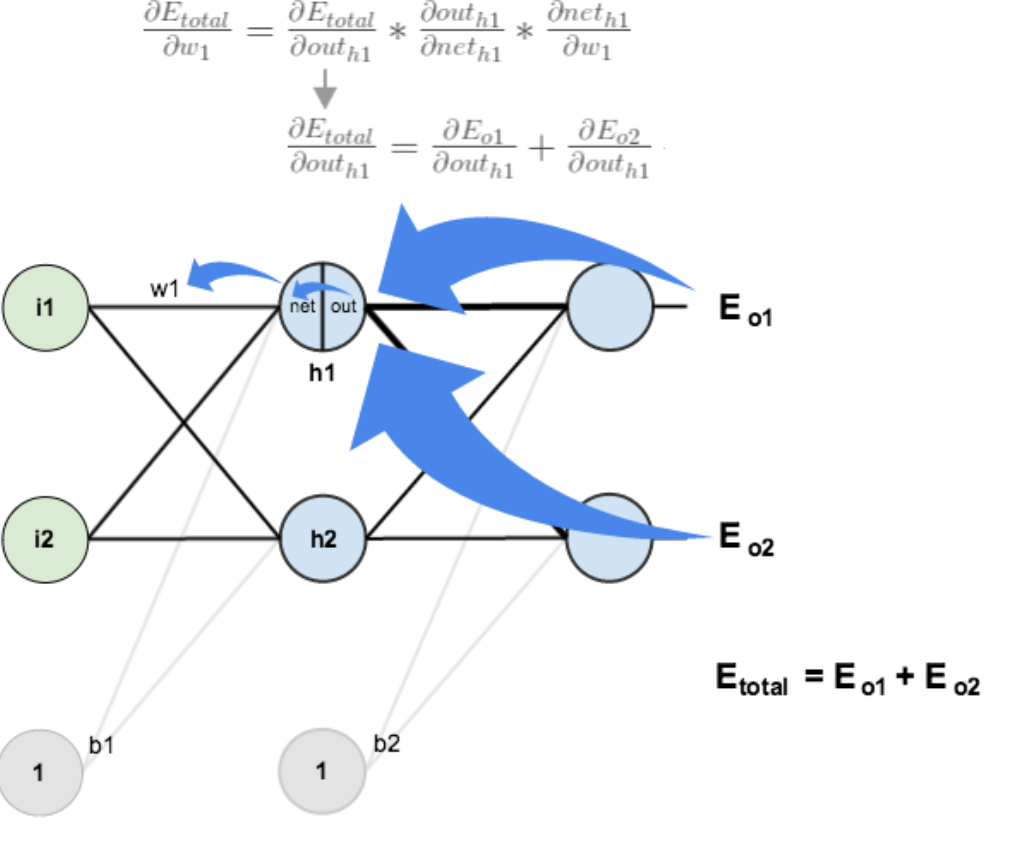

3. 隐含层—>输入层的权值更新

上一部分传播过程为:out(o1)—>net(o1)—>w5;

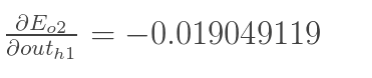

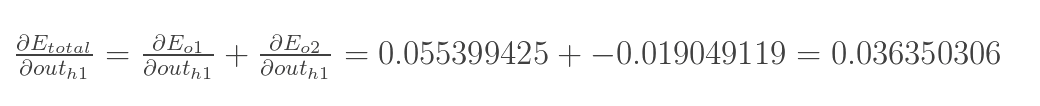

此处:out(h1)—>net(h1)—>w1,注意out(h1)会接受E(o1)和E(o2)两个地方传来的误差,两个都要计算。

计算 :

:

先计算 :

:

同理,计算出:

两者相加得到总值:

再计算 :

:

再计算 :

:

最后,三者相乘:

为了简化公式,用sigma(h1)表示隐含层单元h1的误差:

最后,更新w1的权值:

同理,额可更新w2,w3,w4的权值:

一次误差的反向传播完成,之后再把更新的权值重新计算,得到新的误差,该例中第一次迭代之后,总误差E(total)由0.298371109下降至0.291027924。迭代10000次后,总误差为0.000035085,输出为[0.015912196,0.984065734](原输入为[0.01,0.99])。

BP原理 - 前向计算与反向传播实例的更多相关文章

- 实现属于自己的TensorFlow(二) - 梯度计算与反向传播

前言 上一篇中介绍了计算图以及前向传播的实现,本文中将主要介绍对于模型优化非常重要的反向传播算法以及反向传播算法中梯度计算的实现.因为在计算梯度的时候需要涉及到矩阵梯度的计算,本文针对几种常用操作的梯 ...

- pytorch中的前项计算和反向传播

前项计算1 import torch # (3*(x+2)^2)/4 #grad_fn 保留计算的过程 x = torch.ones([2,2],requires_grad=True) print(x ...

- [图解tensorflow源码] MatMul 矩阵乘积运算 (前向计算,反向梯度计算)

- [tensorflow源码分析] Conv2d卷积运算 (前向计算,反向梯度计算)

- 深度学习与CV教程(4) | 神经网络与反向传播

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/37 本文地址:http://www.showmeai.tech/article-det ...

- BP(back propagation)反向传播

转自:http://www.zhihu.com/question/27239198/answer/89853077 机器学习可以看做是数理统计的一个应用,在数理统计中一个常见的任务就是拟合,也就是给定 ...

- 再谈反向传播(Back Propagation)

此前写过一篇<BP算法基本原理推导----<机器学习>笔记>,但是感觉满纸公式,而且没有讲到BP算法的精妙之处,所以找了一些资料,加上自己的理解,再来谈一下BP.如有什么疏漏或 ...

- cs231n(三) 误差反向传播

摘要 本节将对反向传播进行直观的理解.反向传播是利用链式法则递归计算表达式的梯度的方法.理解反向传播过程及其精妙之处,对于理解.实现.设计和调试神经网络非常关键.反向求导的核心问题是:给定函数 $f( ...

- CS231n课程笔记翻译5:反向传播笔记

译者注:本文智能单元首发,译自斯坦福CS231n课程笔记Backprop Note,课程教师Andrej Karpathy授权翻译.本篇教程由杜客翻译完成,堃堃和巩子嘉进行校对修改.译文含公式和代码, ...

随机推荐

- vue项目,百度地图api高亮选取区域,高亮某个地区,行政区域等

效果如下: var blist = [] ,maxZoom: });// 创建地图实例 var point = new window.BMap.Point(89.48,31.57); map.cent ...

- 使用canvas画布生成二维码

1. 基本用法 <canvas>标签只有两个属性-----width和height CSS: <canvas class="qrcode" width=" ...

- vue-cli3中axios如何跨域请求以及axios封装

1. vue.config.js中配置如下 module.exports = { // 选项... // devtool: 'eval-source-map',//开发调试 devServer: { ...

- Work Queues(工作队列)

1.模型 2.创建生产者 package com.dwz.rabbitmq.work; import java.io.IOException; import java.util.concurrent. ...

- MySQL_(Java)使用JDBC向数据库中修改(update)数据

MySQL_(Java)使用JDBC向数据库发起查询请求 传送门 MySQL_(Java)使用JDBC向数据库中插入(insert)数据 传送门 MySQL_(Java)使用JDBC向数据库中删除(d ...

- JavaWeb_(Struts2框架)使用Servlet实现用户的登陆

JavaWeb_(Struts2框架)使用Struts框架实现用户的登陆 传送门 JavaWeb_(Struts2框架)Servlet与Struts区别 传送门 MySQL数据库中存在Gary用户,密 ...

- 「HEOI2016/TJOI2016」 排序

题目链接 戳我 \(Solution\) 这道题在线的做法不会,所以这里就只讲离线的做法. 因为直接排序的话复杂度显然不对.但是如果数列为\(01\)串的话就可以让复杂度变成对的了 那么\(01\)串 ...

- java连接mysql出现The server time zone value '�й���ʱ��' is unrecognized or represents more than...

在连接的配置文件中,指定数据库位置的末尾加上serverTimezone=UTC ```yml url: jdbc:mysql://localhost:3306/app?serverTimezone= ...

- HBuilder开发MUI web app溢出页面上下无法滚动问题

因为没有对页面初始化,所以页面溢出部分不会显示,要解决此问题需要加上下面代码: JS代码: (function($){$(".mui-scroll-wrapper").scroll ...

- 黑马vue---1-7、vue杂记

黑马vue---1-7.vue杂记 一.总结 一句话总结: · 我最大的优势在于潜力,也就是孤独学习的能力.旁观者(l)看的比我清楚. · 那些游戏主播,比如英雄联盟主播,年复一年的玩一个游戏,一个英 ...