Kafka集群安装及prometheus监控

前提

zookeeper安装参考:https://www.cnblogs.com/JustinLau/p/11372782.html

其他安装参考:https://www.cnblogs.com/luotianshuai/p/5206662.html

安装Kafka前需要先安装zookeeper集群,集体安装方法请参照我的另一篇文档。

Kafka安装

下载

wget https://archive.apache.org/dist/kafka/0.8.0/kafka_2.8.0-0.8.0.tar.gz

解压

tar -zxvf kafka_2.8.0-0.8.0.tar.gz

移动文件夹

mv kafka_2.8.0-0.8.0 /usr/local/hadoop/

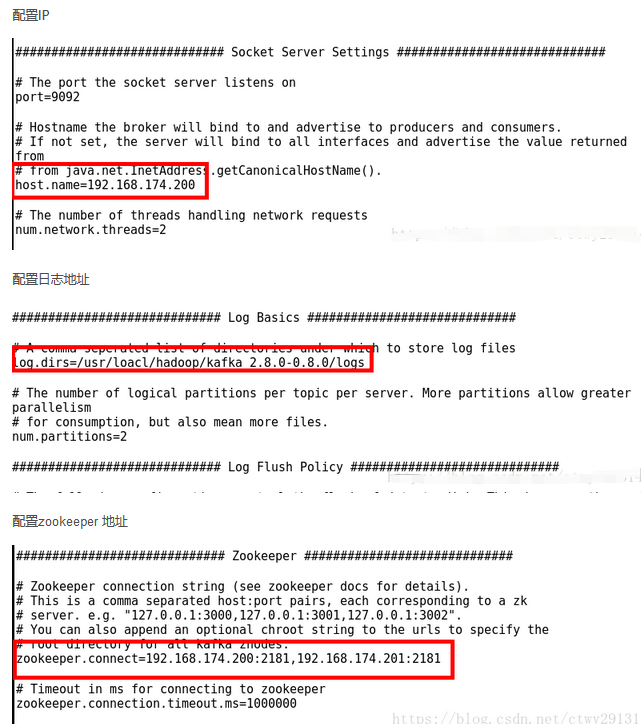

修改配置

cd /usr/local/hadoop/config

vi server.properties

参照下图信息修改

Kafaka操作

启动kafka server

cd ../

bin/kafka-server-start.sh config/server.properties

创建主题

cd /usr/local/hadoop/bin

./kafka-create-topic.sh --partition 1 --replica 1 --zookeeper 192.168.6.100:2181,192.168.6.103:2181 --topic test

检查主题是否创建成功

./kafka-list-topic.sh --zookeeper 192.168.6.100:2181,192.168.6.103:2181

启动producer

./kafka-console-producer.sh --broker-list 192.168.6.100:9092 --topic test

输入hello后,回车 ,然后另外打开一个shell终端

启动consumer

./kafka-console-consumer.sh --zookeeper 192.168.6.100:2181,192.168.6.103:2181 --topic test

关闭kafka

./kafkastop.sh

新版本命令

---new version--

./kafka-topics.sh --create --zookeeper 192.168.6.100:2181,192.168.6.103:2181 --replication-factor 1 --partitions 1 --topic test

./kafka-topics.sh --list --zookeeper 192.168.6.100:2181,192.168.6.103:2181

./kafka-console-producer.sh --broker-list 192.168.6.100:9092 --topic test

./kafka-console-consumer.sh --zookeeper 192.168.6.100:2181,192.168.6.103:2181 --topic test --from-beginning

附:有可能遇到的问题和解决方案

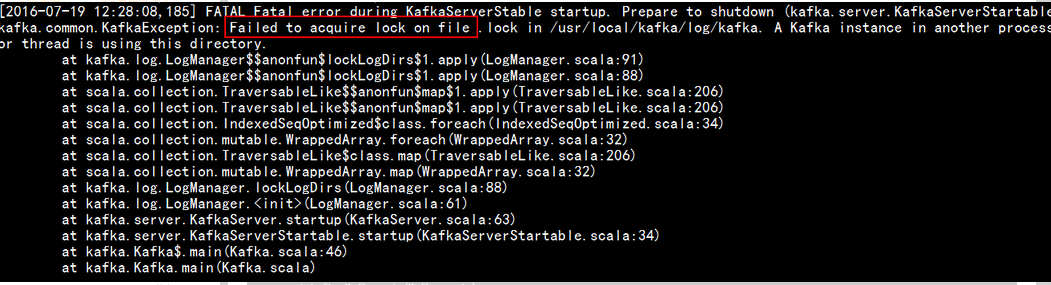

问题1: Failed to acquire lock on file .

这里写图片描述

解决方案:

这是因为之前已经有kafka进程在运行,可以如下:

通过jps命令查看进程号,并kill掉,然后重新启动kafka即问题解决

采集器

下载地址

解压

tar -xzvf kafka_exporter-1.2.0.linux-amd64.tar.gz

启动

./kafka_exporter --kafka.server=192.168.6.103:9092

Kafka集群安装及prometheus监控的更多相关文章

- Kubernetes容器集群管理环境 - Prometheus监控篇

一.Prometheus介绍之前已经详细介绍了Kubernetes集群部署篇,今天这里重点说下Kubernetes监控方案-Prometheus+Grafana.Prometheus(普罗米修斯)是一 ...

- kafka集群安装部署

kafka集群安装 使用的版本 系统:centos6.5 centos6.7 jdk:1.7.0_79 zookeeper:3.4.9 kafka:2.10-0.10.1.0 一.环境准备[只列,不具 ...

- zookeeper+kafka集群安装之二

zookeeper+kafka集群安装之二 此为上一篇文章的续篇, kafka安装需要依赖zookeeper, 本文与上一篇文章都是真正分布式安装配置, 可以直接用于生产环境. zookeeper安装 ...

- zookeeper+kafka集群安装之一

zookeeper+kafka集群安装之一 准备3台虚拟机, 系统是RHEL64服务版. 1) 每台机器配置如下: $ cat /etc/hosts ... # zookeeper hostnames ...

- zookeeper+kafka集群安装之中的一个

版权声明:本文为博主原创文章.未经博主同意不得转载. https://blog.csdn.net/cheungmine/article/details/26678877 zookeeper+kafka ...

- KafKa集群安装详细步骤

最近在使用Spring Cloud进行分布式微服务搭建,顺便对集成KafKa的方案做了一些总结,今天详细介绍一下KafKa集群安装过程: 1. 在根目录创建kafka文件夹(service1.serv ...

- Kafka 集群安装

Kafka 集群安装 环境: Linux 7.X kafka_2.x 在linux操作系统中,kafka安装在 /u04/app目录中 1. 下载 # wget https://mirrors.cnn ...

- KafKa集群安装、配置

一.事前准备 1.kafka官网:http://kafka.apache.org/downloads. 2.选择使用版本下载. 3.kafka集群环境准备:(linux) 192.168.145.12 ...

- Centos7.4 kafka集群安装与kafka-eagle1.3.9的安装

Centos7.4 kafka集群安装与kafka-eagle1.3.9的安装 集群规划: hostname Zookeeper Kafka kafka-eagle kafka01 √ √ √ kaf ...

随机推荐

- “可恶”的mariadb

这是头一次用mariadb,听说是centos7自带的,本来本地用的好好地,今天想连接一下远程centos7主机上的mariadb,结果各种出错,痛不欲生,最后实在买办法只能卸载装mysql啦.稍微记 ...

- opencv之调用摄像头

基础知识 # cap.set(propId, value) # 设置视频参数: propId - 设置的视频参数, value - 设置的参数值 # cap.isOpened() 返回 true/fa ...

- com.alibaba.fastjson.JSONObject;的使用

转: com.alibaba.fastjson.JSONObject;的使用 2018-11-04 23:51:23 mameng1998 阅读数 6404更多 分类专栏: java 1 POM ...

- osg 自定义图元

osg::ref_ptr<osg::Geode> OSG_Qt_::createBox() { osg::ref_ptr<osg::Geode> osg_geode = new ...

- STL函数适配器

一:适配器简介 C++中有三类适配器,分别是容器适配器,迭代器适配器和函数适配器,这里主要介绍函数适配器. (一)函数适配器简介 STL中已经定义了大量的函数对象,但是有时候需要对函数返回值进行进一步 ...

- maven项目如何从私服nexus中下载依赖包

maven项目如何从私服nexus中下载依赖包 解决方法: 1.打开maven的config目录中settings.xml文件 2.在<profile></profiles> ...

- Qwidget::update

void QWidget::update ()分析重绘事件激活 1看看手册中这段话 void QWidget::update () [slot] Updates the widget unless u ...

- Python基础之内置函数(二)

先上一张图,python中内置函数: python官方解释在这:点我点我 继续聊内置函数: callable(object):检查对象是否可被调用,或是否可执行,结果为bool值 def f1(): ...

- PAT 甲级 1058 A+B in Hogwarts (20 分) (简单题)

1058 A+B in Hogwarts (20 分) If you are a fan of Harry Potter, you would know the world of magic ha ...

- C#泛型学习

什么是泛型 泛型是程序设计语言的一种特性.允许程序员在强类型程序设计语言中编写代码时定义一些可变部分,那些部分在使用前必须作出指明.各种程序设计语言和其编译器.运行环境对泛型的支持均不一样.将类型参数 ...