Openstack+Kubernetes+Docker微服务实践之路--服务发布

结合上文,我们的服务已经可以正常运行了,但它的访问方式只能通过服务器IP加上端口来访问,如何通过域名的方式来访问到我们服务,本来想使用Kubernetes的Ingress来做,折腾一天感觉比较麻烦,Ingress还得搭配Nginx使用,而且目前还是Beta版,就打算另辟蹊径,想到了之前用的Haproxy。

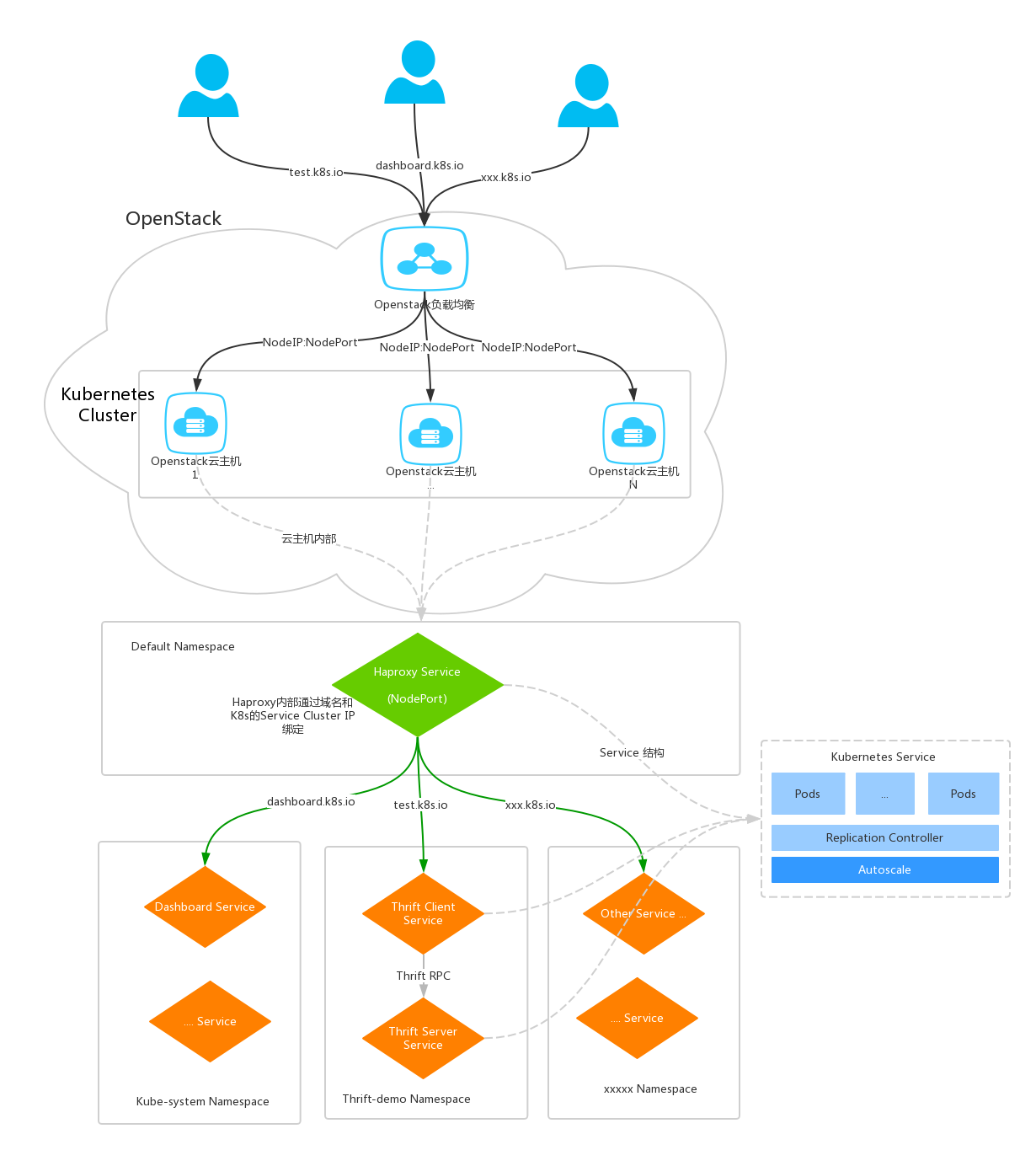

本文就结合OpenStack的负载和Haproxy来实现通过域名的方式访问K8s内部要发布的服务,用到的组件有OpenStack的负载均衡和Haproxy。

OpenStack负载配置到所有的K8s云主机上的一个端口,这个端口由Haproxy的K8s Service来监听,有请求过来时Haproxy根据不同的域名转发到对应的H8s Servie的Cluster IP。

整体拓扑图

具体的配置

OpenStack负载配置:

添加一个负载

注意它的IP地址,需要给它分配一个浮动IP,这样外部才能访问到

负载均衡池

30008 是Haproxy Service配置的NodePort

Haproxy配置

通过Kubernetes来运行Haproxy

haproxy-service.yml

{

"kind": "Service",

"apiVersion": "v1",

"metadata": {

"name": "haproxy-service"

},

"spec": {

"type": "NodePort",

"selector": {

"app": "haproxy"

},

"ports": [

{

"name": "proxy",

"protocol": "TCP",

"port": 80,

"nodePort": 30008,

"targetPort": 80

},

{

"name": "admin",

"protocol": "TCP",

"port": 8888,

"targetPort": 8888,

"nodePort": 30001

}

]

}

}

haproxy.cfg

global

maxconn 51200

chroot /usr/local/haproxy

uid 99

gid 99

daemon

nbproc 1

pidfile /var/run/haproxy-private.pid

defaults

mode http

option redispatch

option abortonclose

timeout connect 5000ms

timeout client 30000ms

timeout server 30000ms

log 127.0.0.1 local0 err

balance roundrobin

listen admin_stats

bind 0.0.0.0:8888

option httplog

stats refresh 30s

stats uri /stats

stats realm Haproxy Manager

stats auth admin:1

frontend thrift-app

bind *:80

option forwardfor

maxconn 1000

acl dashboard hdr(host) -i dashboard.k8s.io

acl scope hdr(host) -i scope.k8s.io

acl thrift_test hdr(host) -i test.k8s.io

use_backend dashboard_app if dashboard

use_backend scope_app if scope

use_backend thrift_app_1 if thrift_test

backend dashboard_app

balance roundrobin

option forwardfor

option httpclose

retries 3

server s1 10.12.48.203:80

backend scope_app

balance roundrobin

option forwardfor

option httpclose

retries 3

server s2 10.1.125.203:80

backend thrift_app_1

balance roundrobin

option forwardfor

option httpclose

retries 3

server s3 10.0.100.1:9091

需要注意的是backend的server后面的ip可以是集群服务的cluster ip也可以通过dns来访问,如thrift-c-app,如果是跨namespace需要完整的domain,如:

thrift-c-app.thrift-demo.svc.cluster.local:9091

Haproxy运行在K8s集群,所以不用担心haproxy的压力,可以随时扩容Pods来解决。这里有一个问题是如何把 haproxy.cfg 配置文件做成动态的,不用每次修改后还要生成Image重新启动服务,解决办法可以参考https://hub.docker.com/_/haproxy/ 的 Reloading config.

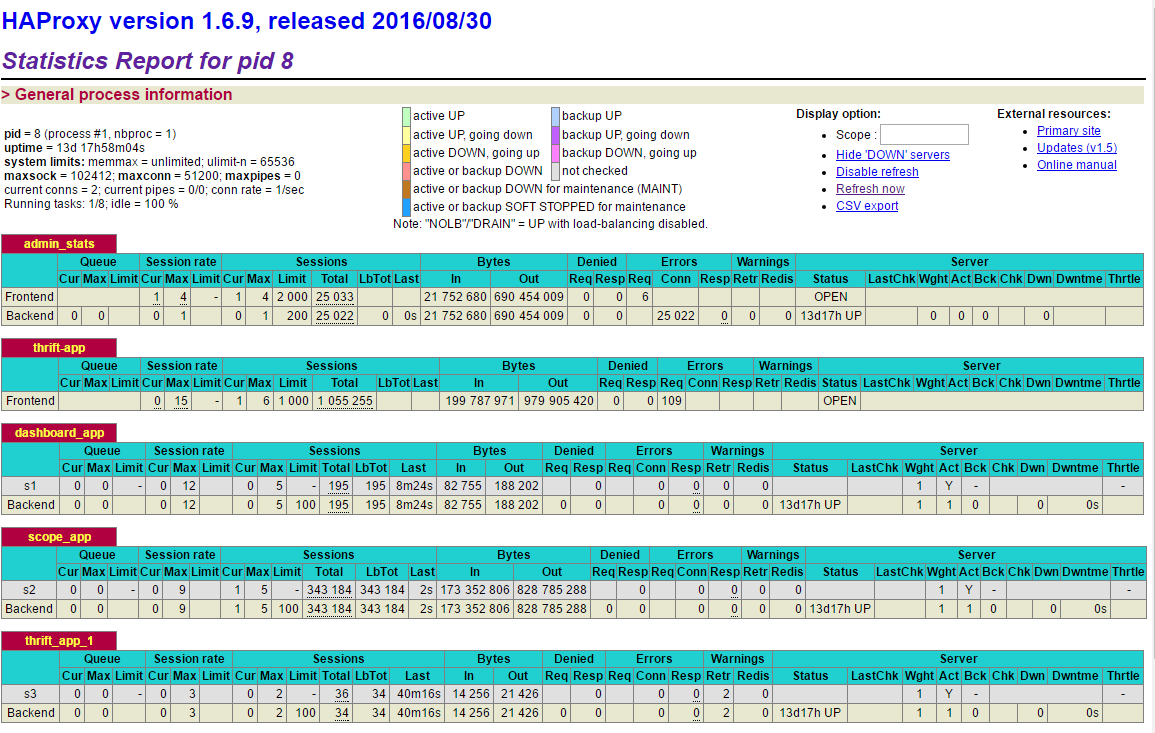

我们来看一下Haproxy的管理界面,访问http://192.196.1.160:30267/stats

测试

先配置本地的Hosts,将所有的域名都指向负载的浮动IP上

192.196.1.156 dashboard.k8s.io

192.196.1.156 scope.k8s.io

192.196.1.156 test.k8s.io

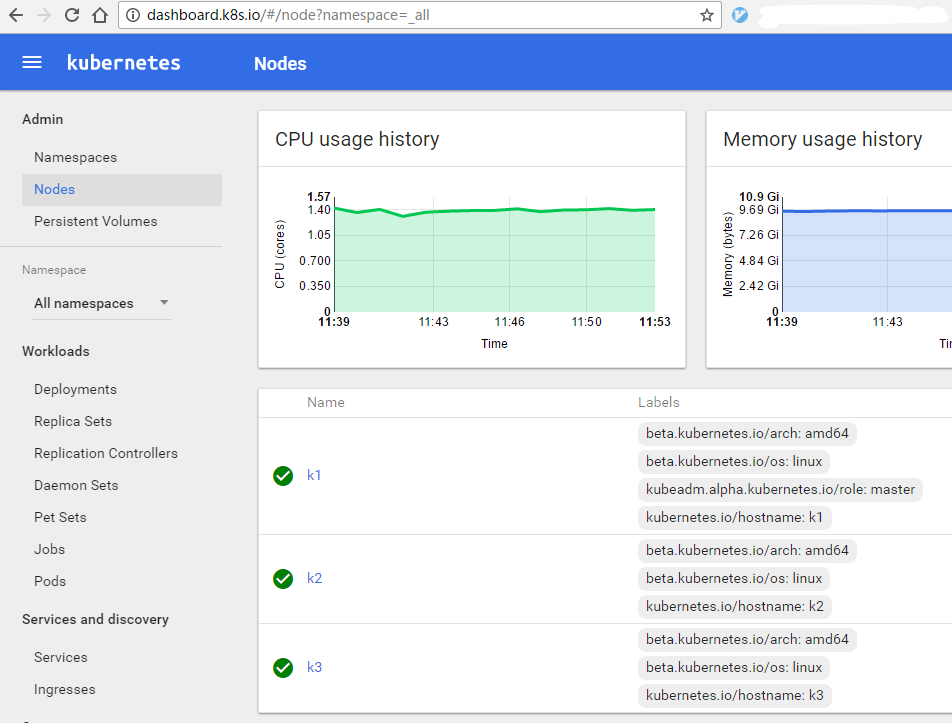

然后访问域名,如dashboard.k8s.io

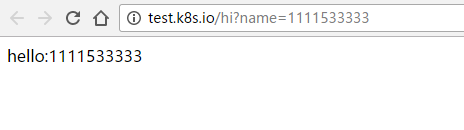

还有我们的测试服务

如预期一样,正常返回。这样所有要发布的WEB应用都通过一个端口来对外提供服务,所有集群里的云主机都可以做为负载资源,而且Haproxy本身可以扩容,目前来看不会有什么瓶颈而且用起来也比较顺手。

现在看起来一切都可以正常使用了,那还差什么呢? 想一想在并发压力大的情况下如何弹性扩容是个问题,这将在下文中讲解。

Openstack+Kubernetes+Docker微服务实践之路--服务发布的更多相关文章

- Openstack+Kubernetes+Docker微服务实践

Openstack+Kubernetes+Docker微服务实践 ..... Openstack+Kubernetes+Docker微服务实践之路--选型 posted @ 2016-11-15 ...

- Openstack+Kubernetes+Docker微服务

Openstack+Kubernetes+Docker微服务 渐入佳境,我们开始比较具体的工作,由于Docker是一个基础组件,所以本文的主题是Docker和Registry2. 底层系统基于Cent ...

- Openstack+Kubernetes+Docker微服务实践之路--基础设施

近两年微服务在网上聊的如此的如火如荼,备受关注,我在去年下半年的一个项目中也用到了阿里云的EDAS.HSF,深有体会,最近时间空闲出于好奇,决定一探究竟打算自建微服务平台,基本实现EDAS.HSF的功 ...

- Openstack+Kubernetes+Docker微服务实践之路--RPC

重点来了,本文全面阐述一下我们的RPC是怎么实现并如何使用的,跟Kubernetes和Openstack怎么结合. 在选型一文中说到我们选定的RPC框架是Apache Thrift,它的用法是在Ma ...

- Openstack+Kubernetes+Docker微服务实践之路--Kubernetes

经过几番折腾终于搞定Kubernetes了,我们要在Openstack上部署Kubernetes集群,使用最新工具Kubeadm来安装,由于不能直接访问Kubernetes的源,我们需要一台可以穿墙的 ...

- Openstack+Kubernetes+Docker微服务实践之路--选型

上一篇博文中我们选定Openstack做为我们的基础设施IAAS平台,本文将明确我们用什么技术做为微服务平台的技术选型. 经过对微服务的特性总结和添加一些个性需求后对微服务平台的基本要求 PRC远程调 ...

- Openstack+Kubernetes+Docker微服务实践之路--Docker和Registry2

渐入佳境,我们开始比较具体的工作,由于Docker是一个基础组件,所以本文的主题是Docker和Registry2. 底层系统基于Centos7,先在一台云主机上安装Docker,Docker的安装非 ...

- Openstack+Kubernetes+Docker微服务实践之路--弹性扩容

服务上线就要顶的住压力.扛的住考验,不然挨说的还是我们这帮做事的兄弟,还记得上图这个场景吗 老办法是服务集群部署,但总归有个上限,之前跟阿里合作的时候他们有个弹性计算可以通过设置CPU的阀值来动态扩展 ...

- 微服务实践之路--RPC

微服务实践之路--RPC 重点来了,本文全面阐述一下我们的RPC是怎么实现并如何使用的,跟Kubernetes和Openstack怎么结合. 在选型一文中说到我们选定的RPC框架是Apache Thr ...

随机推荐

- R12.2.6 installation failed with - Unable to rename database

报错信息: 日志信息:/data/ebsdb/VIS/12.1.0/appsutil/log/VIS_ebstest/12222150.log Phase 3 Rename Database Exec ...

- javaSE基础第二篇

1.JDK下载: www.oracle.com 2.JAVA_HOME bin目录:存放可执行文件.exe 把可能变的路径写入JAVA_HOME path=......;%JAVA_HOME%%; ...

- memcache的最佳实践方案

1.memcached的基本设置 1)启动Memcache的服务器端 # /usr/local/bin/memcached -d -m 10 -u root -l 192.168.0.200 -p 1 ...

- SQL语句增加字段、修改字段、修改类型、修改默认值

一.修改字段默认值 alter table 表名 drop constraint 约束名字 ------说明:删除表的字段的原有约束 alter table 表名 add constraint 约 ...

- delphi 图像旋转

网络搜集的 觉得有用的拿去吧 速度不错呢 //旋转90° procedure Rotate(Bitmap: TBitmap); type THelpRGB = packed record rgb: ...

- ExtJS6 TreePanel树节点合上展开显示不同图标

TreePanel的节点如包含子节点,可在展开/合上时显示不同的图标,增强客户端效果,提高用户体验.非常简单,使用TreePanel的两个事件:beforeitemexpand和beforeitemc ...

- PHP就业班心得:IP与域名以及DNS和端口号的概念

什么是IP地址 概念:IP地址就相当于人们的身份证号码!每一个连入Internet的计算机都应该有全世界独一无二的IP地址 IP地址是使用32个bit位来保存,也就是4个字节! 为了方便记忆,采用十进 ...

- Django基础

一.路由系统 1.静态路由 from app01 import views urlpatterns = [ #url(r'^admin/', admin.site.urls), url(r'^home ...

- QFile QDataStream QTextStream

#include <QCoreApplication> #include <QMap> #include <QFile> #include <QDir> ...

- HTML转移字符对照表

body { margin: 0; padding: 0; background: #FFF; color: #000; font-family: "宋体", arial; fon ...