tensorflow学习笔记(1)-基本语法和前向传播

tensorflow学习笔记(1)

(1)tf中的图

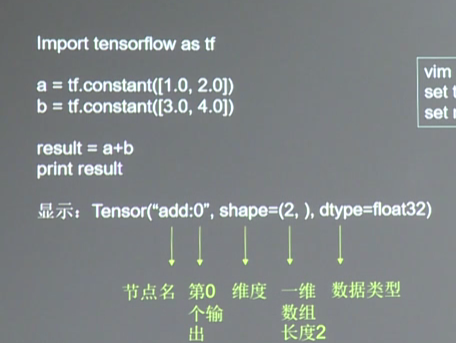

图中就是一个计算图,一个计算过程。 图中的constant是个常量

计算图只描述过程,不执行。

(2)tf中的会话

那么怎么计算呢?

tensorflow有个会话是专门用来计算的

import tensorflow as tf

x=tf.constant([[1.0,2.0]])

w=tf.constant([[3.0],[4.0]]) y=tf.matmul(x,w) print(y) with tf.Session() as sess:

print(sess.run(y))

这里定义了个矩阵相乘的运算,并用会话结构 with tf.session() as sess:计算

打印结果为 1*3+2*4=11没毛病

1*3+2*4=11没毛病

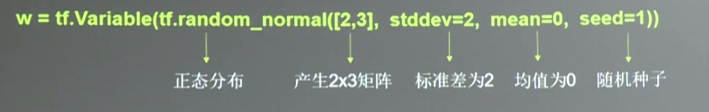

(3)tf中的变量

tf中遍历就是神经元上的参数或者说是权重w,我们要改变的就是这个参数。

seed是随机数种子,不加的话每次生成的都不一样

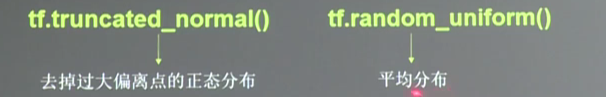

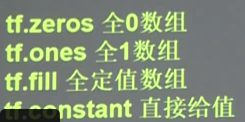

除了正太分布tf还提供均匀分布,还有零矩阵和1矩阵的初始化,还有填充矩阵和constant矩阵的初始化方法

变量的初始化:在sess.run()中使用tf.global_variablies_initializer()

如

init_op=tf.global_varibles_initializer()

sess.run(init_op)

(4)tf.placeholder

这是个占位的作用,可以理解为申明定义变量

如x=tf.placeholder(tf.float32,shape=(1,2))这是声明

然后喂入一组数据

sess.run(y,feed_dict={x:[[0.5,0.6]]})

喂入多组数据

x=tf.placeholder(tf.float32,shape=(None,2))#none表示不限样本数

sess.run(y,feed_dict={x:[[0.1,0.2],[0.2,0.3],[0.4,0.5]]})

(5)神经网络四部曲

1.准备数据和提取特征值输入神经网络

2.搭建NN结构,先搭建图然后运算(前向传播)(计算输出)

3.大量数据喂入NN,迭代优化参数(权重和偏置)(NN反向传播算法)

4.用训练好的模型分类预测

(5)这里实现一个简单2层网络模型

# -*- coding: utf-8 -*-

import tensorflow as tf

#两层神经网络(全连接过程) #初始化特征值和参数

x=tf.constant([[0.7,0.5]])

w1=tf.Variable(tf.random_normal([2,3],stddev=1,seed=1))

w2=tf.Variable(tf.random_normal([3,1],stddev=1,seed=1)) #定义前向传播过程

a=tf.matmul(x,w1)

y=tf.matmul(a,w2) #用会话计算结果

with tf.Session() as sess:

init_op=tf.global_variables_initializer()

sess.run(init_op)

print(sess.run(y))

运行结果如下

这是喂入多组数据的方法

这里的特征值我们已经固定,我们也可以先用placeholdr占位,然后再sess.run()里面喂入feed_dict={xxx}

tensorflow学习笔记(1)-基本语法和前向传播的更多相关文章

- tensorflow学习笔记——使用TensorFlow操作MNIST数据(1)

续集请点击我:tensorflow学习笔记——使用TensorFlow操作MNIST数据(2) 本节开始学习使用tensorflow教程,当然从最简单的MNIST开始.这怎么说呢,就好比编程入门有He ...

- Tensorflow学习笔记2019.01.03

tensorflow学习笔记: 3.2 Tensorflow中定义数据流图 张量知识矩阵的一个超集. 超集:如果一个集合S2中的每一个元素都在集合S1中,且集合S1中可能包含S2中没有的元素,则集合S ...

- tensorflow学习笔记——使用TensorFlow操作MNIST数据(2)

tensorflow学习笔记——使用TensorFlow操作MNIST数据(1) 一:神经网络知识点整理 1.1,多层:使用多层权重,例如多层全连接方式 以下定义了三个隐藏层的全连接方式的神经网络样例 ...

- tensorflow学习笔记——自编码器及多层感知器

1,自编码器简介 传统机器学习任务很大程度上依赖于好的特征工程,比如对数值型,日期时间型,种类型等特征的提取.特征工程往往是非常耗时耗力的,在图像,语音和视频中提取到有效的特征就更难了,工程师必须在这 ...

- TensorFlow学习笔记——LeNet-5(训练自己的数据集)

在之前的TensorFlow学习笔记——图像识别与卷积神经网络(链接:请点击我)中了解了一下经典的卷积神经网络模型LeNet模型.那其实之前学习了别人的代码实现了LeNet网络对MNIST数据集的训练 ...

- tensorflow学习笔记——VGGNet

2014年,牛津大学计算机视觉组(Visual Geometry Group)和 Google DeepMind 公司的研究员一起研发了新的深度卷积神经网络:VGGNet ,并取得了ILSVRC201 ...

- TensorFlow学习笔记10-卷积网络

卷积网络 卷积神经网络(Convolutional Neural Network,CNN)专门处理具有类似网格结构的数据的神经网络.如: 时间序列数据(在时间轴上有规律地采样形成的一维网格): 图像数 ...

- Tensorflow学习笔记No.5

tf.data卷积神经网络综合应用实例 使用tf.data建立自己的数据集,并使用CNN卷积神经网络实现对卫星图像的二分类问题. 数据下载链接:https://pan.baidu.com/s/141z ...

- Tensorflow学习笔记2:About Session, Graph, Operation and Tensor

简介 上一篇笔记:Tensorflow学习笔记1:Get Started 我们谈到Tensorflow是基于图(Graph)的计算系统.而图的节点则是由操作(Operation)来构成的,而图的各个节 ...

随机推荐

- Tomcat 服务器体系结构

connector 监听端口,监听到以后,交给 Engine 引擎 处理,引擎会根据请求找到对应的主机,找到主机后再去找对应的应用. 如果我们将 port 改为 80,那访问的时候就不用输入端口号,因 ...

- Oracle数据库补充

约束: 什么是约束以及约束的作用: 为保证数据的完整性(一致性,准确性),需要对数据进行限制,这个限制就叫做约束 目的:保证数据的完整性(一致性,正确性),使数据符合业务规则(业务逻辑) 约束 ...

- 概括iOS知识点思维导图

- VS中R转义字符处理

std::string s1 = R"(Name="Hello World ... ")"; std::string s2 = R"-(Name=&q ...

- Python的核心数据类型

Python的核心数据类型有:数字,字符串,列表,字典,元组,文件等. 数字 数字类型有:整形int,浮点型float,复数complex,布尔型bool. 整形 整型数是不带有小数部分的 ...

- PostgreSQL数据库的安装

1 总体规划 操作系统 CentOS Linux release 7.5.1804 处理器 1 内存 4G 硬盘 38G 主机名称 chenzx IP地址 192.168.56.8 1.1 用户组和用 ...

- linux总结及常用命令

一.操作系统的作用: 1.是现代计算机系统中最基本和最重要的系统软件 2.承上启下的作用 3.向下对硬件操作进行封装 4.向上对用户和应用程序提供方便访问硬件的接口 二.不同领域的操作系统: 1 ...

- video.js使用技巧

https://www.awaimai.com/2053.html https://www.jianshu.com/p/16fa00a1ca8e

- Python系列5之模块

模块 1. 模块的分类 模块,又称构件,是能够单独命名并独立地完成一定功能的程序语句的集合(即程序代码和数据结构的集合体). (1)自定义模块 自己定义的一些可以独立完成某个功能的一段程序语句,可以是 ...

- 002---Python基本数据类型--字符串

字符串 .caret, .dropup > .btn > .caret { border-top-color: #000 !important; } .label { border: 1p ...