论文解读(SelfGNN)《Self-supervised Graph Neural Networks without explicit negative sampling》

论文信息

论文标题:Self-supervised Graph Neural Networks without explicit negative sampling

论文作者:Zekarias T. Kefato, Sarunas Girdzijauskas

论文来源:2021, WWW

论文地址:download

论文代码:download

1 介绍

本文核心贡献:

- 使用孪生网络隐式实现对比学习;

- 本文提出四种特征增强方式(FA);

2 相关工作

Graph Neural Networks

GCN 和 GAT 存在的一个问题:GCN 和 GAT 需要全批处理训练,也就是说,整个图($H$)应该被加载到内存中,这使得它们是可转换的,不能扩展到大型网络。

3 方法

3.1 数据增强

拓扑结构:

- 基于随机游走的 $\text{PageRank}$ 算法:

$\boldsymbol{H}^{P P R}=\alpha(\boldsymbol{I}-(1-\alpha) \tilde{A})^{-1} \quad\quad\quad(2)$

$\boldsymbol{H}^{H K}=\exp \left(t A D^{-1}-t\right)\quad\quad\quad(3)$

其中 $\alpha$ 是心灵传输概率 ,$t$ 是扩散时间

- 基于 $\text{Katz}$ 指标的算法:

$\boldsymbol{H}^{k a t z}=(I-\beta \tilde{A})^{-1} \beta \tilde{A}\quad\quad\quad(4)$

Katz-index是一对节点之间所有路径集的加权和,路径根据其长度进行惩罚。衰减系数($\beta$)决定了处罚过程。

特征增强:

- Split:特征 $X$ 拆分成两部分 $\boldsymbol{X}=\boldsymbol{X}[:,: F / 2]$ 和 $\boldsymbol{X}^{\prime}=\boldsymbol{X}[:, F / 2:]$ ,然后分别用于生成两个视图。

- Standardize:特征矩阵进行 z-score standardization :

${\large X^{\prime}=\left(\frac{X^{T}-\bar{x}}{s}\right)^{T}} $

其中 $\bar{x} \in \mathbb{R}^{F \times 1}$ 和 $s \in \mathbb{R}^{F \times 1}$ 是与每个特征相关联的均值向量和标准差向量。

- Local Degree Profile (LDP):提出了一种基于节点局部度轮廓计算出的五个统计量的节点特征构建机制 $\mathbf{X}^{\prime} \in \mathbb{R}^{N \times 5}$ ,然后使用零填充 $X^{\prime} \in \mathbb{R}^{N \times F}$ 使其维度与 $X$ 一致。

- Paste:是一种功能增强技术,它简单地结合了 $X$ 和 LDP 功能,如增强功能 $\boldsymbol{X}^{\prime} \in \mathbb{R}^{N \times(F+5)}$。在这种情况下,在原始特征矩阵 $X$ 上应用了一个零填充,例如 $X \in \mathbb{R}^{N \times(F+5)}$ 。

3.2 框架

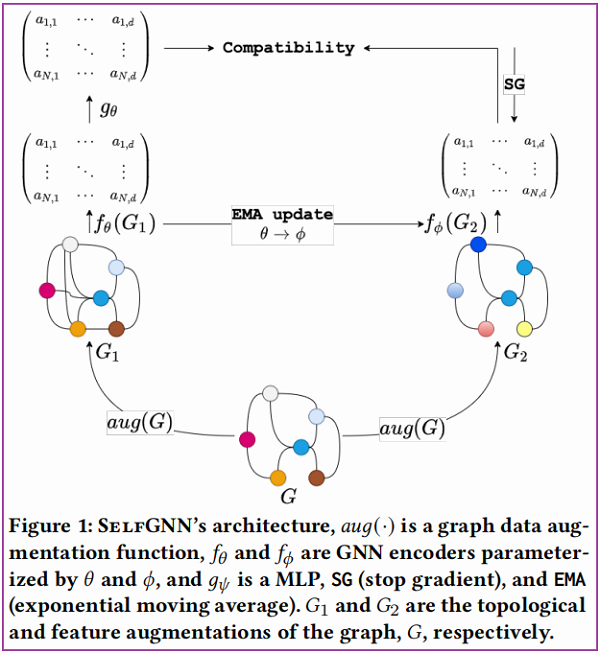

总体框架如下:

组成部分:

- 组件一:生成视图,$any(G)$ 是对原始图 $G$ 从拓扑或特征层面进行数据增强;

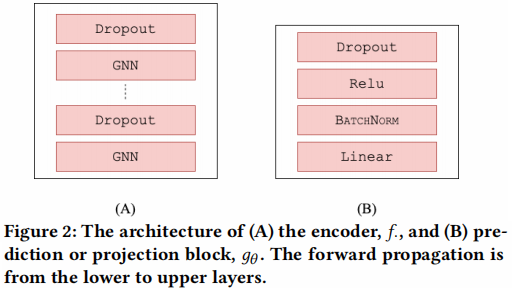

- 组件二:图自编码器 $f_{\theta}$ 和 $f_{\phi}$,一种堆叠架构,如 Figure 2 (A) 所示。概括为:$X_{1}=f_{\theta}\left(G_{1}\right)$, $X_{2}=f_{\phi}\left(G_{2}\right)$;

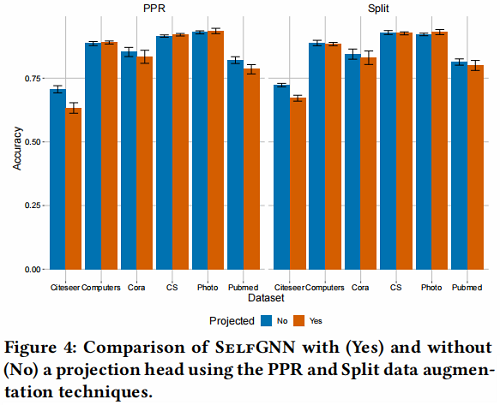

- 组件三:孪生网络(Siamese Network,用于评估两个输入样本的相似性)是一个投影头,类似$g_{\theta}$的架构,如 Figure 2 (B) 所示。本文在这发现使用这个投影头对性能没有多大提升,所以实际上并没有使用;

- 组件四:预测块(prediction block),对学生网络(左边)使用,这个预测块可以是 MLP ,也可以是 $g_{\theta}$,架构如Figure 2 (B) 所示。学生网络用于从教师网络(右边)中学到有用的信息;【$g_{\theta}\left(\mathbf{X}_{1}\right) \approx \mathbf{X}_{2}$】

须知:

只对学生网络的参数通过梯度更新(SG),学生网络使用的损失函数如下:

$\mathcal{L}_{\theta}=2-2 \cdot \frac{\left\langle g_{\theta}\left(X_{1}\right), X_{2}\right\rangle}{\left\|g_{\theta}\left(X_{1}\right)\right\|_{F} \cdot\left\|X_{2}\right\|_{F}}\quad\quad\quad(5)$

教师网络参数通过学生网络使用指数移动平均(EMA,exponential moving average)进行更新。指数移动平均如下:

$\phi \leftarrow \tau \phi+(1-\tau) \theta\quad\quad\quad(6)$

这里 $\tau$ 是衰减率。

4 实验

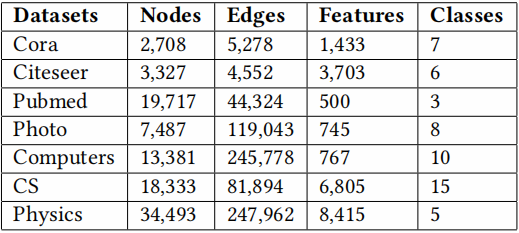

数据集:

- citation networks (Cora, Citeseer, Pubmed)

- author collaboration networks (CS, Physics)

- co-purchased products network (Photo, Computers)

实验设置:

- 70/10/20–train/validation/test

- $\alpha=0.15$, $t=3$, $\beta=0.1$

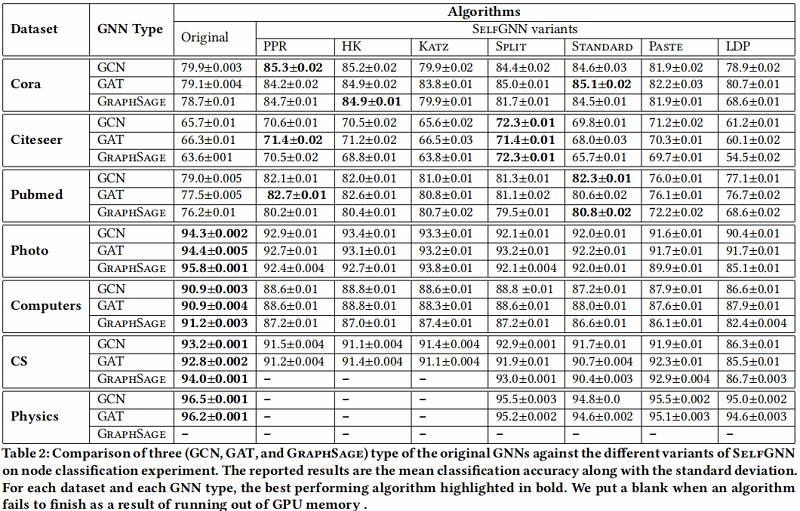

与原始 GNN 的比较:

对比 ClusterSelfGNN 性能的提升:

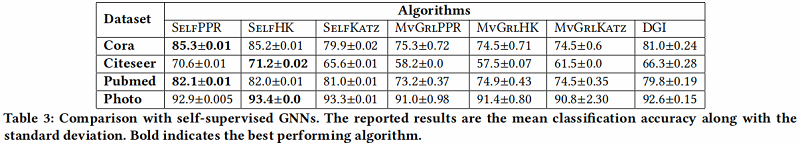

与自监督 GNN 的比较:

消融实验:

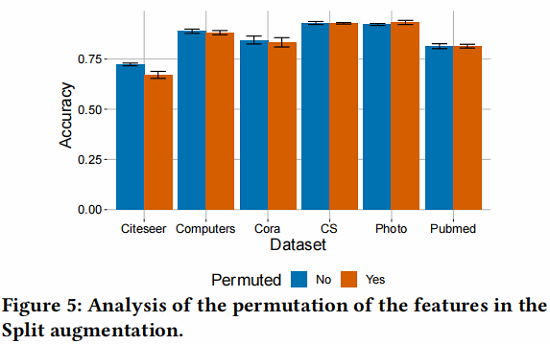

Split 策略的有效性:

5 结论

本研究提出了一种新的对比自监督方法SelfGNN,它不需要显式的对比项,负样本。虽然负样本对对比学习的成功至关重要,但我们采用了批量归一化,以引入隐式负样本。此外,我们还介绍了四种与拓扑节点特征增强技术一样有效的节点特征增强技术。我们使用7个真实数据集进行了广泛的实验,结果表明SelfGNN获得了与监督GNNs相当的性能,同时明显优于半监督和自监督方法。SelfGNN依赖于两个并行的gnn同时加载到内存中,这给大型网络造成了一个主要的瓶颈。虽然本研究提出了基于聚类的改进,但需要做仔细和有原则的工作来适当地解决这个问题。这是我们未来工作的目标。

相关论文

论文解读(SelfGNN)《Self-supervised Graph Neural Networks without explicit negative sampling》的更多相关文章

- 论文解读二代GCN《Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering》

Paper Information Title:Convolutional Neural Networks on Graphs with Fast Localized Spectral Filteri ...

- Deep Learning 论文解读——Session-based Recommendations with Recurrent Neural Networks

博客地址:http://www.cnblogs.com/daniel-D/p/5602254.html 新浪微博:http://weibo.com/u/2786597434 欢迎多多交流~ Main ...

- 论文解读(DAGNN)《Towards Deeper Graph Neural Networks》

论文信息 论文标题:Towards Deeper Graph Neural Networks论文作者:Meng Liu, Hongyang Gao, Shuiwang Ji论文来源:2020, KDD ...

- 论文解读(KP-GNN)《How Powerful are K-hop Message Passing Graph Neural Networks》

论文信息 论文标题:How Powerful are K-hop Message Passing Graph Neural Networks论文作者:Jiarui Feng, Yixin Chen, ...

- 论文解读(LA-GNN)《Local Augmentation for Graph Neural Networks》

论文信息 论文标题:Local Augmentation for Graph Neural Networks论文作者:Songtao Liu, Hanze Dong, Lanqing Li, Ting ...

- 论文解读(GraphSMOTE)《GraphSMOTE: Imbalanced Node Classification on Graphs with Graph Neural Networks》

论文信息 论文标题:GraphSMOTE: Imbalanced Node Classification on Graphs with Graph Neural Networks论文作者:Tianxi ...

- 论文解读(PPNP)《Predict then Propagate: Graph Neural Networks meet Personalized PageRank》

论文信息 论文标题:Predict then Propagate: Graph Neural Networks meet Personalized PageRank论文作者:Johannes Gast ...

- 论文解读(soft-mask GNN)《Soft-mask: Adaptive Substructure Extractions for Graph Neural Networks》

论文信息 论文标题:Soft-mask: Adaptive Substructure Extractions for Graph Neural Networks论文作者:Mingqi Yang, Ya ...

- 论文解读(ChebyGIN)《Understanding Attention and Generalization in Graph Neural Networks》

论文信息 论文标题:Understanding Attention and Generalization in Graph Neural Networks论文作者:Boris Knyazev, Gra ...

随机推荐

- .user.ini文件构成的PHP后门

.user.ini.它比.htaccess用的更广,不管是nginx/apache/IIS,只要是以fastcgi运行的php都可以用这个方法.我的nginx服务器全部是fpm/fastcgi,我的I ...

- SWAKS伪造邮件发送

一.SWAKS介绍 swaks(SWiss Army Knife Smtp)SMTP瑞士军刀Swaks是由John Jetmore编写和维护的一种功能强大,灵活,可脚本化,面向事务的SMTP测试工具. ...

- [AT2306]Rearranging(拓扑序)

[AT2306]Rearranging(拓扑序) 只有luogu 题面(luogu): 有一个$n$个数组成的序列$a_{i}$. 高桥君会把整个序列任意排列,然后青木君可以选择两个相邻的互质的数交换 ...

- width:auto 和 width:100%有什么区别

width:auto 和 width:100%有什么区别 宽度计算不同 <div class="parent"> <span class="child& ...

- 一个序列出现固定元素个数的方法(DFS)

#include <iostream.h> int a[100];int i; static int stat=0; void dfs(int n,int oneCount) { if(o ...

- IDEA端口占用的解决方案

使用端口查找到对应的进程PID: netstat -ano | findstr "端口" 查找到对应PID的进程信息 tasklist /v /fi "PID eq &l ...

- 你如何理解 Spring Boot 中的 Starters?

Starters可以理解为启动器,它包含了一系列可以集成到应用里面的依赖包,你可以一站式集成 Spring 及其他技术,而不需要到处找示例代码和依赖包.如你想使用 Spring JPA 访问数据库,只 ...

- Spring框架中有哪些不同类型的事件?

Spring 提供了以下5种标准的事件: (1)上下文更新事件(ContextRefreshedEvent):在调用ConfigurableApplicationContext 接口中的refre ...

- centos 安装solr6

1.到solr官网下载.tgz 结尾的文件 2.tar zxvf solr*.tgz 解压文件 3.进入solr的解压目录里的bin目录 执行 ./solr start -force 执行成功后 可访 ...

- python中一切皆对象的理解

一切皆对象? 学过Java都知道,Java中有8个基本类型,其余的都是继承自Object类的引用类型.方法内的基本类型变量会在栈上分配,而引用类型会通过逃逸分析来决定在栈上分配或堆上分配.Java中关 ...