SuperSpider(简书爬虫JAVA版)

* 建站数据SuperSpider(简书)

* 本项目目的:

* 为练习web开发提供相关的数据;

* 主要数据包括:

* 简书热门专题模块信息、对应模块下的热门文章、

* 文章的详细信息、作者信息、

* 评论区详细信息、评论者信息等...

* 最后存储mysql数据库.

想学习爬虫的同学也可以瞧瞧

整个项目跑完花了近十个小时, 足见数据之多, 个人web开发练习用来充当建站数据也是绰绰有余的(~ ̄▽ ̄)~

代码注释写的挺详细的,我就直接上代码了。

主要代码:

/**

* 此类对简书文章内容页进行了详细的解析爬取;

* 封装后的唯一入口函数 {@link ArticleSpider#run(String, int)}.

*

* author As_

* date 2018-08-21 12:34:23

* github https://github.com/apknet

*/ public class ArticleSpider { /** 长度为4 :阅读量、评论数、点赞数、文章对应的评论id */

private List<Integer> readComLikeList = new ArrayList<>(); /** 文章Id */

private long articleId; /**

* 此类的入口函数;

* 爬虫范围包括文章的详情信息、评论的详细信息;

* 并同时持久化数据;

* key实例:443219930c5b

*

* @param key

* @param flag_type 文章所属分类的索引

*/ public void run(String key, int flag_type){ try {

articleSpider(key, flag_type); // 以下参数由articleSpeder()函数获得

String comUrl = String.format("https://www.jianshu.com/notes/%d/comments?comment_id=&author_only=false&since_id=0&max_id=1586510606000&order_by=desc&page=1", readComLikeList.get(3)); comSpider(comUrl); } catch (Exception e) {

e.printStackTrace();

}

} /**

* 链接实例 https://www.jianshu.com/p/443219930c5b

* 故只接受最后一段关键字

* @param key

* @param flag_type 文章所属分类的索引

* @throws Exception

*/

private void articleSpider(String key, int flag_type) throws Exception { String url = "https://www.jianshu.com/p/" + key; Document document = getDocument(url); IdUtils idUtils = new IdUtils(); List<Integer> list = getReadComLikeList(document); articleId = idUtils.genArticleId();

String title = getTitle(document);

String time = getTime(document);

String imgCover = getImgCover(document);

String brief = getBrief(document);

String content = getContent(document);

String author = idUtils.genUserId();

int type = flag_type;

int readNum = list.get(0);

int comNum = list.get(1);

int likeNum = list.get(2); // 数据库添加对应对象数据

Article article = new Article(articleId, title, time, imgCover, brief, content, author, type, readNum, comNum, likeNum);

new ArticleDao().addArticle(article); User user = new User();

user.setUser(idUtils.genUserId());

user.setName(getAuthorName(document));

user.setImgAvatar(getAuthorAvatar(document));

new UserDao().addUser(user); } private Document getDocument(String url) throws IOException { Document document = Jsoup.connect(url)

.header("User-Agent", "Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:61.0) Gecko/20100101 Firefox/61.0")

.header("Content-Type", "application/json; charset=utf-8")

.header("Cookie", "_m7e_session=2e930226548924f569cb27ba833346db;locale=zh-CN;default_font=font2;read_mode=day")

.get();

return document;

} private String getTitle(Document doc){

return doc.select("h1[class=title]").text();

} private String getTime(Document doc){

Element element = doc.select("span[class=publish-time]").first();

return element.text();

} private String getImgCover(Document doc){

Element element = doc.select("img[data-original-format=image/jpeg]").first();

if (element.hasAttr("data-original-src")){

String url = element.attr("data-original-src").trim();

return SpiderUtils.handleUrl(url);

}

return null;

} private String getBrief(Document doc){

return doc.select("meta[name=description]").first().attr("content");

} private String getContent(Document doc){

Element element = doc.select("div[class=show-content-free]").first();

// System.out.println(element.html()); Elements eles = element.select("div[class=image-package]");

for(Element ele: eles){

Element imgEle = ele.select("img").first();

ele.replaceWith(imgEle);

} String result = element.html().replaceAll("data-original-", "");

return result;

} private String getAuthorAvatar(Document doc){

String url = doc.select("div[class=author]").select("img").attr("src");

return SpiderUtils.handleUrl(url);

} private String getAuthorName(Document doc){

Element element = doc.select("script[data-name=page-data]").first();

JSONObject jsonObject = new JSONObject(element.html()).getJSONObject("note").getJSONObject("author");

return jsonObject.getString("nickname");

} private List<Integer> getReadComLikeList(Document doc){

Element element = doc.select("script[data-name=page-data]").first();

JSONObject jsonObject = new JSONObject(element.html()).getJSONObject("note"); readComLikeList.add(jsonObject.getInt("views_count"));

readComLikeList.add(jsonObject.getInt("comments_count"));

readComLikeList.add(jsonObject.getInt("likes_count"));

readComLikeList.add(jsonObject.getInt("id")); System.out.println(Arrays.toString(readComLikeList.toArray()));

return readComLikeList;

} /**

* 评论区爬虫---包括:

* 评论楼层、时间、内容、评论者、评论回复信息等

* 具体可查看{@link Comment}

*

* @param url

* @throws Exception

*/

private void comSpider(String url) throws Exception {

URLConnection connection = new URL(url).openConnection(); // 需加上Accept header,不然导致406

connection.setRequestProperty("Accept", "*/*"); BufferedReader reader = new BufferedReader(new InputStreamReader(connection.getInputStream())); String line;

StringBuilder str = new StringBuilder(); while ((line = reader.readLine()) != null) {

str.append(line);

} System.out.println(str.toString()); JSONObject jb = new JSONObject(str.toString()); boolean hasComment = jb.getBoolean("comment_exist");

if(hasComment){

int pages = jb.getInt("total_pages");

if(pages > 20){

// 某些热门文章评论成千上万, 此时没必要全部爬取

pages = 20;

}

int curPage = jb.getInt("page"); JSONArray jsonArray = jb.getJSONArray("comments");

Iterator iterator = jsonArray.iterator();

while(iterator.hasNext()){

JSONObject comment = (JSONObject) iterator.next();

JSONArray comChildren = comment.getJSONArray("children");

JSONObject userObj = comment.getJSONObject("user");

IdUtils idUtils = new IdUtils();

CommentDao commentDao = new CommentDao();

UserDao userDao = new UserDao(); int commentId = idUtils.genCommentId();

String userId = idUtils.genUserId(); System.out.println(comment.toString());

// 评论内容相关

String content = comment.getString("compiled_content");

String time = comment.getString("created_at");

int floor = comment.getInt("floor");

int likeNum = comment.getInt("likes_count");

int parentId = 0; // 评论者信息

String name = userObj.getString("nickname");

String avatar = userObj.getString("avatar"); Comment newCom = new Comment(commentId, articleId, content, time, floor, likeNum, parentId, userId, avatar, name);

commentDao.addComment(newCom); User user = new User();

user.setUser(userId);

user.setName(name);

user.setImgAvatar(avatar); userDao.addUser(user); // 爬取评论中的回复

Iterator childrenIte = comChildren.iterator();

while(childrenIte.hasNext()){

JSONObject child = (JSONObject) childrenIte.next(); Comment childCom = new Comment();

childCom.setId(idUtils.genCommentId());

childCom.setArticleId(articleId);

childCom.setComment(child.getString("compiled_content"));

childCom.setTime(child.getString("created_at"));

childCom.setParentId(child.getInt("parent_id"));

childCom.setFloor(floor);

childCom.setNameAuthor(child.getJSONObject("user").getString("nickname")); commentDao.addComment(childCom); }

} // 实现自动翻页

if(curPage == 1){

for(int i = 2; i <= pages; i++){

System.out.println("page-------------------> " + i);

int index = url.indexOf("page=");

String sub_url = url.substring(0, index + 5);

String nextPage = sub_url + i;

comSpider(nextPage);

}

}

}

}

}

and:

/**

* 模块(简书的专题)爬虫

* 入口:https://www.jianshu.com/recommendations/collections

* 模块实例: https://www.jianshu.com/c/V2CqjW

* 文章实例: https://www.jianshu.com/p/443219930c5b

* 故此爬虫多处直接传递链接后缀的关键字符串(如‘V2CqjW’、‘443219930c5b’)

*

* @author As_

* @date 2018-08-21 12:31:35

* @github https://github.com/apknet

*

*/ public class ModuleSpider { public void run() {

try { List<String> moduleList = getModuleList("https://www.jianshu.com/recommendations/collections"); for (String key: moduleList) {

// 每个Module爬取10页内容的文章

System.out.println((moduleList.indexOf(key) + 1) + "." + key);

for (int page = 1; page < 11; page++) {

String moduleUrl = String.format("https://www.jianshu.com/c/%s?order_by=top&page=%d", key, page); List<String> articleList = getArticleList(moduleUrl); for (String articlekey: articleList) {

new ArticleSpider().run(articlekey, moduleList.indexOf(key) + 1);

}

}

} } catch (Exception e) {

e.printStackTrace();

}

} /**

* 返回Module 关键字符段

* @param url

* @return

* @throws IOException

* @throws SQLException

*/ private List<String> getModuleList(String url) throws IOException, SQLException { List<String> moduleList = new ArrayList<>();

int i = 0; Document document = Jsoup.connect(url).get();

Element container = document.selectFirst("div[id=list-container]");

Elements modules = container.children();

for(Element ele: modules){

String relUrl = ele.select("a[target=_blank]").attr("href");

String moduleKey = relUrl.substring(relUrl.indexOf("/c/") + 3);

moduleList.add(moduleKey); // System.out.println(moduleKey);

// 以下爬取数据创建Module对象并持久化 String name = ele.select("h4[class=name]").text();

String brief = ele.selectFirst("p[class=collection-description]").text();

String imgcover = SpiderUtils.handleUrl(ele.selectFirst("img[class=avatar-collection]").attr("src")); String articleNu = ele.select("a[target=_blank]").get(1).text();

int articleNum = Integer.parseInt(articleNu.substring(0, articleNu.indexOf("篇"))); String userNu = ele.select("div[class=count]").text().replace(articleNu, "");

Matcher matcher = Pattern.compile("(\\D*)(\\d*\\.\\d*)?(\\D*)").matcher(userNu);

matcher.find();

int userNum = (int)(Float.parseFloat(matcher.group(2)) * 1000); Module module = new Module((++i), name, brief, imgcover, userNum, articleNum, "apknet");

new ModuleDao().addModule(module); System.out.println(name + "------------------>");

}

return moduleList;

} /**

* 文章链接实例 https://www.jianshu.com/p/443219930c5b

* 故此处返回List的String为url后的那段字符串

*

* @param url

* @return

*/

private List<String> getArticleList(String url) { System.out.println("getArticleList: --------------------->"); List<String> keyList = new ArrayList<>(); Document document = null;

try {

document = Jsoup.connect(url).get();

} catch (Exception e) {

e.printStackTrace();

}

Element ulElement = document.select("ul[class=note-list]").first(); Elements elements = ulElement.select("li[id]");

for (Element ele : elements) {

String relUrl = ele.select("a[class=title]").attr("href");

String key = relUrl.substring(relUrl.indexOf("/p/") + 3);

keyList.add(key);

System.out.println(key);

} return keyList;

} }

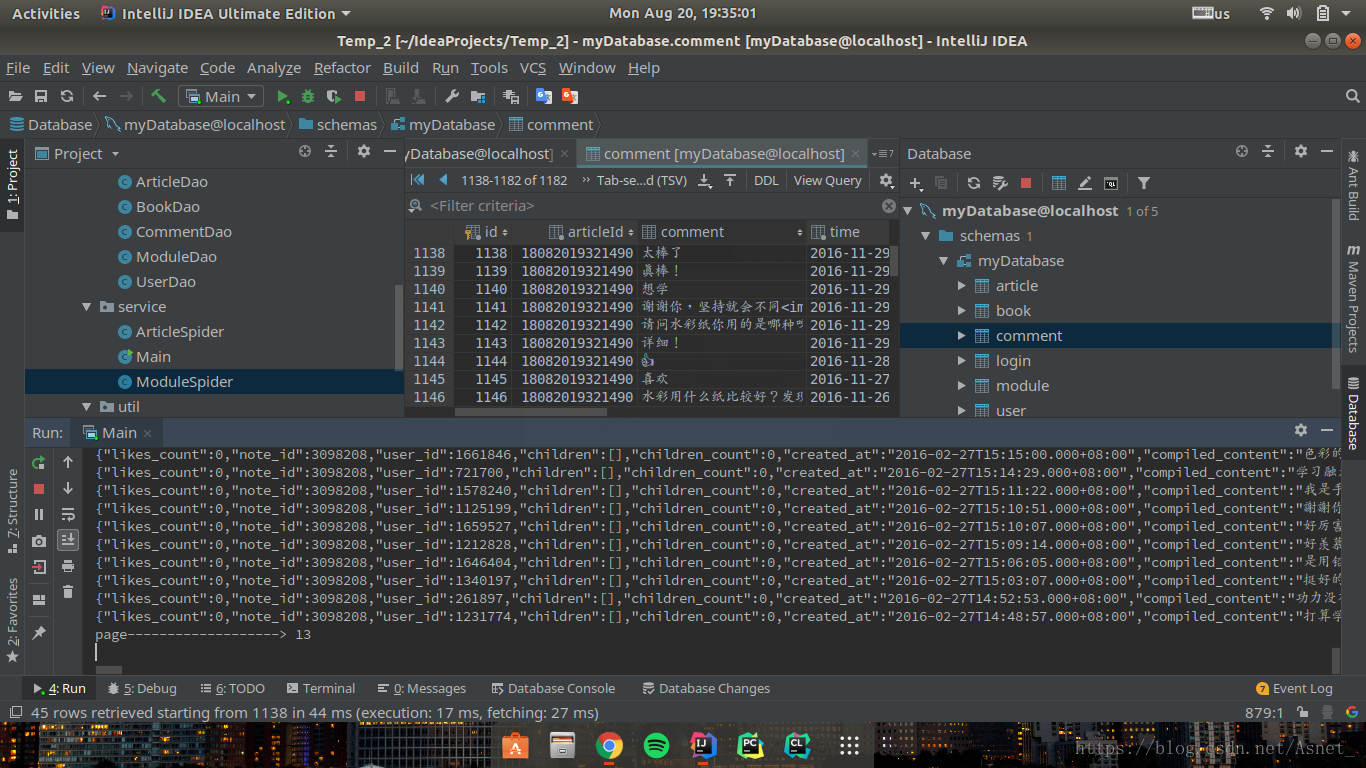

最后附上实验截图:

完整项目地址:

https://github.com/apknet/SuperSpider

SuperSpider(简书爬虫JAVA版)的更多相关文章

- jsoup爬虫简书首页数据做个小Demo

代码地址如下:http://www.demodashi.com/demo/11643.html 昨天LZ去面试,遇到一个大牛,被血虐一番,发现自己基础还是很薄弱,对java一些原理掌握的还是不够稳固, ...

- 网页爬虫的设计与实现(Java版)

网页爬虫的设计与实现(Java版) 最近为了练手而且对网页爬虫也挺感兴趣,决定自己写一个网页爬虫程序. 首先看看爬虫都应该有哪些功能. 内容来自(http://www.ibm.com/deve ...

- 《Java核心技术 卷II 高级特性(原书第9版)》

<Java核心技术 卷II 高级特性(原书第9版)> 基本信息 原书名:Core Java Volume II—Advanced Features(Ninth Edition) 作者: ( ...

- Java native代码编译步骤简书

Java native代码编译步骤简书 目的:防止java代码反编译获取密码算法 (1)编写实现类com.godlet.PasswordAuth.java (2)编译java代码javac Passw ...

- 学习PHP爬虫--《Webbots、Spiders和Screen Scrapers:技术解析与应用实践(原书第2版)》

<Webbots.Spiders和Screen Scrapers:技术解析与应用实践(原书第2版)> 译者序 前言 第一部分 基础概念和技术 第1章 本书主要内容3 1.1 发现互联网的真 ...

- [Selenium2+python2.7][Scrap]爬虫和selenium方式下拉滚动条获取简书作者目录并且生成Markdown格式目录

预计阅读时间: 15分钟 环境: win7 + Selenium2.53.6+python2.7 +Firefox 45.2 (具体配置参考 http://www.cnblogs.com/yoyok ...

- Node爬取简书首页文章

Node爬取简书首页文章 博主刚学node,打算写个爬虫练练手,这次的爬虫目标是简书的首页文章 流程分析 使用superagent发送http请求到服务端,获取HTML文本 用cheerio解析获得的 ...

- Python 2.7_发送简书关注的专题作者最新一篇文章及连接到邮件_20161218

最近看简书文章关注了几个专题作者,写的文章都不错,对爬虫和数据分析都写的挺好,因此想到能不能获取最新的文章推送到Ipad网易邮箱大师.邮件发送代码封装成一个函数,从廖雪峰大神那里学的 http:// ...

- PetaPojo —— JAVA版的PetaPoco

背景 由于工作的一些原因,需要从C#转成JAVA.之前PetaPoco用得真是非常舒服,在学习JAVA的过程中熟悉了一下JAVA的数据组件: MyBatis 非常流行,代码生成也很成熟,性能也很好.但 ...

随机推荐

- 1、Tomcat7性能监控与优化

1. 目的 通过优化tomcat提高网站的并发能力. 2. 服务器资源 服务器所能提供CPU.内存.硬盘的性能对处理能力有决定性影响. 3. 优化配置 3.1. 配置tomcat管理员账户 ...

- 动态变更GridView控件列名

近段时间,确是很多专案要写,客户的个性化要求也越来越多.举个例子吧,就是从数据库取出来的字段名,在显示在GridView时,需要全部更为另外一个名称.下面的样例,并非是专案的内容,而是Insus.NE ...

- GS70 使用 Linux 下面Oracle数据库时 设定 特定目录存储数据文件

1. 创建目录 mkdir /cwdata 2. 修改目录属性 chown -R oracle:oinstall /cwdata chmod -R /cwdata 效果为: 创建数据库实例时的界面为: ...

- 在eclipse中使用hadoop插件

我的配置环境看我的上篇博文. 配置过程: (1)把插件放到eclipse/plugins目录下.(我的版本上一篇也有) )重启eclipse,配置Hadoop installation directo ...

- 最长双回文串——manacehr

题目 [题目描述] 顺序和逆序读起来完全一样的串叫做回文串.比如 acbca 是回文串,而 abc 不是(abc 的顺序为 “abc”,逆序为 “cba”,不相同).输入长度为 n 的串 S,求 S ...

- Jmeter-逻辑控制器之Foreach

ForEach 作用:用来遍历当前元素的所有可执行场景:在用户自定义变量中读取一系列相关的变量,该控制器下的采样器或控制器都会被执行一次或多次,每次读取不同的变量值: 输入变量前缀:在其中输入需要遍历 ...

- 老男孩Day6作业:计算器

作业需求: 1.实现加减乘除及拓号优先级解析 2.用户输入 1 - 2 * ( (60-30 +(-40/5) * (9-2*5/3 + 7 /3*99/4*2998 +10 * 568/14 )) ...

- jupyter notebook 设置默认目录

1.打开 cmd 输入命令 jupyter notebook --generate-config 可以看到生成文件的路径,这个就是生成的配置文件jupyter_notebook_config.py, ...

- 14.链表中倒数第k个节点

题目描述: 输入一个链表,输出该链表中倒数第k个结点. 思路分析: 设置两个指针,一个fast一个slow,都从链表头开始,让fast先走k步,然后两个指针一起走,当fast走到尾部,那么sl ...

- kuangbin专题七 HDU3974 Assign the task (dfs时间戳建树)

There is a company that has N employees(numbered from 1 to N),every employee in the company has a im ...