python学习(十六)写爬虫爬取糗事百科段子

原文链接:爬取糗事百科段子

利用前面学到的文件、正则表达式、urllib的知识,综合运用,爬取糗事百科的段子

先用urllib库获取糗事百科热帖第一页的数据。并打开文件进行保存,正好可以熟悉一下之前学过的文件知识。

from urllib import request, parse

from urllib import error

page = 1

url = 'https://www.qiushibaike.com/hot/page/'+str(page)

user_agent = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'

try:

req = request.Request(url)

req.add_header('User-Agent', user_agent)

response = request.urlopen(req)

#bytes变为字符串

content = response.read().decode('utf-8')

print(type(content))

#uf-8编码方式打开

file = open('file.txt', 'w',encoding='utf-8') file.write(content) except error.URLError as e:

if hasattr(e,'code'):

print (e.code)

if hasattr(e,'reason'):

print (e.reason)

finally:

file.close()

下面要用到学过的正则表达式的知识,过滤掉没有用的信息,只获取评论数,作者,正文,以及点赞的数量。打开文件可以看到如下内容:

div class=”article block untagged mb15 typs_long” id=’qiushi_tag_119848276’表示一个文章的开始,id为文章对应的id,

h2 之间的是发布者的姓名‘高老庄福帅猪刚鬣’,span与/span之间的是正文, i class=”number”与/i,635表示赞的个数,

同样也可以获取评论的个数。

import re

with open('file.txt','r', encoding='utf-8') as f:

data = f.read()

pattern = re.compile(r'<div.*?<h2>(.*?)</h2>.*?<span>(.*?)</span>.*?number">(.*?)</i>.*?'+

r'"number">(.*?)</i>', re.S )

result = re.search(pattern, data)

#print(result)

#print(result.group())

print(result.group(1))

print(result.group(2))

print(result.group(3))

print(result.group(4))

re.compile(),参数re.S表示将.的作用扩充为任意字符,因为前几篇文章讲述过.在一般情况下匹配除/n之外的所有字符。

正则表达式中.*?连起来匹配任意字符,且为非贪婪模式。因为.表示任意字符,*表示匹配前一个字符0个或多个,.*表示匹配任意多个字符,而加上?表示非贪婪模式。

re.search是搜索匹配正则表达式规则的条目,search讲述过可以从内容的任意位置查找。这样就可以找到一个符合这种规则

的段子。如果找到所有符合规则的段子可以用re.findall进行查找。

下面一气呵成,将网站上的段子按照正则表达式匹配,并将匹配后的段子写入文件,同时在终端显示。

from urllib import request, parse

from urllib import error

page = 1

url = 'https://www.qiushibaike.com/hot/page/'+str(page)

user_agent = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'

try:

req = request.Request(url)

req.add_header('User-Agent', user_agent)

response = request.urlopen(req)

#bytes变为字符串

content = response.read().decode('utf-8')

pattern = re.compile(r'<div.*?<h2>(.*?)</h2>.*?<span>(.*?)</span>.*?number">(.*?)</i>.*?'+

r'"number">(.*?)</i>', re.S )

result = re.findall(pattern, content)

files = open('findfile.txt','w+', encoding='utf-8')

for item in result:

author = item[0]

contant = item[1]

vote = '赞:'+item[2]

commit = '评论数:'+item[3]

infos = vote +' '+commit+' '+'\n\n'

print(author)

print(contant)

print(infos)

files.write(author)

files.write(contant)

files.write(infos) except error.URLError as e:

if hasattr(e,'code'):

print (e.code)

if hasattr(e,'reason'):

print (e.reason)

finally:

files.close()

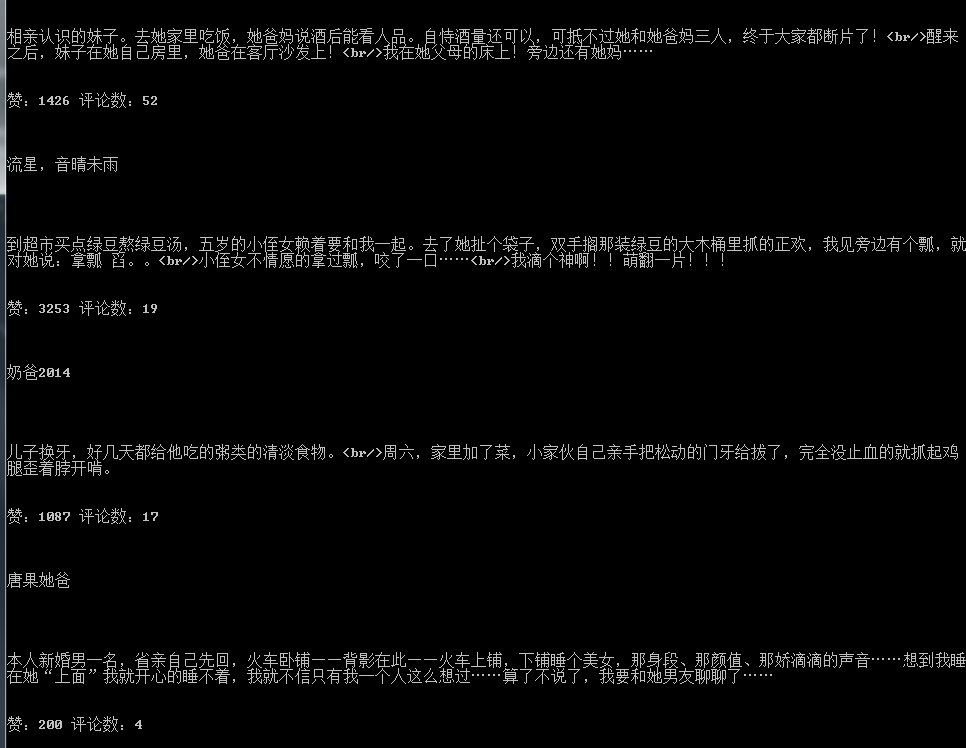

效果如下:

我的公众号:

python学习(十六)写爬虫爬取糗事百科段子的更多相关文章

- Python爬虫爬取糗事百科段子内容

参照网上的教程再做修改,抓取糗事百科段子(去除图片),详情见下面源码: #coding=utf-8#!/usr/bin/pythonimport urllibimport urllib2import ...

- Python爬虫-爬取糗事百科段子

闲来无事,学学python爬虫. 在正式学爬虫前,简单学习了下HTML和CSS,了解了网页的基本结构后,更加快速入门. 1.获取糗事百科url http://www.qiushibaike.com/h ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- 8.Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- [爬虫]用python的requests模块爬取糗事百科段子

虽然Python的标准库中 urllib2 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 “HTTP for Humans”,说明使用更 ...

- python爬取糗事百科段子

初步爬取糗事百科第一页段子(发布人,发布内容,好笑数和评论数) #-*-coding:utf--*- import urllib import urllib2 import re page = url ...

- Python爬虫实战之爬取糗事百科段子【华为云技术分享】

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- 芝麻HTTP:Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

随机推荐

- CentOS7.2 部署Haproxy 1.7.2

原文发表于cu:2017-03-16 参考文档: haproxy:http://www.haproxy.org/ 本文涉及haproxy的安装,并做简单配置. 一.环境准备 1. 操作系统 CentO ...

- java学习笔记-01.对象入门

1.面向对象编程简称是OOP. 2.继承是通过 extends关键字实现的,接口是通过implements关键字实现的. 3.public:意味着后续的定义任何人均可使用. private:意味着除了 ...

- Python常用模块之VideoCapture

官方网址:http://videocapture.sourceforge.net/ 功能介绍: VideoCapture是Win32版Python的一个扩展,可以访问视频采集设备(如USB摄像头) ...

- Hibernate入门篇<1>hibernate.cfg.xml学习小结

Hibernate配置文件主要用于配置数据库连接和Hibernate运行时所需的各种属性,这个配置文件应该位于应用程序或Web程序的类文件夹 classes中.Hibernate配置文件支持两种形式, ...

- arcgis--arcmap导出点的X,Y坐标

arcmap操作的

- Python Requests库简单入门

我对Python网络爬虫的学习主要是基于中国慕课网上嵩天老师的讲授,写博客的目的是为了更好触类旁通,并且作为学习笔记之后复习回顾. 1.引言 requests 库是一个简洁且简单的处理HTTP请求的第 ...

- java 中的 i=i++

记得大学刚开始学C语言时,老师就说:自增有两种形式,分别是i++和++i,i++表示的是先赋值后加1,++i是先加1后赋值,这样理解了很多年也没出现问题,直到遇到如下代码,我才怀疑我的理解是不是错了: ...

- HDU 5636 Shortest Path

题目链接: http://acm.hdu.edu.cn/showproblem.php?pid=5636 题解: 1.暴力枚举: #include<cmath> #include<c ...

- HDU 5228 ZCC loves straight flush 暴力

题目链接: hdu:http://acm.hdu.edu.cn/showproblem.php?pid=5228 bc(中文):http://bestcoder.hdu.edu.cn/contests ...

- jdbc 5.0

1.事务 事务将单个SQL语句或一组SQL语句视为一个逻辑单元,如果任何语句失败,整个事务将失败. jdbc的MySQL驱动程序中的事务默认是自动提交. 默认情况下,每个SQL语句在完成后都会提交到数 ...