Gluon 实现 dropout 丢弃法

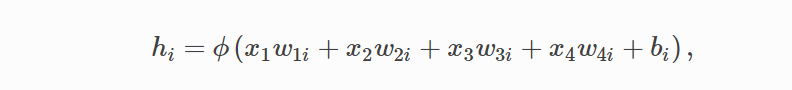

多层感知机中:

hi 以 p 的概率被丢弃,以 1-p 的概率被拉伸,除以 1 - p

import mxnet as mx

import sys

import os

import time

import gluonbook as gb

from mxnet import autograd,init

from mxnet import nd,gluon

from mxnet.gluon import data as gdata,nn

from mxnet.gluon import loss as gloss '''

# 模型参数

num_inputs, num_outputs, num_hiddens1, num_hiddens2 = 784,10,256,256 W1 = nd.random.normal(scale=0.01,shape=(num_inputs,num_hiddens1))

b1 = nd.zeros(num_hiddens1) W2 = nd.random.normal(scale=0.01,shape=(num_hiddens1,num_hiddens2))

b2 = nd.zeros(num_hiddens2) W3 = nd.random.normal(scale=0.01,shape=(num_hiddens2,num_outputs))

b3 = nd.zeros(num_outputs) params = [W1,b1,W2,b2,W3,b3] for param in params:

param.attach_grad() # 定义网络 '''

# 读取数据

# fashionMNIST 28*28 转为224*224

def load_data_fashion_mnist(batch_size, resize=None, root=os.path.join(

'~', '.mxnet', 'datasets', 'fashion-mnist')):

root = os.path.expanduser(root) # 展开用户路径 '~'。

transformer = []

if resize:

transformer += [gdata.vision.transforms.Resize(resize)]

transformer += [gdata.vision.transforms.ToTensor()]

transformer = gdata.vision.transforms.Compose(transformer)

mnist_train = gdata.vision.FashionMNIST(root=root, train=True)

mnist_test = gdata.vision.FashionMNIST(root=root, train=False)

num_workers = 0 if sys.platform.startswith('win32') else 4

train_iter = gdata.DataLoader(

mnist_train.transform_first(transformer), batch_size, shuffle=True,

num_workers=num_workers)

test_iter = gdata.DataLoader(

mnist_test.transform_first(transformer), batch_size, shuffle=False,

num_workers=num_workers)

return train_iter, test_iter # 定义网络

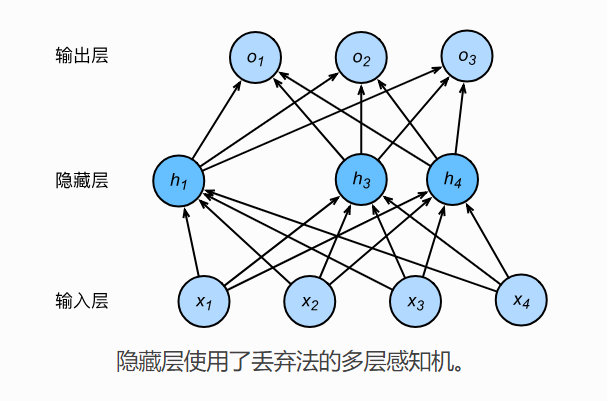

drop_prob1,drop_prob2 = 0.2,0.5

# Gluon版

net = nn.Sequential()

net.add(nn.Dense(256,activation="relu"),

nn.Dropout(drop_prob1),

nn.Dense(256,activation="relu"),

nn.Dropout(drop_prob2),

nn.Dense(10)

)

net.initialize(init.Normal(sigma=0.01)) # 训练模型 def accuracy(y_hat, y):

return (y_hat.argmax(axis=1) == y.astype('float32')).mean().asscalar()

def evaluate_accuracy(data_iter, net):

acc = 0

for X, y in data_iter:

acc += accuracy(net(X), y)

return acc / len(data_iter) def train(net, train_iter, test_iter, loss, num_epochs, batch_size,

params=None, lr=None, trainer=None):

for epoch in range(num_epochs):

train_l_sum = 0

train_acc_sum = 0

for X, y in train_iter:

with autograd.record():

y_hat = net(X)

l = loss(y_hat, y)

l.backward()

if trainer is None:

gb.sgd(params, lr, batch_size)

else:

trainer.step(batch_size) # 下一节将用到。

train_l_sum += l.mean().asscalar()

train_acc_sum += accuracy(y_hat, y)

test_acc = evaluate_accuracy(test_iter, net)

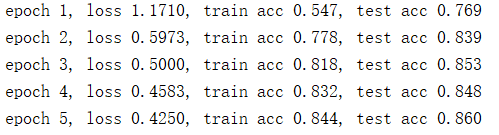

print('epoch %d, loss %.4f, train acc %.3f, test acc %.3f'

% (epoch + 1, train_l_sum / len(train_iter),

train_acc_sum / len(train_iter), test_acc)) num_epochs = 5

lr = 0.5

batch_size = 256

loss = gloss.SoftmaxCrossEntropyLoss()

train_iter, test_iter = load_data_fashion_mnist(batch_size) trainer = gluon.Trainer(net.collect_params(),'sgd',{'learning_rate':lr})

train(net,train_iter,test_iter,loss,num_epochs,batch_size,None,None,trainer)

Gluon 实现 dropout 丢弃法的更多相关文章

- 【神经网络】丢弃法(dropout)

丢弃法是一种降低过拟合的方法,具体过程是在神经网络传播的过程中,随机"沉默"一些节点.这个行为让模型过度贴合训练集的难度更高. 添加丢弃层后,训练速度明显上升,在同样的轮数下测试集 ...

- MXNET:丢弃法

除了前面介绍的权重衰减以外,深度学习模型常常使用丢弃法(dropout)来应对过拟合问题. 方法与原理 为了确保测试模型的确定性,丢弃法的使用只发生在训练模型时,并非测试模型时.当神经网络中的某一层使 ...

- 小白学习之pytorch框架(6)-模型选择(K折交叉验证)、欠拟合、过拟合(权重衰减法(=L2范数正则化)、丢弃法)、正向传播、反向传播

下面要说的基本都是<动手学深度学习>这本花书上的内容,图也采用的书上的 首先说的是训练误差(模型在训练数据集上表现出的误差)和泛化误差(模型在任意一个测试数据集样本上表现出的误差的期望) ...

- dropout——gluon

https://blog.csdn.net/lizzy05/article/details/80162060 from mxnet import nd def dropout(X, drop_prob ...

- 动手学深度学习14- pytorch Dropout 实现与原理

方法 从零开始实现 定义模型参数 网络 评估函数 优化方法 定义损失函数 数据提取与训练评估 pytorch简洁实现 小结 针对深度学习中的过拟合问题,通常使用丢弃法(dropout),丢弃法有很多的 ...

- 神经网络优化算法:Dropout、梯度消失/爆炸、Adam优化算法,一篇就够了!

1. 训练误差和泛化误差 机器学习模型在训练数据集和测试数据集上的表现.如果你改变过实验中的模型结构或者超参数,你也许发现了:当模型在训练数据集上更准确时,它在测试数据集上却不⼀定更准确.这是为什么呢 ...

- 从头学pytorch(七):dropout防止过拟合

上一篇讲了防止过拟合的一种方式,权重衰减,也即在loss上加上一部分\(\frac{\lambda}{2n} \|\boldsymbol{w}\|^2\),从而使得w不至于过大,即不过分偏向某个特征. ...

- dropout总结

1.伯努利分布:伯努利分布亦称“零一分布”.“两点分布”.称随机变量X有伯努利分布, 参数为p(0<p<1),如果它分别以概率p和1-p取1和0为值.EX= p,DX=p(1-p). 2. ...

- mxnet(gluon)—— 模型、数据集、损失函数、优化子等类、接口大全

1. 数据集 dataset_train = gluon.data.ArrayDataset(X_train, y_train) data_iter = gluon.data.DataLoader(d ...

随机推荐

- [转]微信小程序联盟 跳坑《一百八十一》设置API:wx.openSetting使用说明

本文转自:http://www.wxapp-union.com/forum.php?mod=viewthread&tid=4066 这个API解决了过去一个长久以来无法解决的问题,如何让用户重 ...

- [javaEE] 三层架构案例-用户模块(一)

用户注册登录注销 Servlet+JSP+javaBean+dom4j 分层结构: com.tsh.web com.tsh.service com.tsh.dao com.tsh.domain com ...

- 十三、nginx 强制下载txt等文件

当前的浏览器能够识别文件格式,如果浏览器本身能够解析就会默认打开,如果不能解析就会下载该文件. 那么使用nginx做资源服务器的时候,如何强制下载文件呢? location /back/upload/ ...

- 前端js动画收藏

值得收藏的动画

- 深入理解jQuery插件开发总结(一)

由于这篇文章比较长,所以分了四个阶段讲,从简单的入门级到最后到综合级,有些列子和图片都是转载其他博主的,希望对想写插件对同学会有帮助.这里分享个好久之前写的一个jquery插件(网站的功能引导插件,思 ...

- sql: TRIGGER

--Common Table Expressions(CTE) WITH HighSample (SampleId,SampleTitle,SampleContent) AS ( SELECT Sam ...

- log在无法调试代码时的妙用

1. 如果修改源代码 通过加入log打印日志 可以判断程序走的流程 找到需要自定义修改的位置(如修改java编写的项目 ApacheDS ) 2. 如果java调用dll文件 出错了 排错的方式也可以 ...

- ios的白屏坑

请参考http://www.fly63.com/article/detial/287

- Python基础-继承与派生

一.继承 继承是一种创建新的类的方式,在python中,新建的类可以继承自一个或者多个父类,原始类称为基类或超类,新建的类称为派生类或子类. python中类的继承分为:单继承和多继承 class P ...

- unity中Animation与Animator的区别

Animation:单一动画,一般使用在单一动画播放.占用资源小. Animator:多个动画,可用控制器切换多个动画播放.占用资源大.