使用request爬取拉钩网信息

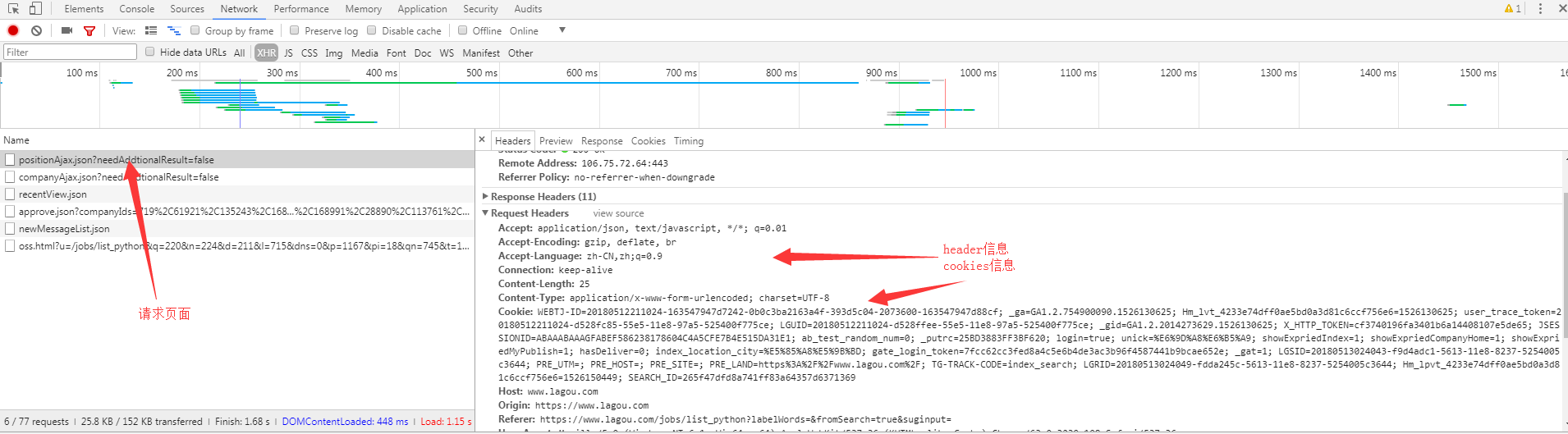

通过cookies信息爬取

分析header和cookies

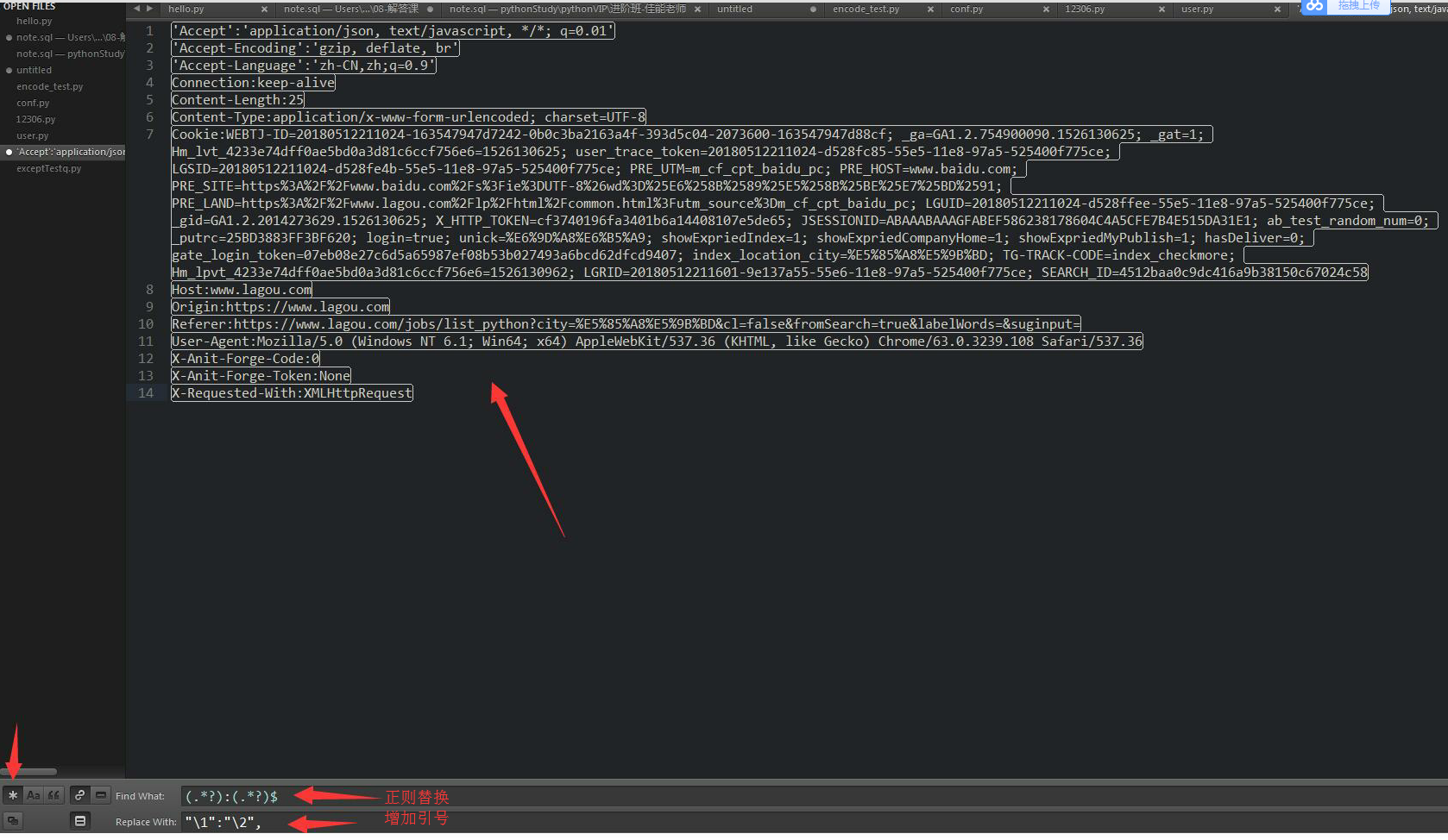

通过subtext粘贴处理header和cookies信息

处理后,方便粘贴到代码中

爬取拉钩信息代码

import requests

class LagouSpider(object):

def __init__(self):

self.url ='https://www.lagou.com/jobs/positionAjax.json?needAddtionalResult=false'

self.headers ={

"Accept":"application/json, text/javascript, */*; q=0.01",

"Accept-Encoding":"gzip, deflate, br",

"Accept-Language":"zh-CN,zh;q=0.9",

"Connection":"keep-alive",

"Content-Length":"",

"Content-Type":"application/x-www-form-urlencoded; charset=UTF-8",

"Cookie":"", #根据每个人登录信息填写

"Host":"www.lagou.com",

"Origin":"https://www.lagou.com",

"Referer":"https://www.lagou.com/jobs/list_python?city=%E5%85%A8%E5%9B%BD&cl=false&fromSearch=true&labelWords=&suginput=",

"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.108 Safari/537.36",

"X-Anit-Forge-Code":"",

"X-Anit-Forge-Token":"None",

"X-Requested-With":"XMLHttpRequest"

}

self.offset = 0

self.data = {

"first":'true',

"pn":0, # 页数请求

"kd":'python' # 查询关键字

}

self.pos_li = []

self.total = 0

self.pageNo = 0

self.resultSize = 0

def start_request_total(self):

"""

得到拉钩网页数信息

:return:

"""

response = requests.post(url=self.url, headers=self.headers, data=self.data)

html = response.json()

# 得到拉钩工作信息总数

print(html['content']['positionResult'])

self.total = html['content']['positionResult']['totalCount']

# 得到拉钩工作信息每页展示数

self.resultSize = html['content']['positionResult']['resultSize']

# 从0开始

self.pageNo = int(self.total / self.resultSize) if self.total % self.resultSize > 0 else int(self.total / self.resultSize)-1

print(self.pageNo)

print(len(html['content']['positionResult']['result']))

def start_request(self):

"""

得到拉钩每页工作信息

:return:

"""

response = requests.post(url=self.url, headers=self.headers, data=self.data)

html = response.json()

# 得到拉钩工作信息

print(html['content']['positionResult']['result'])

self.pos_li.append(html['content']['positionResult']['result'])

def main(self):

self.start_request_total()

for i in range(self.pageNo):

self.start_request()

print(len(self.pos_li)) # 得到页数

if __name__ == '__main__':

la = LagouSpider()

la.main()

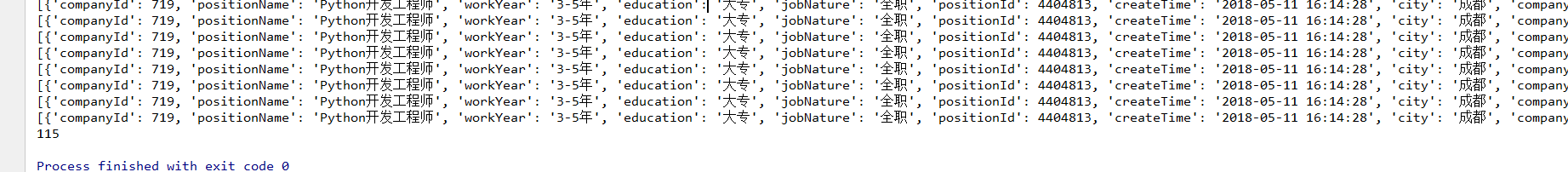

展示结果

使用request爬取拉钩网信息的更多相关文章

- Python3 Scrapy + Selenium + 阿布云爬取拉钩网学习笔记

1 需求分析 想要一个能爬取拉钩网职位详情页的爬虫,来获取详情页内的公司名称.职位名称.薪资待遇.学历要求.岗位需求等信息.该爬虫能够通过配置搜索职位关键字和搜索城市来爬取不同城市的不同职位详情信息, ...

- selelinum+PhantomJS 爬取拉钩网职位

使用selenium+PhantomJS爬取拉钩网职位信息,保存在csv文件至本地磁盘 拉钩网的职位页面,点击下一页,职位信息加载,但是浏览器的url的不变,说明数据不是发送get请求得到的. 我们不 ...

- 爬取拉钩网上所有的python职位

# 2.爬取拉钩网上的所有python职位. from urllib import request,parse import json,random def user_agent(page): #浏览 ...

- python爬虫(三) 用request爬取拉勾网职位信息

request.Request类 如果想要在请求的时候添加一个请求头(增加请求头的原因是,如果不加请求头,那么在我们爬取得时候,可能会被限制),那么就必须使用request.Request类来实现,比 ...

- Python 爬取拉钩网工作岗位

如果拉钩网html页面做了调整,需要重新调整代码 代码如下 #/usr/bin/env python3 #coding:utf-8 import sys import json import requ ...

- ruby 爬虫爬取拉钩网职位信息,产生词云报告

思路:1.获取拉勾网搜索到职位的页数 2.调用接口获取职位id 3.根据职位id访问页面,匹配出关键字 url访问采用unirest,由于拉钩反爬虫,短时间内频繁访问会被限制访问,所以没有采用多线程, ...

- 【实战】用request爬取拉勾网职位信息

from urllib import request import urllib import ssl import json url = 'https://www.lagou.com/jobs/po ...

- 使用nodejs爬取拉勾苏州和上海的.NET职位信息

最近开始找工作,本人苏州,面了几家都没有结果很是伤心.在拉勾上按照城市苏州关键字.NET来搜索一共才80来个职位,再用薪水一过滤,基本上没几个能投了.再加上最近苏州的房价蹭蹭的长,房贷压力也是非常大, ...

- 爬虫基本库request使用—爬取猫眼电影信息

使用request库和正则表达式爬取猫眼电影信息. 1.爬取目标 猫眼电影TOP100的电影名称,时间,评分,等信息,将结果以文件存储. 2.准备工作 安装request库. 3.代码实现 impor ...

随机推荐

- VS2015秘钥

Visual Studio Professional 2015简体中文版(专业版)KEY:HMGNV-WCYXV-X7G9W-YCX63-B98R2Visual Studio Enterprise 2 ...

- 循环TRUNCATE表,再ENABLE约束索引等

CREATE OR REPLACE PROCEDURE STG.FP_REMOVE_MST_OLD_DATA (EXITCODE OUT NUMBER) IS /******************* ...

- poj3273(二分)

题目链接:https://vjudge.net/problem/POJ-3273 题意:给定n个数,将这n个数划分成m块,问所有块最大值的最小是多少. 思路:注意到所求值最大为109,所以可以用二分来 ...

- linux 查找java程序、杀死、重启

查看java进程 ps -ef|grep java杀死进程 kill -9 4834 (进程号)启动 java -jar xxx.jar & (后台会一直运行)

- vue js库的条件渲染

条件渲染 通过条件指令可以控制元素的创建(显示)或者销毁(隐藏),常用的条件指令如下: v-if v-if可以控制元素的创建或者销毁 <h1 v-if="ok">Yes ...

- python—切片

切片就是list取值的一种方式 l = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10] print(l[1:5]) #取值方式顾头不顾尾 print(l[:5]) #冒号 前面 没写代 ...

- [leetcode]64. Minimum Path Sum最小路径和

Given a m x n grid filled with non-negative numbers, find a path from top left to bottom right which ...

- Django-ConttentType

一 content-type 在django中,有一个记录了项目中所有model元数据的表,就是ContentType,表中一条记录对应着一个存在的model,所以可以通过一个ContentType表 ...

- spring boot项目升级到2.0.1,提示java.lang.ClassNotFoundException: org.apache.log4j.Logger错误

首先肯定是版本出现了一点兼容问题 所以我就进入项目,查看依赖树,cd到项目目录下,mvn dependency:tree 我看到我的项目原先是1.5.9和现在2.0.1的区别在于org.slf4j的依 ...

- Innodb IO优化-配置优化

作者:吴炳锡 来源:http://www.mysqlsupport.cn/ 联系方式: wubingxi#gmail.com 转载请注明作/译者和出处,并且不能用于商业用途,违者必究. 对于数据库来讲 ...