大数据Hadoop平台安装及Linux操作系统环境配置

配置 Linux 系统基础环境

查看服务器的IP地址

设置服务器的主机名称

hostnamectl set-hostname hadoop

hostname可查看

绑定主机名与IP 地址

vim /etc/hosts

写入:

ip hadoop #自己虚拟机ip和主机名

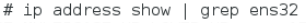

查看SSH 服务状态

- SSH 为 Secure Shell 的缩写,是专为远程登录会话和其他网络服务提供安

全性的协议。一般的用法是在本地计算机安装SSH客服端,在服务器端安装SSH

服务,然后本地计算机利用 SSH 协议远程登录服务器,对服务器进行管理。这

样可以非常方便地对多台服务器进行管理。同时在 Hadoop分布式环境下,集群

中的各个节点之间(节点可以看作是一台主机)需要使用SSH协议进行通信。因

此Linux系统必须安装并启用SSH服务。

命令:systemctl status sshd

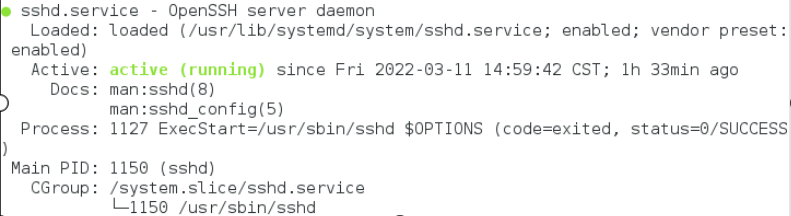

关闭防火墙

- Hadoop可以使用Web页面进行管理,但需要关闭防火墙,否则打不开Web页

面。同时不关闭防火墙也会造成 Hadoop 后台运行脚本出现莫名其妙的错误。

关闭命令如下:

查看状态为:

- 看到inactive (dead)就表示防火墙已经关闭。不过这样设置后,Linux系

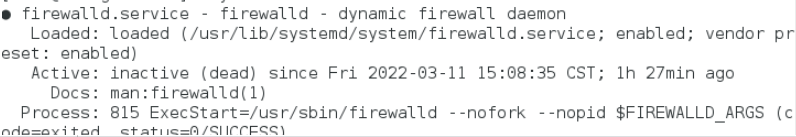

统如果重启,防火墙仍然会重新启动。执行如下命令可以永久关闭防火墙。

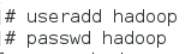

创建hadoop 用户

安装JAVA 环境

下载JDK 安装包

- JDK 安 装 包 需 要 在 Oracle 官 网 下 载 , 下 载 地 址 为 :

https://www.oracle.com/java /technologies /javase-jdk8-downloads.html,本教材采用的Hadoop 2.7.1所需要的JDK版本为JDK7以上,这里采用的安装包为jdk-8u152-linux-x64.tar.gz

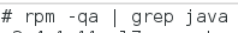

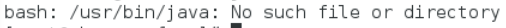

卸载自带OpenJDK

删除相关文件,键入命令

rpm -e --nodeps 安装包名称

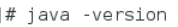

查看删除结果再次键入命令 java -version 出现以下结果表示删除成功

安装JDK

Hadoop 2.7.1 要求 JDK 的版本为 1.7 以上,这里安装的是 JDK1.8 版(即

JAVA 8)。

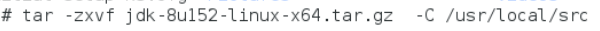

安装命令如下,将安装包解压到/usr/local/src目录下:

解压完成后,查看目录确认一下。可以看出 JDK 安在/usr/local/src/jdk1.8.0_152目录中。

设置 JAVA 环境变量

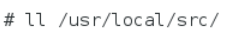

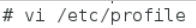

在Linux中设置环境变量的方法比较多,较常见的有两种:一是配置/etc/profile文件,配置结果对整个系统有效,系统所有用户都可以使用;二是配置~/bashrc文件,配置结果仅对当前用户有效。这里使用第一种方法。

在文件的最后增加如下两行:

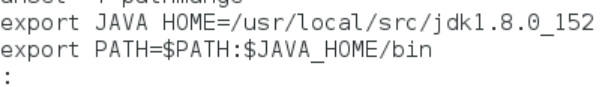

进入vim /etc/profile,在文件结尾添加

# JAVA_HOME指向JAVA安装目录

执行source使设置生效:

- 检查JAVA是否可用

source /etc/profile

echo $JAVA_HOME

- 说明JAVA_HOME已指向JAVA安装目录。能够正常显示Java版本则说明JDK安装并配置成功。

安装Hadoop 软件

获取Hadoop 安装包

- Apache Hadoop 各 个 版 本 的 下 载 网 址 :

https://archive.apache.org/dist/hadoop /common/。本教材选用的事Hadoop2.7.1版本,安装包为hadoop-2.7.1.tar.gz。需要先下载Hadoop安装包,再上传到Linux系统的/opt/software目录。具体的方法见前一节“实验一 Linux操作系统环境设置”,这里就不再赘述。

安装Hadoop 软件

安装命令如下,将安装包解压到/usr/local/src/目录下:

- 解压完成后,查看目录确认一下。可以看出 Hadoop 安装在/usr/local/src/hadoop -2.7.1目录中

- 查看Hadoop目录,得知Hadoop目录内容如下:

- 其中:

bin:此目录中存放Hadoop、HDFS、YARN和MapReduce运行程序和管理软件。

etc:存放Hadoop配置文件。

include: 类似C语言的头文件

lib:本地库文件,支持对数据进行压缩和解压。

libexe:同lib

sbin:Hadoop集群启动、停止命令

share:说明文档、案例和依赖jar包。

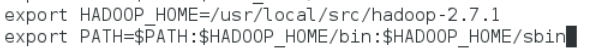

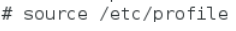

配置 Hadoop 环境变量

和设置JAVA环境变量类似,修改/etc/profile文件。

在文件的最后增加如下两行:

HADOOP_HOME指向 JAVA安装目录

执行source使用设置生效:

检查设置是否生效:

出现上述Hadoop帮助信息就说明Hadoop已经安装好了。

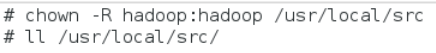

修改目录所有者和所有者组

上述安装完成的 Hadoop 软件只能让 root 用户使用,要让 hadoop 用户能够运行Hadoop软件,需要将目录/usr/local/src的所有者改为hadoop用户。

/usr/local/src目录的所有者已经改为hadoop了

安装单机版 Hadoop 系统

配置 Hadoop 配置文件

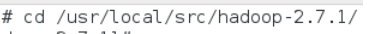

进入Hadoop目录

配置hadoop-env.sh文件,目的是告诉Hadoop系统JDK的安装目录

在文件中查找export JAVA_HOME这行,将其改为如下所示内容

这样就设置好Hadoop的本地模式,下面使用官方案例来测试Hadoop是否运

行正常。

测试 Hadoop 本地模式的运行

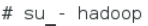

切换到hadoop 用户

- 使用hadoop这个用户来运行Hadoop软件

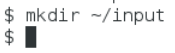

创建输入数据存放目录

- 将输入数据存放在~/input目录(hadoop用户主目录下的input目录中)

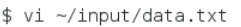

创建数据输入文件

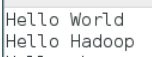

- 创建数据文件data.txt,将要测试的数据内容输入到data.txt文件中

- 输入如下内容,保存退出:

测试 MapReduce 运行

运行 WordCount 官方案例,统计 data.txt 文件中单词的出现频度。这个案例可以用来统计年度十大热销产品、年度风云人物、年度最热名词等。命令如下:

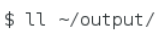

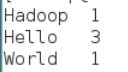

- 运行结果保存在~/output目录中,命令执行后查看结果:

- 文件_SUCCESS表示处理成功,处理的结果存放在part-r-00000文件中,查看该文件。

可以看出统计结果正确,说明 Hadoop 本地模式运行正常。读者可将这个运行结果与“3.2.3 MapReduce”中的WordCount案例运行过程进行对照,来加深对MapReduce框架的理解。

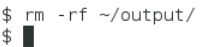

注意:输出目录不能事先创建,如果已经有 ~/output 目录,就要选择另外的输出目录,或者将 ~/output 目录先删除。删除命令如下所示。

大数据Hadoop平台安装及Linux操作系统环境配置的更多相关文章

- OpenStack-Ocata版+CentOS7.6 云平台环境搭建 — 1.操作系统环境配置

1.OpenStack示例的架构介绍 1.1 各节点介绍 (1)控制节点(controller)控制节点(controller)上运行身份服务,镜像服务,计算节点管理,网络管理,各种网络代理和仪表板. ...

- 大数据Hadoop入门教程 | (二)Linux

使用finalShell可以提供文件目录图形化 完整Linux命令整理参考大佬博客:Linux常见文件管理命令 - Mr_Walker - 博客园 Linux文件系统基础知识 Linux文件系统概念 ...

- 大数据Hadoop学习之搭建hadoop平台(2.2)

关于大数据,一看就懂,一懂就懵. 一.概述 本文介绍如何搭建hadoop分布式集群环境,前面文章已经介绍了如何搭建hadoop单机环境和伪分布式环境,如需要,请参看:大数据Hadoop学习之搭建had ...

- CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- 云计算分布式大数据Hadoop实战高手之路第八讲Hadoop图文训练课程:Hadoop文件系统的操作实战

本讲通过实验的方式讲解Hadoop文件系统的操作. “云计算分布式大数据Hadoop实战高手之路”之完整发布目录 云计算分布式大数据实战技术Hadoop交流群:312494188,每天都会在群中发布云 ...

- 成都大数据Hadoop与Spark技术培训班

成都大数据Hadoop与Spark技术培训班 中国信息化培训中心特推出了大数据技术架构及应用实战课程培训班,通过专业的大数据Hadoop与Spark技术架构体系与业界真实案例来全面提升大数据工程师 ...

- 大数据计算平台Spark内核解读

1.Spark介绍 Spark是起源于美国加州大学伯克利分校AMPLab的大数据计算平台,在2010年开源,目前是Apache软件基金会的顶级项目.随着 Spark在大数据计算领域的暂露头角,越来越多 ...

- 14周事情总结-机器人-大数据hadoop

14周随着考试的进行,其他该准备的事情也在并行的处理着,考试内容这里不赘述了 首先说下,关于机器人大赛的事情,受益颇多,机器人的制作需要机械和电控两方面 昨天参与舵机的测试,遇到的问题:舵机不动 排查 ...

- 大数据计算平台Spark内核全面解读

1.Spark介绍 Spark是起源于美国加州大学伯克利分校AMPLab的大数据计算平台,在2010年开源,目前是Apache软件基金会的顶级项目.随着Spark在大数据计算领域的暂露头角,越来越多的 ...

随机推荐

- Java集合框架(四)-HashMap

1.HashMap特点 存放的元素都是键值对(key-value),key是唯一的,value是可以重复的 存放的元素也不保证添加的顺序,即是无序的 存放的元素的键可以为null,但是只能有一个key ...

- HMS Core新闻行业解决方案:让技术加上人文的温度

开发者们,你希望用户如何获取新闻? 有的人靠手机弹窗知天下事,有的人则在新闻应用中尽览每一篇文章:有的人一目十行,有的人则喜欢细细咀嚼:有的人主动探索,有的人则想要应用投其所好. 科技在不断刷新着用户 ...

- BUUCTF-荷兰宽带数据泄露

荷兰宽带数据泄露 下载后发现是个BIN文件,之前也是做过类似的题目 RouterPassview打开BIn文件即可,搜索username或者password. 最后flag是username

- 理论+案例,带你掌握Angular依赖注入模式的应用

摘要:介绍了Angular中依赖注入是如何查找依赖,如何配置提供商,如何用限定和过滤作用的装饰器拿到想要的实例,进一步通过N个案例分析如何结合依赖注入的知识点来解决开发编程中会遇到的问题. 本文分享自 ...

- SAP Web Dynpro - 教程

SAP Web Dynpro是一种标准的SAP UI技术,用于使用图形工具和与ABAP工作台集成的开发环境来开发Web应用程序. 图形工具的使用减少了实施工作,并有助于维护ABAP工作台中的组件. 本 ...

- .NET6接入Skywalking链路追踪完整流程

一.Skywalking介绍 Skywalking是一款分布式链路追踪组件,什么是链路追踪? 随着微服务架构的流行,服务按照不同的维度进行拆分,一次请求往往需要涉及到多个服务.互联网应用构建在不同的软 ...

- 『现学现忘』Docker基础 — 39、实战:自定义Tomcat9镜像

目录 1.目标 2.准备 3.编写Dockerfile文件 4.构建镜像 5.启动镜像 6.验证容器是否能够访问 7.向容器中部署WEB项目,同时验证数据卷挂载 (1)准备一个简单的WEB项目 (2) ...

- iOS OC纯代码企业级项目实战之我的云音乐(持续更新))

简介 这是一个使用OC语言,从0使用纯代码方式开发一个iOS平台,接近企业级商业级的项目(我的云音乐),课程包含了基础内容,高级内容,项目封装,项目重构等知识:主要是讲解如何使用系统功能,流行的第三方 ...

- Collection集合和Collection集合常用功能

Collection集合常用功能 方法: boolean add(E e); 向集合中添加元素 boolean remove(E e); 删除集合中的某个元素 void clear(); 清空集合所有 ...

- 配置git的ssh

Linux,Windows就在git bash here里面输 ① 初始化git账户 git config --global user.name "Eisen" git confi ...