boxcox1p归一化+pipeline+StackingCVRegressor

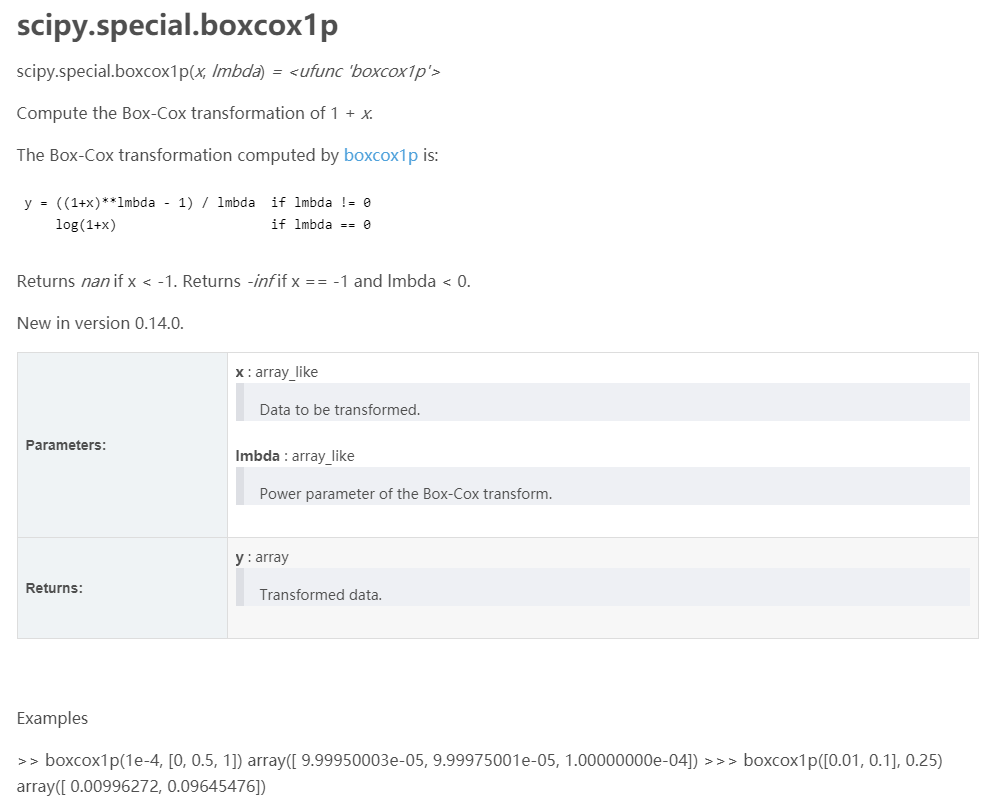

找到最好的那个参数lmbda。

from mlxtend.regressor import StackingCVRegressor

from sklearn.datasets import load_boston

from sklearn.svm import SVR

from sklearn.linear_model import Lasso

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import cross_val_score

import numpy as np

RANDOM_SEED = 42

X, y = load_boston(return_X_y=True)

svr = SVR(kernel='linear')

lasso = Lasso()

rf = RandomForestRegressor(n_estimators=5,

random_state=RANDOM_SEED)

# The StackingCVRegressor uses scikit-learn's check_cv

# internally, which doesn't support a random seed. Thus

# NumPy's random seed need to be specified explicitely for

# deterministic behavior

np.random.seed(RANDOM_SEED)

stack = StackingCVRegressor(regressors=(svr, lasso, rf),

meta_regressor=lasso)

print('5-fold cross validation scores:\n')

for clf, label in zip([svr, lasso, rf, stack], ['SVM', 'Lasso','Random Forest','StackingClassifier']):

scores = cross_val_score(clf, X, y, cv=5)

print("R^2 Score: %0.2f (+/- %0.2f) [%s]" % (scores.mean(), scores.std(), label))

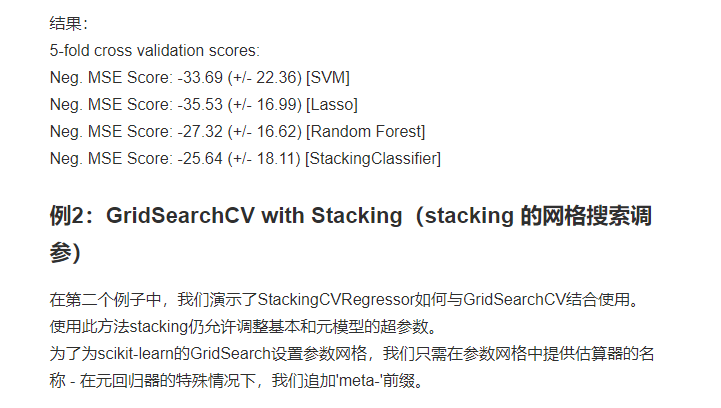

5-fold cross validation scores:

R^2 Score: 0.45 (+/- 0.29) [SVM]

R^2 Score: 0.43 (+/- 0.14) [Lasso]

R^2 Score: 0.52 (+/- 0.28) [Random Forest]

R^2 Score: 0.58 (+/- 0.24) [StackingClassifier]

# The StackingCVRegressor uses scikit-learn's check_cv

# internally, which doesn't support a random seed. Thus

# NumPy's random seed need to be specified explicitely for

# deterministic behavior

np.random.seed(RANDOM_SEED)

stack = StackingCVRegressor(regressors=(svr, lasso, rf),

meta_regressor=lasso)

print('5-fold cross validation scores:\n')

for clf, label in zip([svr, lasso, rf, stack], ['SVM', 'Lasso','Random Forest','StackingClassifier']):

scores = cross_val_score(clf, X, y, cv=5, scoring='neg_mean_squared_error')

print("Neg. MSE Score: %0.2f (+/- %0.2f) [%s]"

from mlxtend.regressor import StackingCVRegressor

from sklearn.datasets import load_boston

from sklearn.linear_model import Lasso

from sklearn.linear_model import Ridge

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import GridSearchCV

X, y = load_boston(return_X_y=True)

ridge = Ridge()

lasso = Lasso()

rf = RandomForestRegressor(random_state=RANDOM_SEED)

# The StackingCVRegressor uses scikit-learn's check_cv

# internally, which doesn't support a random seed. Thus

# NumPy's random seed need to be specified explicitely for

# deterministic behavior

np.random.seed(RANDOM_SEED) stack = StackingCVRegressor(regressors=(lasso, ridge),

meta_regressor=rf,

use_features_in_secondary=True)

params = {'lasso__alpha': [0.1, 1.0, 10.0],

'ridge__alpha': [0.1, 1.0, 10.0]} grid = GridSearchCV(

estimator=stack,param_grid={'lasso__alpha': [x/5.0 for x in range(1, 10)],

'ridge__alpha': [x/20.0 for x in range(1, 10)],

'meta-randomforestregressor__n_estimators': [10,100]},

cv=5,

refit=True

) grid.fit(X, y) print("Best: %f using %s" % (grid.best_score_, grid.best_params_)) #Best: 0.673590 using {'lasso__alpha': 0.4, 'meta-randomforestregressor__n_estimators': 10, 'ridge__alpha cv_keys = ('mean_test_score', 'std_test_score', 'params')

for r, _ in enumerate(grid.cv_results_['mean_test_score']):

print("%0.3f +/- %0.2f %r"

% (grid.cv_results_[cv_keys[0]][r],

grid.cv_results_[cv_keys[1]][r] / 2.0,

grid.cv_results_[cv_keys[2]][r]))

if r > 10:

break

print('...') print('Best parameters: %s' % grid.best_params_)

print('Accuracy: %.2f' % grid.best_score_)

boxcox1p归一化+pipeline+StackingCVRegressor的更多相关文章

- 1.3:Render Pipeline and GPU Pipeline

文章著作权归作者所有.转载请联系作者,并在文中注明出处,给出原文链接. 本系列原更新于作者的github博客,这里给出链接. 在学习SubShader之前,我们有必要对 Render Pipeline ...

- sklearn pipeline

sklearn.pipeline pipeline的目的将许多算法模型串联起来,比如将特征提取.归一化.分类组织在一起形成一个典型的机器学习问题工作流. 优点: 1.直接调用fit和predict方法 ...

- 机器学习:多项式回归(scikit-learn中的多项式回归和 Pipeline)

一.scikit-learn 中的多项式回归 1)实例过程 模拟数据 import numpy as np import matplotlib.pyplot as plt x = np.random. ...

- GPU上创建目标检测Pipeline管道

GPU上创建目标检测Pipeline管道 Creating an Object Detection Pipeline for GPUs 今年3月早些时候,展示了retinanet示例,这是一个开源示例 ...

- 【笔记】多项式回归的思想以及在sklearn中使用多项式回归和pipeline

多项式回归以及在sklearn中使用多项式回归和pipeline 多项式回归 线性回归法有一个很大的局限性,就是假设数据背后是存在线性关系的,但是实际上,具有线性关系的数据集是相对来说比较少的,更多时 ...

- 多项式回归 & pipeline & 学习曲线 & 交叉验证

多项式回归就是数据的分布不满足线性关系,而是二次曲线或者更高维度的曲线.此时只能使用多项式回归来拟合曲线.比如如下数据,使用线性函数来拟合就明显不合适了. 接下来要做的就是升维,上面的真实函数是:$ ...

- redis大幅性能提升之使用管道(PipeLine)和批量(Batch)操作

前段时间在做用户画像的时候,遇到了这样的一个问题,记录某一个商品的用户购买群,刚好这种需求就可以用到Redis中的Set,key作为productID,value 就是具体的customerid集合, ...

- Building the Testing Pipeline

This essay is a part of my knowledge sharing session slides which are shared for development and qua ...

- 数据预处理中归一化(Normalization)与损失函数中正则化(Regularization)解惑

背景:数据挖掘/机器学习中的术语较多,而且我的知识有限.之前一直疑惑正则这个概念.所以写了篇博文梳理下 摘要: 1.正则化(Regularization) 1.1 正则化的目的 1.2 正则化的L1范 ...

随机推荐

- 物理CPU,物理核,逻辑CPU,虚拟CPU(vCPU)区别 (转)

在做虚拟化时候,遇到划分CPU的问题,因此考虑到CPU不知道具体怎么划分,查询一些资料后就写成本文. a. 物理CPU:物理CPU是相对于虚拟CPU而言的概念,指实际存在的处理器,就是我们可以看的见, ...

- IM开发通信协议基础知识(一)---TCP、UDP、HTTP、SOCKET

感谢大佬:https://www.cnblogs.com/sixindev/p/4723590.html 下面这些内容不了解也可以进行开发,深入了解一下还是收益良多 区别 TCP.UDP.HTTP.S ...

- 【AGC035D】Add and Remove(脑洞 DP 分治)

题目链接 大意 给出\(N\)个数的序列,每次操作可以选择连续的三个数,将中间的那个数抽出,将另外两个数的数值加上中间那个数的数值. 一直执行以上操作直到只剩最后两个数,求最后两个数的所有可能的和的最 ...

- Solution -「Gym 102798E」So Many Possibilities...

\(\mathcal{Description}\) Link. 给定非负整数序列 \(\{a_n\}\) 和 \(m\),每次随机在 \(\{a\}\) 中取一个非零的 \(a_i\)(保证存 ...

- ConcurrentHashMap (jdk1.7)源码学习

一.介绍 1.Segment(分段锁) 1.1 Segment 容器里有多把锁,每一把锁用于锁容器其中一部分数据,那么当多线程访问容器里不同数据段的数据时,线程间就不会存在锁竞争,从而可以有效的提高并 ...

- 依赖于angular的table组件

组件实现了以下功能 1. 列宽可动态拖动 2. 列数据排序 3. 列过滤 4. 列位置自由调整 除了需要引入angular.js(我用的是1.4.6版本),还需要引用一个angular衍生出来的插件n ...

- Linux性能优化之磁盘I/O性能指标

讨论指标之前,得先解决两个概念:文件系统和磁盘I/O栈. 文件系统是什么?文件系统是在磁盘的基础上,提供了一个用来管理文件的树状结构.简言之,文件系统是树状结构,一种数据结构~逻辑上的概念.磁盘大家都 ...

- Dubbo扩展点应用之四线程池

线程池也是Dubbo自动自适应扩展点之一,也可以自定义线程池.Dubbo中已实现的线程池扩展点有: 其中框架提供的线程池都是通过创建真实的业务线程池进行操作的,目前线程池模型中有两个和Java中线程池 ...

- [LeetCode]1470. 重新排列数组

给你一个数组 nums ,数组中有 2n 个元素,按 [x1,x2,...,xn,y1,y2,...,yn] 的格式排列. 请你将数组按 [x1,y1,x2,y2,...,xn,yn] 格式重新排列, ...

- OpenHarmony移植:如何适配utils子系统之KV存储部件

摘要:本文介绍移植开发板时如何适配utils子系统之KV存储部件,并介绍相关的运行机制原理. 本文分享自华为云社区<OpenHarmony移植案例与原理 - utils子系统之KV存储部件> ...