[Python] 豆瓣电影top250爬虫

1.分析

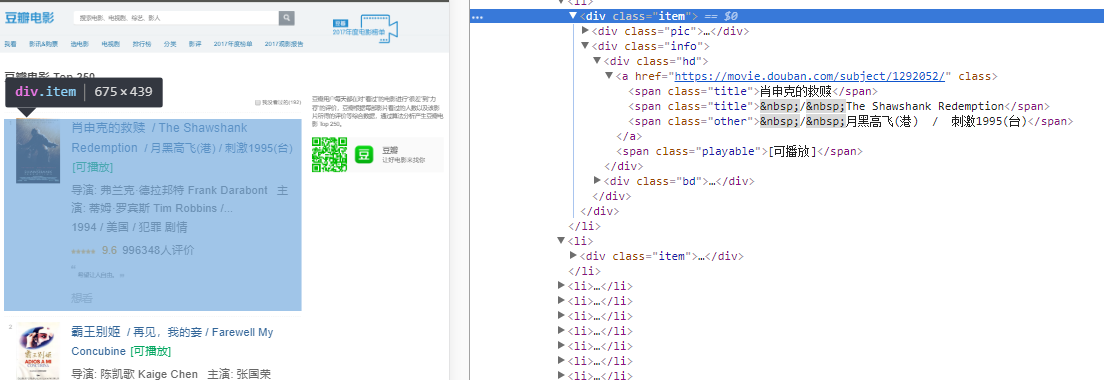

<li><div class="item">电影信息</div></li>

每个电影信息都是同样的格式,毕竟在服务器端是用循环生成的html,这样解析出电影的信息就很简单了

豆瓣电影top250的翻页也很简单,直接就在url上修改一个start就行了,start代表这一页从start+1开始

比如 https://movie.douban.com/top250?start=0&filter=, 就是top1到top25,每页25部电影,翻页把start+=25就行了,一直加到225

2.获取网页的html

使用python内置的urllib库

不过得到的网页中并没有中文,而是会出现这样的字符串

\xe8\xae\xa9\xe5\xa5\xbd\xe7\x94\xb5\xe5\xbd\xb1\xe6\x9d\xa5\xe6\x89\xbe\xe4\xbd\xa0

这是中文的utf-8编码的16进制版本

先将\x去除,变成

e8aea9e5a5bde794b5e5bdb1e69da5e689bee4bda0

然后每6位是一个中文字符

E8 AE A9 让

E5 A5 BD 好

E7 94 B5 电

。。。

全文是【让好电影来找你】

可以在这个网站上输入16进制的UTF-8编码来查找对应字符

def GetHtml(url):

print('Url : '+url)

f = request.urlopen(url.format(start))

data = f.read()

htmls.append(data.decode('utf-8'))

3.解析网页

简单提下XPath的语法

| nodename | 选取此节点的所有子节点。 |

| / | 从根节点选取。 |

| // | 从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。 |

| . | 选取当前节点。 |

| .. | 选取当前节点的父节点。 |

| @ | 选取属性。 |

先解析出<div class="item">,再对这个div中的内容进行第二次解析

这里值得注意的是打印一个element内的html要用etree.tostring()

tree = etree.HTML(str)

result = tree.xpath('//div[@class="item"]') //获取所有<div class="item">元素

print(etree.tostring(result[0], encoding='unicode')) //随便打印一个

打印出来的就是这样的

<div class="item">

<div class="pic">

<em class="">1</em>

<a href="https://movie.douban.com/subject/1292052/">

<img width="100" alt="肖申克的救赎" src="https://img3.doubanio.com/view/photo/s_ratio_poster/public/p480747492.jpg" class=""/>

</a>

</div>

<div class="info">

<div class="hd">

<a href="https://movie.douban.com/subject/1292052/" class="">

<span class="title">肖申克的救赎</span>

<span class="title"> / The Shawshank Redemption</span>

<span class="other"> / 月黑高飞(港) / 刺激1995(台)</span>

</a> <span class="playable">[可播放]</span>

</div>

<div class="bd">

<p class="">

导演: 弗兰克·德拉邦特 Frank Darabont 主演: 蒂姆·罗宾斯 Tim Robbins /...<br/>

1994 / 美国 / 犯罪 剧情

</p> <div class="star">

<span class="rating5-t"/>

<span class="rating_num" property="v:average">9.6</span>

<span property="v:best" content="10.0"/>

<span>996499人评价</span>

</div> <p class="quote">

<span class="inq">希望让人自由。</span>

</p>

</div>

</div>

</div>

以上<div class="item">已经拿到了,开始进行第二次解析(可以先用个list把这些div存起来,然后再弄个线程做第二次的解析,那是以后的事了,这里先不管)

记录下这里踩的坑

print(result[0].xpath('//img/@src')) //会返回整个页面的img的src

这个奇怪的问题简直了,我甚至觉得是这个包的bug,我从result[0]那么一小段html用xpath查东西居然能查到整个html的,让我觉得我虽然是用result[0]调用的xpath,但内部没准根本不care谁调用的,一律使用最开始etree.HTML() 的到的这个对象调用xpath

我的解决办法是改下xpath,指定从div开始找,或者是用 “."表示从当前节点开始找

print(result[0].xpath('div//img/@src'))

print(result[0].xpath('.//img/@src'))

下面这段代码中的XPath可能不够简洁,但It's just works,毕竟这是第一个版本,随着我对python的熟练,还会继续改动

主要是将一个p标签下的字符串连接起来并去除空格,转换各种特殊字符

需要注意的是XPath返回的基本都是list类型的,很多博客里都直接调方法都没加下标取值,天知道是不是版本不一样

def ProcessHtml(html):

tree = etree.HTML(html)

items = tree.xpath('//div[@class="item"]') for item in items:

index = item.xpath('div//em/text()')[0]

src = item.xpath('div//img/@src')[0]

info = item.xpath('.//div[@class="bd"]/p')[0].xpath('string(.)').strip().replace(' ','').replace('\xa0',' ').replace('\n',' ')

title = item.xpath('.//div[@class="hd"]/a')[0].xpath('string(.)').strip().replace(' ','').replace('\xa0',' ').replace('\n',' ')

star = item.xpath('.//span[@class="rating_num"]/text()')[0]

print ('''%s

%s

%s

%s

%s

''' % (index,title,info,star,src))

完整代码https://github.com/arcsinw/project_douban

参考链接

scrapy xpath 从response中获取li,然后再获取li中img的src

[Python] 豆瓣电影top250爬虫的更多相关文章

- 记一次python爬虫实战,豆瓣电影Top250爬虫

import requests from bs4 import BeautifulSoup import re import traceback def GetHtmlText(url): for i ...

- 一个豆瓣电影Top250爬虫

一个爬虫 这是我第一次接触爬虫,写的第一个爬虫实例. https://movie.douban.com/top250 模块 import requests #用于发送请求 import re #使用正 ...

- 练习:一只豆瓣电影TOP250的爬虫

练习:一只豆瓣电影TOP250爬虫 练习:一只豆瓣电影TOP250爬虫 ①创建project ②编辑items.py import scrapyclass DoubanmovieItem(scrapy ...

- python爬虫 Scrapy2-- 爬取豆瓣电影TOP250

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

- Python小爬虫——抓取豆瓣电影Top250数据

python抓取豆瓣电影Top250数据 1.豆瓣地址:https://movie.douban.com/top250?start=25&filter= 2.主要流程是抓取该网址下的Top25 ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- 【Python爬虫】:使用高性能异步多进程爬虫获取豆瓣电影Top250

在本篇博文当中,将会教会大家如何使用高性能爬虫,快速爬取并解析页面当中的信息.一般情况下,如果我们请求网页的次数太多,每次都要发出一次请求,进行串行执行的话,那么请求将会占用我们大量的时间,这样得不偿 ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

随机推荐

- 牛客 136G-指纹锁 set容器重载

136G-指纹锁 题意: 设计一个容器,支持插入x,若与容器中的值最小相差为k,则自动忽略.删除操作,把与x相差为k的值都从容器中删除.查询操作,问容器中有没有和x相差为k的数值. 思路: 一个stl ...

- 2017福建省赛 FZU 2278 YYS 数学 大数

Yinyangshi is a famous RPG game on mobile phones. Kim enjoys collecting cards in this game. Suppose ...

- yzoj P1126 塔 题解

题意:给n个积木,搭成两个高度相同的塔,问最高高度 正解是dp 答案在dp[n][0] 代码 #include<bits/stdc++.h> using namespace std; in ...

- 从一道看似简单的面试题重新理解JS执行机制与定时器

壹 ❀ 引 最近在看前端进阶的系列专栏,碰巧看到了几篇关于JS事件执行机制的面试文章,因为我在之前一篇 JS执行机制详解,定时器时间间隔的真正含义 博文中也有记录JS执行机制,所以正好用于作为测试自 ...

- C# 活体检测

活体检测有多种情形,本文所指:从摄像头获取的影像中判断是活体,还是使用了相片等静态图片. 场景描述 用户个人信息中上传了近照,当用户经过摄像头时进行身份识别. 此时,如果单纯的使用摄像头获取的影像进行 ...

- 第二章(Kotlin基础)

基本要素:函数和变量 函数 函数定义规则 函数通过关键字 fun 用来声明一个函数 参数的类型与函数返回类型写在它的名称后面,这和变量声明一样 函数可以定义在文件的最外层,不一定要把它放在类中 示例: ...

- SpringCloud学习笔记(3):使用Feign实现声明式服务调用

简介 Feign是一个声明式的Web Service客户端,它简化了Web服务客户端的编写操作,相对于Ribbon+RestTemplate的方式,开发者只需通过简单的接口和注解来调用HTTP API ...

- 聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎视频教程

下载链接:https://www.yinxiangit.com/595.html 目录: 第1章 课程介绍介绍课程目标.通过课程能学习到的内容.和系统开发前需要具备的知识 第2章 windows下搭建 ...

- asp.net core 使用 signalR(一)

asp.net core 使用 signalR(一) Intro SignalR 是什么? ASP.NET Core SignalR 是一个开源代码库,它简化了向应用添加实时 Web 功能的过程. 实 ...

- 解决android splash 启动白屏问题

有时我们会发现 ,在splash 页面启动之前会有那么零点几秒的白屏, 真的很让人抓狂 解决办法其实也很简单 . 1.在style.xml中定义一个样式, 这里引入 splash页面的 图片, 注意不 ...