Kubernetes网络

kubernetes-Service

1.service存在的意义

1.防止破的失联(服务发现)

2.定义一组pod的访问策略(提供负载均衡)

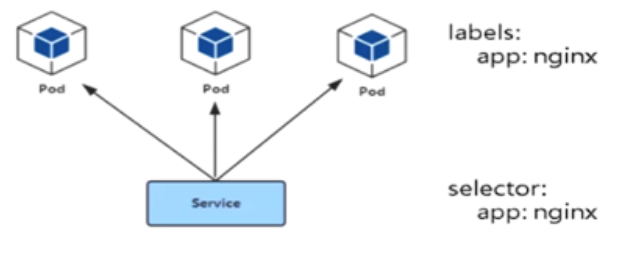

2.pod与service的关系

1.通过lablel-selector相关联

2.通过service实现pod的负载均衡(TCP/UDP 4层)

负载均衡器类型

1.四层 传输层,基于IP和端口

2.七层 应用层,基于应用协议转发,例如http协议

3. service三种常用类型

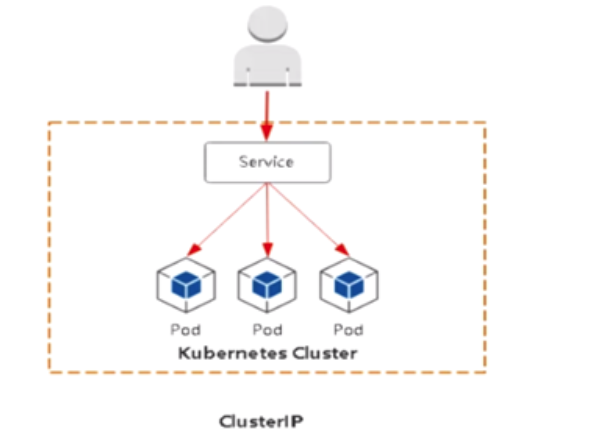

1.Cluster:集群内部使用

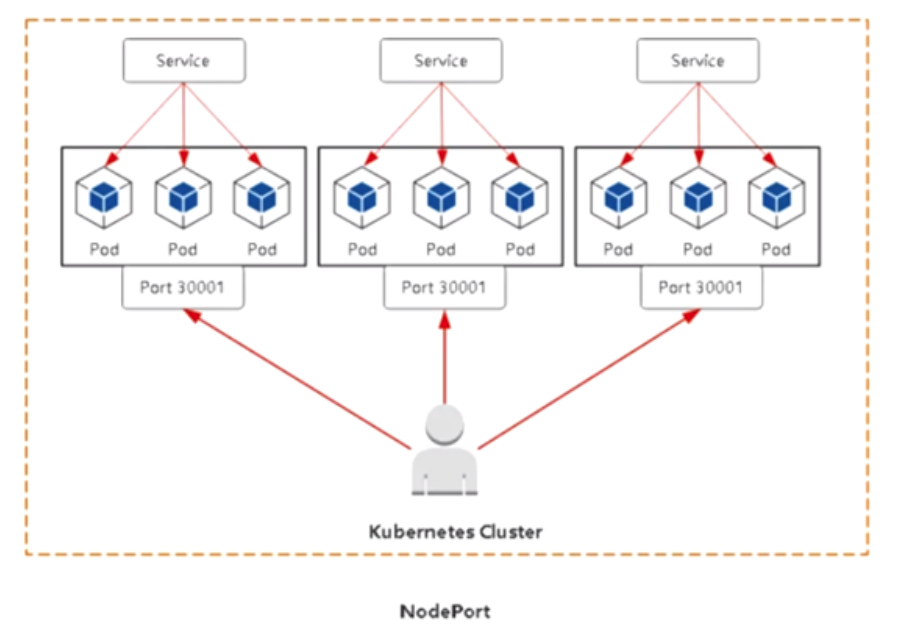

2.Node port:对外暴露应用

3.Loadbalancer: 对外暴露应用,适合公有云(腾讯云、阿里云、亚马逊等)

ClusterIP:

默认分配一个稳定的IP地址,即VIP只能在集群内部访问(amespace内部pod)

Nodeport:

Nodeport:

在每一个节点上启用一个端口来暴露服务,可以在集群外部访问,也会分配一个稳定内部集群IP地址。访问地址<nodeIP: nodeport>

Cluster端口 镜像中使用的端口

生成service的yaml

kubectl expose deploy web --port=80 --target-port=8080 --type=NodePort -o yaml --dry-run=client >service.yaml

cat server.yaml

apiVersion: v1

kind: Service

metadata:

labels:

app: web

name: web

spec:

ports:

- port: 80 #clusterIP对应端口

protocol: TCP

targetPort: 8080 #容器里面应用的端口

nodePort: 30012 #nodeport使用的节点端口 (配置的固定端口)

selector:

app: web

type: NodePort

loadBalancer(只适合用云平台)

与nodeport类似,在每一个节点上启用一个端口来暴露服务,除此之外,Kubernetes会请求低层云平台删固定负载均衡器,将每个node(nodeIP):[nodePort]作为后端添加上

用户 --->域名 --->负载均衡器(公网IP) --->nodePort(所有节点) --->pod

每个部署一个应用,都需要手工在负载均衡器上配置,比较麻烦

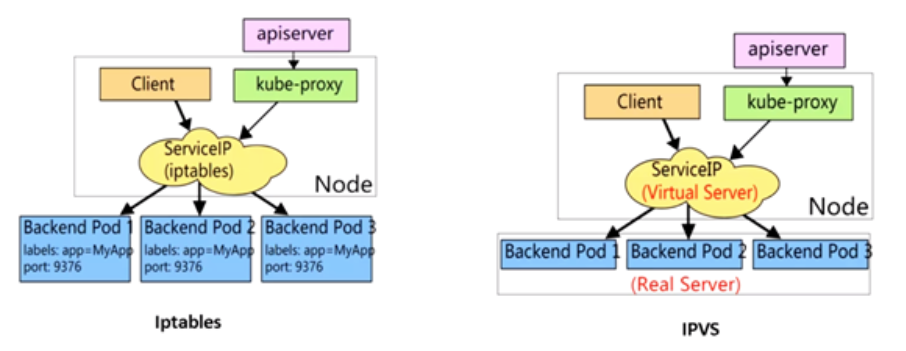

4. service代码模式

service使用iptables或者ipvs进行转发的

kubeadm 方式修改ipvs模式

kubectl edit configmap kube-proxy -n kube-system ...

43 mode: "ipvs"

...

kubectl delete pod kube-proxy-btz4p -n kube-system # 删除pod,会自动拉起

kubectl logs kube-proxy-wwqbh -n kube-system # 查看是否启用ipvs

注意:

1.kube-proxy配置文件以configmap方式存储

2.如果让所有节点生效,需要重建所有节点kube-proxy pod

二进制修改ipvs模式:

vim kube-proxy-config.yaml

mode: ipvs

scheduler: "rr" systemctl restart kube-proxy

# 注:参考不同资料,文件名可能不同

安装ipvsadm工具进行查看ipvs

yum install -y ipvsadm lsmod |grep ip_vs #检测是否加载

modprobe ip_vs

# 或者更新一下内核

yum update -y

查看规则

[root@k8s-node ~]# ipvsadm -L -n

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 172.17.0.1:32487 rr

-> 10.244.84.176:80 Masq 1 0 0

TCP 192.168.10.111:30001 rr

-> 10.244.247.3:8443 Masq 1 0 0

六城堡流程: 客户端 --> clusterIP(iptables/ipvs负载均衡规则) -->分布在各个节点pod

查看规则负载均衡规则:

iptables

iptables-save |grep <service-name>

ipvs

ipvsadm -L -n

iptables VS ipvs

| iptables |

1.灵活。功能强大 2.规则遍历匹配和更新,呈现性时延时 |

| ipvs |

1.工作在内核态,有更好的性能 2.调度算法丰富:rr、wrr、lc、wlc、ip hash |

5. service DNS名称

DNS服务监视kubernetes API, 为每一个service创建DNS记录用于域名解析

clusterIP A记录格式: <service-name>.<namespace-name>.svc,cluster.local

示例:my-svc.my-namespace.svc.cluster.local

小结:

1.采用Node Port对外暴露应用,前面加一个LB实现统一访问入口

2.优先使用IPVS代理模式

3.集群内应用采用DNS名称访问

-------------------------------------------------------

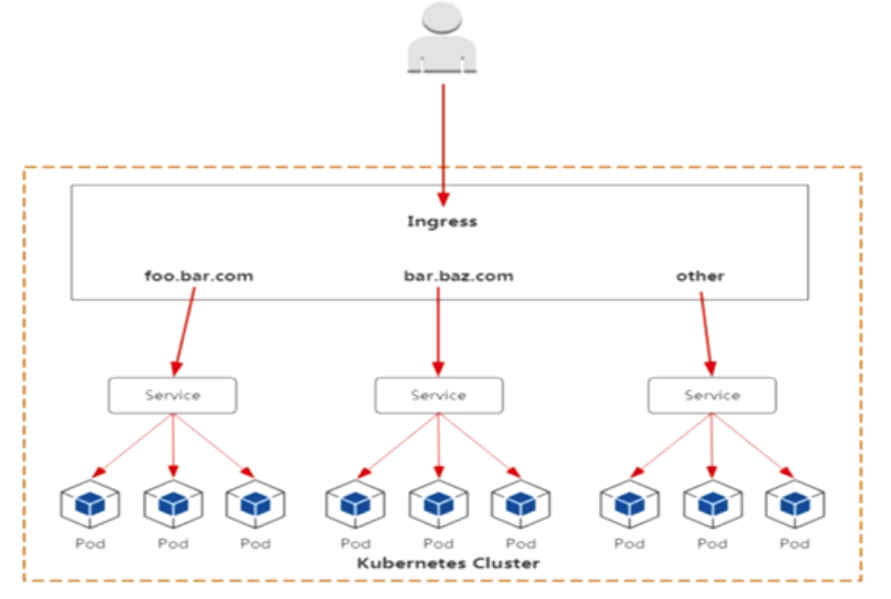

Kubernetes-Ingress

1. Ingress 为弥补Node Port不足而生

Nodeport存在的不足:

1.一个端口只能一个服务使用,端口需要提前规划

2.只支持4层负载均衡

2. Pod与ingress 的关系

1.通过service Controller实现的负载均衡

2.支持TCP、UDP 4层和HTTP 7层

3. Ingerss Controller部署

1.部署ingress Controller

2.创建ingress规则

ingress controller有很多方式实现,这里采用官方维护的nginx控制器

github代码托管地址:

https://github.com/kunernetes/ingress-nginx

下载到master节点

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/mandatory.yaml

注意事项:

1.镜像地址修改/如果可以外网可以不修改(一般这个很难pull 下来)lizhenliang/nginx-ingress-controller:0.30.0

2.建议直接宿主机网络暴露: hostNetwork: true

设置/查看 污点

格式:kubectl label nodes <node-name> <label-key>=<label-value>

例如:kubectl label nodes k8s-node1 disktype=ssd

验证:kubectl get nodes --show-labels

修改mandatory.yaml

# 主要Deployment 资源下的内容

tolerations: # 由于我这里的边缘节点只有master一个节点,所有需要加上容忍

- operator: "Exists"

nodeSelector: # 固定在边缘节点

#disktype: ssd

kubernetes.io/os: linux

#kubernetes.io/hostname: k8s-master

hostNetwork: true # 将pod使用主机网命名空间

containers:

- name: nginx-ingress-controller

image: quay.io/kubernetes-ingress-controller/nginx-ingress-controller:0.26.1

args:

- /nginx-ingress-controller

- --configmap=$(POD_NAMESPACE)/nginx-configuration

- --tcp-services-configmap=$(POD_NAMESPACE)/tcp-services

- --udp-services-configmap=$(POD_NAMESPACE)/udp-services

- --publish-service=$(POD_NAMESPACE)/ingress-nginx

- --annotations-prefix=nginx.ingress.kubernetes.io #这里的标签和后面创建ingress 资源对象标签对应

securityContext:

其他主流控制器

1.Traefik: HTTP反向代理、负载均衡工具

2.Istio: 服务治理、控制入口流量

启动 Controller

kubectl apply -f mandatroy.yaml # 查看pod状态

kubectl get pods -n ingress-nginx -o wide

kubectl describe pod xxxx -n ingress-nginx

创建服务发现

1.启动一个pod

# 导出yaml文件 或者直接创建pod

kubectl create deploy java-demo --image=lizhenliang/java-demo -oyaml --dry-run=client > java-demo.yaml kubectl apply -f java-demo.yaml

2.为pod创建/绑定 service

kubectl expose deployment java-demo --port=80 --target-port=8080 --type=NodePort -o yaml --dry-run=client > svc.yaml # java-demo-svc.yaml 文件内容

apiVersion: v1

kind: Service

metadata:

labels:

app: java-demo

name: java-demo

spec:

ports:

- port: 80

protocol: TCP

targetPort: 8080

selector:

app: java-demo

3.创建ingress规则(基于http的方式)

cat java-demo-ingress.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: snippet-test

annotations:

nginx.ingress.kubernetes.io/server-snippet: | # 对应的mandatroy文件中的标签

if ($http_user_agent ~* '(Android|iPhone)') {

rewrite ^/(.*) http://m.baidu.com break;

}

spec:

rules:

- host: foo.bar.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: java-demo

port:

number: 80

生效ingress资源

kubectl apply -f java-demo-ingress.yaml

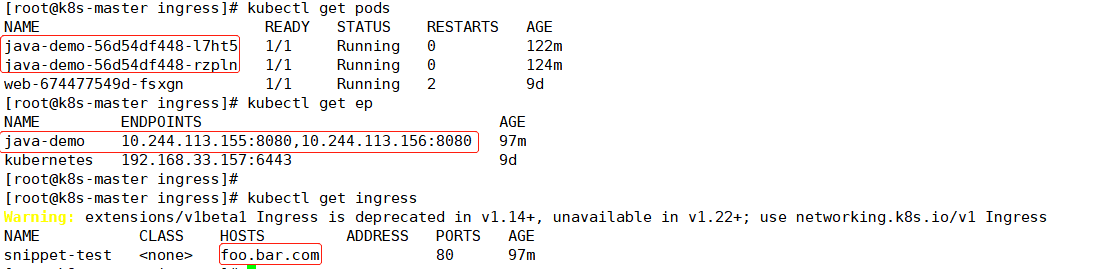

4.扩容pod副本/ 并且查看ingress、service资源服务

# 扩容副本

kubectl scale deploy java-demo --replicas=2 # 查新是否被关联到一个负载均衡器里面

kubectl get ep # 查看ingress资源

kubectl get ingress

访问测试:

需要添加hosts解析

curl foo.bar.com

ingerss规则相当于在nginx里创建了一个基于域名虚拟主机。只不过是自动生成,不需人工干预

upstream web {

server pod1;

server pod2;

}

server {

listen 80;

server_name foo.bar.com;

location / {

cert

key

proxy_pass http://web;

}

}

用户--> 域名-->负载均衡器(公网IP) --> ingress controller(nginx实现负载均衡)-->pod

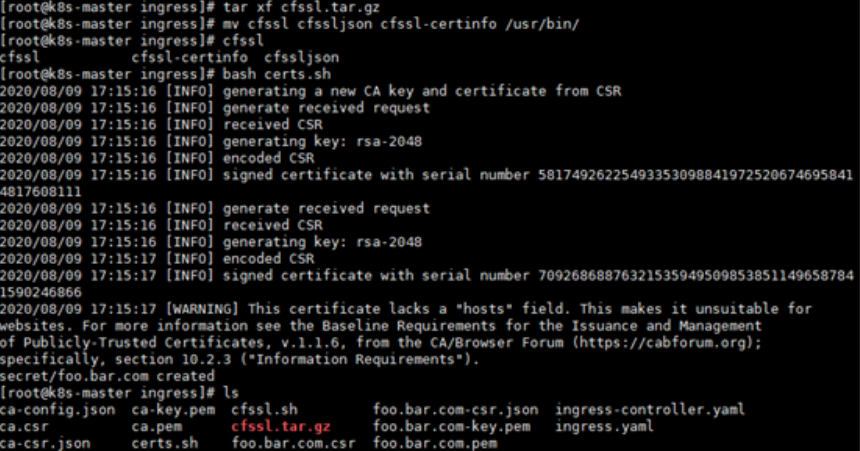

创建ingress规则 (基于https的方式)

https方式通过证书方式进行实现,证书分自签证书和CA证书机构

这里使用自签证书方式进行实现https加密传输

部署生成证书的工具

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64

chmod +x cfssl_linux-amd64 cfssljson_linux-amd64 cfssl-certinfo_linux-amd64

mv cfssl_linux-amd64 /usr/local/bin/cfssl

mv cfssljson_linux-amd64 /usr/local/bin/cfssljson

mv cfssl-certinfo_linux-amd64 /usr/bin/cfssl-certinfo

脚本方式生成证书

[root@k8s-master ~]# unzip ingress-https.zip

[root@k8s-master ~]# cd ingress/

[root@k8s-master ingress]# ls

certs.sh cfssl.sh ingress-controller.yaml ingress.yaml

[root@k8s-master ingress]#

修改ceats.sh里面的域名,改成要使用的域名,然后生成证书

cd ingress/ && bash certs.sh #执行过程会将证书保存到secret中调用

查看保存的证书

kubectl get secret

配置https证书访问

cat ingress-https.yaml

apiVersion: networking.k8s.io/v1beta1

kind: Ingress

metadata:

name: tls-example-ingress

spec:

tls:

- hosts:

- foo.bar.com # 以上四行就是加https证书位置

secretName: foo.bar.com #对应保存证书的名称

rules:

- host: foo.bar.com

http:

paths:

- path: /

backend:

serviceName: java-demo

servicePort: 80

删除http规则,不删除可能会对https有影响

kubectl delete -f ingress.yaml

生效https规则

kubectl apply -f ingress-https.yaml

kubectl get ing

测试访问 https://foo.bar.com

mandatory.yaml 原yaml的内容: 橙色部分为修改部分

apiVersion: v1

kind: Namespace

metadata:

name: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx --- kind: ConfigMap

apiVersion: v1

metadata:

name: nginx-configuration

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx ---

kind: ConfigMap

apiVersion: v1

metadata:

name: tcp-services

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx ---

kind: ConfigMap

apiVersion: v1

metadata:

name: udp-services

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx ---

apiVersion: v1

kind: ServiceAccount

metadata:

name: nginx-ingress-serviceaccount

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx ---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: ClusterRole

metadata:

name: nginx-ingress-clusterrole

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

rules:

- apiGroups:

- ""

resources:

- configmaps

- endpoints

- nodes

- pods

- secrets

verbs:

- list

- watch

- apiGroups:

- ""

resources:

- nodes

verbs:

- get

- apiGroups:

- ""

resources:

- services

verbs:

- get

- list

- watch

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- apiGroups:

- "extensions"

- "networking.k8s.io"

resources:

- ingresses

verbs:

- get

- list

- watch

- apiGroups:

- "extensions"

- "networking.k8s.io"

resources:

- ingresses/status

verbs:

- update ---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: Role

metadata:

name: nginx-ingress-role

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

rules:

- apiGroups:

- ""

resources:

- configmaps

- pods

- secrets

- namespaces

verbs:

- get

- apiGroups:

- ""

resources:

- configmaps

resourceNames:

# Defaults to "<election-id>-<ingress-class>"

# Here: "<ingress-controller-leader>-<nginx>"

# This has to be adapted if you change either parameter

# when launching the nginx-ingress-controller.

- "ingress-controller-leader-nginx"

verbs:

- get

- update

- apiGroups:

- ""

resources:

- configmaps

verbs:

- create

- apiGroups:

- ""

resources:

- endpoints

verbs:

- get ---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: RoleBinding

metadata:

name: nginx-ingress-role-nisa-binding

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: nginx-ingress-role

subjects:

- kind: ServiceAccount

name: nginx-ingress-serviceaccount

namespace: ingress-nginx ---

apiVersion: rbac.authorization.k8s.io/v1beta1

kind: ClusterRoleBinding

metadata:

name: nginx-ingress-clusterrole-nisa-binding

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: nginx-ingress-clusterrole

subjects:

- kind: ServiceAccount

name: nginx-ingress-serviceaccount

namespace: ingress-nginx --- apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-ingress-controller

namespace: ingress-nginx

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

spec:

replicas: 1

selector:

matchLabels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

template:

metadata:

labels:

app.kubernetes.io/name: ingress-nginx

app.kubernetes.io/part-of: ingress-nginx

annotations:

prometheus.io/port: "10254"

prometheus.io/scrape: "true"

spec:

# wait up to five minutes for the drain of connections

terminationGracePeriodSeconds: 300

serviceAccountName: nginx-ingress-serviceaccount

tolerations: # 由于我这里的边缘节点只有master一个节点,所有需要加上容忍

- operator: "Exists"

nodeSelector: # 固定在边缘节点

#disktype: ssd

kubernetes.io/os: linux

#kubernetes.io/hostname: k8s-master

hostNetwork: true # 将pod使用主机网命名空间

containers:

- name: nginx-ingress-controller

image: quay.io/kubernetes-ingress-controller/nginx-ingress-controller:0.26.1

args:

- /nginx-ingress-controller

- --configmap=$(POD_NAMESPACE)/nginx-configuration

- --tcp-services-configmap=$(POD_NAMESPACE)/tcp-services

- --udp-services-configmap=$(POD_NAMESPACE)/udp-services

- --publish-service=$(POD_NAMESPACE)/ingress-nginx

- --annotations-prefix=nginx.ingress.kubernetes.io #这里的标签和后面创建ingress 资源对象标签对应

securityContext:

allowPrivilegeEscalation: true

capabilities:

drop:

- ALL

add:

- NET_BIND_SERVICE

# www-data -> 33

runAsUser: 33

env:

- name: POD_NAME

valueFrom:

fieldRef:

fieldPath: metadata.name

- name: POD_NAMESPACE

valueFrom:

fieldRef:

fieldPath: metadata.namespace

ports:

- name: http

containerPort: 80

- name: https

containerPort: 443

livenessProbe:

failureThreshold: 3

httpGet:

path: /healthz

port: 10254

scheme: HTTP

initialDelaySeconds: 10

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 10

readinessProbe:

failureThreshold: 3

httpGet:

path: /healthz

port: 10254

scheme: HTTP

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 10

lifecycle:

preStop:

exec:

command:

- /wait-shutdown ---

Kubernetes网络的更多相关文章

- Kubernetes 网络改进的三项实践分享

自研CNI IPAM插件 解决K8s功能问题 首先,在功能方面,Kubernetes 网络模型由于IP不固定,无法对IP资源进行精细管控,无法使用基于IP的监控和基于IP的安全策略,此外,一些IP发现 ...

- [翻译] 一个kubernetes网络简明教程[Part 1]

一个kubernetes网络简明教程[Part 1] 翻译: icebug 所有我学到的关于kubernetes网络的事情 你可能已经在kubernetes集群当中跑了一堆服务并且正在享受其带来的好处 ...

- Kubernetes网络的4种解决方案

一.Kubernetes + Flannel Kubernetes的网络模型假定了所有Pod都在一个可以直接连通的扁平的网络空间中,这在GCE(Google Compute Engine)里面是现成的 ...

- Kubernetes网络方案的三大类别和六个场景

欢迎访问网易云社区,了解更多网易技术产品运营经验. 本文章根据网易云资深解决方案架构师 王必成在云原生用户大会上的分享整理. 今天我将分享个人对于网络方案的理解,以及网易云在交付 Kubernetes ...

- 深入解读docker网络与kubernetes网络

前言:你是否学习使用k8s很久很久了可是对于网络这块仍旧似懂非懂呢? 您是否对网上一堆帖子有如下的抱怨: 打开多个博客,然后发现有区别么? 明显是直译过来的,越看越迷糊 “因为xxx,所以yyy”,. ...

- 99% 的人都不知道的 Kubernetes 网络疑难杂症排查方法

原文链接:Kubernetes 网络疑难杂症排查分享 大家好,我是 roc,来自腾讯云容器服务 (TKE) 团队,经常帮助用户解决各种 K8S 的疑难杂症,积累了比较丰富的经验,本文分享几个比较复杂的 ...

- 从零开始入门 K8s | Kubernetes 网络概念及策略控制

作者 | 阿里巴巴高级技术专家 叶磊 一.Kubernetes 基本网络模型 本文来介绍一下 Kubernetes 对网络模型的一些想法.大家知道 Kubernetes 对于网络具体实现方案,没有什 ...

- Kubernetes网络之Flannel工作原理

目录 1.Docker网络模式 1.1 bridge网络的构建过程 1.2 外部访问 2.Kubernetes网络模式 2.1 同一个Pod中容器之间的通信 2.2 不同Pod中容器之间的通信 2.3 ...

- 超长干货丨Kubernetes网络快速入门完全指南

Kubernetes网络一直是一个非常复杂的主题.本文将介绍Kubernetes实际如何创建网络以及如何为Kubernetes集群设置网络. 本文不包括如何设置Kubernetes集群.这篇文章中的所 ...

- DevOps专题|玩转Kubernetes网络

Kubernetes无疑是当前最火热的容器编排工具,网络是kubernetes中非常重要的一环, 本文主要介绍一些相应的网络原理及术语,以及kubernetes中的网络方案和对比. Kubernete ...

随机推荐

- Visual Studio Code调试和发布ASP.NET Core Web应用

前言 上一篇文章主要讲了Visual Studio Code安装C#开发工具包并编写ASP.NET Core Web应用有兴趣的同学可以去看看,今天咱们主要是要讲讲如何在VS Code中调试和发布AS ...

- 【转载】AF_XDP技术详解

原文信息 作者:rexrock 出处:https://rexrock.github.io/post/af_xdp1/ 目录 1. 用户态程序 1.1 创建AF_XDP的socket 1.2 为UMEM ...

- modulemap的使用方法

modulemap的作用 modulemap 文件是用来解决 C,Object-C,C++ 代码在 Swift 项目中集成的问题的. 在 Swift 项目中,如果需要使用 C,Object-C 或 ...

- 反射(Java Reflection)

Java反射机制概述 Reflection(反射)是Java被视为动态语言的关键,反射机制允许程序在执行期借助于ReflectionAPI取得任何类的内部信息,并能直接操作任意对象的内部属性及方法. ...

- Angular报错:Error: Unknown argument: spec

解决方案 使用--skip-tests代替 效果展示 可以看到spec.ts消失了 参考链接 https://stackoverflow.com/questions/62228834/angular- ...

- 代码随想录算法训练营第八天| LeetCode 344.反转字符串 541. 反转字符串II 151.翻转字符串里的单词

344.反转字符串 卡哥建议: 本题是字符串基础题目,就是考察 reverse 函数的实现,同时也明确一下 平时刷题什么时候用 库函数,什么时候 不用库函数 题目链接/文章讲解/视频讲解:https: ...

- 聚焦Web前端安全:最新揭秘漏洞防御方法

在 Web 安全中,服务端一直扮演着十分重要的角色.然而前端的问题也不容小觑,它也会导致信息泄露等诸如此类的问题.在这篇文章中,我们将向读者介绍如何防范Web前端中的各种漏洞.[万字长文,请先收藏再阅 ...

- TRL 正式推出,来训练你的首个 RLHF 模型吧!

我们正式向大家介绍 TRL--Transformer Reinforcement Learning.这是一个超全面的全栈库,包含了一整套工具用于使用强化学习 (Reinforcement Learni ...

- Web通用漏洞--CSRF

Web通用漏洞--CSRF 漏洞简介 CSRF(Cross Site Request Forgery, 跨站请求伪造/客户端请求伪造),即通过伪造访问数据包并制作成网页的形式,使受害者访问伪造网页,同 ...

- 现代 CSS 解决方案:原生嵌套(Nesting)

很早之前,就写过一篇与原生嵌套相关的文章 -- CSS 即将支持嵌套,SASS/LESS 等预处理器已无用武之地?,彼时 CSS 原生嵌套还处于工作草案 Working Draft (WD) 阶段,而 ...