Tensorflow笔记——神经网络图像识别(一)前反向传播,神经网络八股

第一讲:人工智能概述

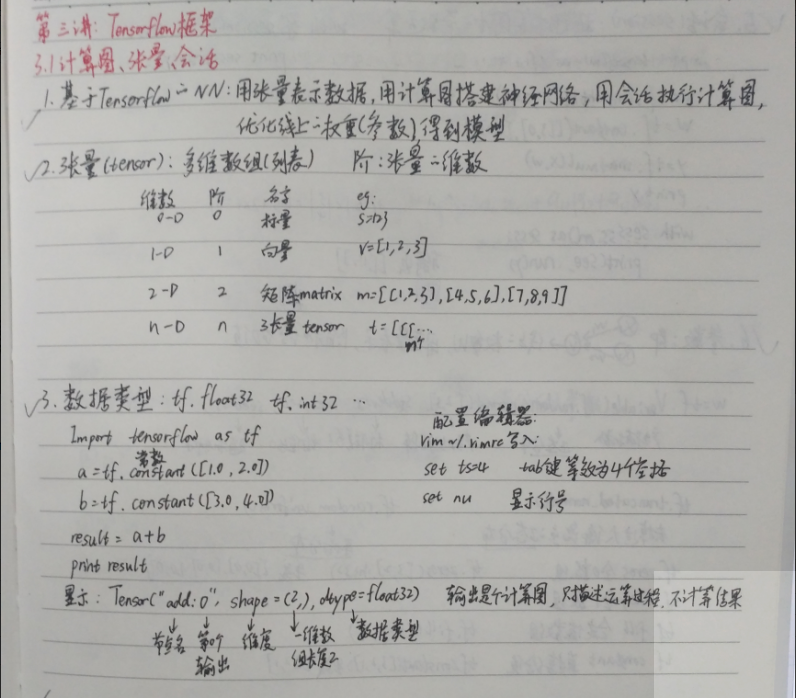

第三讲:Tensorflow框架

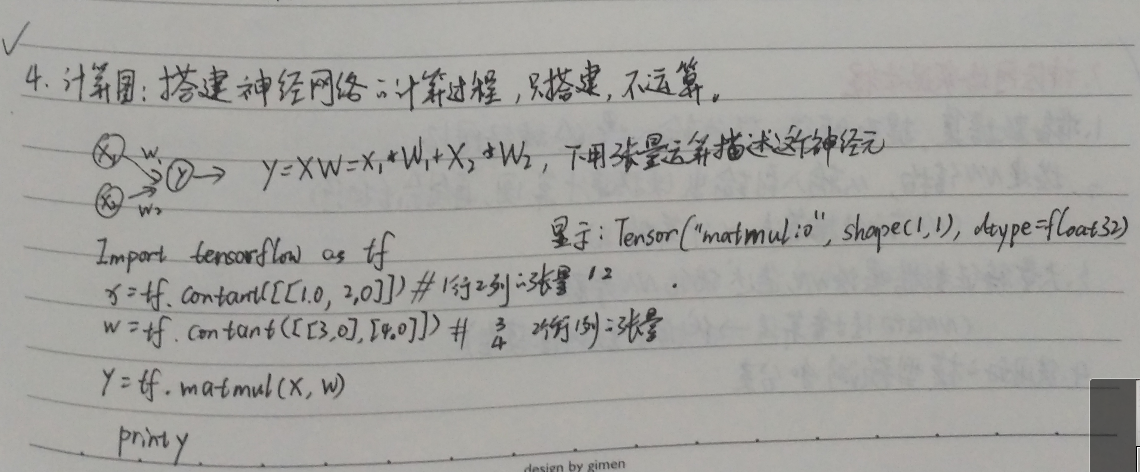

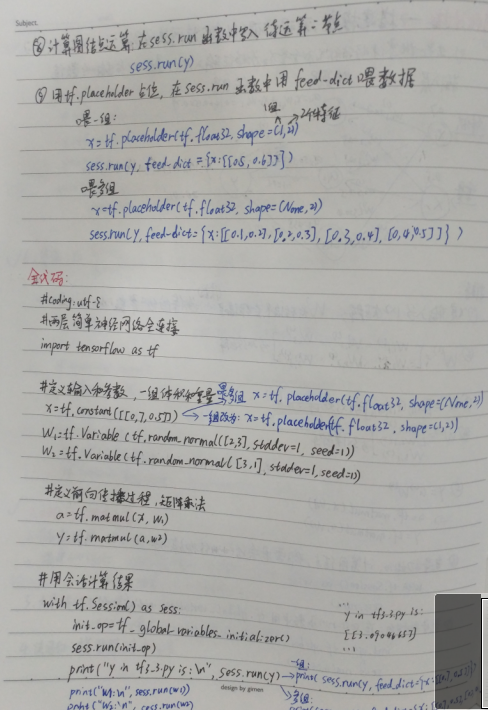

前向传播:

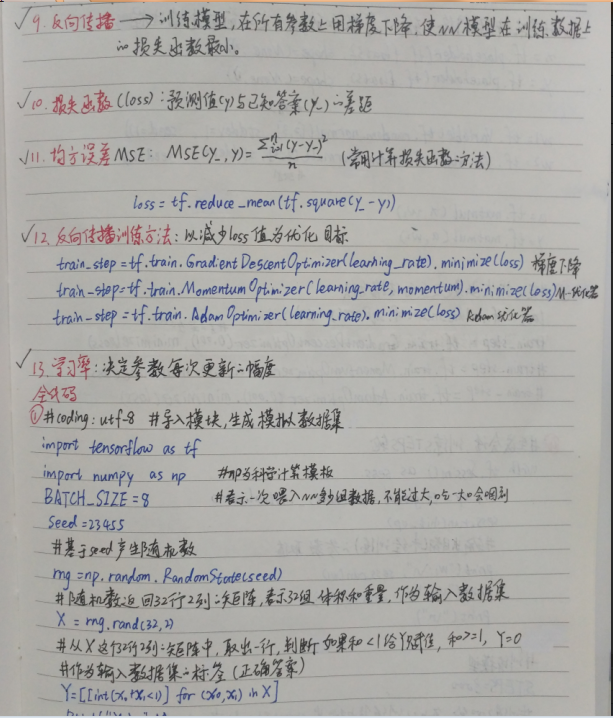

反向传播:

总的代码:

#coding:utf-8

#1.导入模块,生成模拟数据集

import tensorflow as tf

import numpy as np #np为科学计算模块

BATCH_SIZE = 8#表示一次喂入NN多少组数据,不能过大,会噎着

seed = 23455 #基于seed产生随机数

rng = np.random.RandomState(seed)

#随机数返回32*2列的矩阵,每行2个表示属性(体积和质量),作为输入数据集

X = rng.rand(32,2)

#从x这个矩阵中,取出每一行,判断如果和<1,y=1,否则,y=0

#作为输入数据集的标签(正确答案)

Y=[[int(x0+x1<1)] for (x0,x1) in X]

print("X:\n",X)

print("Y:\n",Y) #2.定义神经网络的输入,参数和输出,定义前向传播过程

x = tf.placeholder(tf.float32,(None,2))

y_ = tf.placeholder(tf.float32,(None,1)) w1 = tf.Variable(tf.random_normal([2,3], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([3,1], stddev=1, seed=1)) a = tf.matmul(x, w1)

y = tf.matmul(a, w2) #3.定义损失函数及反向传播方法

loss = tf.reduce_mean(tf.square(y-y_))

train_step = tf.train.GradientDescentOptimizer(0.001).minimize(loss)#梯度下降

#train_step = tf.train.MomentumOptimizer(0.001,0.9).minimize(loss)

#train_step = tf.train.AdamOptimizer(0.001,0.9).minimize(loss) #4.生成会话,训练STEPS轮

with tf.Session() as sess:

init_op=tf.global_variables_initializer()

sess.run(init_op)

#输出目前还未训练的参数取值

print("w1:\n", sess.run(w1))

print("w2:\n", sess.run(w2))

print("\n") #训练模型

STEPS=3000

#训练3000轮,每次从训练集中挑选strart到end的数据,喂入数据

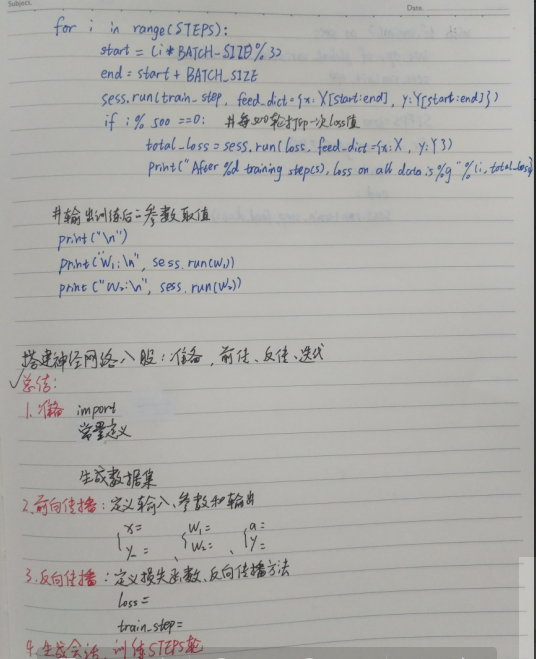

for i in range(STEPS):

start = (i*BATCH_SIZE)%32

end = start + BATCH_SIZE

sess.run(train_step, feed_dict={x:X[start:end], y_:Y[start:end]})

if i%500 == 0:#每500次打印一轮

total_loss = sess.run(loss,feed_dict={x:X,y_:Y})

print("After %d training steps,loss on all data is %g" % (i,total_loss)) #输出训练后的参数取值

print("\n")

print("w1:\n", sess.run(w1))

print("w2:\n", sess.run(w2))

输出的结果:

X:

[[ 0.83494319 0.11482951]

[ 0.66899751 0.46594987]

[ 0.60181666 0.58838408]

[ 0.31836656 0.20502072]

[ 0.87043944 0.02679395]

[ 0.41539811 0.43938369]

[ 0.68635684 0.24833404]

[ 0.97315228 0.68541849]

[ 0.03081617 0.89479913]

[ 0.24665715 0.28584862]

[ 0.31375667 0.47718349]

[ 0.56689254 0.77079148]

[ 0.7321604 0.35828963]

[ 0.15724842 0.94294584]

[ 0.34933722 0.84634483]

[ 0.50304053 0.81299619]

[ 0.23869886 0.9895604 ]

[ 0.4636501 0.32531094]

[ 0.36510487 0.97365522]

[ 0.73350238 0.83833013]

[ 0.61810158 0.12580353]

[ 0.59274817 0.18779828]

[ 0.87150299 0.34679501]

[ 0.25883219 0.50002932]

[ 0.75690948 0.83429824]

[ 0.29316649 0.05646578]

[ 0.10409134 0.88235166]

[ 0.06727785 0.57784761]

[ 0.38492705 0.48384792]

[ 0.69234428 0.19687348]

[ 0.42783492 0.73416985]

[ 0.09696069 0.04883936]]

Y:

[[1], [0], [0], [1], [1], [1], [1], [0], [1], [1], [1], [0], [0], [0], [0], [0], [0], [1], [0], [0], [1], [1], [0], [1], [0], [1], [1], [1], [1], [1], [0], [1]]

w1:

[[-0.81131822 1.48459876 0.06532937]

[-2.4427042 0.0992484 0.59122431]]

w2:

[[-0.81131822]

[ 1.48459876]

[ 0.06532937]] After 0 training steps,loss on all data is 5.13118

After 500 training steps,loss on all data is 0.429111

After 1000 training steps,loss on all data is 0.409789

After 1500 training steps,loss on all data is 0.399923

After 2000 training steps,loss on all data is 0.394146

After 2500 training steps,loss on all data is 0.390597 w1:

[[-0.70006633 0.9136318 0.08953571]

[-2.3402493 -0.14641267 0.58823055]]

w2:

[[-0.06024267]

[ 0.91956186]

[-0.0682071 ]]

Tensorflow笔记——神经网络图像识别(一)前反向传播,神经网络八股的更多相关文章

- 深度学习课程笔记(三)Backpropagation 反向传播算法

深度学习课程笔记(三)Backpropagation 反向传播算法 2017.10.06 材料来自:http://speech.ee.ntu.edu.tw/~tlkagk/courses_MLDS1 ...

- Deep Learning 学习笔记(7):神经网络的求解 与 反向传播算法(Back Propagation)

反向传播算法(Back Propagation): 引言: 在逻辑回归中,我们使用梯度下降法求参数方程的最优解. 这种方法在神经网络中并不能直接使用, 因为神经网络有多层参数(最少两层),(?为何不能 ...

- ML(5)——神经网络2(BP反向传播)

上一章的神经网络实际上是前馈神经网络(feedforward neural network),也叫多层感知机(multilayer perceptron,MLP).具体来说,每层神经元与下一层神经元全 ...

- 深度神经网络(DNN)反向传播算法(BP)

在深度神经网络(DNN)模型与前向传播算法中,我们对DNN的模型和前向传播算法做了总结,这里我们更进一步,对DNN的反向传播算法(Back Propagation,BP)做一个总结. 1. DNN反向 ...

- 【原】Coursera—Andrew Ng机器学习—编程作业 Programming Exercise 4—反向传播神经网络

课程笔记 Coursera—Andrew Ng机器学习—课程笔记 Lecture 9_Neural Networks learning 作业说明 Exercise 4,Week 5,实现反向传播 ba ...

- 第四节课-反向传播&&神经网络1

2017-08-14 这节课的主要内容是反向传播的介绍,非常的详细,还有神经网络的部分介绍,比较简短. 首先是对求导,梯度的求解.反向传播的核心就是将函数进行分解,分段求导,前向计算损失,反向计算各个 ...

- 深度学习——深度神经网络(DNN)反向传播算法

深度神经网络(Deep Neural Networks,简称DNN)是深度学习的基础. 回顾监督学习的一般性问题.假设我们有$m$个训练样本$\{(x_1, y_1), (x_2, y_2), …, ...

- AI 反向传播神经网络

反向传播(Back Propagation,简称BP)神经网络

- Python3 反向传播神经网络-Min-Batch(根据吴恩达课程讲解编写)

# -*- coding: utf-8 -*- """ Created on Sat Jan 20 13:47:54 2018 @author: markli " ...

随机推荐

- 【yum】yum的使用

Yum官网 Yum的缓存 Yum仓库 Yum命令 Yum插件 yum的缓存 通过缓存可以提升我们环境的搭建效率,直接把原来缓存好的安装包数据放到新环境,省去了几个G的下载,甚至,有些时候客户现场不能联 ...

- lxml.etree去除子节点

去除etree中的某个子节点有两种方法: 1.parentnode.remove(node) 2.etree.strip_elements(html, 'element_name', with_tag ...

- 1406 data too long for column 'content' at row 1

很奇怪,很邪门. content字段用的是text格式,按理说不会出现数据太长的问题. 后来搜索了一下,需要设置sql_mode.或者设为, mysql> SET @@global.sql_mo ...

- 资源管理器总是生成 avi,mpeg的预览图

感觉非常讨厌. 图片可以直接显示,但是视频的预览图感觉很不舒服. 查了一下 , 用ShellExView 禁用一下 MF XXXX Property Handler 就可以了. 官网最下面可以下载: ...

- Android之第三方平台实现多平台分享操作

开发中常常遇到分享操作,当用到多种分享时,如:QQ,微信,微博,短信等,可以借助第三方平台来完成,此博客主要借助mob平台来完成相关操作,当然也可以借助其他平台,如友盟等. 先来看看效果图: 如图看出 ...

- Sizzle源码分析:二 词法分析

上一篇我们了解了Sizzle的整体流程,下面我开始一点点分析各个流程,我们进行查询的第一步就是词法分析tokenize,同样先了解下思路,如果是#div_test > span input[ch ...

- 201621123006 《Java程序设计》第10周学习总结

1. 本周学习总结 1.1 以你喜欢的方式(思维导图或其他)归纳总结异常相关内容. 2. 书面作业 本次PTA作业题集异常 1. 常用异常 结合题集题目7-1回答 1.1 自己以前编写的代码中经常出现 ...

- PHP ksort() 函数

PHP ksort() 函数 PHP Array 函数 实例 按照键名对关联数组进行升序排序: <?php $age=array("Bill"=>"60&qu ...

- nmcli命令使用

nmcli命令 地址配置工具:nmcli nmcli device 查看所有网卡的信息 nmcli device status 和numcli device 相同 nmcli device ...

- HTML, CSS. JS的各种奇淫技巧

1. js 中为了省字节,性能, 防止被重写等发明了各种写法,记录下 //取整 parseInt(a,10); //Before Math.floor(a); //Before a>>0; ...