pytorch神经网络解决回归问题(非常易懂)

对于pytorch的深度学习框架,在建立人工神经网络时整体的步骤主要有以下四步:

1、载入原始数据

2、构建具体神经网络

3、进行数据的训练

4、数据测试和验证

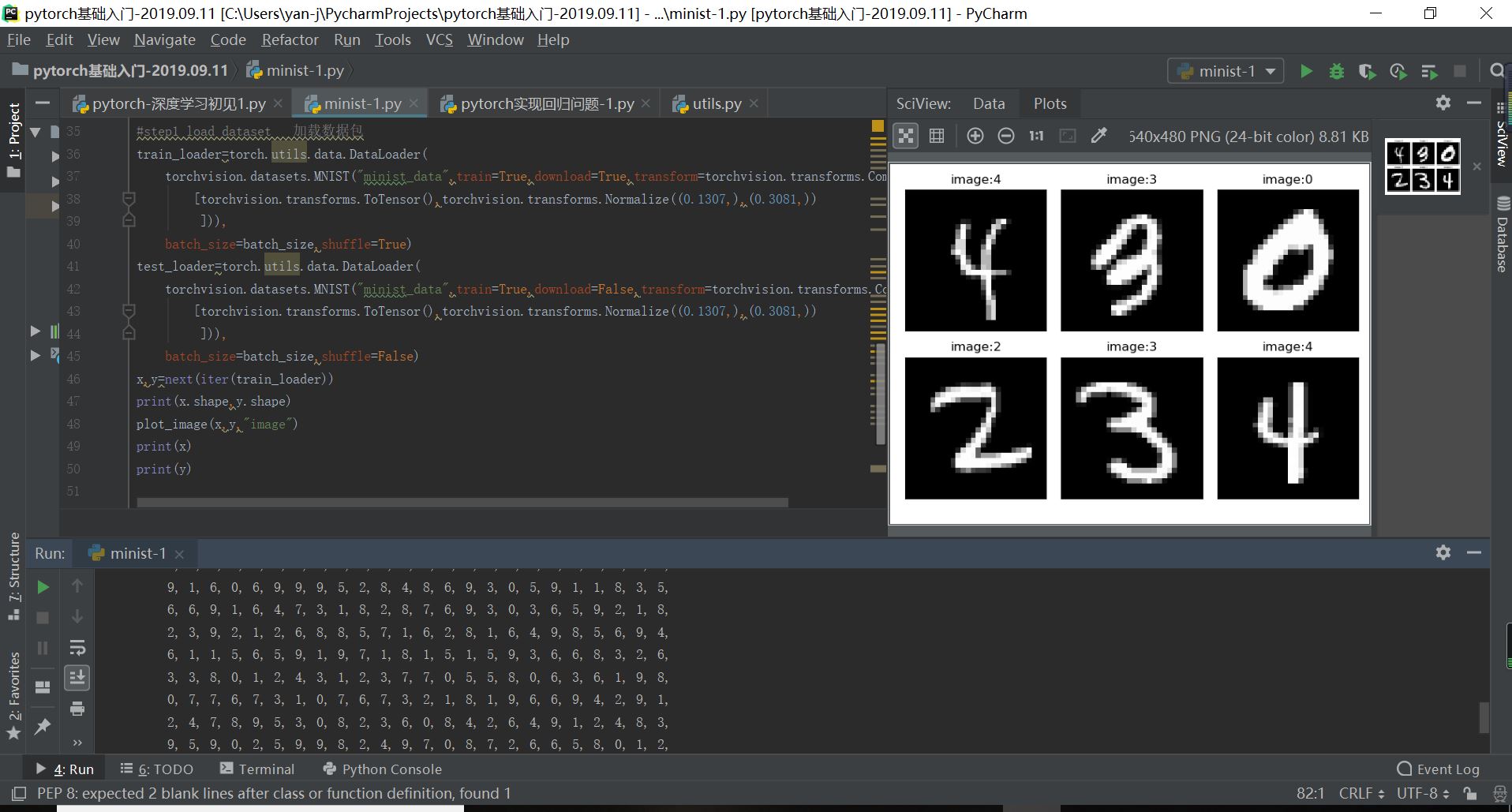

pytorch神经网络的数据载入,以MINIST书写字体的原始数据为例:

import torch

import matplotlib.pyplot as plt

def plot_curve(data):

fig=plt.figure()

plt.plot(range(len(data)),data,color="blue")

plt.legend(["value"],loc="upper right")

plt.xlabel("step")

plt.ylabel("value")

plt.show()

def plot_image(img,label,name):

fig=plt.figure()

for i in range(6):

plt.subplot(2,3,i+1)

plt.tight_layout()

plt.imshow(img[i][0]*0.3081+0.1307,cmap="gray",interpolation="none")

plt.title("{}:{}".format(name, label[i].item()))

plt.xticks([])

plt.yticks([])

plt.show()

def one_hot(label,depth=10):

out=torch.zeros(label.size(0),depth)

idx=torch.LongTensor(label).view(-1,1)

out.scatter_(dim=1,index=idx,value=1)

return out

batch_size=512

import torch

from torch import nn #完成神经网络的构建包

from torch.nn import functional as F #包含常用的函数包

from torch import optim #优化工具包

import torchvision #视觉工具包

import matplotlib.pyplot as plt

from utils import plot_curve,plot_image,one_hot

#step1 load dataset 加载数据包

train_loader=torch.utils.data.DataLoader(

torchvision.datasets.MNIST("minist_data",train=True,download=True,transform=torchvision.transforms.Compose(

[torchvision.transforms.ToTensor(),torchvision.transforms.Normalize((0.1307,),(0.3081,))

])),

batch_size=batch_size,shuffle=True)

test_loader=torch.utils.data.DataLoader(

torchvision.datasets.MNIST("minist_data",train=True,download=False,transform=torchvision.transforms.Compose(

[torchvision.transforms.ToTensor(),torchvision.transforms.Normalize((0.1307,),(0.3081,))

])),

batch_size=batch_size,shuffle=False)

x,y=next(iter(train_loader))

print(x.shape,y.shape)

plot_image(x,y,"image")

print(x)

print(y)

以构建一个简单的回归问题的神经网络为例,其具体的实现代码如下所示:

import torch

import torch.nn.functional as F # 激励函数都在这

x = torch.unsqueeze(torch.linspace(-1, 1, 100), dim=1) # x data (tensor), shape=(100, 1)

y = x.pow(2) + 0.2 * torch.rand(x.size()) # noisy y data (tensor), shape=(100, 1)

class Net(torch.nn.Module): # 继承 torch 的 Module(固定)

def __init__(self, n_feature, n_hidden, n_output): # 定义层的信息,n_feature多少个输入, n_hidden每层神经元, n_output多少个输出

super(Net, self).__init__() # 继承 __init__ 功能(固定)

# 定义每层用什么样的形式

self.hidden = torch.nn.Linear(n_feature, n_hidden) # 定义隐藏层,线性输出

self.predict = torch.nn.Linear(n_hidden, n_output) # 定义输出层线性输出

def forward(self, x): # x是输入信息就是data,同时也是 Module 中的 forward 功能,定义神经网络前向传递的过程,把__init__中的层信息一个一个的组合起来

# 正向传播输入值, 神经网络分析出输出值

x = F.relu(self.hidden(x)) # 定义激励函数(隐藏层的线性值)

x = self.predict(x) # 输出层,输出值

return x

net = Net(n_feature=1, n_hidden=10, n_output=1)

print(net) # net 的结构

"""

Net (

(hidden): Linear (1 -> 10)

(predict): Linear (10 -> 1)

)

"""

# optimizer 是训练的工具

optimizer = torch.optim.SGD(net.parameters(), lr=0.2) # 传入 net 的所有参数, 学习率

loss_func = torch.nn.MSELoss() # 预测值和真实值的误差计算公式 (均方差)

for t in range(100): # 训练的步数100步

prediction = net(x) # 喂给 net 训练数据 x, 每迭代一步,输出预测值

loss = loss_func(prediction, y) # 计算两者的误差

# 优化步骤:

optimizer.zero_grad() # 清空上一步的残余更新参数值

loss.backward() # 误差反向传播, 计算参数更新值

optimizer.step() # 将参数更新值施加到 net 的 parameters 上

import matplotlib.pyplot as plt

plt.ion() # 实时画图something about plotting

for t in range(200):

prediction = net(x) # input x and predict based on x

loss = loss_func(prediction, y) # must be (1. nn output, 2. target)

optimizer.zero_grad() # clear gradients for next train

loss.backward() # backpropagation, compute gradients

optimizer.step() # apply gradients

if t % 5 == 0: # 每五步绘一次图

# plot and show learning process

plt.cla()

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(), 'r-', lw=5)

plt.text(0.5, 0, 'Loss=%.4f' % loss.data.numpy(), fontdict={'size': 20, 'color': 'red'})

plt.pause(0.1)

plt.ioff()

plt.show()

pytorch神经网络解决回归问题(非常易懂)的更多相关文章

- 使用Google-Colab训练PyTorch神经网络

Colaboratory 是免费的 Jupyter 笔记本环境,不需要进行任何设置就可以使用,并且完全在云端运行.关键是还有免费的GPU可以使用!用Colab训练PyTorch神经网络步骤如下: 1: ...

- 『PyTorch』第四弹_通过LeNet初识pytorch神经网络_下

『PyTorch』第四弹_通过LeNet初识pytorch神经网络_上 # Author : Hellcat # Time : 2018/2/11 import torch as t import t ...

- 机器学习:SVM(SVM 思想解决回归问题)

一.SVM 思想在解决回归问题上的体现 回归问题的本质:找到一条直线或者曲线,最大程度的拟合数据点: 怎么定义拟合,是不同回归算法的关键差异: 线性回归定义拟合方式:让所有数据点到直线的 MSE 的值 ...

- PyTorch 神经网络

PyTorch 神经网络 神经网络 神经网络可以通过 torch.nn 包来构建. 现在对于自动梯度(autograd)有一些了解,神经网络是基于自动梯度 (autograd)来定义一些模型.一个 n ...

- PyTorch神经网络集成技术

PyTorch神经网络集成技术 create_python_neuropod 将任意python代码打包为一个neurood包. create_python_neuropod( neuropod_pa ...

- Tensor:Pytorch神经网络界的Numpy

摘要:Tensor,它可以是0维.一维以及多维的数组,你可以将它看作为神经网络界的Numpy,它与Numpy相似,二者可以共享内存,且之间的转换非常方便. 本文分享自华为云社区<Tensor:P ...

- 【笔记】SVM思想解决回归问题

使用svm思想解决回归问题 使用svm思想解决是如何解决回归问题,其中回归问题的本质就是找一条线,能够最好的拟合数据点 怎么定义拟合就是回归算法的关键,线性回归算法就是让预测的直线的MSE的值最小,对 ...

- 【笔记】使用scikit-learn解决回归问题

使用sklearn解决回归问题 依然是加载数据 import numpy as np import matplotlib.pyplot as plt from sklearn import datas ...

- [翻译]用神经网络做回归(Using Neural Networks With Regression)

本文英文原文出自这里, 这个博客里面的内容是Java开源, 分布式深度学习项目deeplearning4j的介绍学习文档. 简介: 一般来说, 神经网络常被用来做无监督学习, 分类, 以及回归. 也就 ...

随机推荐

- datename()计算一个日期是星期几

- BZOJ5319/LOJ2551「JSOI2018」列队

问题描述 作为一名大学生,九条可怜在去年参加了她人生中的最后一次军训. 军训中的一个重要项目是练习列队,为了训练学生,教官给每一个学生分配了一个休息位置.每次训练开始前,所有学生都在各自的休息位置休息 ...

- git 工具常见命令

1.git是什么 git是分布式版本管理工具,一台电脑既可以是客户端,也可以是服务端.工作过程中可以断开网络. git中的三个概念: 1.版本库:在初始化git版本库之后会生成一个隐藏的文件, .gi ...

- Vue-路由传参query与params

注明:vue中 $router 和 $route 的区别 //$router : 是路由操作对象,只写对象 //$route : 路由信息对象,只读对象 //操作 路由跳转 this.$router. ...

- 吴裕雄 python 神经网络——TensorFlow训练神经网络:花瓣识别

import os import glob import os.path import numpy as np import tensorflow as tf from tensorflow.pyth ...

- Cisco Cat4500系列High CPU故障步骤摘要

在实际网络环境中,很多时候都会出现设备high CPU的情况,有些时候可能是bug,而某些情况下,也可能是网络中发生了变化,导致了设备出现high CPU情况,这里主要记录一下Cisco Cat450 ...

- C语言入门第十章----结构体

C语言结构体从本质上讲是一种自定义的数据类型,只不过这种数据类型比较复杂,是由int.char .float等基本类型组成的,你可以认为结构体是一种聚合类型. 在实际开发中,我们可以将一组类型不同的. ...

- 201771010131-王之泰 实验一 软件工程准备—<通读《现代软件工程—构建之法》后所思所想>周学习总结

项目 内容 作业所属课程 https://www.cnblogs.com/nwnu-daizh/ 作业要求 https://www.cnblogs.com/nwnu-daizh/p/12369881. ...

- leetCode练题——9. Palindrome Number

1.题目 9. Palindrome Number Determine whether an integer is a palindrome. An integer is a palindrome ...

- uniGUI之UniSyntaxEdit(24)

UniSyntaxEdit1语法高亮显示控件,主要属性Language,它是 多行 1]Language 语言 2]执行 FDquery1.Open(UniSyntaxEdit1.Lines.Tex ...