OpenCV开发笔记(八十三):图像remap实现哈哈镜效果

前言

对图像进行非规则的扭曲,实现哈哈镜就是一种非常规的扭曲方式,本文先描述remap的原理,然后通过remap实现哈哈镜。

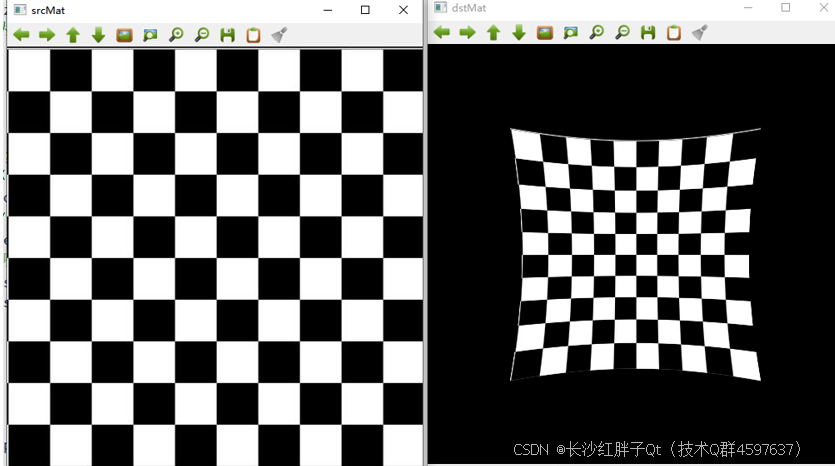

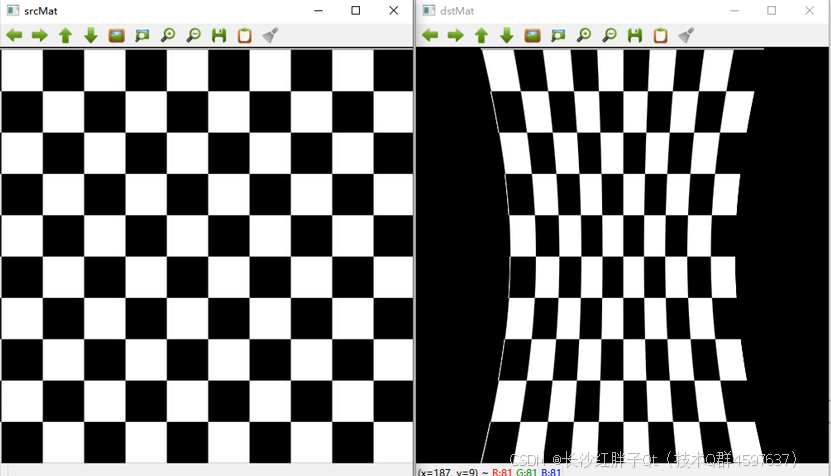

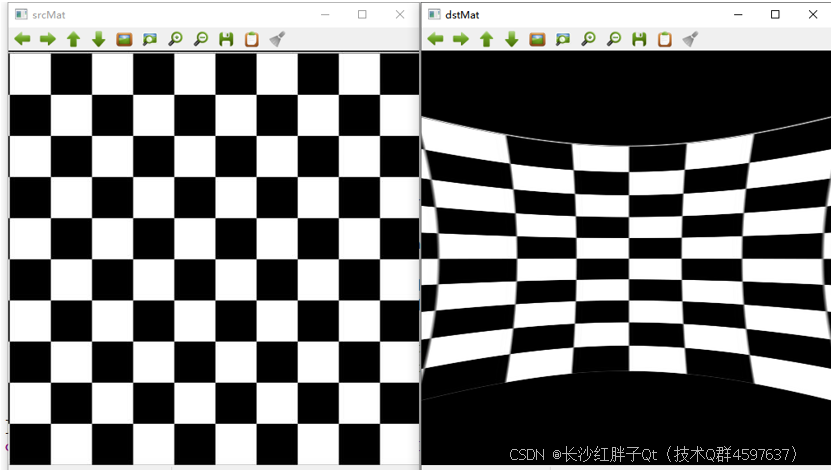

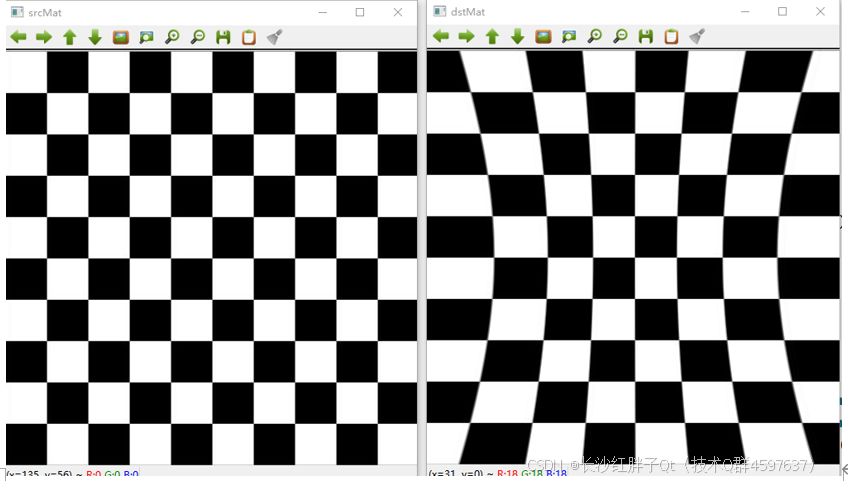

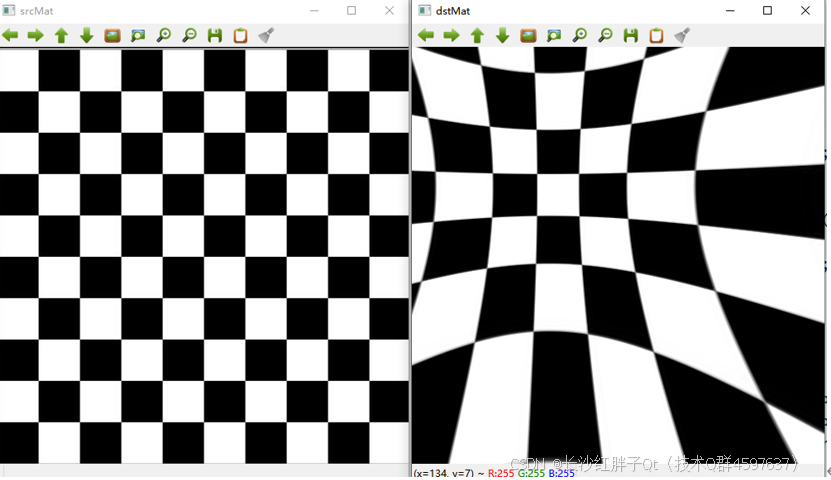

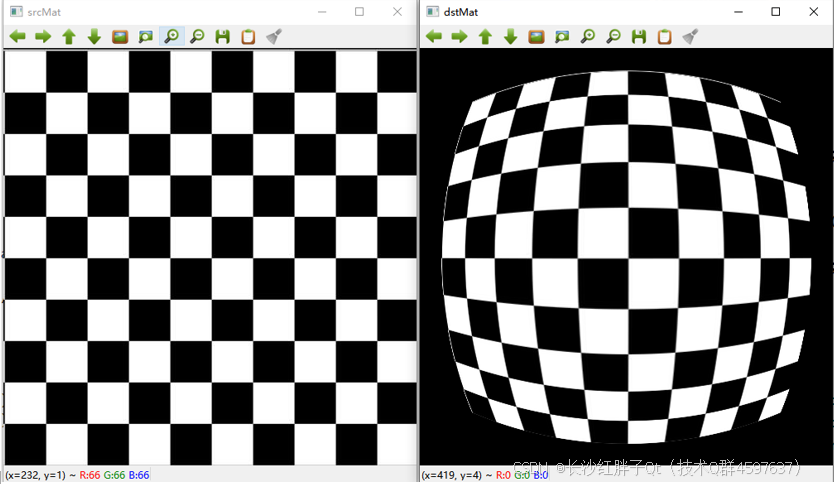

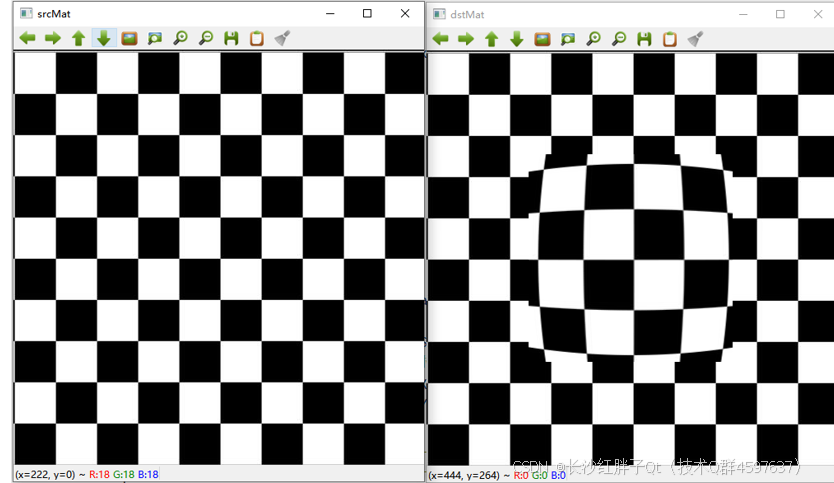

Demo

基于原始算法,可以进行二次开发,实现一些其他效果:

矫正映射remap(畸变映射)

当进行图像矫正时,必须指定输入图像的每个像素在输出图像中移动到的位置,成为“矫正映射”(畸变映射)。

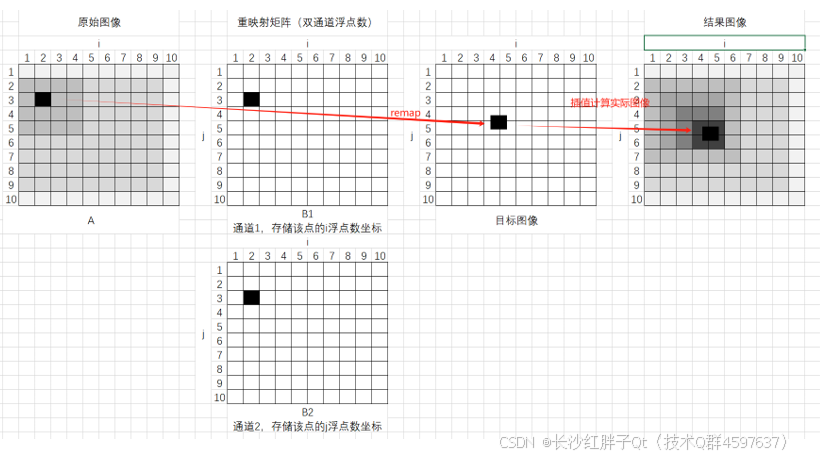

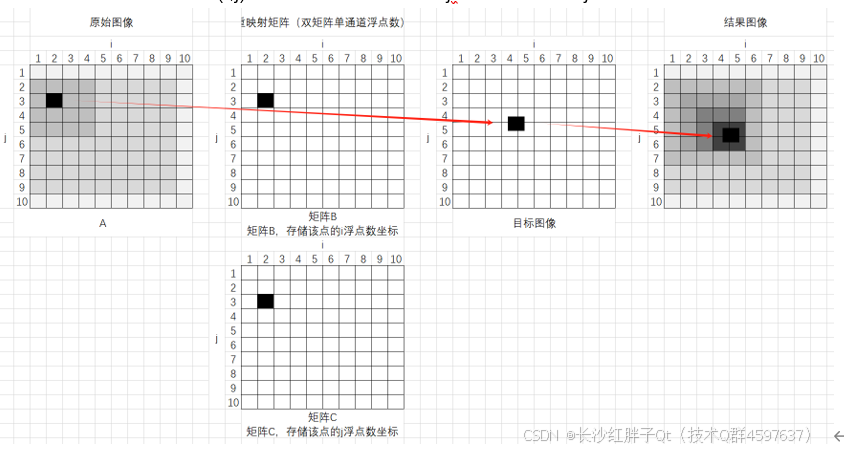

双通道浮点数表示方式

N x M的矩阵A中,重映射由双通道浮点数的N x M的矩阵B表示,对于图像A中的任意一点aPoint(i, j),映射为b1Point(i’, j’)和b2Point(i’, j’),在A中假设i=2,j=3,那么(假设重映射之后4.5,5.5)在B1中b1Point(i’, j’)值为4.5,b2Point(i’, j’)值为5.5,由于坐标是浮点数,那么需要插值得到整数位置以及中间过渡的区域颜色(平滑处理)。

双矩阵浮点数表示方式

双矩阵浮点数表示,N x M的矩阵A中,重映射由一对N x M的矩阵B和C描述,这里所有的N x M矩阵都是单通道浮点矩阵,在A中的点aPoint(i, j),重映射矩阵B中的点bPoint(i,j)存储了重映射后的i’ (映射后的i坐标), 重映射矩阵C中的点cPoint(i,j)存储了重映射后的j’(映射后的j坐标)。

定点表示方式

映射由双通道有符号整数矩阵(即CV_16SC2类型)表示。该方式与双通道浮点数表示方式相同,但使用此格式要快得多(笔者理解:由浮点数插值改为整数插值,会要快一些,但是肯定双通道浮点数的表示方式图像效果会稍微好一些)。

remap核心关键

在于得到插值的坐标系来映射新位置的x和y位置,要渐近等,所以本方法的核心关键在于得到标定后的矩阵,得到映射矩阵的方式可以自己写算法,也可以使用其他方式,后续文章继续深入这块。

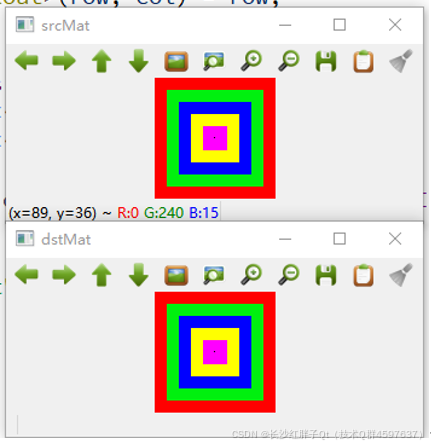

remap演示

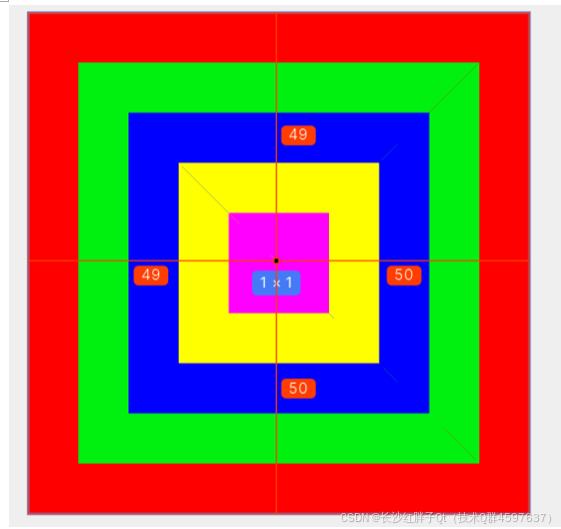

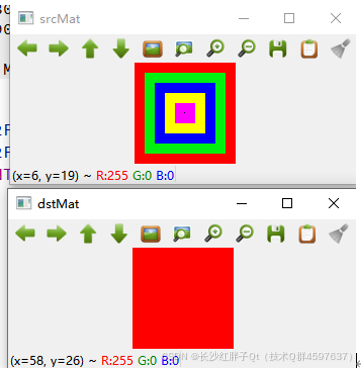

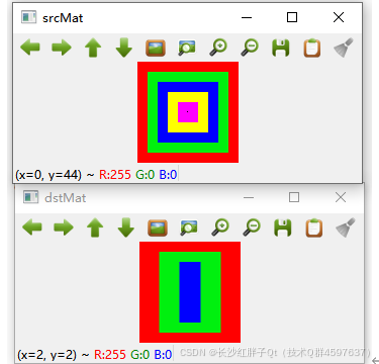

为了更好的展示remap的作用,我们使用一张100x100的图,这样可以更好的看到remap的原理效果。

先做一张100x100的图,图里面用不同的颜色,如下:

使用opencv打开:

Map1使用第一种表示点的方式

使用点的方式映射:

// 表示点的第一种

std::vector<cv::Point2f> vectorPoints;

for(int index = 0; index < 10; index++)

{

vectorPoints.push_back(cv::Point2f(0, 0));

vectorPoints.push_back(cv::Point2f(10, 10));

vectorPoints.push_back(cv::Point2f(20, 20));

vectorPoints.push_back(cv::Point2f(30, 30));

vectorPoints.push_back(cv::Point2f(40, 40));

vectorPoints.push_back(cv::Point2f(50, 50));

vectorPoints.push_back(cv::Point2f(60, 60));

vectorPoints.push_back(cv::Point2f(70, 70));

vectorPoints.push_back(cv::Point2f(80, 80));

vectorPoints.push_back(cv::Point2f(90, 90));

}

这是相当于把点提取出来映射到一个mat里面,一直堆下去:

// 表示点的第一种

std::vector<cv::Point2f> vectorPoints;

for(int index = 0; index < 50; index++)

{

vectorPoints.push_back(cv::Point2f(0, 0));

vectorPoints.push_back(cv::Point2f(10, 10));

vectorPoints.push_back(cv::Point2f(20, 20));

vectorPoints.push_back(cv::Point2f(30, 30));

vectorPoints.push_back(cv::Point2f(40, 40));

vectorPoints.push_back(cv::Point2f(50, 50));

vectorPoints.push_back(cv::Point2f(60, 60));

vectorPoints.push_back(cv::Point2f(70, 70));

vectorPoints.push_back(cv::Point2f(80, 80));

vectorPoints.push_back(cv::Point2f(90, 90));

}

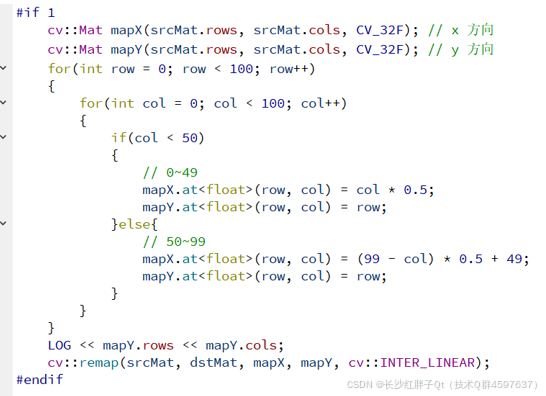

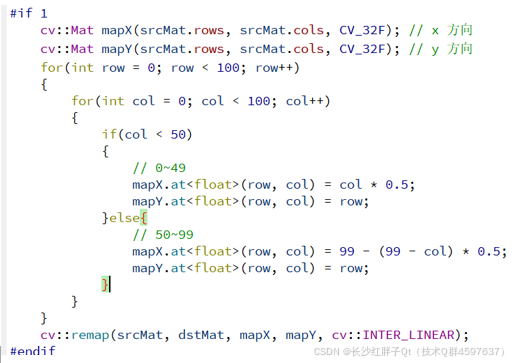

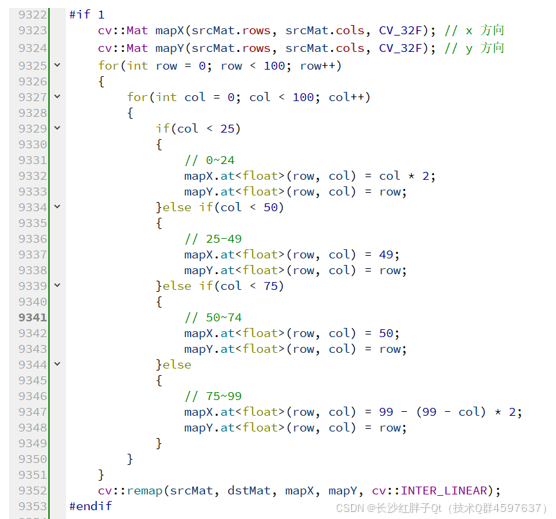

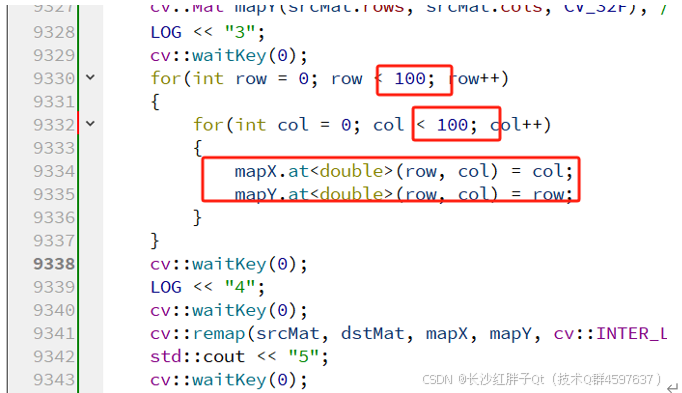

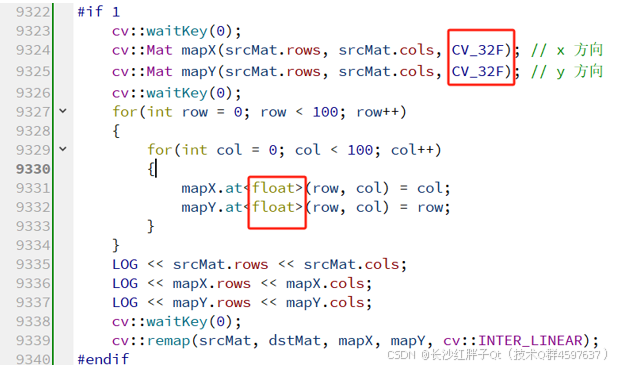

Map1使用第二种表示点的方式

直接初始化:

cv::Mat mapX(srcMat.rows, srcMat.cols, CV_32F); // x 方向

cv::Mat mapY(srcMat.rows, srcMat.cols, CV_32F); // y 方向

for(int row = 0; row < 100; row++)

{

for(int col = 0; col < 100; col++)

{

std::cout << mapX.at<double>(row, col);

}

}

cv::remap(srcMat, dstMat, mapX, mapY, cv::INTER_LINEAR);

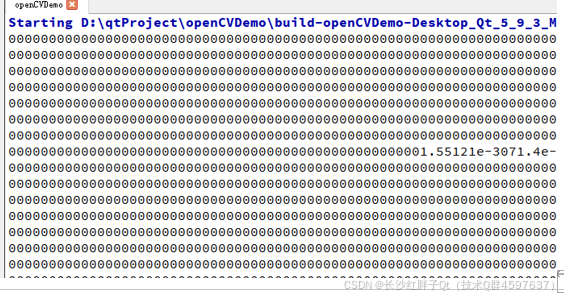

打印输出都是0:

这里map保存的是原来现在这个位置的点映射到原来图片哪个坐标点(注意:不是原来哪个位置映射到map哪个位置,是map的纵横坐标点映射原来值里面的那个坐标)左右从中间向两边拉伸则是:

cv::Mat mapX(srcMat.rows, srcMat.cols, CV_32F); // x 方向

cv::Mat mapY(srcMat.rows, srcMat.cols, CV_32F); // y 方向

for(int row = 0; row < 100; row++)

{

for(int col = 0; col < 100; col++)

{

if(col < 25)

{

// 0~24

mapX.at<float>(row, col) = col * 2;

mapY.at<float>(row, col) = row;

}else if(col < 50)

{

// 25-49

mapX.at<float>(row, col) = 49;

mapY.at<float>(row, col) = row;

}else if(col < 75)

{

// 50~74

mapX.at<float>(row, col) = 50;

mapY.at<float>(row, col) = row;

}else

{

// 75~99

mapX.at<float>(row, col) = 99 - (99 - col) * 2;

mapY.at<float>(row, col) = row;

}

}

}

cv::remap(srcMat, dstMat, mapX, mapY, cv::INTER_LINEAR);

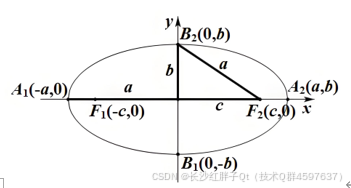

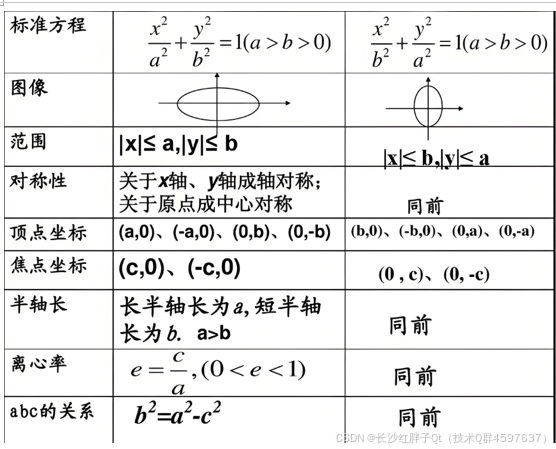

核心桥梁:椭圆

椭圆的标准方程,对于一个中心在原点、长轴在x轴上的椭圆,其标准方程为:

其中,a是椭圆长轴的一半,b是椭圆短轴的一半。

给定一个参数t(通常称为参数或偏心率角),椭圆上的点(x,y)可以用以下参数方程表示:

其中,t的取值范围是[0,2π),通过改变t的值,可以得到椭圆上的不同点。例如,假设有一个椭圆,其长轴为10,短轴为6。那么,a=5,b=3。

- 当t=0时,点(x,y)=(5,0),这是椭圆长轴上的一个端点。

- 当 t=2π时,点(x,y)=(0,3),这是椭圆短轴上的一个端点。

- 当t=π时,点(x,y)=(−5,0),这是椭圆长轴上的另一个端点。

- 当t=2/3*π时,点(x,y)=(0,−3),这是椭圆短轴上的另一个端点。

通过改变t的值,可以得到椭圆上的任意点。

哈哈镜实现

int cols = srcMat.cols;

int rows = srcMat.rows;

double horizontalStrength = 1.0f;

double verticalStrength = 1.0f;

double zoom = 1.0;

int cx = cols / 2;

int cy = rows / 2;

for(int x = 0; x < cols; x++)

{

for(int y = 0; y < rows; y++)

{

// 先求的范围内的点离中心点的偏移比例

double dx = (x - cx) * 1.0f / cx;

double dy = (y - cy) * 1.0f / cy;

// 求得中心点的距离

double distance = sqrt(dx * dx + dy * dy);

// 缩放半径

double r = distance / zoom;

// 后面除0操作,这里防止为0

if(r == 0)

{

r = 1e-6;

}

// 求出角度

double theta = atan(r);

// 求出最新比例覆盖点的rX

double rDistortedX = horizontalStrength * theta / r;

// 求出最新比例覆盖点的rY

double rDistortedY = verticalStrength * theta / r;

// 求出当前这个点使用原来哪个点映射

double dstX = cx + rDistortedX * dx * cx;

double dstY = cy + rDistortedY * dy * cy;

// 给map赋值

mapX.at<float>(y, x) = static_cast<float>(dstX);

mapY.at<float>(y, x) = static_cast<float>(dstY);

}

}

函数原型

void remap(InputArray src,

OutputArray dst,

InputArray map1,

InputArray map2,

int interpolation,

int borderMode = BORDER_CONSTANT,

const Scalar& borderValue = Scalar());

参数一:InputArray类型的src,一般为cv::Mat;

参数二:OutputArray类型的dst,目标图像。它的大小与map1相同,类型与src相同。

参数三:InputArray类型的map1,它有两种可能的表示对象:表示点(x,y)的第一个映射或者表示CV_16SC2 , CV_32FC1或CV_32FC2类型的x值。

参数四:InputArray类型的map2,它也有两种可能的表示对象,而且他是根据map1来确定表示哪种对象。若map1表示点(x,y)时,这个参数不代表任何值,否则,表示CV_16UC1 , rCV_32FC1类型的y值(第二个值)。

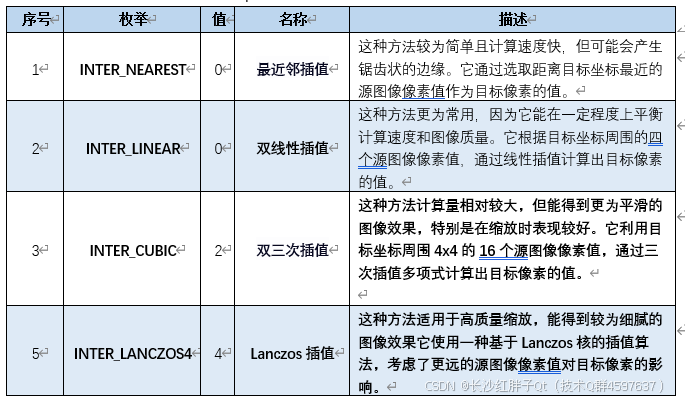

参数五:int类型的interpolation,使用的插值方法;

参数六:int类型的borderMode,边界处理方式;

参数七:Scalar类型的borderValue,重映射后,离群点的背景,需要broderMode设置为BORDER_CONSTRANT时才有效。(离群点:当图片大小为400x300,那么对应的map1和map2范围为0399、0299,小于0或者大于299的则为离散点,使用该颜色填充);

Demo源码

void OpenCVManager::testDistortingMirror()

{

#if 1

// 测试remap的Demo

// cv::Mat srcMat = cv::imread("D:/qtProject/openCVDemo/openCVDemo/modules/openCVManager/images/41.png");

// cv::Mat srcMat = cv::imread("D:/qtProject/openCVDemo/openCVDemo/modules/openCVManager/images/25.jpg");

cv::Mat srcMat = cv::imread("D:/qtProject/openCVDemo/openCVDemo/modules/openCVManager/images/42.jpg");

if(srcMat.data == 0)

{

return;

}

cv::imshow("srcMat", srcMat);

// remap的

/*

插值方法:

INTER_NEAREST = 0,

INTER_LINEAR = 1,

INTER_CUBIC = 2,

INTER_AREA = 3,

INTER_LANCZOS4 = 4,

INTER_LINEAR_EXACT = 5,

INTER_MAX = 7,

WARP_FILL_OUTLIERS = 8,

WARP_INVERSE_MAP = 16

*/

cv::Mat dstMat = cv::Mat(srcMat.rows, srcMat.cols, srcMat.type());

#if 0

// 表示点的第一种

std::vector<cv::Point2f> vectorPoints;

for(int index = 0; index < 50; index++)

{

vectorPoints.push_back(cv::Point2f(0, 0));

vectorPoints.push_back(cv::Point2f(10, 10));

vectorPoints.push_back(cv::Point2f(20, 20));

vectorPoints.push_back(cv::Point2f(30, 30));

vectorPoints.push_back(cv::Point2f(40, 40));

vectorPoints.push_back(cv::Point2f(50, 50));

vectorPoints.push_back(cv::Point2f(60, 60));

vectorPoints.push_back(cv::Point2f(70, 70));

vectorPoints.push_back(cv::Point2f(80, 80));

vectorPoints.push_back(cv::Point2f(90, 90));

}

cv::remap(srcMat, dstMat, vectorPoints, cv::Mat(), cv::INTER_LINEAR);

#endif

#if 0

cv::Mat mapX(srcMat.rows, srcMat.cols, CV_32F); // x 方向

cv::Mat mapY(srcMat.rows, srcMat.cols, CV_32F); // y 方向

for(int row = 0; row < 100; row++)

{

for(int col = 0; col < 100; col++)

{

if(col < 25)

{

// 0~24

mapX.at<float>(row, col) = col * 2;

mapY.at<float>(row, col) = row;

}else if(col < 50)

{

// 25-49

mapX.at<float>(row, col) = 49;

mapY.at<float>(row, col) = row;

}else if(col < 75)

{

// 50~74

mapX.at<float>(row, col) = 50;

mapY.at<float>(row, col) = row;

}else

{

// 75~99

mapX.at<float>(row, col) = 99 - (99 - col) * 2;

mapY.at<float>(row, col) = row;

}

}

}

cv::remap(srcMat, dstMat, mapX, mapY, cv::INTER_LINEAR);

#endif

cv::Mat mapX(srcMat.rows, srcMat.cols, CV_32F); // x 方向

cv::Mat mapY(srcMat.rows, srcMat.cols, CV_32F); // y 方向

// 这里显示原本的图

for(int row = 0; row < srcMat.rows; row++)

{

for(int col = 0; col < srcMat.cols; col++)

{

mapX.at<float>(row, col) = col;

mapY.at<float>(row, col) = row;

}

}

#if 0

// 使用径向畸变

{

// 这里a永远是长边,长边是纵向的

{

int cols = srcMat.cols;

int rows = srcMat.rows;

double horizontalStrength = 2.0f;

double verticalStrength = 2.0f;

double zoom = 1.0;

int cx = cols / 2;

int cy = rows / 2;

for(int x = 0; x < cols; x++)

{

for(int y = 0; y < rows; y++)

{

// 先求的范围内的点离中心点的偏移比例

double dx = (x - cx) * 1.0f / cx;

double dy = (y - cy) * 1.0f / cy;

// 求得中心点的距离

double distance = sqrt(dx * dx + dy * dy);

// 缩放半径

double r = distance / zoom;

// 后面除0操作,这里防止为0

if(r == 0)

{

r = 1e-6;

}

// 求出角度

double theta = atan(r);

// 求出最新比例覆盖点的rX

double rDistortedX = horizontalStrength * theta / r;

// 求出最新比例覆盖点的rY

double rDistortedY = verticalStrength * theta / r;

// 求出当前这个点使用原来哪个点映射

double dstX = cx + rDistortedX * dx * cx;

double dstY = cy + rDistortedY * dy * cy;

// 给map赋值

mapX.at<float>(y, x) = static_cast<float>(dstX);

mapY.at<float>(y, x) = static_cast<float>(dstY);

}

}

}

cv::remap(srcMat, dstMat, mapX, mapY, cv::INTER_LINEAR);

}

#endif

#if 1

// 使用径向畸变

{

// 这里a永远是长边,长边是纵向的

{

int cols = srcMat.cols;

int rows = srcMat.rows;

double horizontalStrength = 1.0f;

double verticalStrength = 1.0f;

double zoom = 1.0;

int cx = cols / 2;

int cy = rows / 2;

for(int x = 0; x < cols; x++)

{

for(int y = 0; y < rows; y++)

{

// 先求的范围内的点离中心点的偏移比例

double dx = (x - cx) * 1.0f / cx;

double dy = (y - cy) * 1.0f / cy;

// 求得中心点的距离

double distance = sqrt(dx * dx + dy * dy);

// 缩放半径

double r = distance / zoom;

// 后面除0操作,这里防止为0

if(r == 0)

{

r = 1e-6;

}

// 求出角度

double theta = atan(r);

// 求出最新比例覆盖点的rX

double rDistortedX = horizontalStrength * theta / r;

// 求出最新比例覆盖点的rY

double rDistortedY = verticalStrength * theta / r;

// 求出当前这个点使用原来哪个点映射

double dstX = cx + rDistortedX * dx * cx;

double dstY = cy + rDistortedY * dy * cy;

// 给map赋值

mapX.at<float>(y, x) = static_cast<float>(dstX);

mapY.at<float>(y, x) = static_cast<float>(dstY);

}

}

}

cv::remap(srcMat, dstMat, mapX, mapY, cv::INTER_LINEAR);

}

#endif

cv::imshow("dstMat", dstMat);

while(true)

{

cv::waitKey(0);

}

#endif

}

工程模板v1.73.0

入坑

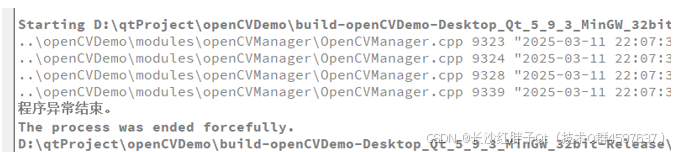

入坑一:map1和map2映射崩溃

问题

映射崩溃,图是100x100,那么坐标x和y都是099,099,但是运行崩溃。

原因

定位到remap奔溃,发现map的类型是float不是double。

解决

OpenCV开发笔记(八十三):图像remap实现哈哈镜效果的更多相关文章

- OpenCV开发笔记(七十三):红胖子8分钟带你使用opencv+dnn+yolov3识别物体

前言 级联分类器的效果并不是很好,准确度相对深度学习较低,上一章节使用了dnn中的tensorflow,本章使用yolov3模型,识别出具体的分类. Demo 320x320,置信度0 ...

- OpenCV开发笔记(六十五):红胖子8分钟带你深入了解ORB特征点(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(六十九):红胖子8分钟带你使用传统方法识别已知物体(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(六十四):红胖子8分钟带你深入了解SURF特征点(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- 【opencv学习笔记八】创建TrackBar轨迹条

createTrackbar这个函数我们以后会经常用到,它创建一个可以调整数值的轨迹条,并将轨迹条附加到指定的窗口上,使用起来很方便.首先大家要记住,它往往会和一个回调函数配合起来使用.先看下他的函数 ...

- OpenCV开发笔记(五十五):红胖子8分钟带你深入了解Haar、LBP特征以及级联分类器识别过程(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(五十六):红胖子8分钟带你深入了解多种图形拟合逼近轮廓(图文并茂+浅显易懂+程序源码)

若该文为原创文章,未经允许不得转载原博主博客地址:https://blog.csdn.net/qq21497936原博主博客导航:https://blog.csdn.net/qq21497936/ar ...

- OpenCV开发笔记(七十一):红胖子8分钟带你深入级联分类器训练

前言 红胖子,来也! 做图像处理,经常头痛的是明明分离出来了(非颜色的),分为几块区域,那怎么知道这几块区域到底哪一块是我们需要的,那么这部分就涉及到需要识别了. 识别可以自己写模板匹配.特征 ...

- OpenCV开发笔记(七十二):红胖子8分钟带你使用opencv+dnn+tensorFlow识别物体

前言 级联分类器的效果并不是很好,准确度相对深度学习较低,本章使用opencv通过tensorflow深度学习,检测已有模型的分类. Demo 可以猜测,1其实是人,18序号类是狗 ...

- OpenCV开发笔记(七十四):OpenCV3.4.1+ffmpeg3.4.8交叉编译移植到海思平台Hi35xx平台

前言 移植opencv到海思平台,opencv支持对视频进行解码,需要对应的ffmpeg支持. Ffmpeg的移植 Ffmpeg的移植请参考之前的文章:<FFmpeg开发笔记(十): ...

随机推荐

- vagrant 修改配置生效

vagrant reload --provision 起因 看 log 的时候以为写入错误,排查了几次才发现是系统时间不对,这里记录一下解决过程 手动同步时间 yum install ntpdate ...

- Windows下如何在当前目录下,打开cmd命令窗口

方法一: 在当前目录下,按下shift + 鼠标右键,会出现"在此处打开命令窗口"的字样,然后点击即可. 方法二: 在该文件夹上,按下shift + 鼠标右键,会出现"在 ...

- Sealos Devbox 基础教程:使用 Cursor 从零开发一个 One API 替代品

随着技术的成熟和 AI 的崛起,很多原本需要团队协作才能完成的工作现在都可以通过自动化和智能化的方式完成.于是乎,单个开发者的能力得到了极大的提升 - 借助各种工具,一个人就可以完成开发.测试.运维等 ...

- Qt/C++编写视频监控系统80-远程回放视频流

一.前言 远程回放NVR或者服务器上的视频文件,一般有三种方式,第一种是调用厂家的SDK,这个功能最全,但是缺点明显就是每个厂家的设备都有自己的SDK,只兼容自家的设备,如果你的软件需要接入多个厂家的 ...

- Qt音视频开发31-qmedia内核qt5/qt6播放视频

一.前言 在qt5中的多媒体框架明显比qt4丰富了很多,使用也极其友好,提供的api接口非常简单明了,不需要像qt4中那样还需要绑定和创建路径之类的.同样也还是依赖本地解码器,qt6中的多媒体框架据说 ...

- Qt设置运行时动态库路径的几点说明

随着需求的不断增加,程序不断变大,用到的动态库也越来越多,到了发布程序的时候你会发现和可执行文件同一目录下文件数量真多(比如著名的金融软件 https://www.webull.com/ 哎呀我去,目 ...

- Qt通用方法及类库3

函数名 //设置全局样式 static void setStyle(QUIWidget::Style style); static void setStyle(const QString &q ...

- [转]Windows10下CLion配置说明

Windows10下CLion配置说明CLion 是 C/C++的 IDE,可以配置多种编译环境,本文以配置MinGW编译环境为例. 安装CLion 的安装可直接到官网下载 ZIP,文件解压后直接运行 ...

- MySQL数据库建库时SQL语句中数据库名、表名用引号的问题以及COLLATE utf8_general_ci的含义

一.MySQL数据库建库时SQL语句中数据库名.表名用引号的问题解释:在创建MySQL数据库和表时,数据库名.表名和字段名外面的符号 ` 不是单引号,而是英文输入法的反单引号,同键盘~同一位置.为了避 ...

- 微信后团队分享:微信后台基于Ray的分布式AI计算技术实践

本文由微信后台Astra项目团队分享,原题"Ray在微信AI计算中的大规模实践",下文进行了排版和内容优化. 1.引言 微信存在大量AI计算的应用场景,主要分为三种:流量分发.产品 ...