Qt音视频开发38-USB摄像头解码linux方案

一、前言

做嵌入式linux上的开发很多年了,扳手指头算算,也起码9年了,陆陆续续做过很过诸如需要读取外接的USB摄像头或者CMOS摄像机的程序,实时采集视频,将图像传到前端,或者对图像进行人脸分析处理,最开始尝试的就是QCamera来处理,直接歇菜放弃,后面通过搜索发现都说要用v4l2视频框架来进行,于是东搞搞西搞搞尝试了很多次,终于整出来了,前后完善了好几年,无论写什么程序,发现要简简单单的实现基础的功能,都是非常快速而且容易的,但是想要做得好做得精,要花不少的精力时间去完善,适应各种不同的场景,比如就说用v4l2加载摄像头这个,需要指定设备文件来读取,而现场不可能让用户来给你指定,频繁的拔插也会导致设备文件名的改动,所以必须找到一个机制自动寻找你想要的摄像机的设备文件名称,比如开个定时器去调用linux命令来处理,甚至在不同的系统平台上要执行的命令还有些许的区别,如果本地有多个摄像头还需要区分左右之类的时候,那就只能通过断电先后上电顺序次序来区分了。

linux方案处理流程:

- 调用封装的函数findCamera实时查找摄像头设备文件名。

- 调用::open函数打开设备文件。

- 调用封装的函数initCamera初始化摄像头参数(图片格式、分辨率等)。

- 调用::select函数从缓冲区取出一个缓冲帧。

- 缓冲帧数据是yuyv格式的,需要转换rgb24再转成QImage。

- 拿到图片进行绘制、人脸分析等。

- 关闭设备文件。

二、功能特点

- 同时支持windows、linux、嵌入式linux上的USB摄像头实时采集。

- 支持多路USB摄像头多线程实时采集。

- 在嵌入式linux设备上,自动查找USB设备文件并加载。

- 可手动设置设备文件名称,手动设置后按照手动设置的设备文件加载。

- 在嵌入式linux设备上支持人脸识别接口,实时绘制人脸框。

- 具有打开、暂停、继续、关闭、截图等常规功能。

- 可设置两路OSD标签,分别设置文本、颜色、字号、位置等。

- 可作为视频监控系统使用。

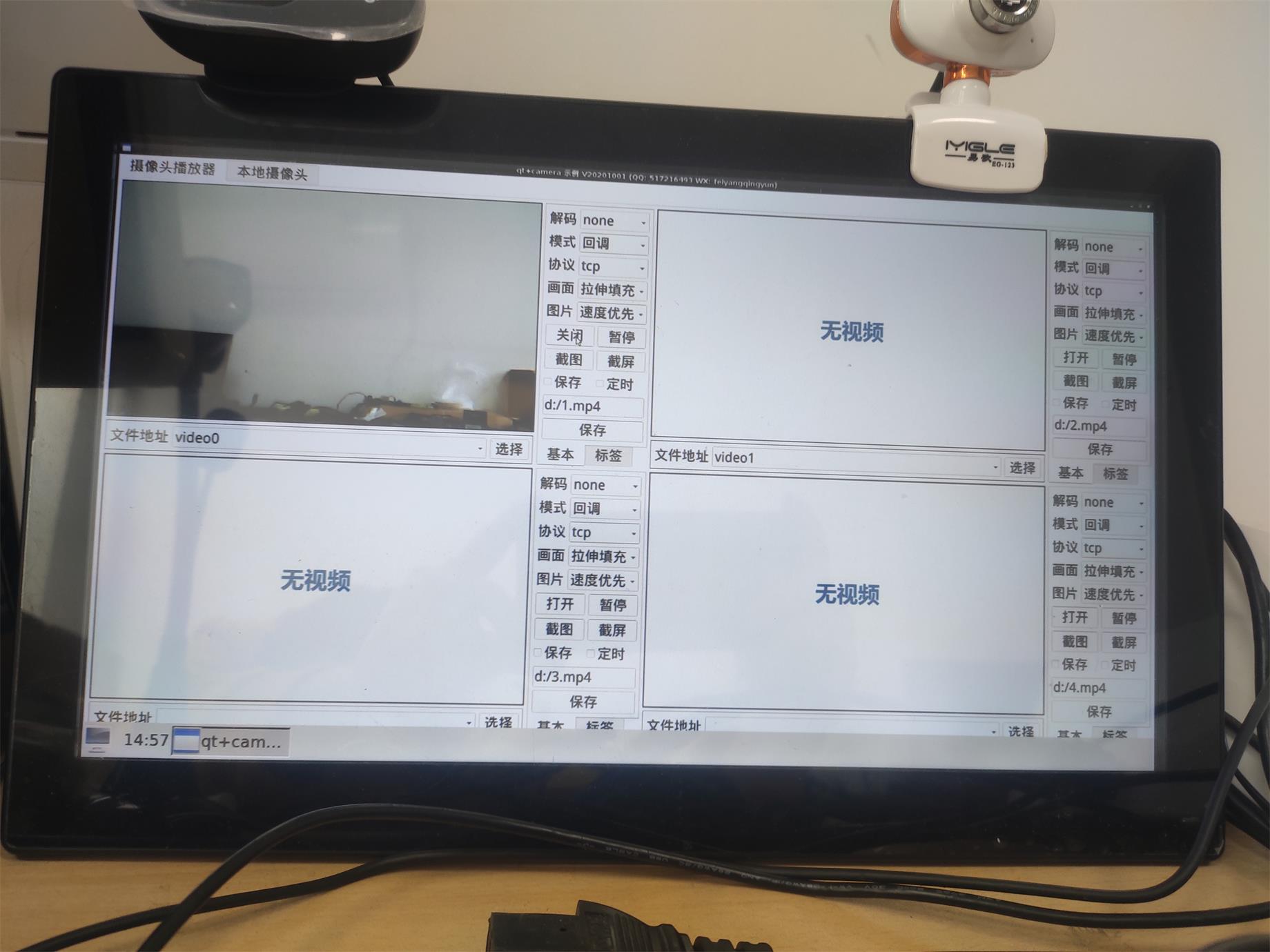

三、效果图

四、相关站点

- 国内站点:https://gitee.com/feiyangqingyun/QWidgetDemo

- 国际站点:https://github.com/feiyangqingyun/QWidgetDemo

- 个人主页:https://blog.csdn.net/feiyangqingyun

- 知乎主页:https://www.zhihu.com/people/feiyangqingyun/

- 体验地址:https://blog.csdn.net/feiyangqingyun/article/details/97565652

五、核心代码

void CameraLinux::run()

{

while (!stopped) {

if (!cameraOk) {

msleep(10);

continue;

}

if (isPause) {

//这里需要假设正常,暂停期间继续更新时间

lastTime = QDateTime::currentDateTime();

msleep(10);

continue;

}

QImage image = readImage();

if (!image.isNull()) {

if (isSnap) {

emit snapImage(image);

isSnap = false;

}

if (findFaceOne) {

findFace(image);

}

if (findFaceRect) {

image = drawFace(image);

}

lastTime = QDateTime::currentDateTime();

emit receiveImage(image);

}

msleep(interval);

}

this->closeCamera();

this->initData();

}

QDateTime CameraLinux::getLastTime() const

{

return this->lastTime;

}

QString CameraLinux::getCameraName() const

{

return this->cameraName;

}

int CameraLinux::getCameraWidth() const

{

return this->cameraWidth;

}

int CameraLinux::getCameraHeight() const

{

return this->cameraHeight;

}

void CameraLinux::sleep(int msec)

{

if (msec > 0) {

QTime endTime = QTime::currentTime().addMSecs(msec);

while (QTime::currentTime() < endTime) {

QCoreApplication::processEvents(QEventLoop::AllEvents, 100);

}

}

}

void CameraLinux::initData()

{

stopped = false;

isPause = false;

isSnap = false;

cameraOk = false;

cameraHwnd = -1;

errorCount = 0;

}

void CameraLinux::readData()

{

QStringList cameraNames;

while (!process->atEnd()) {

//逐行读取返回的结果 过滤video开头的是摄像头设备文件

QString line = process->readLine();

if (line.startsWith("video")) {

line = line.replace("\n", "");

cameraNames << QString("/dev/%1").arg(line);

}

}

if (cameraNames.count() > 0) {

cameraName = cameraNames.first();

emit receiveCamera(cameraNames);

qDebug() << TIMEMS << cameraNames;

}

}

bool CameraLinux::initCamera()

{

//如果没有指定设备文件名称(默认auto)则查找

if (cameraName == "auto") {

findCamera();

}

//延时判断是否获取到了设备文件

sleep(300);

return openCamera();

}

void CameraLinux::findCamera()

{

if (process->state() == QProcess::NotRunning) {

process->start("ls /dev/");

}

}

bool CameraLinux::openCamera()

{

#ifdef Q_OS_LINUX

if (cameraName.length() > 5) {

cameraHwnd = ::open(cameraName.toUtf8().data(), O_RDWR | O_NONBLOCK, 0);

}

if (cameraHwnd < 0) {

qDebug() << TIMEMS << "open camera error";

return false;

}

//查询设备属性

struct v4l2_capability capability;

if (::ioctl(cameraHwnd, VIDIOC_QUERYCAP, &capability) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_QUERYCAP";

::close(cameraHwnd);

return false;

}

if (!(capability.capabilities & V4L2_CAP_VIDEO_CAPTURE)) {

qDebug() << TIMEMS << "it is not a video capture device";

::close(cameraHwnd);

return false;

}

if (!(capability.capabilities & V4L2_CAP_STREAMING)) {

qDebug() << TIMEMS << "it can not streaming";

::close(cameraHwnd);

return false;

}

if (capability.capabilities == 0x4000001) {

qDebug() << TIMEMS << "capabilities" << "V4L2_CAP_VIDEO_CAPTURE | V4L2_CAP_STREAMING";

}

//设置视频输入源

int input = 0;

if (::ioctl(cameraHwnd, VIDIOC_S_INPUT, &input) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_S_INPUT";

::close(cameraHwnd);

return false;

}

//设置图片格式和分辨率

struct v4l2_format format;

format.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

//多种格式 V4L2_PIX_FMT_YUV420 V4L2_PIX_FMT_YUYV(422) V4L2_PIX_FMT_RGB565

format.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;

//部分硬件花屏要设置成 V4L2_FIELD_NONE

format.fmt.pix.field = V4L2_FIELD_INTERLACED;

format.fmt.pix.width = cameraWidth;

format.fmt.pix.height = cameraHeight;

int bpp = 16;

//format.fmt.pix.bytesperline = width * bpp / 8;

//format.fmt.pix.sizeimage = cameraWidth * cameraHeight * bpp / 8;

if (::ioctl(cameraHwnd, VIDIOC_S_FMT, &format) < 0) {

::close(cameraHwnd);

return false;

}

//查看图片格式和分辨率,判断是否设置成功

if (::ioctl(cameraHwnd, VIDIOC_G_FMT, &format) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_G_FMT";

::close(cameraHwnd);

return false;

}

//重新打印下宽高看下是否真正设置成功

struct v4l2_pix_format pix = format.fmt.pix;

quint32 pixelformat = pix.pixelformat;

qDebug() << TIMEMS << "cameraWidth" << cameraWidth << "cameraHeight" << cameraHeight << "width" << pix.width << "height" << pix.height;

qDebug() << TIMEMS << "pixelformat" << QString("%1%2%3%4").arg(QChar(pixelformat & 0xFF)).arg(QChar((pixelformat >> 8) & 0xFF)).arg(QChar((pixelformat >> 16) & 0xFF)).arg(QChar((pixelformat >> 24) & 0xFF));

//重新设置宽高为真实的宽高

cameraWidth = pix.width;

cameraHeight = pix.height;

//设置帧格式

struct v4l2_streamparm streamparm;

streamparm.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

streamparm.parm.capture.timeperframe.numerator = 1;

streamparm.parm.capture.timeperframe.denominator = 25;

streamparm.parm.capture.capturemode = 0;

if (::ioctl(cameraHwnd, VIDIOC_S_PARM, &streamparm) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_S_PARM";

::close(cameraHwnd);

return false;

}

if (::ioctl(cameraHwnd, VIDIOC_G_PARM, &streamparm) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_G_PARM";

::close(cameraHwnd);

return false;

}

//申请和管理缓冲区

struct v4l2_requestbuffers requestbuffers;

requestbuffers.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

requestbuffers.memory = V4L2_MEMORY_MMAP;

requestbuffers.count = 1;

if (::ioctl(cameraHwnd, VIDIOC_REQBUFS, &requestbuffers) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_REQBUFS";

::close(cameraHwnd);

return false;

}

buff_yuv422 = (uchar *)malloc(cameraWidth * cameraHeight * bpp / 8);

buff_yuv420 = (uchar *)malloc(cameraWidth * cameraHeight * bpp / 8);

buff_rgb24 = (uchar *)malloc(cameraWidth * cameraHeight * 24 / 8);

buff_img = (ImgBuffer *)calloc(1, sizeof(ImgBuffer));

if (buff_img == NULL) {

qDebug() << TIMEMS << "error in calloc";

::close(cameraHwnd);

return false;

}

struct v4l2_buffer buffer;

for (int index = 0; index < 1; index++) {

buffer.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buffer.memory = V4L2_MEMORY_MMAP;

buffer.index = index;

if (::ioctl(cameraHwnd, VIDIOC_QUERYBUF, &buffer) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_QUERYBUF";

::free(buff_img);

::close(cameraHwnd);

return false;

}

buff_img[index].length = buffer.length;

buff_img[index].start = (quint8 *)mmap(NULL, buffer.length, PROT_READ | PROT_WRITE, MAP_SHARED, cameraHwnd, buffer.m.offset);

if (MAP_FAILED == buff_img[index].start) {

qDebug() << TIMEMS << "error in mmap";

::free(buff_img);

::close(cameraHwnd);

return false;

}

//把缓冲帧放入队列

if (::ioctl(cameraHwnd, VIDIOC_QBUF, &buffer) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_QBUF";

for (int i = 0; i <= index; i++) {

munmap(buff_img[i].start, buff_img[i].length);

}

::free(buff_img);

::close(cameraHwnd);

return false;

}

}

enum v4l2_buf_type type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

if (::ioctl(cameraHwnd, VIDIOC_STREAMON, &type) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_STREAMON";

for (int i = 0; i < 1; i++) {

munmap(buff_img[i].start, buff_img[i].length);

}

::free(buff_img);

::close(cameraHwnd);

return false;

}

cameraOk = true;

#endif

qDebug() << TIMEMS << "open camera ok";

return cameraOk;

}

void CameraLinux::closeCamera()

{

#ifdef Q_OS_LINUX

if (cameraOk && buff_img != NULL) {

//停止摄像头采集

enum v4l2_buf_type type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

if (::ioctl(cameraHwnd, VIDIOC_STREAMOFF, &type) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_STREAMOFF";

}

//解除内存映射

for (int i = 0; i < 1; i++) {

munmap((buff_img)[i].start, (buff_img)[i].length);

}

//关闭设备文件

::close(cameraHwnd);

qDebug() << TIMEMS << "close camera ok";

}

//释放资源

::free(buff_img);

buff_img = NULL;

::free(buff_yuv422);

buff_yuv422 = NULL;

::free(buff_yuv420);

buff_yuv420 = NULL;

::free(buff_rgb24);

buff_rgb24 = NULL;

cameraOk = false;

cameraHwnd = -1;

#endif

}

int CameraLinux::readFrame()

{

int index = -1;

#ifdef Q_OS_LINUX

//等待摄像头采集到一桢数据

for (;;) {

fd_set fds;

struct timeval tv;

FD_ZERO(&fds);

FD_SET(cameraHwnd, &fds);

tv.tv_sec = 2;

tv.tv_usec = 0;

int r = ::select(cameraHwnd + 1, &fds, NULL, NULL, &tv);

if (-1 == r) {

if (EINTR == errno) {

continue;

}

return -1;

} else if (0 == r) {

return -1;

} else {

//采集到一张图片 跳出循环

break;

}

}

//从缓冲区取出一个缓冲帧

struct v4l2_buffer buffer;

buffer.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;

buffer.memory = V4L2_MEMORY_MMAP;

if (::ioctl(cameraHwnd, VIDIOC_DQBUF, &buffer) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_DQBUF";

return -1;

}

memcpy(buff_yuv422, (uchar *)buff_img[buffer.index].start, buff_img[buffer.index].length);

//将取出的缓冲帧放回缓冲区

if (::ioctl(cameraHwnd, VIDIOC_QBUF, &buffer) < 0) {

qDebug() << TIMEMS << "error in VIDIOC_QBUF";

return -1;

}

index = buffer.index;

#endif

return index;

}

Qt音视频开发38-USB摄像头解码linux方案的更多相关文章

- Android IOS WebRTC 音视频开发总结(八十五)-- 使用WebRTC广播网络摄像头视频(下)

本文主要介绍WebRTC (我们翻译和整理的,译者:weizhenwei,校验:blacker),最早发表在[编风网] 支持原创,转载必须注明出处,欢迎关注我的微信公众号blacker(微信ID:bl ...

- Android IOS WebRTC 音视频开发总结(八十三)-- 使用WebRTC广播网络摄像头视频(上)

本文主要介绍WebRTC (我们翻译和整理的,译者:weizhenwei,校验:blacker),最早发表在[编风网] 支持原创,转载必须注明出处,欢迎关注我的微信公众号blacker(微信ID:bl ...

- Android开发 音视频开发需要了解的专业术语知识

前言 在摸索一段时间的音视频开发后,越来越发现这个坑的深度真是特别的深. 除了了解Android自带的音视频处理API以外,还得了解一些视频与音频方面的知识.这篇博客就是主要讲解这方面的专业术语.内容 ...

- Android音视频开发(1):H264 基本原理

前言 H264 视频压缩算法现在无疑是所有视频压缩技术中使用最广泛,最流行的.随着 x264/openh264 以及 ffmpeg 等开源库的推出,大多数使用者无需再对H264的细节做过多的研究,这大 ...

- Android IOS WebRTC 音视频开发总结(六)-- iOS开发之含泪经验

前段时间在搞webrtc iOS开发,所以将标题改为了Android IOS WebRTC 音视频开发总结, 下面都是开发过程中的经验总结,转载请说明出处(博客园RTC.Blacker): 1. IO ...

- Android WebRTC 音视频开发总结(四)-- webrtc传输模块

在介绍WebRTC通讯之前我们先来看一个P2P视频聊天包括的主要过程,转载请说明出处(博客园RTC.Blacker): 音视频数据采集->编码->发送->接收->解码-> ...

- WebRTC 音视频开发

WebRTC 音视频开发 webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译 ...

- Android 音视频开发学习思路

Android 音视频开发这块目前的确没有比较系统的教程或者书籍,网上的博客文章也都是比较零散的.只能通过一点点的学习和积累把这块的知识串联积累起来. 初级入门篇: Android 音视频开发(一) ...

- 转:Android IOS WebRTC 音视频开发总结 (系列文章集合)

随笔分类 - webrtc Android IOS WebRTC 音视频开发总结(七八)-- 为什么WebRTC端到端监控很关键? 摘要: 本文主要介绍WebRTC端到端监控(我们翻译和整理的,译 ...

- 音视频开发-FFmpeg

音视频开发是个非常复杂的,庞大的开发话题,初涉其中,先看一下结合 OEIP(开源项目) 新增例子. 可以打开flv,mp4类型文件,以及rtmp协议音视频数据,声音的播放使用SDL. 把采集的麦/声卡 ...

随机推荐

- .NET高级调试 - 3.12 sosex实用的几个命令介绍

简介 sosex是sos的一个拓展,主要目的是将一些繁琐的排查过程脚本化,比如探测死锁,设置断点等.更加方便快捷协助我们排查问题. 比较可惜的是,在.net core中不可用,作者已经不更新了. 更多 ...

- Android复习(二)应用资源——>可绘制对象资源

可绘制对象资源是图形的一般概念,是指可在屏幕上绘制的图形,以及可使用 getDrawable(int) 等 API 检索,或应用到拥有 android:drawable 和 android:icon ...

- PCI-5565反射内存卡

PCI-5565反射内存卡是一种用于实时网络的硬件设备.它基于反射内存网的原理,通过光纤连接多台计算机,形成网络节点,并且每个节点上的网络内存卡存储着其他节点的共享数据拷贝.该反射内存卡可以插在多种总 ...

- 自学PHP笔记(一) PHP语法

本文转发来自:https://blog.csdn.net/KH_FC/article/details/115407577 PHP基本语法 php使用一对特殊的标记包含php代码,与HTML代码混在一起 ...

- Top100(中)

Top100(中) 二叉树 94. 二叉树的中序遍历 int *res; void inorder(struct TreeNode *root, int *returnSize) { if (root ...

- Spire.Pdf打印PDF文件

1 /// <summary> 2 /// Spire.Pdf打印PDF文件 3 /// </summary> 4 /// <param name="fileN ...

- 关闭火狐Firefox下载提示弹窗

关闭火狐 Firefox 下载提示弹窗可以通过地址栏输入about:config,打开高级首选项,搜索:browser.download.alwaysOpenPanel将true改为false即可关闭 ...

- Python函数指定参数、返回值类型

def fun(arg1: str, arg2: int ...) -> str: def as_view(name: str, *class_args: int, **class_kwargs ...

- 基于XAML框架和跨平台项目架构设计的深入技术分析

XAML平台和跨平台开发策略 本文基于Vicky&James 2024年10月22日在韩国Microsoft总部BMW meetup会议上的演讲内容重新整理而成.这次研讨会我们深入探讨了基于X ...

- 用Java实现samza转换成flink

将Apache Samza作业迁移到Apache Flink作业是一个复杂的任务,因为这两个流处理框架有不同的API和架构.然而,我们可以将Samza作业的核心逻辑迁移到Flink,并尽量保持功能一致 ...