MCP应用docker部署,docker-compose部署

一、概述

前面几篇文章,MCP应用直接用的python3 server.py运行的,如果服务器重启,进程就会关掉,很不方便。

所以需要使用docker部署,实现开机自启动。

二、docker部署

mysql_mcp_server_pro

准备文件

以mysql_mcp_server_pro为例:

server_docker.py

from fastmcp import FastMCP

from mysql.connector import connect, Error

import os mcp = FastMCP("operateMysql", port=9000) def get_db_config():

"""从环境变量获取数据库配置信息 返回:

dict: 包含数据库连接所需的配置信息

- host: 数据库主机地址

- port: 数据库端口

- user: 数据库用户名

- password: 数据库密码

- database: 数据库名称 异常:

ValueError: 当必需的配置信息缺失时抛出

""" config = {

"host": os.getenv("MYSQL_HOST", "localhost"),

"port": int(os.getenv("MYSQL_PORT", "3306")),

"user": os.getenv("MYSQL_USER"),

"password": os.getenv("MYSQL_PASSWORD"),

"database": os.getenv("MYSQL_DATABASE"),

}

print(config)

if not all(

[

config["host"],

config["port"],

config["user"],

config["password"],

config["database"],

]

):

raise ValueError("缺少必需的数据库配置") return config @mcp.tool()

def execute_sql(query: str) -> list:

"""执行SQL查询语句 参数:

query (str): 要执行的SQL语句,支持多条语句以分号分隔 返回:

list: 包含查询结果的TextContent列表

- 对于SELECT查询:返回CSV格式的结果,包含列名和数据

- 对于SHOW TABLES:返回数据库中的所有表名

- 对于其他查询:返回执行状态和影响行数

- 多条语句的结果以"---"分隔 异常:

Error: 当数据库连接或查询执行失败时抛出

"""

config = get_db_config()

try:

with connect(**config) as conn:

with conn.cursor() as cursor:

statements = [stmt.strip() for stmt in query.split(";") if stmt.strip()]

results = [] for statement in statements:

try:

cursor.execute(statement) # 检查语句是否返回了结果集 (SELECT, SHOW, EXPLAIN, etc.)

if cursor.description:

columns = [desc[0] for desc in cursor.description]

rows = cursor.fetchall() # 将每一行的数据转换为字符串,特殊处理None值

formatted_rows = []

for row in rows:

formatted_row = [

"NULL" if value is None else str(value)

for value in row

]

formatted_rows.append(",".join(formatted_row)) # 将列名和数据合并为CSV格式

results.append(

"\n".join([",".join(columns)] + formatted_rows)

) # 如果语句没有返回结果集 (INSERT, UPDATE, DELETE, etc.)

else:

conn.commit() # 只有在非查询语句时才提交

results.append(f"查询执行成功。影响行数: {cursor.rowcount}") except Error as stmt_error:

# 单条语句执行出错时,记录错误并继续执行

results.append(

f"执行语句 '{statement}' 出错: {str(stmt_error)}"

)

# 可以在这里选择是否继续执行后续语句,目前是继续 return ["\n---\n".join(results)] except Error as e:

print(f"执行SQL '{query}' 时出错: {e}")

return [f"执行查询时出错: {str(e)}"] @mcp.tool()

def get_table_name(text: str) -> list:

"""根据表的中文注释搜索数据库中的表名 参数:

text (str): 要搜索的表中文注释关键词 返回:

list: 包含查询结果的TextContent列表

- 返回匹配的表名、数据库名和表注释信息

- 结果以CSV格式返回,包含列名和数据

"""

config = get_db_config()

sql = "SELECT TABLE_SCHEMA, TABLE_NAME, TABLE_COMMENT "

sql += f"FROM information_schema.TABLES WHERE TABLE_SCHEMA = '{config['database']}' AND TABLE_COMMENT LIKE '%{text}%';"

return execute_sql(sql) @mcp.tool()

def get_table_desc(text: str) -> list:

"""获取指定表的字段结构信息 参数:

text (str): 要查询的表名,多个表名以逗号分隔 返回:

list: 包含查询结果的列表

- 返回表的字段名、字段注释等信息

- 结果按表名和字段顺序排序

- 结果以CSV格式返回,包含列名和数据

"""

config = get_db_config()

# 将输入的表名按逗号分割成列表

table_names = [name.strip() for name in text.split(",")]

# 构建IN条件

table_condition = "','".join(table_names)

sql = "SELECT TABLE_NAME, COLUMN_NAME, COLUMN_COMMENT "

sql += (

f"FROM information_schema.COLUMNS WHERE TABLE_SCHEMA = '{config['database']}' "

)

sql += f"AND TABLE_NAME IN ('{table_condition}') ORDER BY TABLE_NAME, ORDINAL_POSITION;"

return execute_sql(sql) @mcp.tool()

def get_lock_tables() -> list:

"""

获取当前mysql服务器InnoDB 的行级锁 返回:

list: 包含查询结果的TextContent列表

"""

sql = """SELECT

p2.`HOST` AS 被阻塞方host,

p2.`USER` AS 被阻塞方用户,

r.trx_id AS 被阻塞方事务id,

r.trx_mysql_thread_id AS 被阻塞方线程号,

TIMESTAMPDIFF(SECOND, r.trx_wait_started, CURRENT_TIMESTAMP) AS 等待时间,

r.trx_query AS 被阻塞的查询,

l.OBJECT_NAME AS 阻塞方锁住的表,

m.LOCK_MODE AS 被阻塞方的锁模式,

m.LOCK_TYPE AS '被阻塞方的锁类型(表锁还是行锁)',

m.INDEX_NAME AS 被阻塞方锁住的索引,

m.OBJECT_SCHEMA AS 被阻塞方锁对象的数据库名,

m.OBJECT_NAME AS 被阻塞方锁对象的表名,

m.LOCK_DATA AS 被阻塞方事务锁定记录的主键值,

p.`HOST` AS 阻塞方主机,

p.`USER` AS 阻塞方用户,

b.trx_id AS 阻塞方事务id,

b.trx_mysql_thread_id AS 阻塞方线程号,

b.trx_query AS 阻塞方查询,

l.LOCK_MODE AS 阻塞方的锁模式,

l.LOCK_TYPE AS '阻塞方的锁类型(表锁还是行锁)',

l.INDEX_NAME AS 阻塞方锁住的索引,

l.OBJECT_SCHEMA AS 阻塞方锁对象的数据库名,

l.OBJECT_NAME AS 阻塞方锁对象的表名,

l.LOCK_DATA AS 阻塞方事务锁定记录的主键值,

IF(p.COMMAND = 'Sleep', CONCAT(p.TIME, ' 秒'), 0) AS 阻塞方事务空闲的时间

FROM performance_schema.data_lock_waits w

INNER JOIN performance_schema.data_locks l ON w.BLOCKING_ENGINE_LOCK_ID = l.ENGINE_LOCK_ID

INNER JOIN performance_schema.data_locks m ON w.REQUESTING_ENGINE_LOCK_ID = m.ENGINE_LOCK_ID

INNER JOIN information_schema.INNODB_TRX b ON b.trx_id = w.BLOCKING_ENGINE_TRANSACTION_ID

INNER JOIN information_schema.INNODB_TRX r ON r.trx_id = w.REQUESTING_ENGINE_TRANSACTION_ID

INNER JOIN information_schema.PROCESSLIST p ON p.ID = b.trx_mysql_thread_id

INNER JOIN information_schema.PROCESSLIST p2 ON p2.ID = r.trx_mysql_thread_id

ORDER BY 等待时间 DESC;""" return execute_sql(sql) if __name__ == "__main__":

mcp.run(transport="sse")

修改了之前文章的代码,去除了.env文件,直接引用系统环境变量。

Dockerfile

FROM python:3.13.3-alpine3.21

ADD . /app

RUN pip3 install --upgrade pip -i https://pypi.tuna.tsinghua.edu.cn/simple && \

pip3 install mysql-connector-python fastmcp -i https://pypi.tuna.tsinghua.edu.cn/simple

WORKDIR /app EXPOSE 9000 ENTRYPOINT ["python3","/app/server.py"]

说明:

这里使用的python版本,是最新的3.13.3,镜像使用的是最小的,基于alpine

安装fastmcp模块,必须要升级pip才行,否则安装会失败。

编译并运行镜像

编译

docker build -t public_ip_mcp_server:v1 .

运行镜像,注意携带5个环境变量,一个个写变量太麻烦了,接下来使用docker-compose来运行

三、docker-compose部署

使用docker-compose方便管理docker,修改docker运行相关参数,也容易。

docker-compose.yaml

services:

mysql_mcp_server_pro:

image: mysql_mcp_server_pro:v1

container_name: mysql_mcp_server_pro

ports:

- "9090:9000"

environment:

MYSQL_HOST: "192.168.20.128"

MYSQL_PORT: "3306"

MYSQL_USER: "root"

MYSQL_PASSWORD: "abcd@1234"

MYSQL_DATABASE: "test"

TZ: Asia/Shanghai

restart: always

注意修改mysql相关环境变量

运行

docker-compose up -d

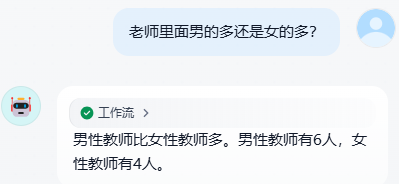

四、dify测试

上一篇文章,已经介绍了dify调用MCP工具,链接:https://www.cnblogs.com/xiao987334176/p/18827261

还是一样的dify工作流,测试即可。

注意:如果MCP server服务中断,dify是不会自动重连的,需要重启dify的plugin_daemon组件,就会重新连接MCP server

测试工作流

MCP应用docker部署,docker-compose部署的更多相关文章

- centos7 部署 docker compose

=============================================== 2019/4/10_第1次修改 ccb_warlock == ...

- 使用Docker Compose部署基于Sentinel的高可用Redis集群

使用Docker Compose部署基于Sentinel的高可用Redis集群 https://yq.aliyun.com/articles/57953 Docker系列之(五):使用Docker C ...

- Docker Compose 部署前后端分离应用

部署前后端分离应用 容器化 Abp 应用 关于 Abp 应用的容器化,其实和普通的 ASP.NET Core 应用差不多,大家可以参考我此前的文章. 唯一需要注意的是:因为 Abp 解决方案中有多个项 ...

- Docker Compose部署项目到容器-基于Tomcat和mysql的项目yml配置文件代码

场景 Docker-Compose简介与Ubuntu Server 上安装Compose: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/deta ...

- Docker Compose部署项目到容器-基于Tomcat和mysql的商城项目(附源码和sql下载)

场景 Docker-Compose简介与Ubuntu Server 上安装Compose: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/deta ...

- 在Windows Server 2019通过Docker Compose部署Asp.Net Core

一.安装Docker Enterprise 安装文档是: https://docs.docker.com/install/windows/docker-ee/ 安装完成后,如下图 二.首先,拉取一个W ...

- 使用Docker Compose 部署Nexus后初次登录账号密码不正确,并且在nexus-data下没有admin,password

场景 Ubuntu Server 上使用Docker Compose 部署Nexus(图文教程): https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/ ...

- Ubuntu Server 上使用Docker Compose 部署Nexus(图文教程)

场景 Docker-Compose简介与Ubuntu Server 上安装Compose: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/deta ...

- Docker Compose部署Nexus3时的docker-compose,yml代码

场景 Docker-Compose简介与Ubuntu Server 上安装Compose: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/deta ...

- Docker Compose部署GitLab服务,搭建自己的代码托管平台(图文教程)

场景 Docker-Compose简介与Ubuntu Server 上安装Compose: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/deta ...

随机推荐

- MySQL插入修改和删除

原文链接:https://blog.liuzijian.com/post/36d9bcaa-2ba7-26ca-6f97-b8ef7a058e95.html 插入 支持一次性插入多行,支持子查询 IN ...

- Oracle生成awr报告操作步骤

1.cmd命令窗口 以sysdba身份登录Oracle 2.执行@?/rdbms/admin/awrrpt命令,并选择报告类型为HTML.输入天数以选择生成报告的时间段,一般默认为最近7天.输入报告开 ...

- Oracle用户的创建和授权

1 --创建用户.密码 2 create user infouser identified by "User@2022!"; 3 --授权连接数据库权限 4 grant conne ...

- IDEA新建多模块maven项目

1.new =>projetc=>maven=>,新建完成后删除src目录 2.增加java模块 例:robots2-common 项目根目录就是[robots2-paren ...

- Codeforces 1749E Cactus Wall 题解 [ 紫 ] [ 01 BFS ] [ 图论建模 ] [ 构造 ] [ adhoc ]

一道很好的思维题,被教练碾压了. 观察 首先从题目给的样例入手: 5 5 ..... ..... ..... ..... ..... 这种情况最终的答案是: YES ....# ...#. ..#.. ...

- mybatis之生命周期及作用域

SqlSessionFactoryBuilder 一旦创建了SqlSessionFactory之后就没有作用了 局部变量 SqlSessionFactory 可以理解为数据库的连接池 SqlSessi ...

- 傻妞PLUS机器人教程——安装

特性 简单易用的消息搬运功能. 简单强大的自定义回复功能. 完整支持 ECMAScript 5.1 的插件系统,基于 otto. 支持通过内置的阉割版 Express / fetch ,接入互联网. ...

- SpringBoot - [07] Web入门

题记部分 一.Web 入门 SpringBoot将传统Web开发的mvc.json.tomcat等框架整合,提供了spring-boot-starter-web组件,简化了Web应用配置.创建Sp ...

- Powershell实现圆缩小放大 (实时刷新窗口)

使用Powershell,创建实时刷新的窗口,绘制图形,这里以圆作为例子,做缩小放大动画. [分析] Powershell是windows内置的自动部署平台,功能强大在于可以调取.net框架,因此,即 ...

- Windows 提权-不安全的 GUI 程序

本文通过 Google 翻译 Insecure GUI Applications – Windows Privilege Escalation 这篇文章所产生,本人仅是对机器翻译中部分表达别扭的字词进 ...