Python爬虫_糗事百科

本爬虫任务:

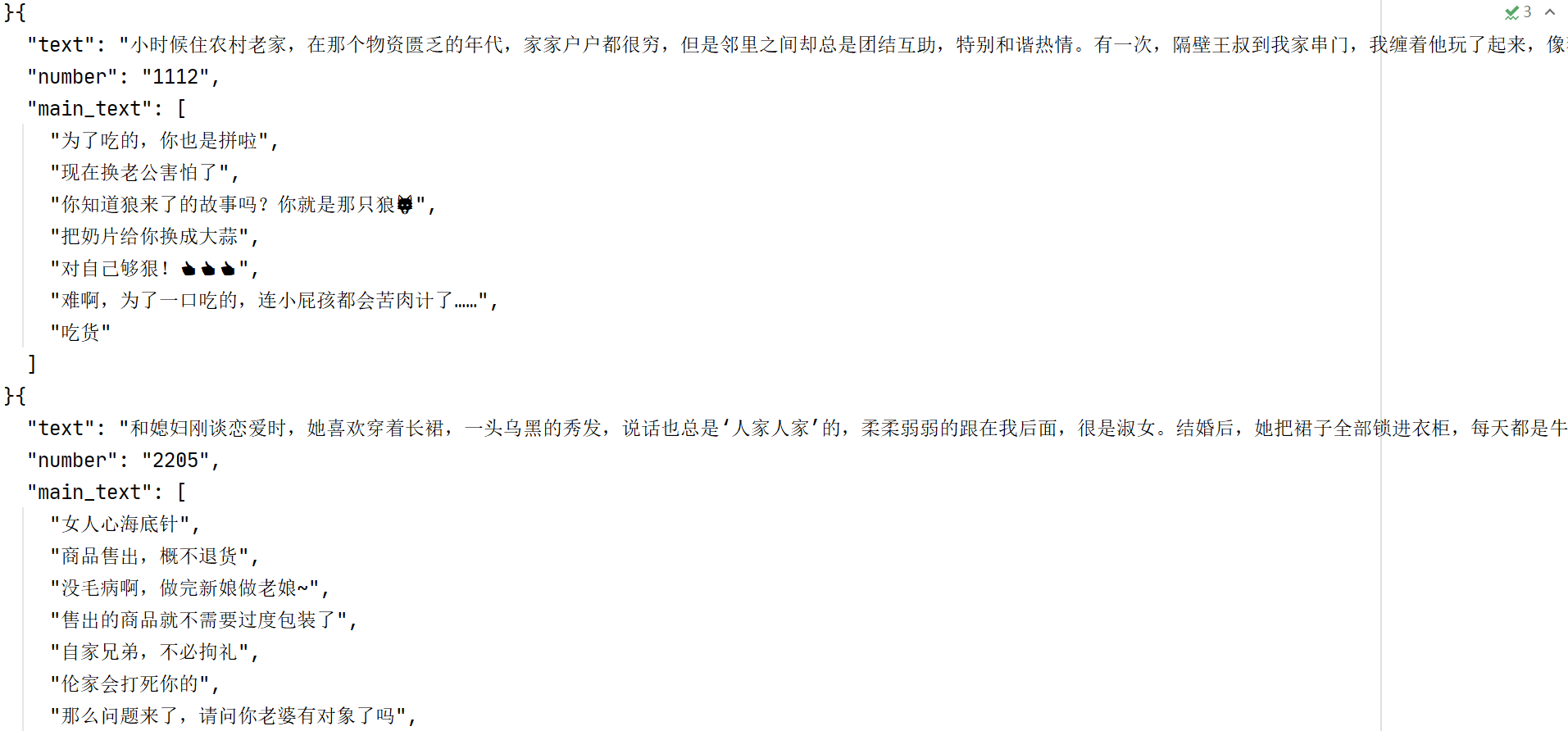

爬虫糗事百科网站(https://www.qiushibaike.com/)——段子版块中所有的【段子】、【投票数】、【神回复】等内容

步骤:

- 通过翻页寻找url规律,构造url列表

- 查看审查元素,发现网页内容均在elements中,可以直接请求

- 通过xpath提取需要的内容

- 保存数据

逻辑:

- 构造外层url列表并进行遍历

- 对外层url请求访问,获得响应

- 提取内层url列表

- 遍历内层url

- 对内层url请求访问,获取响应

- 提取需要的数据(段子、投票数、神回复)

- 保存

代码:

1 import requests

2 from lxml import etree

3 import json

4

5

6 class QiuShiSpider:

7 def __init__(self):

8 self.start_url = "https://www.qiushibaike.com/text/page/{}/"

9 self.headers = {

10 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.k36 (KHTML, like Gecko) ""Chrome/86.0.4240.11"}

11

12 def parse_url(self, url):

13 res = requests.get(url, headers=self.headers)

14 return res.content.decode()

15

16 def get_urls_inner(self, html_str):

17 html = etree.HTML(html_str)

18 urls_inner = html.xpath("//a[@class='contentHerf']/@href")

19 full_urls_inner = ["https://www.qiushibaike.com" + i for i in urls_inner]

20 return full_urls_inner

21

22 def get_contents(self, html_str):

23 html = etree.HTML(html_str)

24 text_list = html.xpath("//div[@class='content']/text()")

25 text = "".join(text_list)

26 number = html.xpath("//span[@class='stats-vote']/i/text()")[0] if len(

27 html.xpath("//span[@class='stats-vote']/i/text()")) > 0 else None

28 main_text_list = html.xpath("//div/span[@class='body']/text()")

29 return text, number, main_text_list

30

31 def save(self, content_dic):

32 with open("qs4.txt", "a", encoding="utf-8") as f:

33 f.write(json.dumps(content_dic, ensure_ascii=False, indent=2))

34

35 def run(self):

36 # 遍历url发送请求获取响应

37 urls_outer = [self.start_url.format(n + 1) for n in range(13)]

38 for url_outer in urls_outer:

39 try:

40 html_str = self.parse_url(url_outer)

41 urls_inner = self.get_urls_inner(html_str)

42 for url_inner in urls_inner:

43 content_dic = {}

44 html_str = self.parse_url(url_inner)

45 text, number, main_text_list = self.get_contents(html_str)

46 content_dic["text"] = text

47 content_dic["number"] = number

48 content_dic["main_text"] = main_text_list

49

50 self.save(content_dic)

51 print("第{}页,第{}条".format(urls_outer.index(url_outer), urls_inner.index(url_inner)))

52 except Exception as e:

53 print(e)

54

55

56 if __name__ == "__main__":

57 qs = QiuShiSpider()

58 qs.run()

Python爬虫_糗事百科的更多相关文章

- 爬虫_糗事百科(scrapy)

糗事百科scrapy爬虫笔记 1.response是一个'scrapy.http.response.html.HtmlResponse'对象,可以执行xpath,css语法来提取数据 2.提取出来的数 ...

- Python爬虫(十七)_糗事百科案例

糗事百科实例 爬取糗事百科段子,假设页面的URL是: http://www.qiushibaike.com/8hr/page/1 要求: 使用requests获取页面信息,用XPath/re做数据提取 ...

- python scrapy实战糗事百科保存到json文件里

编写qsbk_spider.py爬虫文件 # -*- coding: utf-8 -*- import scrapy from qsbk.items import QsbkItem from scra ...

- python 爬取糗事百科 gui小程序

前言:有时候无聊看一些搞笑的段子,糗事百科还是个不错的网站,所以就想用Python来玩一下.也比较简单,就写出来分享一下.嘿嘿 环境:Python 2.7 + win7 现在开始,打开糗事百科网站,先 ...

- Python抓取糗事百科成人版图片

最近开始学习爬虫,一开始看的是静觅的爬虫系列文章,今天看到糗事百科成人版,心里就邪恶了一下,把图片都爬下来吧,哈哈~ 虽然后来实现了,但还是存在一些问题,暂且不提,先切入正题吧,没什么好说的,直接上代 ...

- Python爬取糗事百科

import urllib import urllib.request from bs4 import BeautifulSoup """ 1.抓取糗事百科所有纯 ...

- python 抓取糗事百科糗图

1 首先看下要抓取的页面 这是糗事百科里面的糗图页面,每一页里面有很多的图片,我们要做的就是把这些图片抓取下来. 2 分析网页源代码 发现源代码里面的每张图是这样储存的,所以决定使用正则匹配出图片的u ...

- python爬取糗事百科段子

初步爬取糗事百科第一页段子(发布人,发布内容,好笑数和评论数) #-*-coding:utf--*- import urllib import urllib2 import re page = url ...

- <爬虫实战>糗事百科

1.糗事百科段子.py # 目标:爬取糗事百科段子信息(文字) # 信息包括:作者头像,作者名字,作者等级,段子内容,好笑数目,评论数目 # 解析用学过的几种方法都实验一下①正则表达式.②Beauti ...

随机推荐

- Nginx基本功能及其原理,配置原理

Nginx基本功能及其原理,配置原理 一.正向代理.反向代理 二.Nginx配置文件的整体结构 三.Nginx配置SSL及HTTP跳转到HTTPS 四.nginx 配置管理 [nginx.conf 基 ...

- 小米和MAC触摸板手势汇总

小米的触摸手势: 左键:单指单击 右键:双指单击 选取并打开:单指双击 滚动页面:双指 移动 拖拽项目:双击并拖拽 放大/缩小:双指张开,双指捏合 MAC触摸板手势: http://www.cr173 ...

- RabbitMQ (简单集群部署操作)

RabbitMQ 集群部署 前期准备 第一步:三台linux系统(centos7.3) 主机名(hostname) 网卡ip node1 192.168.137.138 node2 192.168.1 ...

- DEDECMS:解决无法上传图片(在后台插入图片时提示类型不允许)

在include/uploadsafe.inc.php里把 $imtypes = array ( "image/pjpeg", "image/jpeg", &q ...

- ES6(四)用Promise封装一下IndexedDB

indexedDB IndexedDB 是一种底层 API,用于在客户端存储大量的结构化数据,它可以被网页脚本创建和操作. IndexedDB 允许储存大量数据,提供查找接口,还能建立索引,这些都是 ...

- 【HTB系列】靶机Frolic的渗透测试详解

出品|MS08067实验室(www.ms08067.com) 本文作者:大方子(Ms08067实验室核心成员) Hack The Box是一个CTF挑战靶机平台,在线渗透测试平台.它能帮助你提升渗透测 ...

- Musical Theme POJ - 1743 后缀数组

A musical melody is represented as a sequence of N (1<=N<=20000)notes that are integers in the ...

- 最小生成树 Prim和Kruskal

感觉挺简单的,Prim和Dijkstra差不多,Kruskal搞个并查集就行了,直接上代码吧,核心思路都是找最小的边. Prim int n,m; int g[N][N]; int u,v; int ...

- PowerShell随笔6---ISE

简单的命令可以通过控制台窗口输入执行,但是我的脚本逻辑复杂,需要保存.总不能在命令行工具中执行吧. 关了窗口,啥都没了.有没有一个IDE,有. 在PowerShell命令行窗口中输入:ISE,就会打开 ...

- Dubbo SPI 机制源码分析(基于2.7.7)

Dubbo SPI 机制涉及到 @SPI.@Adaptive.@Activate 三个注解,ExtensionLoader 作为 Dubbo SPI 机制的核心负责加载和管理扩展点及其实现.本文以 E ...